简介: Self-attention对文本处理有很大影响,并成为NLU自然语言理解的构成部分。 但是,这种成功并不仅限于文本(或一维序列),基于变压器的体系结构可以在视觉任务上击败最新的ResNet。 为了解释这一成就,我们的工作表明自我注意力可以表达CNN层,并且在实践中可以学习卷积滤波器。

Ashish Vaswani及其同事介绍的转换器架构已成为自然语言理解的主要力量。 转换器与以前的方法(例如递归神经网络(RNN)和卷积神经网络(CNN))之间的主要区别在于,转换器可以同时关注输入序列中的每个单词。

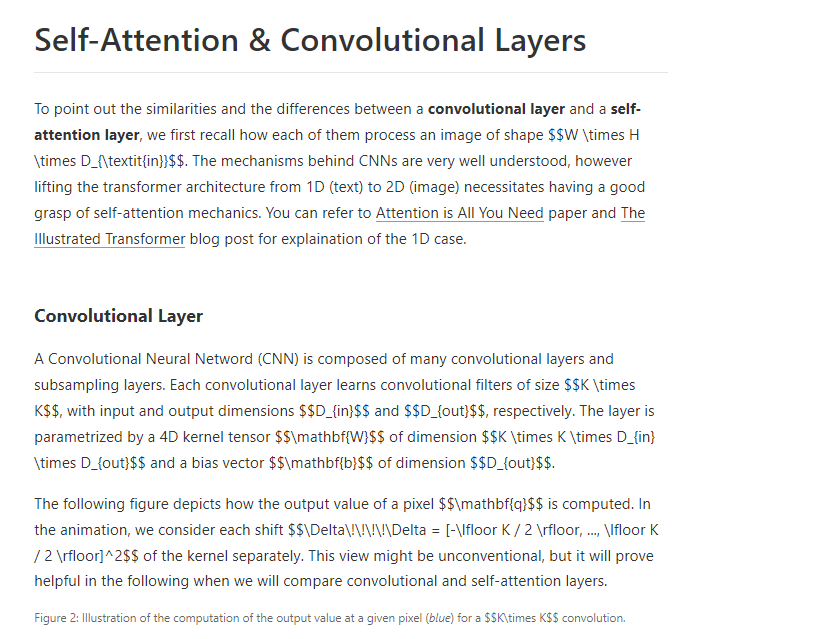

最近,Google AI的研究人员成功地将转换器架构应用于图像。 这意味着通过Self-attention替换所有CNN层,并调整参数数量以进行公平比较。 本文是对“自我注意和卷积层之间关系的论文”的简介,在本文中我们研究了变形器如何处理图像。 具体来说,我们表明具有足够数量的头部的多头自我注意层可以至少与任何卷积层一样具有表现力。 我们的发现提出了图像上变压器成功的可能解释。

成为VIP会员查看完整内容

相关内容

专知会员服务

108+阅读 · 2020年3月29日

专知会员服务

16+阅读 · 2020年3月27日

Arxiv

3+阅读 · 2018年7月5日

Arxiv

11+阅读 · 2018年5月27日