【速览】TIP 2021丨基于全局与局部纹理随机化的虚拟到现实跨域语义分割

学会“成果速览”系列文章旨在将图像图形领域会议期刊重要成果进行传播,通过短篇文章让读者用母语快速了解相关学术动态,欢迎关注和投稿~

◆ ◆ ◆ ◆

基于全局与局部纹理随机化的虚拟到现实跨域语义分割

*通讯作者:雷印杰 (yinjie@scu.edu.cn)

◆ ◆ ◆ ◆

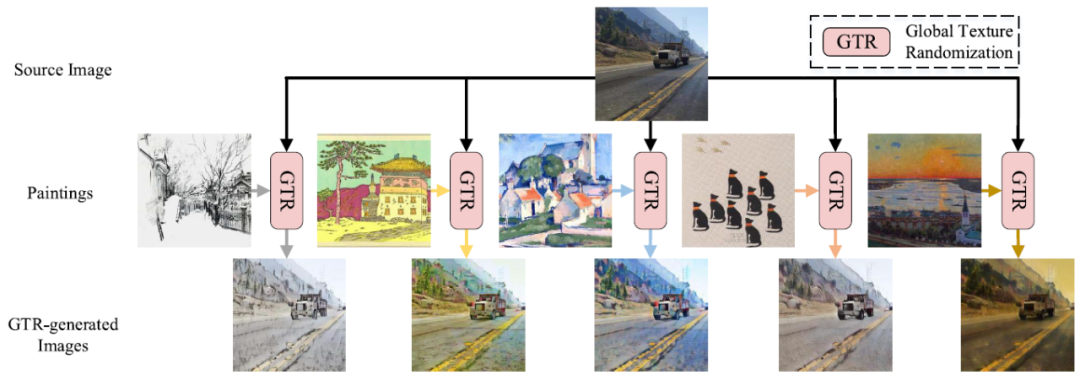

图 1 全局纹理随机化示例

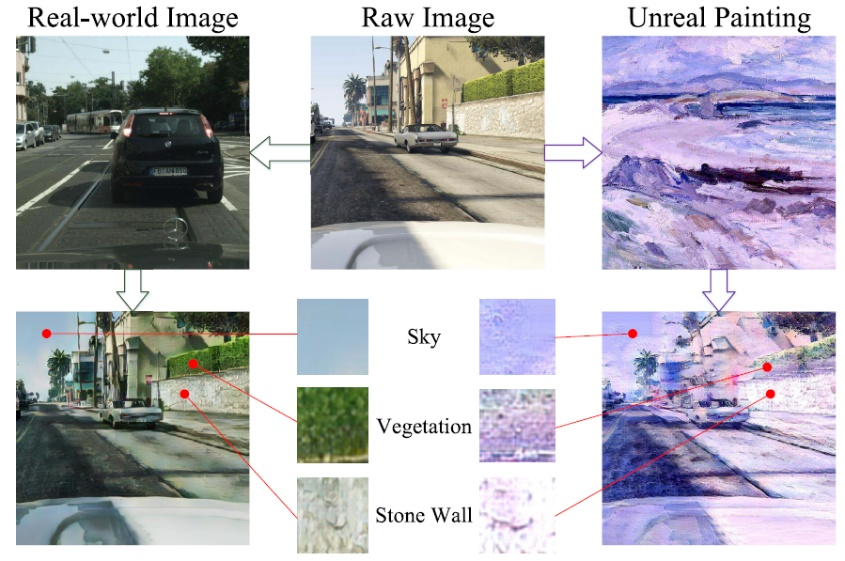

图 2 真实图像与虚幻绘画风格迁移的比较

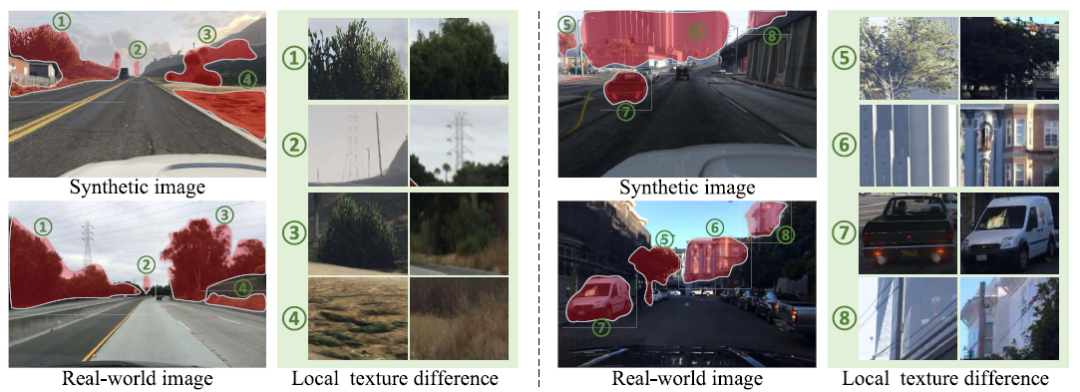

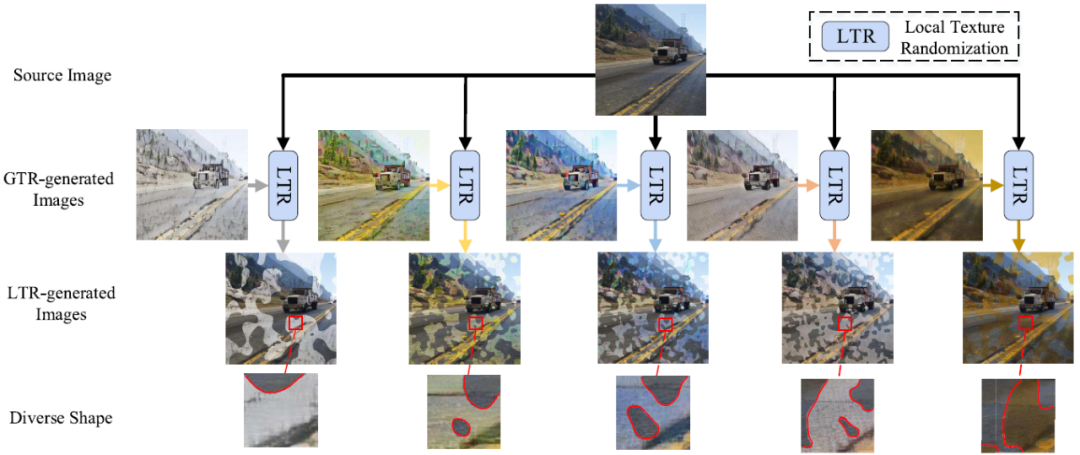

GTR倾向于使网络完全忽略纹理信息,它确实增强了模型对纹理移动的鲁棒性,但也阻止了网络利用一些有价值的纹理线索。事实上,在大多数情况下,图像中只有一些局部区域存在纹理差异。如图3所示,只有红色掩蔽区域的纹理差异较大,其他区域的纹理差异较小。因此,我们提出了局部纹理随机化(LTR)来应对这种情况。由于这些局部区域通常具有任意形状,因此LTR生成具有随机边界的局部纹理随机区域(如图4所示),可以使CNN在各种不同的局部纹理场景下获得良好的性能。

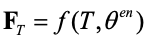

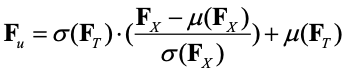

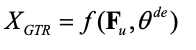

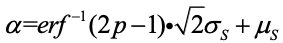

其中,

其中,

其中,

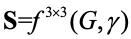

LTR是一种局部随机纹理随机生成图像的方法。原始图像

其中,

其中,

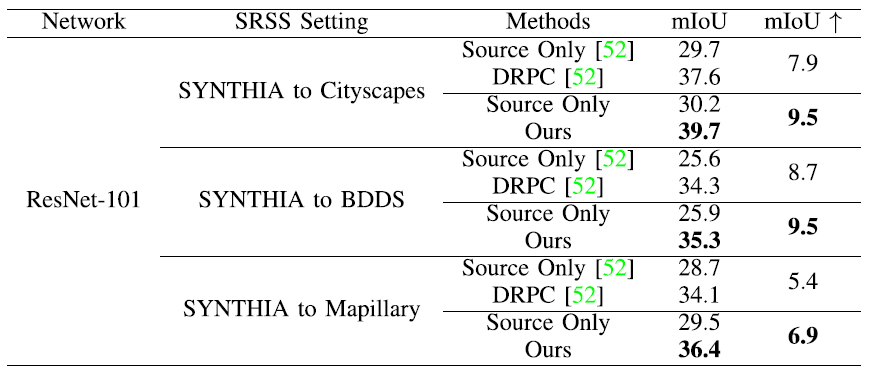

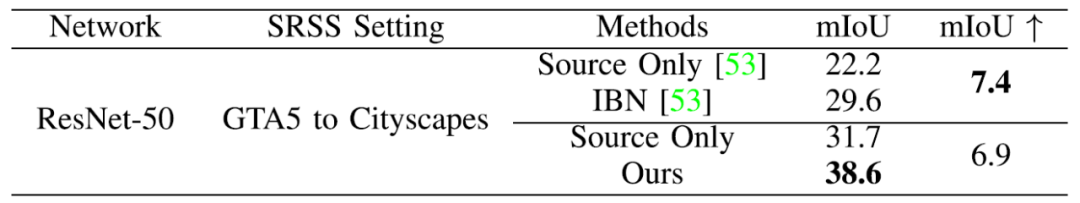

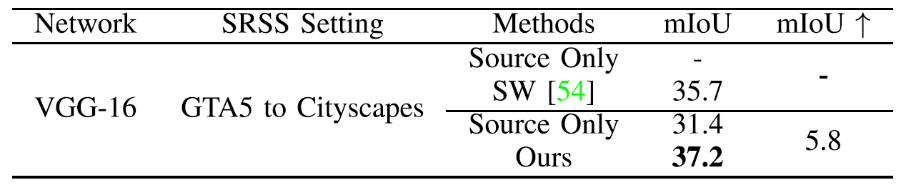

表 1 与DRPC的实验结果对比

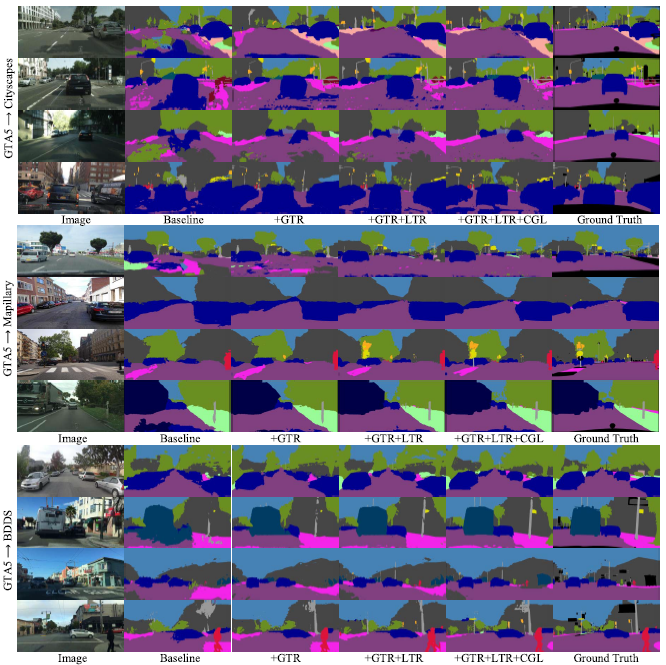

图 5 在三种跨域设定下的分割结果展示

[1] R. Geirhos, P. Rubisch, C. Michaelis, M. Bethge, F. A. Wichmann, and W. Brendel, “ImageNet-trained CNNs are biased towards texture; increasing shape bias improves accuracy and robustness,” 2018, arXiv:1811.12231. [Online]. Available: http://arxiv.org/abs/1811.12231

[2] J. Hoffman et al., “CyCADA: Cycle-consistent adversarial domain adaptation,” 2017, arXiv:1711.03213. [Online]. Available: http://arxiv.org/abs/1711.03213

[3] K. Bousmalis, N. Silberman, D. Dohan, D. Erhan, and D. Krishnan, “Unsupervised pixel-level domain adaptation with generative adversarial networks,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), Jul. 2017, pp. 3722–3731.

[4] X. Huang and S. Belongie, “Arbitrary style transfer in real-time with adaptive instance normalization,” in Proc. IEEE Int. Conf. Comput. Vis. (ICCV), Oct. 2017, pp. 1501–1510.

[5] G. French, S. Laine, T. Aila, M. Mackiewicz, and G. Finlayson, “Semi-supervised semantic segmentation needs strong, varied perturbations,” 2019, arXiv:1906.01916. [Online]. Available: http://arxiv.org/abs/1906.01916

[6] L. C. Andrews, Special Functions of Mathematics for Engineers, vol. 49. Bellingham, WA, USA: SPIE, 1998.

[7] X. Yue, Y. Zhang, S. Zhao, A. Sangiovanni-Vincentelli, K. Keutzer, and B. Gong, “Domain randomization and pyramid consistency: Simulation-to-real generalization without accessing target domain data,” in Proc. IEEE/CVF Int. Conf. Comput. Vis. (ICCV), Oct. 2019, pp. 2100–2110.

[8] X. Pan, P. Luo, J. Shi, and X. Tang, “Two at once: Enhancing learning and generalization capacities via IBN-Net,” in Proc. Eur. Conf. Comput. Vis. (ECCV), 2018, pp. 464–479.

[9] X. Pan, X. Zhan, J. Shi, X. Tang, and P. Luo, “Switchable whitening for deep representation learning,” in Proc. IEEE/CVF Int. Conf. Comput. Vis. (ICCV), Oct. 2019, pp. 1863–1871.