医学图像分割

·

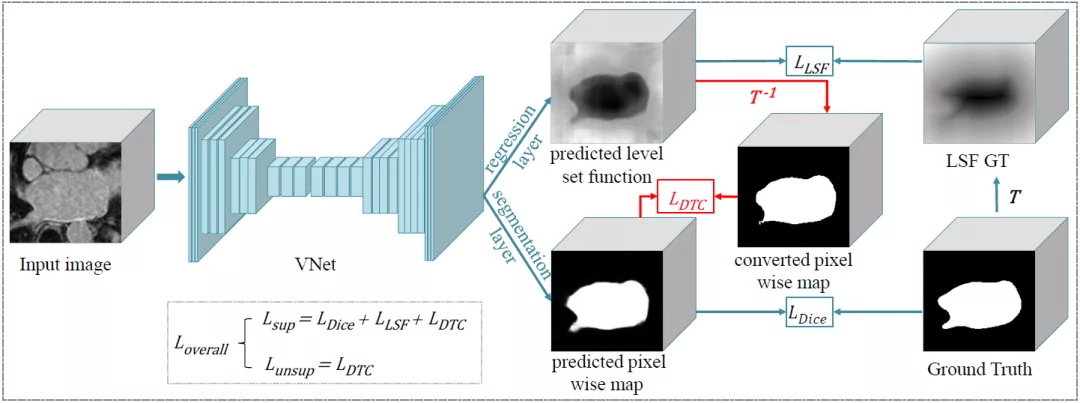

该工作针对基于半监督的医学图像算法,提出了一种利用双任务一致性约束的新方法,将同一个分割问题表示成两个不同的任务,并鼓励两个任务在预定义的表示空间内保持一致,进而充分利用未标注的数据提升深度神经网络的性能,同时大大降低训练网络模型所需要的标注成本。图片

基于深度学习的方法因为在图像处理上优越表现而受到广泛的关注,近年来在图像识别、人工智能领域不断取得了性能突破。但是由于深度神经网络需要依赖大量良好标注的数据,在小数据上很难达到比较好的效果。在医学图像领域,数据标注通常需要大量的时间,也需要医学领域的专业知识,但医生通常很忙,没有充足的时间来标注大量的数据,因此从少量标注数据和大量未标注数据来学习以获得高性能模型变得尤为重要。

基于这样的问题,本文提出了一种基于双任务一致性的半监督学习算法,在现有全监督医学图像分割算法基础上,该算法可以充分利用没有标注的数据进行进一步学习,进而大大提高未标注数据的利用率和促进网络分割性能。实验表明,通过引入双任务一致性,网络能更稳定的从少量标注数据和大量未标注数据中学习,并显著提高分割结果。同时与最新的半监督分割算法相比,此方法需要的训练成本更低,所取得的效果也更好,从而降低了深度神经网络对标注数据的依赖。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2021年3月29日

Arxiv

5+阅读 · 2020年4月2日