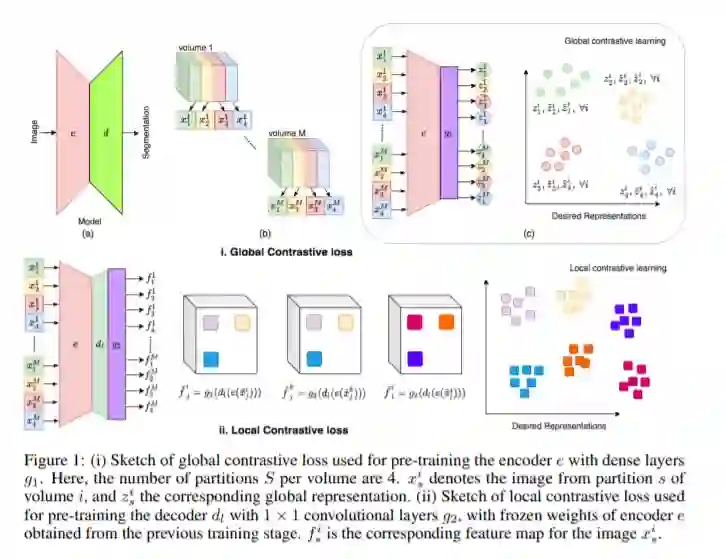

基于深度学习的算法模型往往需要大量的标注数据,相对于自然场景图像来说,医学图像更难获取,且标注数据的成本和难度都更高。自监督学习能够利用未标注的数据进行模型的预训练,然后再利用有限的标注数据进行模型的微调(fine-tune)。一种自监督学习的变种模型“对比学习”,是一种高效的技术,能够学习到图像级别(image-level)的表征。本文提出的策略通过扩展对比学习框架在数据量较为局限(标注数据少)的医学标注数据中,利用半监督学习进行三维医学图像分割。具体来说:①提出了一种全新的对比学习策略,通过利用三维医学图像(特定领域)的结构相似性;②设计了一种局部对比损失以学习独特的局部特征表达,其在像素级图像分割(特定问题)中性能提升显著。作者应用该方法在三个医学数据集上进行了实验验证,实验设定使用较为有限的标注数据上进行训练(限定训练集的大小),与已提出的自监督和半监督学习方法相比,该方法对分割性能有大幅的提升。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2020年12月3日

Arxiv

4+阅读 · 2018年9月23日