MLOD:基于鲁棒特征融合方法的多视点三维目标检测

点击上方“CVer”,选择加"星标"或“置顶”

重磅干货,第一时间送达

本文转载自:SIGAI

SIGAI特约作者

黄浴

奇点汽车美研中心总裁兼自动驾驶首席科学家

注:这是一篇2019年9月发表在arXiv【1】激光雷达和摄像头数据融合的目标检测论文。

摘要

本文介绍了一个多视图标记的目标检测器(MLOD)。检测器将RGB图像和激光雷达点云作为输入,并遵循两步目标检测框架。区域提议网络(RPN)在点云的鸟瞰视图(BEV)投影中生成3D提议。第二步将3D提议边框投影到图像和BEV特征图,并将相应的图截取发送到检测头(detector head)以进行分类和边界框回归。与其他多视图方法不同,裁剪的图像特征不直接馈送到检测头,而是被深度信息掩盖以过滤掉3D边框外的部分。图像和BEV特征的融合具有挑战性,因为它们来自不同的视角。这里引入了一种新检测头,不仅可以从融合层提供检测结果,还可以从每个传感器通道提供检测结果。因此,可以用不同视图标记的数据训练目标检测器,以避免特征提取器的退化。MLOD在KITTI 3D目标检测基准测试中实现了最好的性能。最重要的是,评估表明新的头架构(header architecture)在防止图像特征提取器退化方面是有效的。

1.MLOD架构

大约有三种方法可以利用摄像头和激光雷达做自动驾驶的3D目标检测:1)图像区域建议,2)基于投影和3)多视图方法。

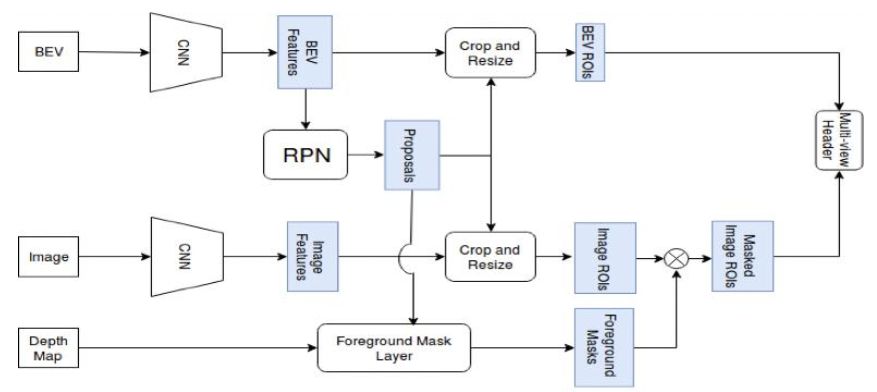

本文提出的两步神经网络结构如图1所示。BEV图和RGB图像被馈入两个卷积神经网络获得特征。为了提高计算效率,仅使用RPN的鸟瞰视图(BEV)特征生成3D提议。基于提议的深度信息,3D提议之外的图像特征被前景掩码层(foreground mask layer)掩盖。然后,掩码的图像特征图和BEV特征图被裁剪并传递到多视图头(multi-view header),提供最终的分类、定位和定向结果。

图1

6个通道的BEV图输入是一个0.1米分辨率的2D网格,包括5个高度通道和1个密度通道。点云沿着地平面的法线在[0, 2.5米]之间被划分为5个相等的切片(slices),并且每个切片产生高度通道,每个网格单元表示该单元中的点的最大高度。

该模型采用U-Net结构作为BEV特征提取器。编码器部分类似VGG的CNN,但有一半的通道。它包括CNN层,最高可达conv-4层。在解码器部分中,特征提取器使用卷积转置(conv- transpose)操作对特征图上采样。上采样特征图与来自编码器的相应特征串联实现融合。图像特征提取器是在pool-5层之前的VGG16 CNN。

为在提议的3D边框内正确捕获目标的图像特征,本文引入了前景掩码层来过滤掉前景特征。

为了识别图像的前景和背景,具有每个像素深度信息是必要的。但是由于激光雷达点云的稀疏性,图像平面中的大部分深度信息都是未知的。最近,有几种方法来完整化深度图。不幸的是,它们通常具有高GPU内存使用率,不适合实现。相反,这里引入了一种轻量级方法来利用稀疏深度信息。

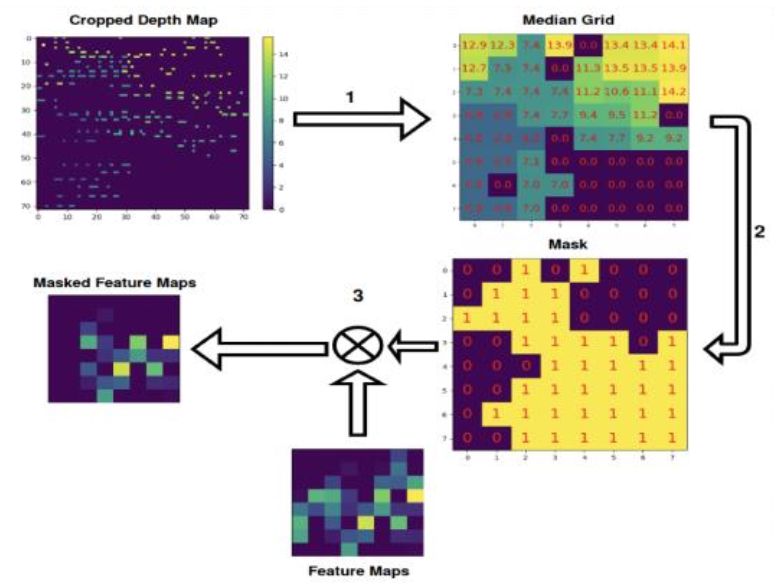

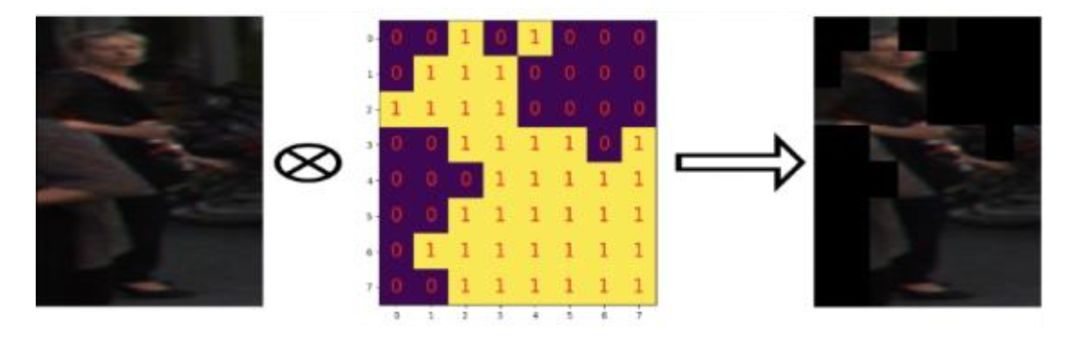

图2显示了前景掩码层的流程。首先,该层用3D提议投影的前视2D边框裁剪并调整其(稀疏)深度图的大小。为了计算方便,调整大小的深度图是k×k大小裁剪图像特征图的n倍。由于深度信息在前视图是不连续的,因此使用最近邻内插算法获得大小调整过的深度图。然后将nk×nk深度图等分成k×k网格。这样,每个网格单元表示k×k图像特征图对应像素的深度信息。该层计算每个网格单元中非零深度值的中值mij,因为零值表示该像素没有激光雷达点信息。请注意,由于点云的稀疏性,网格单元格中的所有深度值都可能为零。

(a)

(b)

图2

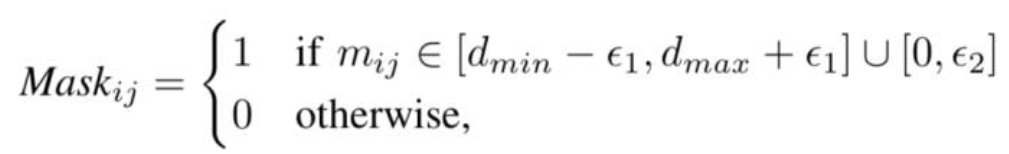

由于远目标只有较少的投射激光雷达点,因此这些目标的某些部分没有任何深度信息。为此,为保留3D边框内或没有深度信息的图像特征,将前景掩码设置为前视图,使用最近邻内插算法获得调整大小的深度图。然后,将nk×nk深度图等分为k×k网格。因此,每个网格单元表示k×k图像特征映射中的对应像素的深度信息。因此,为了保留3D边界框内的图像特征或没有深度信息,我们将前景掩码设置为

其中dmax和dmin分别是3D边框的最大和最小深度值。ε1和ε2是小缓冲区,用于吸收3D提议和点云的不确定性。(图2中dmin = 6.8,dmax = 9.7)

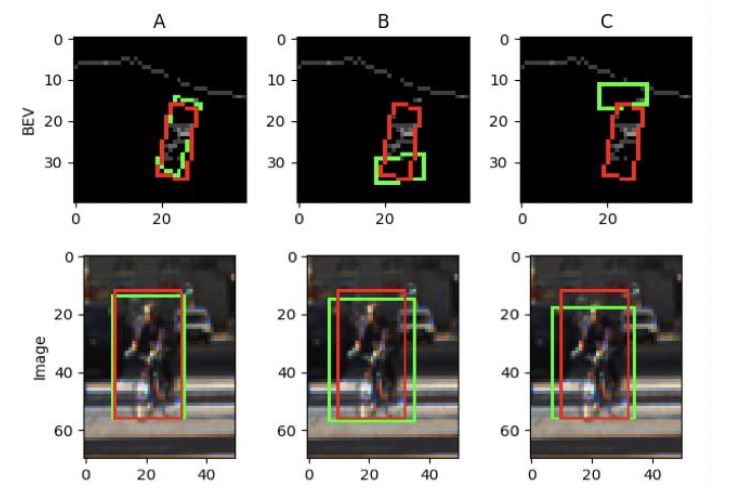

在多视图3D目标检测方法中,基于BEV的IoU来分配提议标签。但前视图的IoU可能与BEV的IoU明显不同。图3示出将3D边框分配给负标签但在图像视图中IoU > 0.7的示例。当仅基于BEV IoU分配标签来训练目标检测器时,(前视图)图像通道的性能降低。

图3

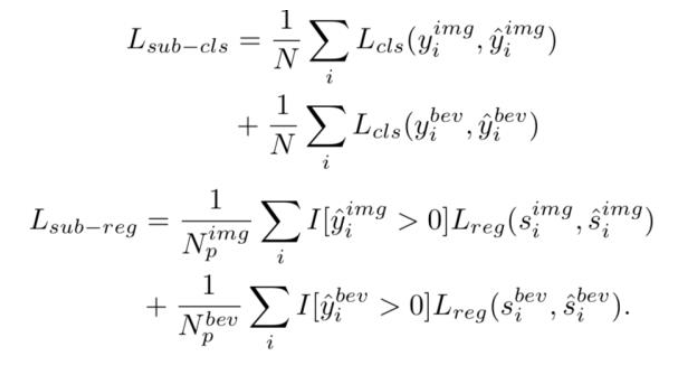

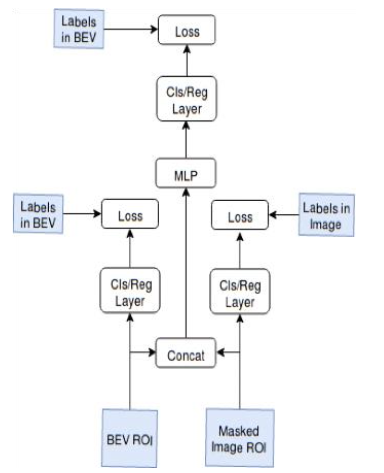

作者提出了一种多视图检测头,以避免RGB图像特征的衰减。图4显示了头部网络结构。关键想法是在融合层(concat)之前为每个通道添加额外的输出层。两个输出的每一个馈入到相应的子输出(sub-output)损失中。每个子输出损失是采用在相应通道视图中IoU分配的标签计算,即

图4

其中I[.> 0]是选择正提案的指标函数,N、

。

2.网络训练

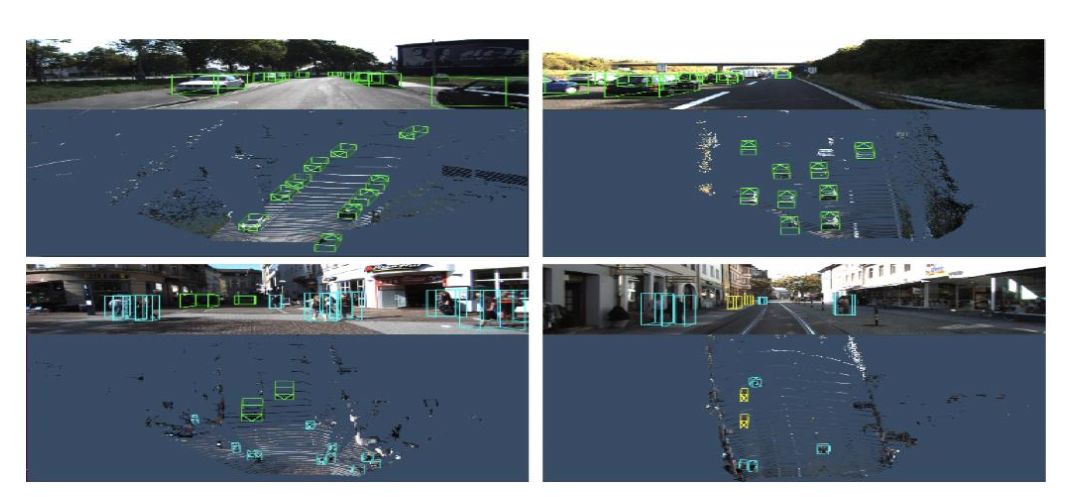

文中使用多任务损失来训练网络,其检测网络的损失函数由下式定义

这里使用平滑L1损失进行3D边框偏移和朝向旋转回归,并使用交叉熵损失进行分类。λ是用于平衡不同损失项的超参数。子输出损失可以被认为是网络上的一种正则化过程。

KITTI基准测试对汽车类(> 0.7)和行人和骑车者类(> 0.5)使用不同的IoU阈值。因此,文中训练了两个网络,一个用于汽车,另一个用于行人和骑自行车者。用大小是1024个ROI的微批量联合训练RPN网络和检测头。采用ADAM优化器【2】,指数衰减的学习率初始化为0.0001。在汽车网络,每100K迭代衰减0.1。在步行者和自行车者网络,每20K迭代衰减0.5。图像特征提取器加载预训练的ImageNet权重。BEV特征提取器权重由Xavier统一初始化器(uniform initializer)初始化。

如果BEV /图像和真实GT目标的IoU分别大于0.65 / 0.7,则汽车建议在自上而下/前视图中被标记为正。如果其BEV /图像IoU分别小于0.55 / 0.5,则标记为负。正的行人或骑车者建议在BEV /图像视图中至少分别为0.45 / 0.6 IoU。负样本分别在BEV /图像视图中不超过0.4 / 0.4 IoU。对于微批量大小,先选择1024个样本,包括在自上而下的视图中具有最高RPN分数的正ROI和负ROI;然后,在正面视图中挑选正或负的ROI。

有许多方法可以编码3D边框。为了减少参数的数量并保持物理限制,3D边框表示为X-Y平面上的四个角,顶部和底部角高度会偏离地平面。

数据增强是增加训练实例数量和减少过拟合的重要技术。在这里的网络训练中实现了两种增强方法,即翻转和PCA抖动。点云和图像沿x轴翻转。PCA抖动会改变训练图像中RGB通道的强度。PCA分解应用在整组训练图像RGB像素值的集合中。然后,将高斯随机噪声添加到图像的主分量中。

3.实验

主要评估KITTI目标检测基准测试中汽车、行人和骑车人3D检测任务的MLOD性能。KITTI的3D目标检测数据集包含7,481个训练帧和7,518个测试帧。基于遮挡级别、最大截断和最小边框高度,这些帧包含三个难度级别的目标级对象:简易(E),中等(M)和难(H)。由于KITTI没有提供官方验证集,标记的7,481帧被分成训练集和1:1比例的验证集。

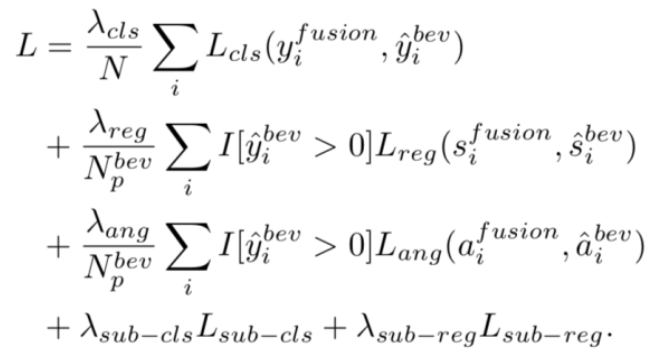

图5展示了实验结果例子。每张图像检测到的车辆为绿色,行人为蓝色,骑车者为黄色。

图5

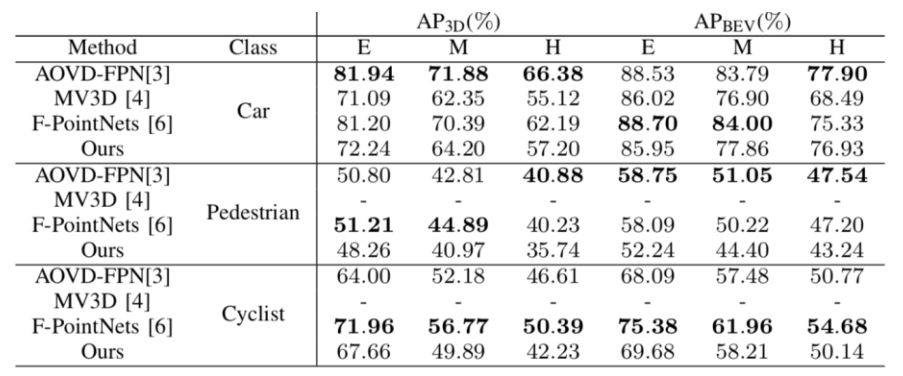

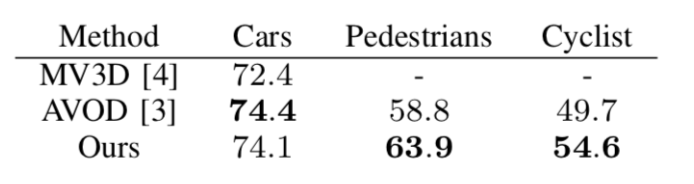

为评估MLOD的性能,分别在表II和表I中给出验证集和KITTI测试集的平均精度(AP)结果。MLOD在验证集上优于其他两个最先进的多视图目标检测器【3-4】。但是,MLOD方法在KITTI测试集上比AVOD差。这可能是由MLOD和AVOD中使用不同地平面引起的。评估表明,该方法可以达到当前最佳性能。

表I:MLOD与当前3D目标检测器的性能比较

表II:在中等难度验证集上MLOD与当前3D目标检测器的AP3D比较

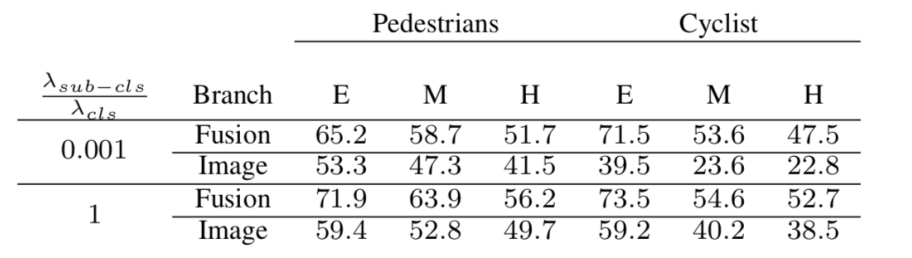

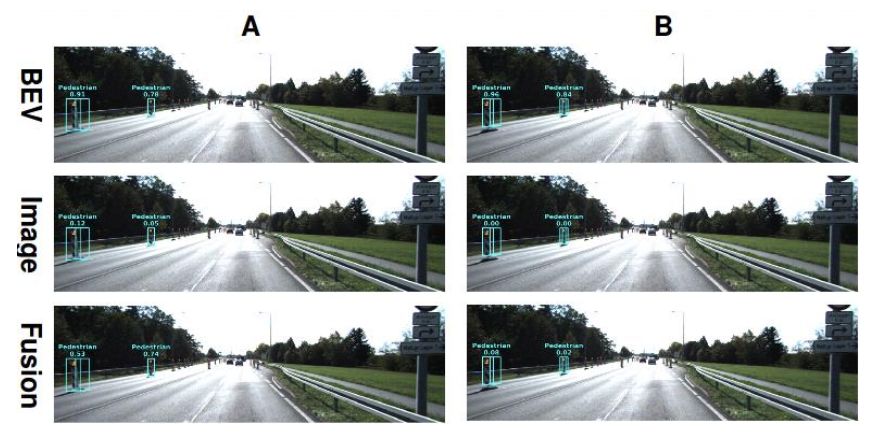

为评估多视图头网络的影响,将MLOD的AP(%)与验证集不同λsub-cls设置进行比较,如表III。当λsub-cls /λcls= 0.001时,BEV标记样本的融合通道支配了网络训练,这时候子通道损失可忽略。表III显示多视图头网络可为图像通道提供显著的性能增益,范围从5%到20%不等。对行人检测的容易、中等和难三种级别,AP最终检测分别增加了6.7%,5.2%和4.5%。图6显示了多视图头网络的效果示例(A栏:λsub-cls /λcl = 0.001; B列:λsub-cls /λcl = 1)。注意:当λsub-cls /λcls= 1,图像通道正确地为激光雷达BEV中误报的行人记分0.0。

表III 不同的λ设置在验证集上评估MLOD的AP3D性能

图6

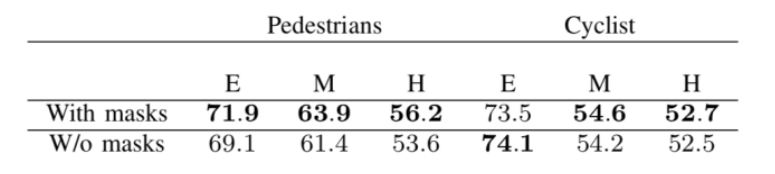

表IV显示了掩码组件如何影响MLOD的性能。

表IV 前景掩码层的效果

本文作者简介:

黄浴,奇点汽车美研中心总裁和自动驾驶首席科学家,上海大学兼职教授。曾在百度美研自动驾驶组、英特尔公司总部、三星美研数字媒体研究中心、华为美研媒体网络实验室,和法国汤姆逊多媒体公司普林斯顿研究所等工作。发表国际期刊和会议论文30余篇,申请30余个专利,其中13个获批准。

PS:好书推荐

《机器学习-原理,算法与应用》,清华大学出版社,雷明著。在这本书中对有监督学习,聚类,降维,半监督学习,强化学习的主要算法进行了细致、深入浅出的推导和证明。

参考文献

1. J Deng,K Czarnecki,“MLOD: A multi-view 3D object detection based on robust feature fusion method ”,arXiv 1909.04163v1,2019,9.

2. D. P. Kingma,J. Ba, “Adam: A method for stochastic optimization”,arXiv preprint arXiv:1412.6980, 2014

3. J. Ku, M. Mozifian, J. Lee, A. Harakeh, and S. L. Waslander, “Joint 3d proposal generation and object detection from view aggregation”, IEEE IROS, 2018.

4. X. Chen, H. Ma, J. Wan, B. Li, and T. Xia, “Multi-view 3d object detection network for autonomous driving”,IEEE CVPR, 2017.

5. C. R. Qi, W. Liu, C. Wu, H. Su, and L. J. Guibas, “Frustum PointNets for 3d object detection from RGB-D data”, IEEE CVPR, 2018.

6. C. R. Qi, H. Su, K. Mo, and L. J. Guibas, “Pointnet: Deep learning on point sets for 3d classification and segmentation”,IEEE CVPR, 2017.

重磅!CVer-目标检测交流群已成立

扫码添加CVer助手,可申请加入CVer-目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测和模型剪枝&压缩等群。一定要备注:研究方向+地点+学校/公司+昵称(如目标检测+上海+上交+卡卡)

▲长按加群

▲长按关注我们

麻烦给我一个在看!