【泡泡点云时空】PointFusion:深度传感器融合估计3D包围盒(CVPR2018-16)

泡泡点云时空,带你精读点云领域顶级会议文章

标题:PointFusion: Deep Sensor Fusion for 3D Bounding Box Estimation

作者:Xu Danfei, Anguelov Dragomir, Jain Ashesh, Stanford Unviersity,Zoox Inc

来源:The IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2018

播音员:Crystal

编译:蔡毅

审核:吕佳俊

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

提出一种通用的3D目标检测方法PointFusion,该方法利用了图像和3D点云融合信息。不像有些现有方法要么使用多步骤流程,要么基于传感器和指定数据集假设,PointFusion 相当简单且有应用前景。

图像数据和原始点云数据分别单独通过CNN和 PointNet处理。然后把输出的结果和一个新的融合网络进行结合,将输入的3D点作为空间角点,预测多个3D Box的可能性和置信度。

我们在两种不同的数据集上对PointFusion进行了评价,KITTI数据是由激光雷达和相机采集的驾驶场景,SUN-RGBD数据集是RGBD深度相机采集的室内环境。在没有对任何指定数据集模型进行调参情况下,与目前最好的方法相比,我们的模型能够表现出相当或者更好的效果。

方法概要

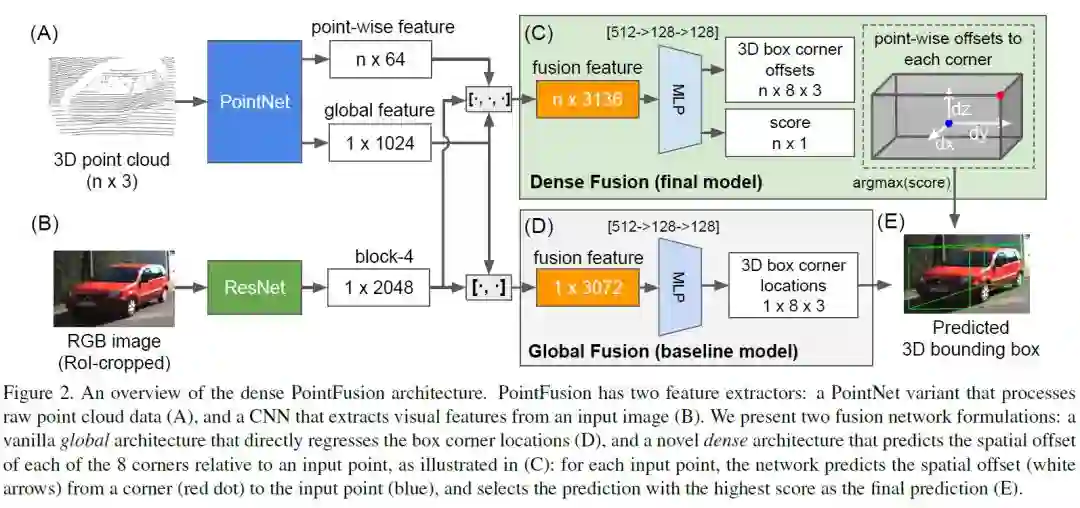

图2 PointFusion结构流程。PointFusion有两个特征提取器:一个是PointNet变体用来处理原始点云数据(A),另一个是CNN用来从图像上提取视觉特征(B)。

提出两种融合网络架构:一种是普通的全局架构(Global Fusion),直接从特征回归出box角点位置(D);第二个是提出一种新的逐点判断的稠密结构(Dense Fusion含义可参考CV中的dense prediction的意思),预测8个角点相对于输入点云的的空间偏置(C),每个点会有一个评分,最后选择得分最高到作为最后到预测结果(E)。

其中红色点为角点,蓝色点为输入点云,白色箭头表示角点到输入点到空间偏置。

实验结果

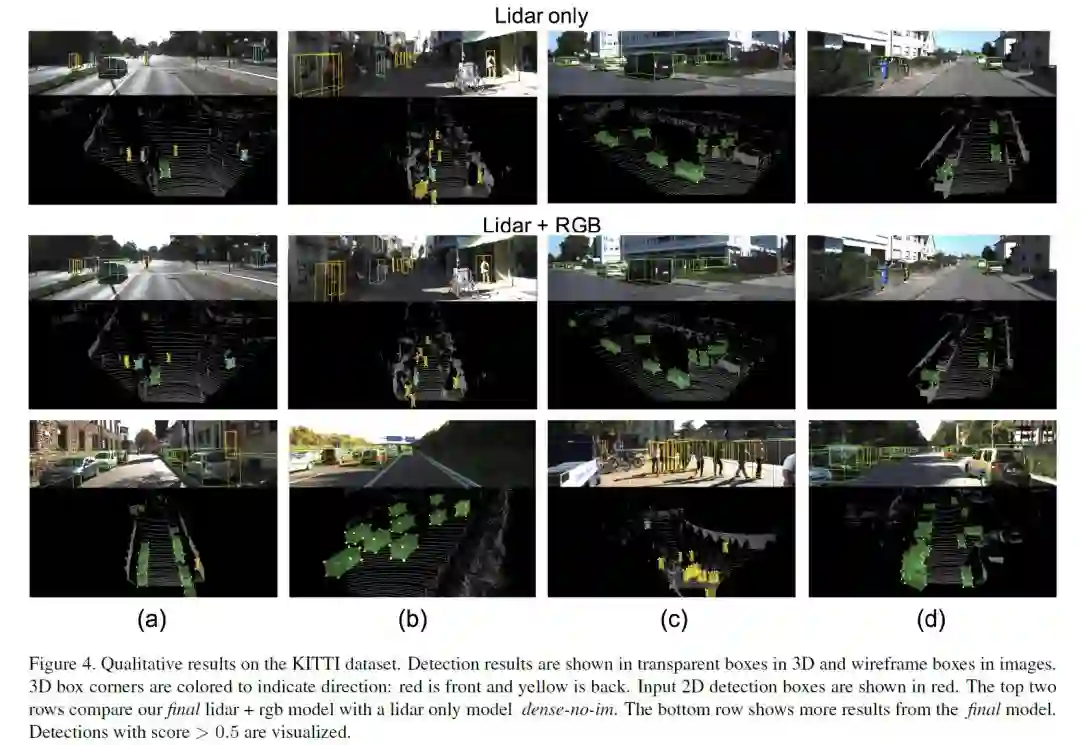

图4 基于KITTI数据集的定性评价。

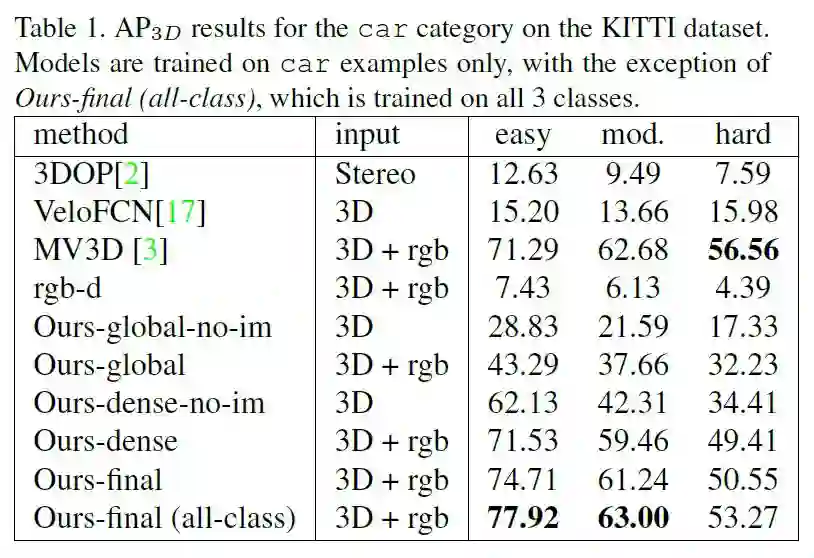

表1. KITTI数据集车辆分类精度,global表示仅适用global fusion;dense表示使用dense fusion + 监督评分函数;final表示dense fusion +非监督评分函数;no-im 表示仅使用lidar作为输入。

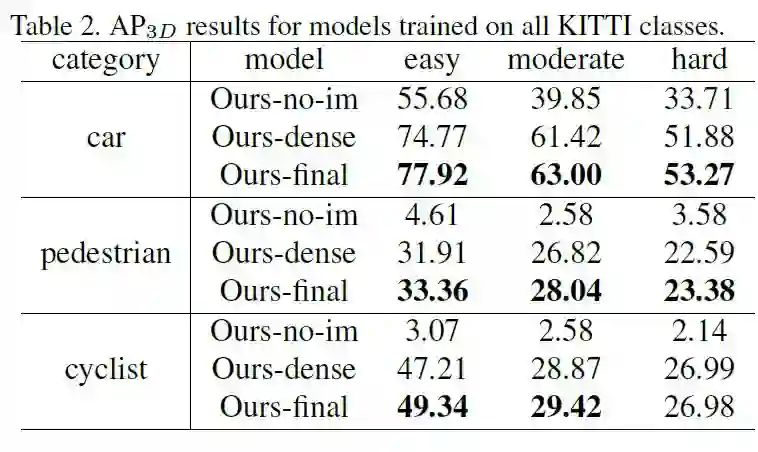

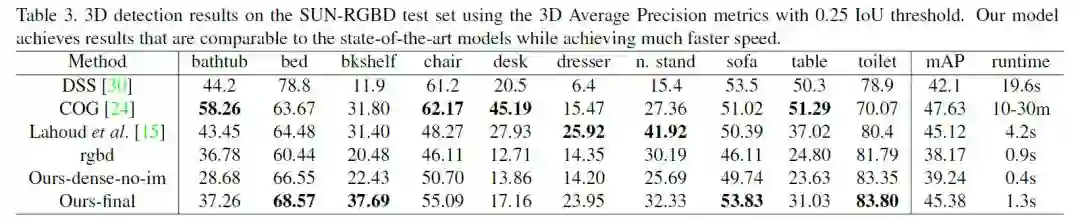

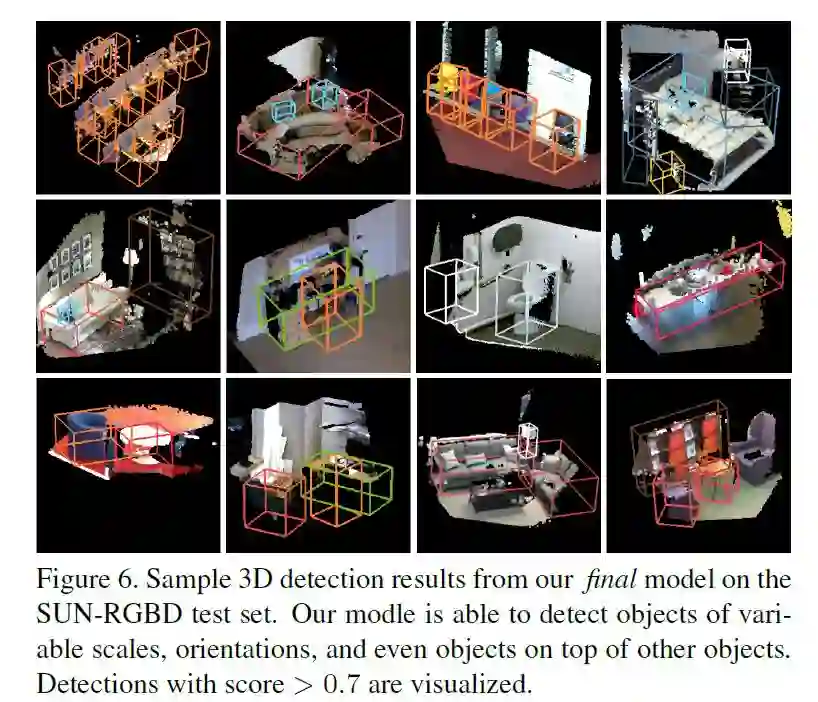

表2. Results on SUN-RGBD dataset

Abstract

We present PointFusion, a generic 3D object detection method that leverages both image and 3D point cloud information. Unlike existing methods that either use multi-stage pipelines or hold sensor and dataset-specific assumptions, PointFusion is conceptually simple and application-agnostic. The image data and the raw point cloud data are independently processed by a CNN and a PointNet architecture, respectively. The resulting outputs are then combined by a novel fusion network, which predicts multiple 3D box hypotheses and their confidences, using the input 3D points as spatial anchors. We evaluate PointFusion on two distinctive datasets: the KITTI dataset that features driving scenes captured with a lidar-camera setup, and the SUN-RGBD dataset that captures indoor environments with RGB-D cameras. Our model is the first one that is able to perform better or on-par with the state-of-the-art on these diverse datasets without any dataset-specific model tuning.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com