编辑:David 袁榭

【新智元导读】GPT-3问世两周年,业界中人或是感叹沧海桑田、或是展望美好未来。

在Reddit上,技术博客作家、研究员Gwern Branwen特别发帖纪念这个时刻。

2年前,GPT-3刚刚推出,把小作文写的栩栩如生、和真人对话聊天、讲故事引来一片惊叹,但Gwern本人却对其大泼冷水,他仍然认为,AI的前途也就那样。

「人工智能程序缺乏意识和自我意识」,Gwern在2020年的一篇关于 GPT-3 的文章中写道。

「他们永远不会有幽默感。他们永远无法欣赏艺术、美丽或爱情。他们永远不会感到孤独。他们永远不会对其他人、动物和环境有同理心。他们永远不会享受音乐,也不会坠入爱河,也不会哭得一塌糊涂。」

上一段话其实就是GPT-3写的,训练GPT-3的正是Gwern本人,用的语料就是当年diss人工智能各种不行的言论。

果然还是骂你最狠的人,爱你最深啊,对人、对AI都是如此。

算起来,GPT-3的诞生要从这篇OpenAI的论文开始说起。

这篇最初发表于2020年5月28日的论文,按照Gwern的说法,目的是为了比前身GPT-2实现零样本/少样本性能的一点提升,却用了100倍大的模型 ,有点「高射炮打蚊子」的意思。

Ta有时候很直男,总是讲一些蹩脚的玩笑哄你开心,可以一本正经的尬聊下去,丝毫不尴尬。

有时候又化身文艺青年,浪子诗人,时不时吟诵一些脱离俗套和低级趣味、另辟蹊径的随想,金句频出。

OpenAI 的CEO Sam Altman表示,他把GPT-3展示给一个10岁的小男孩儿,他当即说自己想进入人工智能领域。

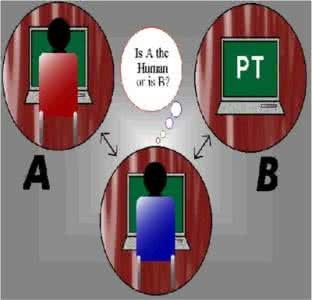

甚至有开发者认为,GPT-3确实让他预感到,在未来10年内,AI有望通过图灵测试。图灵测试目的就是测试机器是否具备人类智能。

讲道理,这么可爱又聪明的宝宝,2岁生日当然值得庆祝一下。

在reddit的跟帖上,有人为GPT-3的影响力P了一幅搞笑漫画:

「我的天呐,GPT-3论文上Arxiv后的这十年可真精彩。」

有一位ID为「死星挖掘机」的网友,为了纪念GPT-3两周年,只调了下词频等参数,拿GPT-3一次性生成了一段「冰箱落地砸断我腿」的家庭情景剧小故事。还配了曲调,当成卡拉OK来唱。

![]()

另有个ID为「Veedrac」的网友,就此写了篇小作文:「是吗?我不觉得哦,因为我的纪年是从(2022年1月底公布的)InstructGPT开始算的。」

「Veedrac」说,坦白地讲,上次GPT更新至今对我来说像是两年,因为我勉强接受InstructGPT是一个有意义的版本更新。然而,这些「年」都是非常忙碌的。

「Veedrac」个人认为,这两年有点像戏剧性的停顿,为未来非常混乱的局面做了铺垫,因为GPT-3有了各种扩展与进步,其他公司还推出了很多功能相似的竞品模型。

但是像PaLM和Chinchilla这样的边界推动型模型却被远远地排除在公众视线外,甚至它们的相关论文也很晚才出版,而GPT的下一个真正更新也已经花了超过一年的时间来准备。

当然,已经有非常多的论文扩展了这些模型的范围和理论,包括像Codex和InstructGPT这样的更新,以及各种各样不同的百亿参数模型。多模态和图像生成逐渐成熟,大家弄清了真正的数据规模缩放规则和一些参数化技巧,以进一步扩展这些进步。

硬件方面也没有丝毫放缓,其他领域如强化学习和证明搜索也有足够的突破,尽管它们还没有都得到同等的公众关注。

但其中很多论文都是抛媚眼性质的:嘿,看看我的潜力,把我的模型在那些大家都在使劲新建的超级电脑上跑一跑,不是很酷么?

「Veedrac」并不认为大模型的下一次疯狂跃进会比上一次幅度更小,而且业界似乎已经没有空间让模型的重大改进不在经济上自给自足。

电动车销量剧涨、Waymo的无人出租车可以不配安全员了、渣渣特斯拉的辅助驾驶系统满街都是、星舰上天、星链上天、商用太空旅游首次上天、苹果发布M1芯片、英特尔起死回生、AMD开搞3D堆栈、世界性大瘟疫、影响深远的地区性战争……

等下,最后俩事是GPT-3之后才出的么?好像真的是哦。

![]()

另一名ID为「All-DayErrDay」的网友感叹:

单个情势就能折射你对某事的直觉感受,如此局面真的很神奇。

在GPT-3出街前,没人想到可以这么玩。在此之后,业界都觉得只消按比例扩展规模就会源源不绝出新成果。

这个事件概况,特别适合在GPT-3面世前对深度学习不甚了了的资深未来学家们仔细玩味。

参考资料:

https://www.reddit.com/r/mlscaling/comments/uznkhw/gpt3_2nd_anniversary/iab8vy2/

https://www.vox.com/future-perfect/21355768/gpt-3-ai-openai-turing-test-language

![]()