机器学习系统通常被认为是不透明的、不可预测的,和人类所接受的训练几乎没有任何共通之处。

难道,黑盒模型和可解释性的学习注定是两条路?

但最近有研究表明,至少在某些情况下,神经网络能够学习到一些人类可理解的表征!

例如分类器中的单个神经元可以表示一些语义信息,语言模型中也包含语法信息,在视觉和文本数据的对齐数据中也能发现一些复杂的概念表示,这些神经网络学到的概念都和人类接受的概念训练相关。

但还有一个问题,这些学习到的概念是通用的吗?我们是否也希望其他深度学习的系统具有类似的有意义的表示?

如果这些问题的答案都是没有的话,那么一些关于反映模型计算过程可解释性的研究将受到种种限制,并且很难找到其他合理的方法来解释。

虽然上面提到的几个例子能一定程度上能展现机器学习模型能够理解人类的语义,但本质上是因为它们只能接触到人类生成的数据,并且在分类任务中是将人类的类别概念强加给模型才导致它们能捕捉到类别语义。

或者说,这些任务也相对简单,解释起来也更加容易。

为了进一步测试机器学习模型是否真正获取到了人类可理解概念(human-understandable concepts),需要找到一个在没有使用人类标签数据的情况下,表现出超越人类表现的模型。

这不巧了吗?AlphaZero就同时满足这两个要求。

首先,AlphaZero是通过self-play的方式训练的,所以从未接触过人类数据,并且它在国际象棋,围棋和将棋(Shogi)这三项竞技游戏上借助蒙特卡洛树搜索成功战胜人类。

所以AlphaZero就成了研究机器学习模型和人类理解之间关系的一座重要桥梁,如果AlphaZero中能找到人类可理解的概念,那其他模型应该也会有!

说干就干!

DeepMind、Google Brain的研究人员携手国际象棋世界冠军共同打造了一篇长达69页的论文,主要研究了像AlphaZero这样的超越人类的神经网络模型正在学习什么,这是一个既科学又实用的问题。

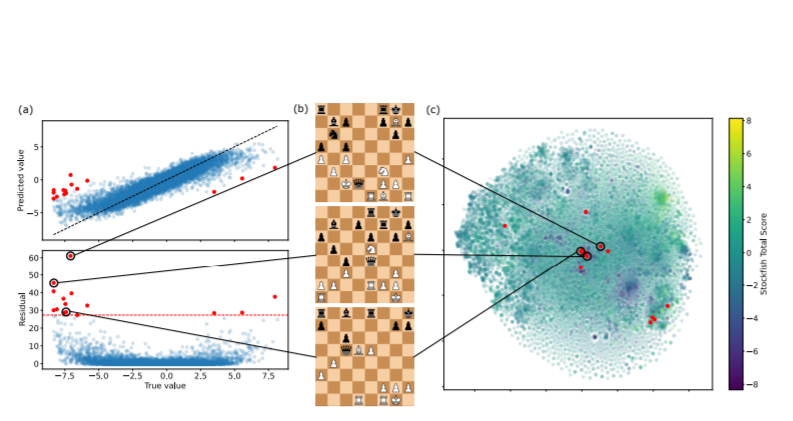

在论文中研究人员证明了人类获取知识和AlphaZero在国际象棋中获得的知识都是相似的。并通过对大量人类关于国际象棋的概念的探索,还可以观察到其中一些概念在AlphaZero网络是如何表示的。