【泡泡图灵智库】基于几何增量分割的快速准确语义建图

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Fast and Accurate Semantic Mapping through Geometric-based Incremental Segmentation

作者:Yoshikatsu Nakajima, Keisuke Tateno, Federico Tombari, Hideo Saito

来源:IROS2018

播音员:

编译:万应才

审核:李雨昊

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——基于几何增量式分割的快速准确语义建图,该文章发表于IROS2018。

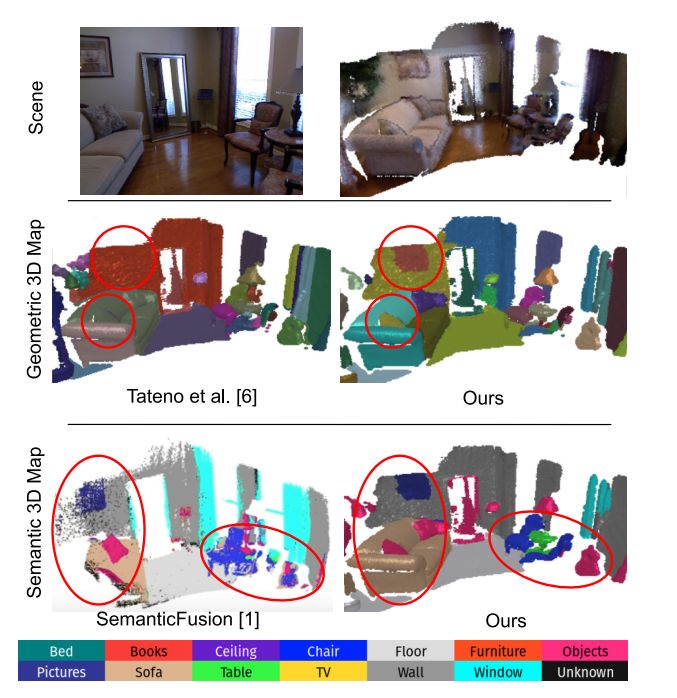

本文提出了一种高效且可扩展的方法来逐步构建一个密集的、语义注释的实时3D地图。该方法将类概率分配给三维地图的每个区域,而不是每个元素(如面元素和体元素),该三维地图是通过一个健壮的SLAM框架建立的,并使用基于几何的分割方法进行增量分割方法。与所有其他方法不同,本文的方法在运行所有处理模块(包括SLAM、分割、2D识别等)时,能够以超过30Hz的频率运行,并且更新每个进入帧的每个分段标签的类概率,这得益于设计的框架在计算密集阶段有较高的性能。利用一个专门设计的CNN来提高帧分割能够达到很高的精度。在NYU2数据集上验证了本文所提出的方法,并通过对时间和空间复杂性的分析,与现有技术的精度和计算效率进行比较。

主要贡献

1.当前方法为了能够获得实时的带有语义分割的3D实时建图,采取选择提取语义信息,虽然这种跳帧策略可以提高运行时性能,但它限制了它们的应用范围,因为它在快速摄像机运动下往往会带来不准确的情况。本文提出了一种新的增量语义映射方法,通过实时生成高精度的语义场景重建来克服这一问题。

2.本文引入一种新的概率策略来处理语义映射中的分配问题,即类概率分配。这显著降低了时间复杂性,因为在每个新的帧上,需要更新从当前相机姿势在图像平面上可见的那些片段的概率分布,而与需要更新图像平面上所有曲面的概率的传统方法不同。该策略还显著降低了空间复杂性,因为概率分布只需要存储在每个段,而不是每个像素面。

3.本文提出了一种有效的语义映射方法,将类概率赋给几何三维映射的每个区域,该区域通过一个鲁棒的SLAM框架和基于几何的增量分割逐步建立起来。

4. 本文提出了新的算法框架结构,降低了计算的复杂性,提高了实时性。

图1 本文精确语义分割示意图

算法流程

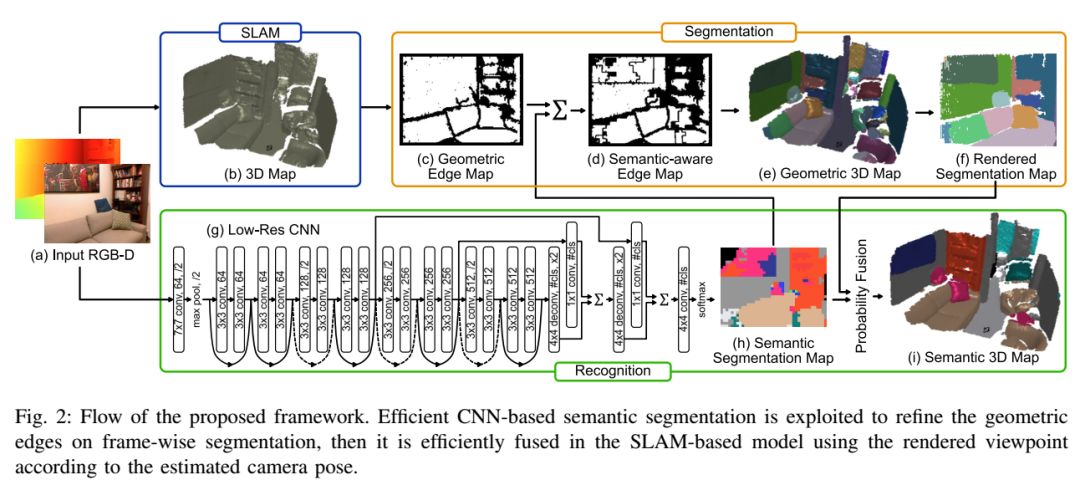

图2 算法流程图

本文提出的方法有四部分:SLAM框架,专门设计地CNN网络的2D语义分割,增量式构建的几何3D地图,更新分配给几何三维地图每个部分的类概率。首先,SLAM和CNN语义分割同时进行。在分割阶段,几何边缘地图从当前深度图中获取,利用语义分割结果提高边界分割结果精度从而得到语义感知表达。通过边界地图更新几何3D地图并且递交给当前像平面。最后,利用传递来的分割图更新分配给每个分割区域的类概率。

主要结果

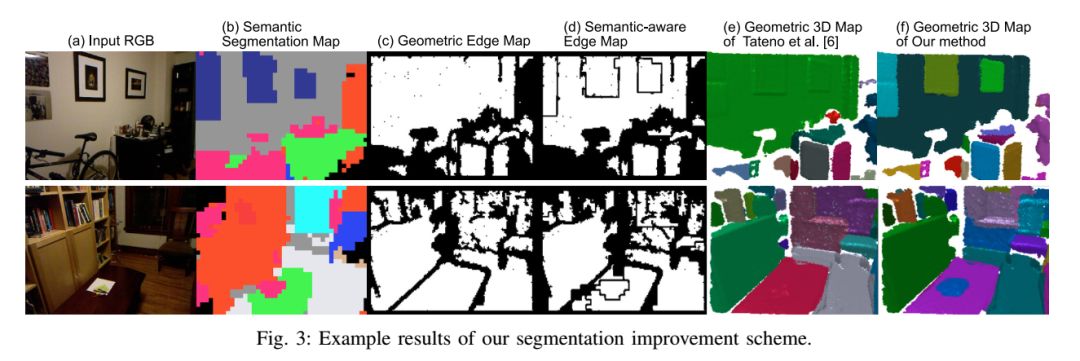

图3 分割改进方案的示例结果

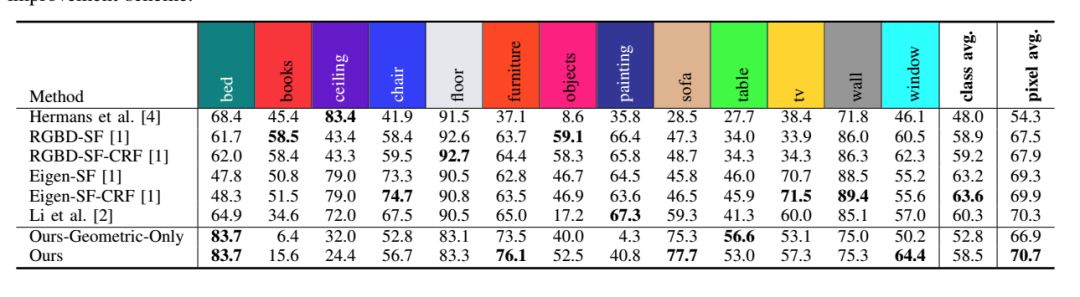

图4 在NYD数据集上测试对比结果

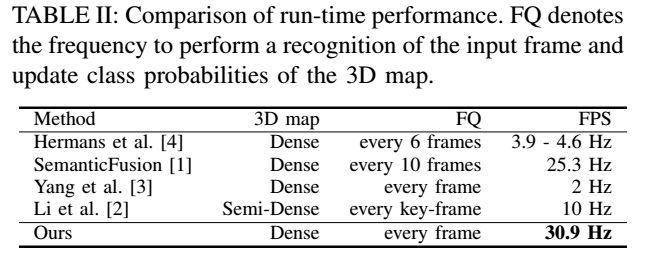

图5 算法实时性对比

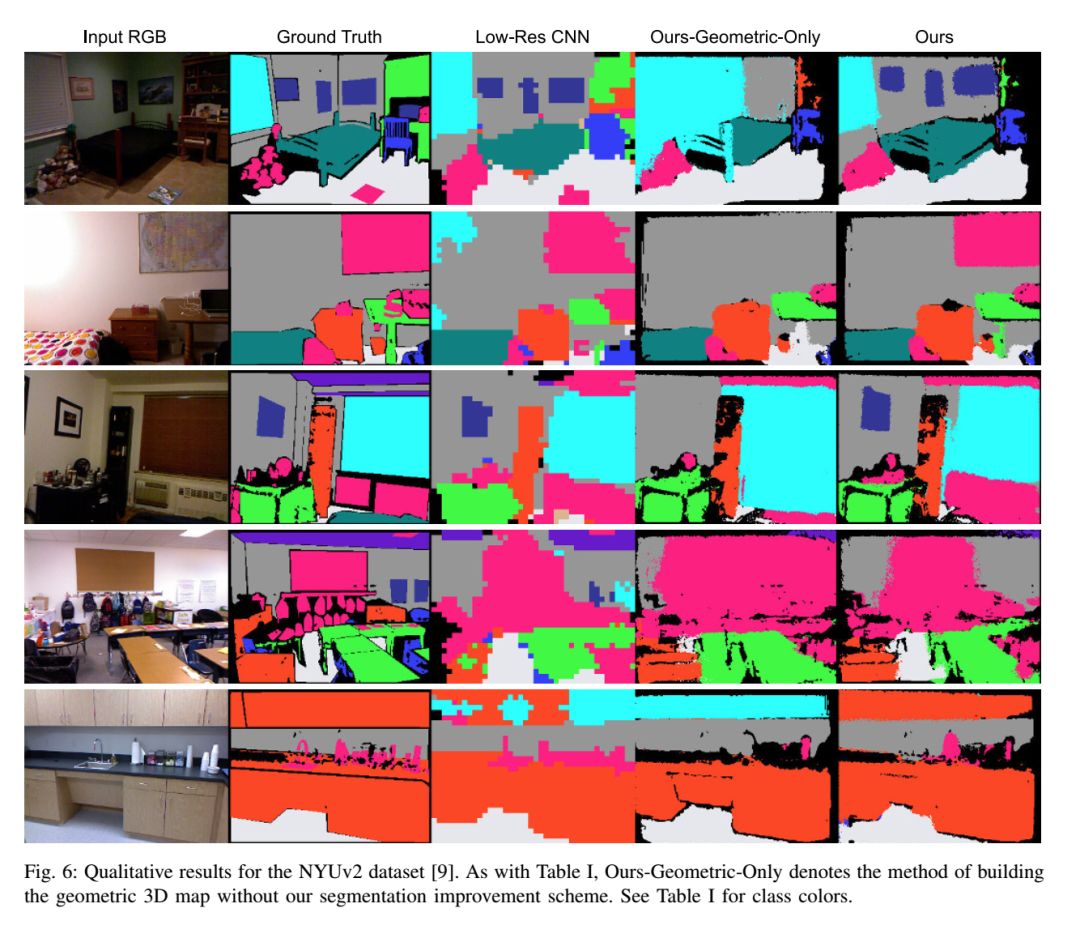

图6 在NYU v2数据集上测试结果

Abstract

We propose an efficient and scalable method for incrementally building a dense, semantically annotated 3D map in real-time. The proposed method assigns class probabilities to each region, not each element (e.g., surfel and voxel), of the 3D map which is built up through a robust SLAM framework and incrementally segmented with a geometric-based segmentation method. Differently from all other approaches, our method has a capability of running at over 30Hz while performing all processing components, including SLAM, segmentation, 2D recognition, and updating class probabilities of each segmentation label at every incoming frame, thanks to the high efficiency that characterizes the computationally intensive stages of our framework. By utilizing a specifically designed CNN to improve the frame-wise segmentation result, we can also achieve high accuracy. We validate our method on the NYUv2 dataset by comparing with the state of the art in terms of accuracy andcomputational efficiency, and by means of an analysis in terms of time and space complexity.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com