NeurIPS 2022 | 利用子图和结点的对称性提升子图GNN

论文链接:

代码链接:

论文介绍

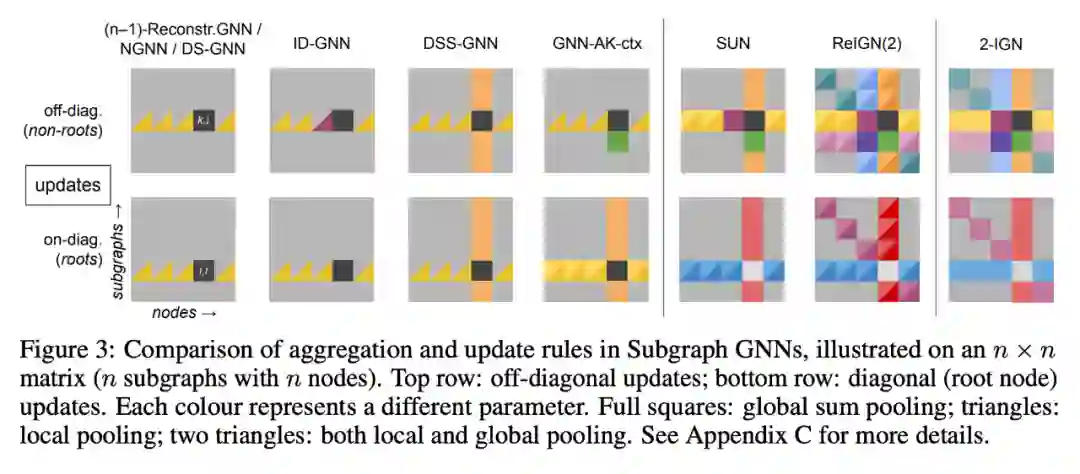

子图 GNN 能够将图建模成为子图的集合。时至今日,对于子图 GNN 结构的设计和其性质的理论分析方向仍有待探索。本文研究了子图方法中最重要的部分——基于结点的子图选择策略,如 ego-network/node marketing/node deletion。本文将子图表达能力的上界界定为 3-WL,并设计了新的子图 GNN 模型,称之为 SUN,在理论上统一了之前的子图模型,并在多个数据集上取得了更优越的表现。

方法

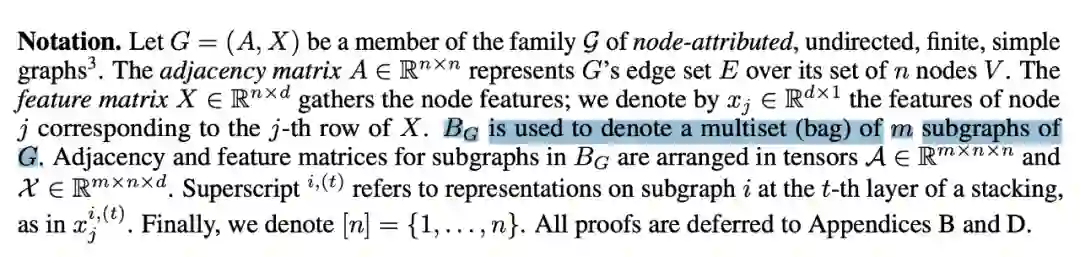

3.1 Subgraph GNNs

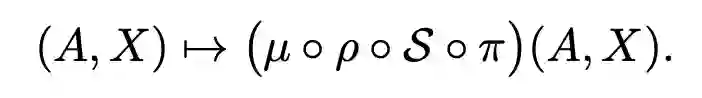

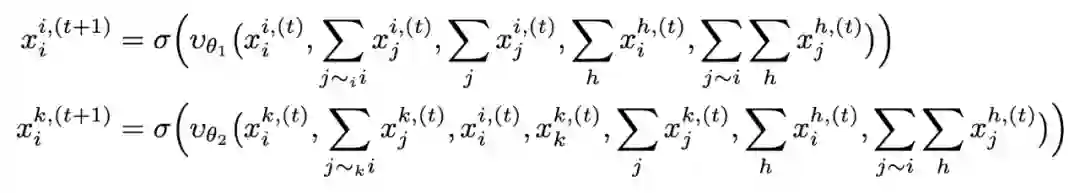

子图 GNN 按如下公式计算图 G 的表示:

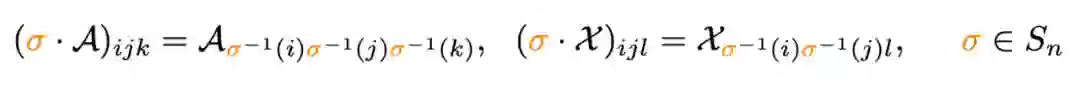

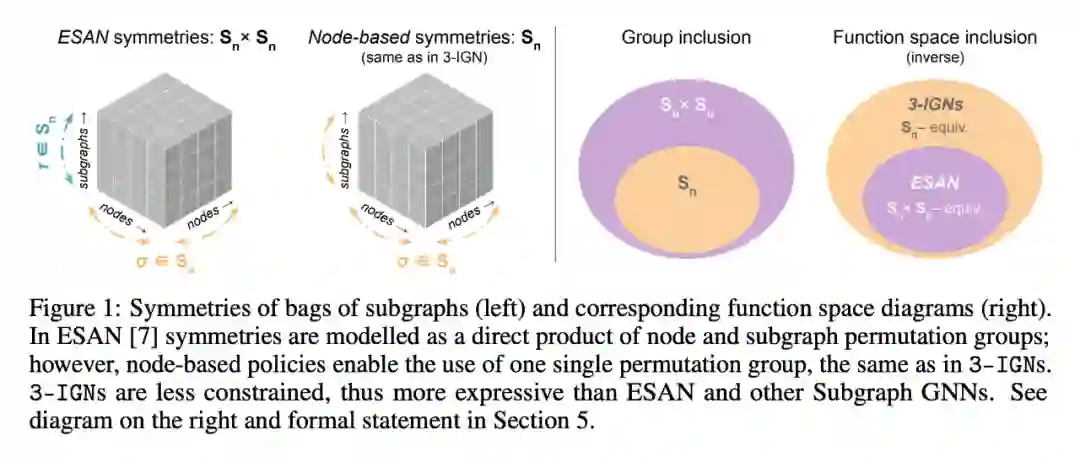

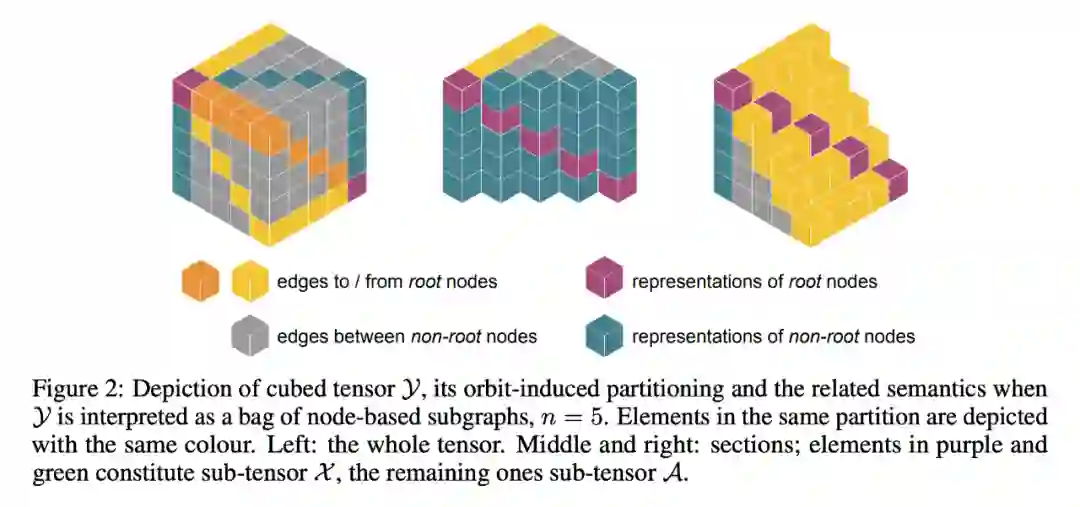

3.2 基于结点的子图选择策略的symmetries

实验

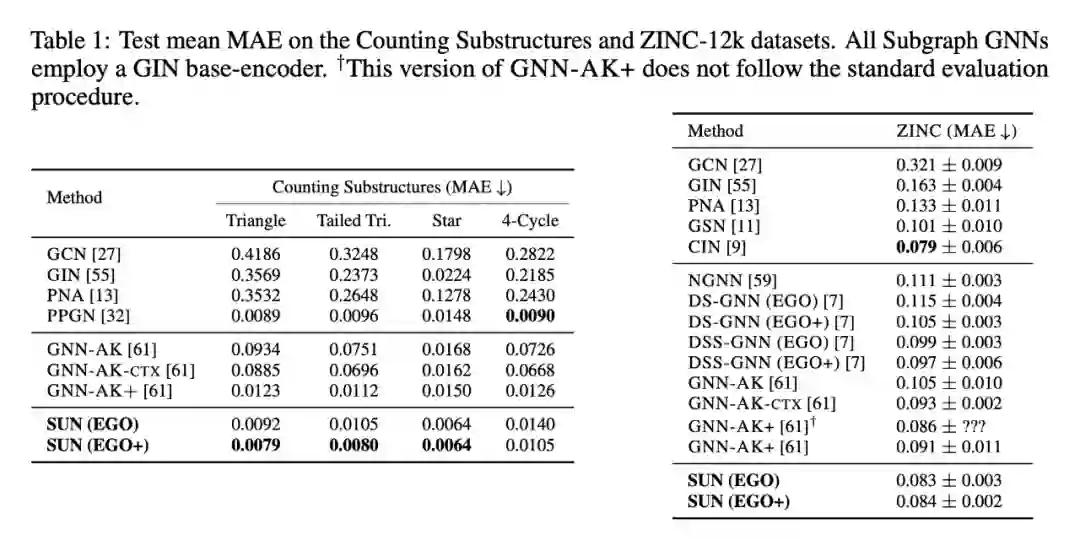

人工数据集上的任务是对图中子结构进行计数,SUN 在 4 个任务中的 3 个上表现都最好;真实数据集采用 ZINC-12k,用 MAE 进行衡量,SUN 取得了 SOTA 的结果。

本文测试了当采取训练数据的一小部分时,模型能否仍有效,即模型的泛化能力如何。

总结

本文的工作对现有子图 GNN 的工作进行了统一和拓展,并界定了这些方法的 expressive power 上界是 3-WL。通过对 expressive power 在 1 & 3-WL 之间的模型进行系统研究,提出了子图 GNN 这一类模型的通用理论。在实验部分,本文额外研究了这些模型的泛化能力,其中 SUN 表现最好。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧