【泡泡图灵智库】模型辅助单目视觉惯性里程计状态估计与稠密建图(IROS)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Model-Aided Monocular Visual-Inertial State Estimation and Dense Mapping

作者:Kejie Qiu and Shaojie Shen

来源:IROS 2017

编译:皮燕燕

审核:杨小育

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——模型辅助单目视觉惯性里程计的状态估计与稠密建图,该文章发表于IROS 2017。

鲁棒的状态估计和实时稠密建图是移动机器人自主导航的两个核心功能。 全球导航卫星系统(GNSS)和视觉测距/ SLAM是用于状态估计的常用方法。但是,在高层建筑物之间或室内环境中工作时,由于天空视野有限或建筑物受阻,GNSS会失效。在没有可靠的闭环检测的情况下,视觉测距/ SLAM长期很容易漂移。对于导航应用而言需要具有全局一致性保证的状态估计方法。对于实时建图,SLAM方法通常会得到稀疏地图,这对于避障和路径规划来说还不够好,而高质量稠密建图对于移动设备来说通常在计算上要求太高。为了实现城市规模的三维模型,在这项工作中,本文改进了以前基于模型的全局定位的工作,并提出了模型辅助的单目视觉惯性里程计的状态估计和稠密建图解决方案。本文首先通过融合视觉惯性测距法和基于模型的定位结果来开发全局一致状态估计器,利用模型中的深度优先级,我们执行具有半全局视差平滑的运动体视。本文的稠密建图流程能够在线检测最初未包含在离线3D模型中的障碍物。本文的方法实时在嵌入式计算机上运行,且验证了实际环境实验中的状态估计和建图精度。

主要贡献

1、本文使用最小的传感和粗略的先验3D模型同时处理全局定位和实时稠密建图问题。

2、本文们将基于模型的全局定位方法与紧耦合的视觉惯性融合方法相结合,以获得具有高局部精度的全时定位。

3 、本文实现了具有先验3D渲染深度的运动体视。

算法流程

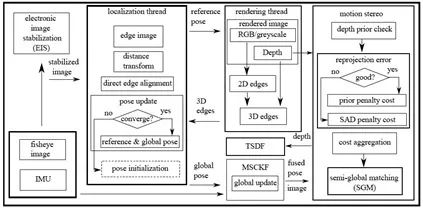

图1 基于模型的全局定位和建图系统的总体架构

1、多视图集成代价

与仅使用两个校准视图进行深度估计的空间体视不同,多个相机视图用于深度估计,其中每个相机帧具有精确的姿态估计。

2、半全局匹配

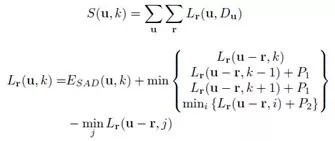

由于全局最小化是一个无法在多项式时间内求解的NP完全问题,因此提出了一种半全局近似如下所示:

3、三维重建

对于使用离散深度图的稠密三维建图,本文应用TSDF来获得不确定性感知表示。

主要结果

1、状态估计结果

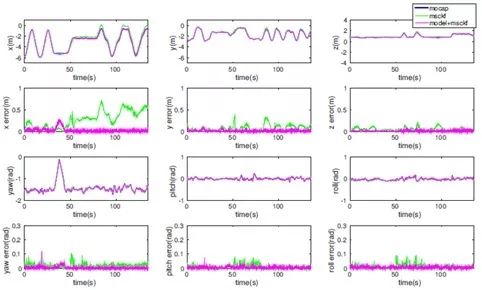

位置,方向比较和误差项如图2所示。与MSCKF相比,融合方法(模型+ MSCKF)产生无漂移的全局定位结果。

图2 MSCKF和MSCKF +模型的位置,姿态的对比结果

2、 建图结果

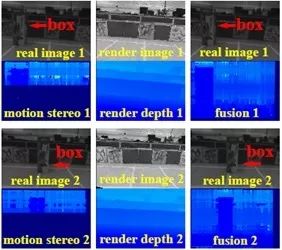

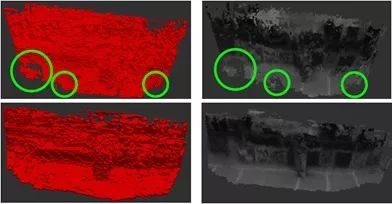

与纯运动体视相比,模型辅助运动体视在无纹理区域(如地面和墙壁)具有更好的估计效果。 详细比较如图3所示,TSDF结果如图4所示。

图3 深蓝色背景表示无效估计的深度估计对比

图4在线建图对比

Abstract

Robust state estimation and real-time dense mapping are two core capabilities for autonomous navigation of mobile robots. Global Navigation Satellite System (GNSS) and visual odometry/SLAM are popular methods for state estimation. However, when working between tall buildings or in indoor environments, GNSS fails due to limited sky view or obstruction from buildings. Visual odometry/SLAM are prone to long-term drifting in the absence of reliable loop closure detection. A state estimation method with global-consistent guarantee is desirable for navigation applications. As for realtime mapping, SLAM methods usually get a sparse map that is not good enough for obstacle avoidance and path-planning, and high-quality dense mapping is often computationally too demanding for mobile devices. Realizing the availability of city-scale 3D models, in this work, we improve our previous work on model-based global localization, and propose a model-aided monocular visual-inertial state estimation and dense mapping solution. We first develop a global-consistent state estimator by fusing visual-inertial odometry with the model-based localization results. Utilizing depth prior from the model, we perform motion stereo with semi-global disparity smoothing. Our dense mapping pipeline is capable of online detection of obstacles that are originally not included in the offline 3D model. Our method runs onboard an embedded computer in real-time. We validate both the state estimation and mapping accuracy in real-world experiments.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com