每周论文推荐-0803

多读论文可以丰富我们的知识、拓展我们的视野,让我们领略其他智者的思想,让我们的思路也变得开阔起来。在此,鼓励大家多多阅读论文,挑些自己感兴趣的论文,仔细体会作者的思想,最好动手多多推研一下公式,相信你一定能收获不少灵感。

奉上本周份的10篇笔者认为不错的论文,希望诸位朋友也能从中有所收获。

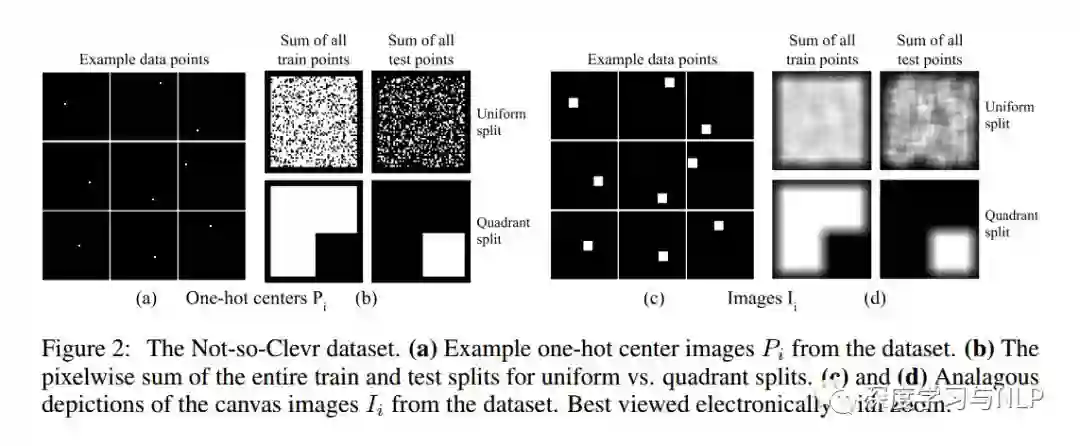

1、An intriguing failing of convolutional neural networks and the CoordConv solution

内容概述:很少有一些新奇的策略能像卷积(Convolution)那样,对深度学习产生如此大的影响。对于涉及像素或空间表示的任何问题,一般都会认为卷积神经网络可能是最合适的。在本文中,我们通过看似微不足道的坐标变换问题(Coordinate Transform Problem)来给出了一个反例,该问题只需要学习( x,y )笛卡尔空间和one-hot像素空间中的坐标。尽管卷积网络看起来似乎很适合解决这项任务,但我们的实验显示结果却恰恰相反。我们先在一个toy problem上验证并分析了失败的原因,并给出了我们的解决方案。我们的解决方法称为CoorConv,它通过使用额外的坐标通道使得卷积可以访问自己的输入坐标。在不牺牲普通卷积的计算和参数效率的情况下,CoorConv允许网络根据最终任务的要求,学习完美的平移不变性(translation invariance)或不同程度的平移依赖性(translation dependence)。CoorConv用比普通的卷积少10 - 100倍的参数,以完美的泛化和150倍的速度解决坐标变换问题(Coordinate Transform Problem)。这种鲜明的对比提出了这样一个问题: 在其他任务中,这种inability of convolution在多大程度上持续存在,从内部潜移默化地阻碍模型的性能?这个问题的完整答案需要进一步研究,但我们初步证明,用CoorConv代替卷积可以对多种任务的模型进行改进。在GAN中使用CoorConv,可以产生较少的模式崩溃(mode collapse),因为高阶的空间延迟(high-level spatial latent)和像素之间的转换变得更容易学习。基于MNIST数据集,Faster R - CNN检测模型显示,当使用CoorConv时,IOU提高了24 %,在增强学习( RL )领域, Playing Atari游戏中,使用CoorConv层可以使agent显著受益。

2、Convergence Problems withGenerative Adversarial Networks (GANs)

内容概述:生成对抗网络( GANs )是一种新的生成建模方法,其目标是学习真实数据的分布。它们经常被证明很难训练: GANs同机器学习中的很多其他技术不同,因为GAN被描述为discriminator和generator之间的双人游戏。这既造成了训练过程中的不可靠性,也造成了我们缺乏对GAN是如何收敛?如果收敛,又会收敛到哪里?等问题的理解。本文主要目的是介绍关于GANs的,比较mathematician的理论,突出正反两方面的结果。这包括如何鉴别训练GANs时存在的问题,以及GANs的拓扑(topology)和博弈论观点(game-theoretic perspectives)是如何帮助我们理解和改进我们近年来的技术的。

3、Feature Selection for Unsupervised Domain Adaptation using Optimal Transport

内容概述:本文基于新兴的最优运输理论(optimal transportation theory),提出了一种新的,用于无监督领域自适应特征选择的方法。我们基于最近关于领域适应性(domain adaptation)中最佳传输(optimal transport)的理论分析,表明optimal transport可以直接给出一种利用域间转移的特征选择过程。在此基础上,我们提出了一种新的算法,旨在通过源域(source domain)和目标域(target domain)之间的相似性对特征进行排序,这种排序是通过分析我们所提出的最优运输问题的解的耦合矩阵(coupling matrix)来获得的。我们在一个著名的标准数据集上评估了我们的方法,并证明了它具有选择正确feature的能力,从而获得更好的分类性能。此外,我们还表明,所提出的算法可以作为现有领域自适应技术的预处理步骤,在保持可比结果的同时,在计算时间方面获得了巨大的加速。最后,在临床影像数据库上对算法进行了验证,并取得了良好的效果。

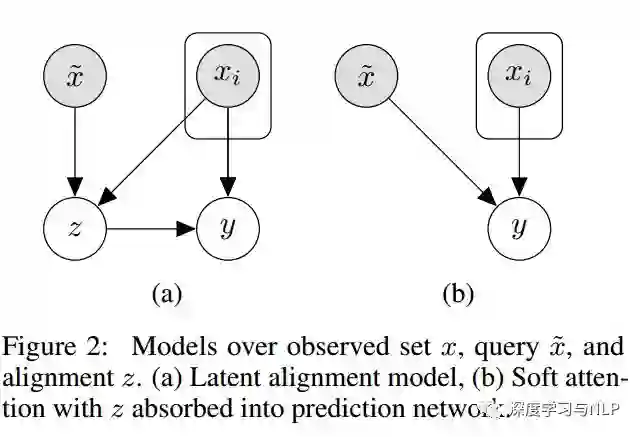

4、Latent Alignment and Variational Attention

内容概述:Neural Attention力已经成为自然语言处理和相关领域中许多最新模型的核心架构。注意力网络(Attention network)是一种易于训练且有效的soft simulating alignment的方法;然而,这种方法在概率意义上并不排斥latent alignment。这种特性使得很难将注意力与其他对齐方法进行比较,难以将其与概率模型组合,也难以根据观察到的数据进行后验推断。另外一个相关的latent方法,即hart attention,解决了这些问题,但通常更难训练,也不太准确。本文主提出了变分注意力网络(variational attention networks),一种基于amortized variational inference的具有更紧密的approximation bounds的,用于替代soft attention和hard attention,学习latent variable alignment的解决方案。我们进一步提出减少梯度方差的方法,使这些方法在计算上可行。实验表明,对于机器翻译和visual question answering,效率低下的exact latent variable models优于标准的神经注意力模型,但当基于hard attention进行训练时,这些增益就消失了。另一方面,变分注意力(variational attention)具有很有优秀的性能,同时训练速度与神经注意力模型相当。

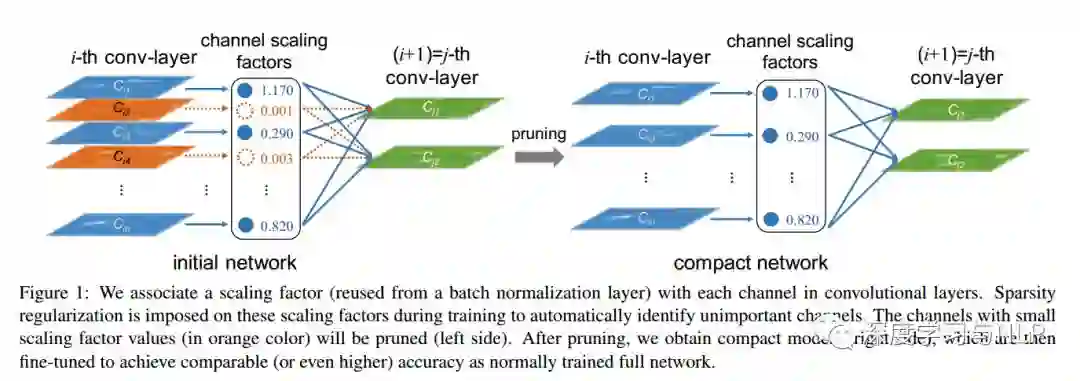

5、Learning Efficient Convolutional Networks through Network Slimming

内容概述:卷积神经网络( CNNs )在许多实际应用中的部署在很大程度上受到其高计算成本的制约。本文提出了一种新的CNNs学习方法,同时实现以下目标: 1 )减少模型规模;2 )减少运行时的内存占用;3 )在不影响精度的情况下,减少计算操作的次数。这是通过在网络中以简单而有效的方式加强信道级的稀疏性(channel-level sparsity)来实现的。与现有的许多方法不同,该方法直接应用于CNN体系结构中,将训练过程的开销减到最小,并且所得到的模型不需要特殊的软硬件加速器。我们称之为“网络瘦身(network slimming)”方法,它以大而广的网络为输入模型,但在训练过程中,会自动识别不重要的通道(channels)并在训练结束后进行修剪,从而产生具有相当精确度且轻薄紧凑的模型。我们使用VGGNet、ResNet和densent等多种典型CNN模型,在各种图像分类数据集上实验验证了我们方法的有效性。对于VGGNet来说,network slimming使模型大小减少了20倍,计算操作减少了5倍。

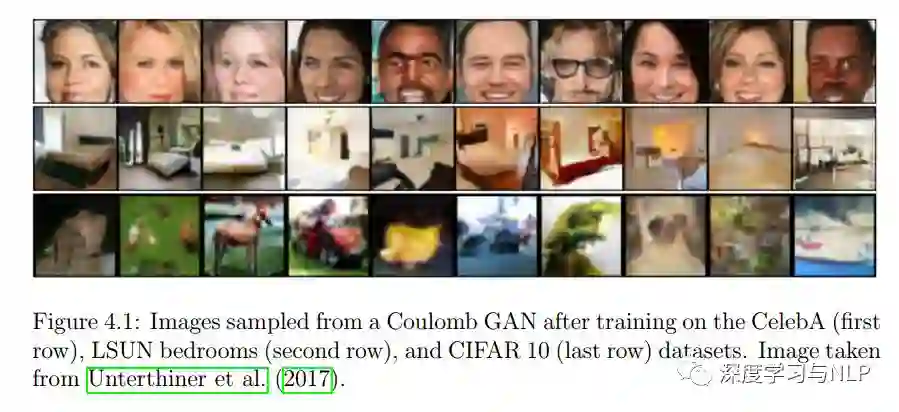

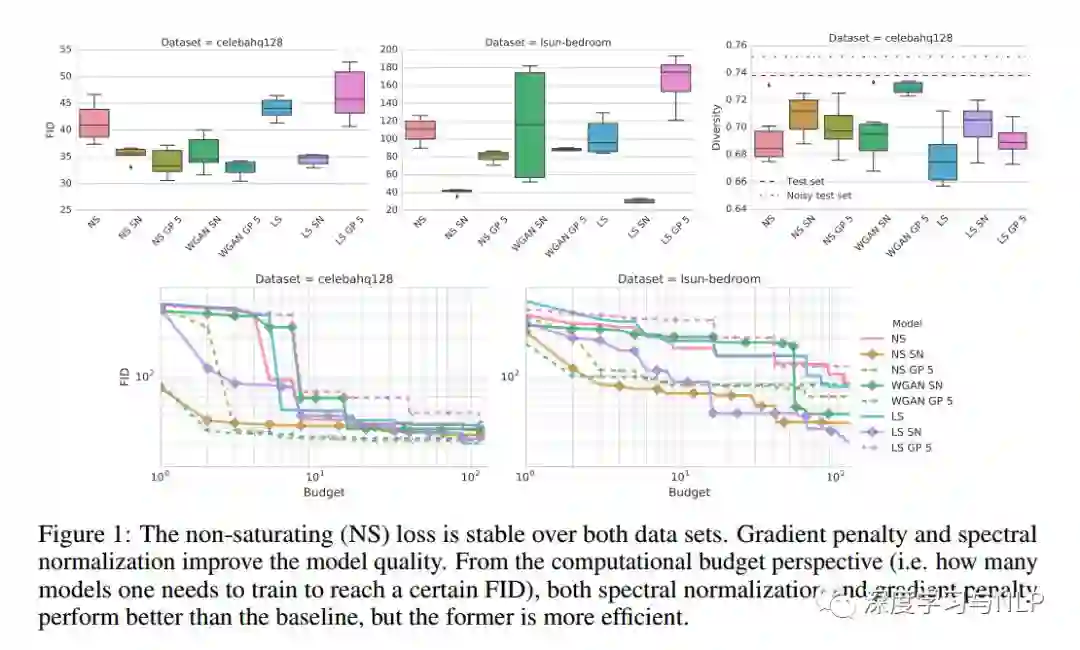

6、The GAN Landscape: Losses, Architectures, Regularization, and Normalization

内容概述:生成对抗性网络( GANs )是一种深层生成模型(deep generative model),旨在以无监督的方式学习目标分布(target distribution)。虽然GAN成功地应用于许多问题,但众所周知,训练GAN是一项的很具挑战性的任务,需要大量的超参数调整(hyperparameter tuning)、神经架构工程和大量琐碎的“trick”。许多成功的实际应用,加上缺乏对于GANs失败可能性的量化,导致了大量proposed losses、正则化和归一化方案以及神经架构。在这项工作中,我们从实际的角度出发,清醒地看待GAN的现状。我们再现了GAN当前的状况,并对其未来发展进行了适当的探索。我们讨论常见的pitfall和raproducibility issues,在Github上开源我们的代码,并在TensorFlow Hub上提供预先训练的模型。

7、Towards more Reliable Transfer Learning

内容概述:多源迁移学习(Multi-source transfer learning)已被证明在目标内标记数据(within-target labeled data)稀缺的情况下是有效的。以前的工作主要集中在利用域相似性,并且假设source domain被丰富地或者至少是相对地标记。尽管这一强有力的假设在实践中从未成立,但本文适当忽略这一假设,着力于解决与不同标签量和不同的可靠性来源相关的挑战。第一个挑战是融合领域相似性(domain similarity)和源可靠性(source reliability),提出一种新的迁移学习方法,它可以同时利用源-目标相似性和源间关系。第二个挑战主要关于pool-based的主动学习(active learning),其中Oracle仅在源域中可用,从而形成了一个集成的主动迁移学习框架,其中包括分布匹配(distribution matching)和不确定性采样。在合成数据集和两个真实数据集上的大量实验有力证明,我们提出的方法优于包括state-of-art的迁移学习方法在内的多种baseline。

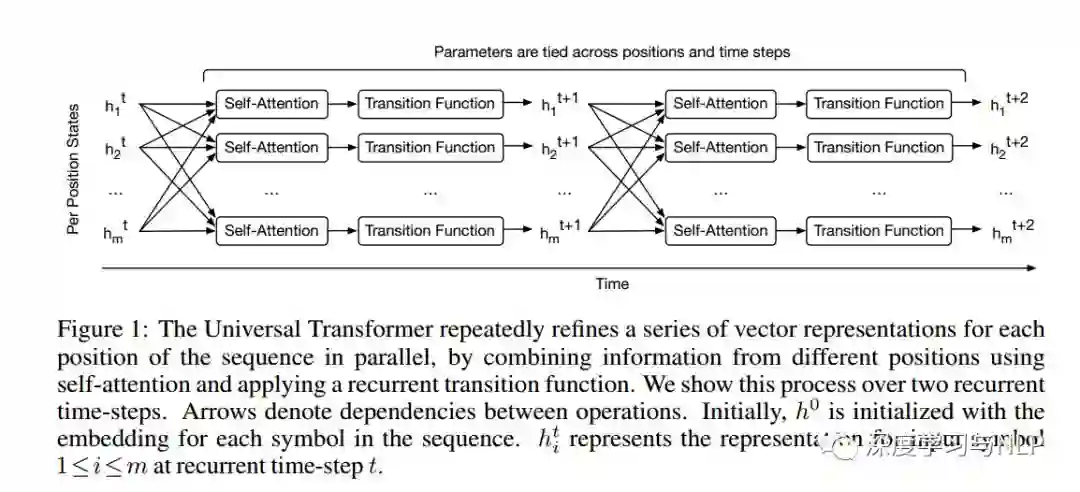

8、Universal Transformers

内容概述:Self-attentive前馈序列模型已经在序列建模任务上获得了令人惊艳的成绩,包括机器翻译、图像生成和句法分析,从而被认为可以替代传统的递归神经网络( RNNs ),而RNNs至今仍是解决许多序列建模问题的标准架构。然而,虽然取得了这些成功,但像Transformer这样的前馈序列模型任然未能获得广泛使用,因为有些问题用RNN处理非常容易,但Transformer却不行(比如,Transformer没法实现拷贝机制(copy mechanism);并且,在推理(inference)阶段,遇到比trainin corpus中更长的句子时,Transformer没法处理)。此外,与RNNs相比,Transformer的计算速度更慢,这限制了其实际应用。本文提出了一种通用Transformer,它不仅能解决以上所以实践或理论上存在的问题,并在几个任务上都获得了性能的提高。通用Transformer不像RNNs那样,每次recurring只处理一个symbol,而是所有已经执行过的所有recurrent step都会参与计算,对每个step的representation都会进行revise。为了融合来自序列不同部分的信息,通用Transformer在每个recurrent step都采用self-attention mechanism。假设有足够的内存,通用Transformer的recurrence特性将提升它的计算效率。此外,我们还采用了自适应计算时间(adaptive computation time, ACT )机制,允许模型动态调整序列中每个位置的representation的修改次数。除了节省计算量,我们还表明ACT可以提高模型的精度。我们的实验表明,在各种算法任务和多种大规模语言理解任务上,通用Transformer的泛化效果明显优于普通Transformer和机器翻译中的LSTM模型,在bAbI推理任务和具有挑战性的LAMBADA语言建模任务上取得了最新的成绩。

9、Recent Advances in Deep Learning: An Overview

内容概述:深度学习是机器学习和人工智能研究的最新方向之一。也是当下最流行的科研方向之一。深度学习方法给计算机视觉和机器学习带来了革命性的进步。时不时地就会有新的深度学习技术诞生,超越最好的机器学习甚至是现有的深度学习技术。近年来,深度学习技术取得了许多重大突破。由于深度学习技术正高速发展,特别是对于新入门深度学习领域的研究人员来说,很难follow该领域新的一些技术。在本文中,我们将简要讨论下过去几年来深度学习的最新进展。

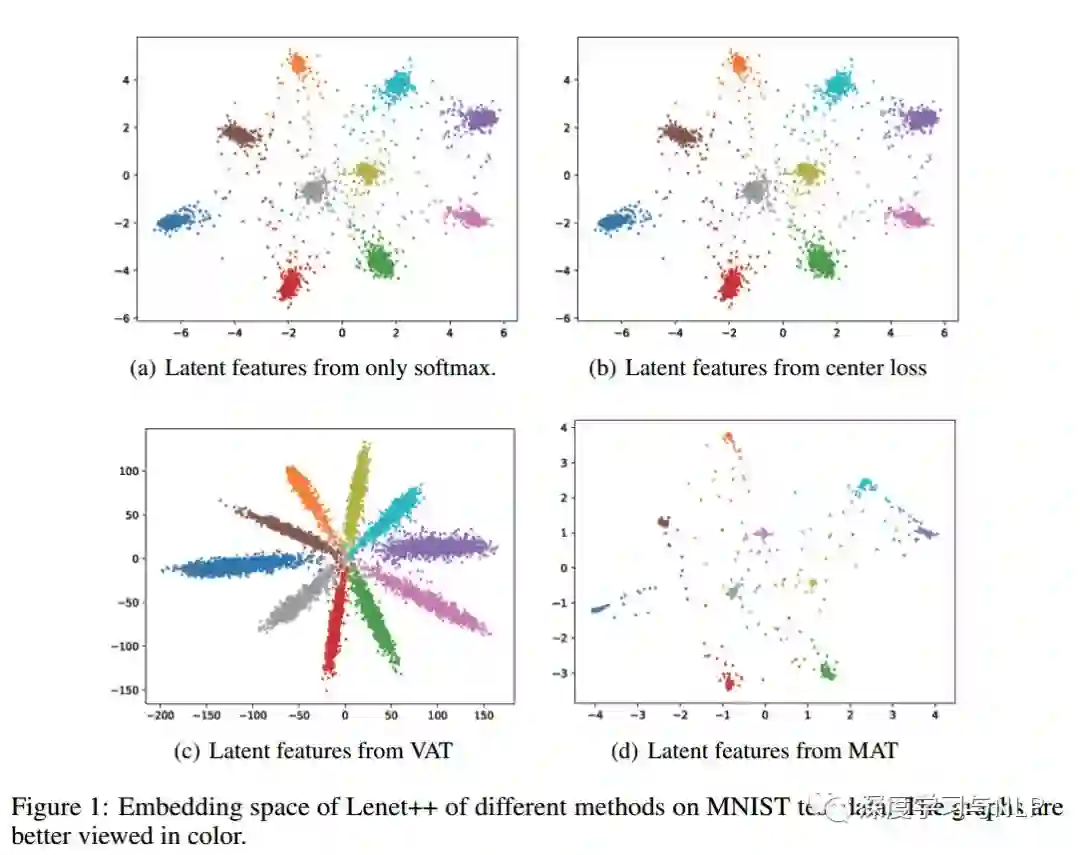

10、Manifold Adversarial Learning

内容概述:最近提出的对抗训练方法提升了模型对对抗样本的鲁棒性,并在很多监督和半监督领域中取得了很多最优的结果。但所有现有的对抗训练方法都只考虑了最糟糕的干扰例子(即,对抗性例子)如何影响模型输出,所以,尽管他们取得了成功,但这种方法只针对极端样本,明显缺乏普适性。在本文中,我们提出了一种新的对抗学习方法,称为流形对抗性训练(Manifold Adversarial Training, MAT )。MAT是基于最坏的扰动(perturbation)如何影响manifold而不是output space来构建一个对抗学习框架。首先得到一个具有高斯混合模型( Gaussian Mixture Model, GMM )的latent data space。一方面,MAT试图以最坏的方式扰动输入样本,使其通过distribution manifold。另一方面,深度学习模型经过训练,试图在潜在空间中提升流形平滑度(manifold smoothness),并通过Gaussian mixture的变化(给定数据点周围的局部扰动)来测量。更重要的是,由于潜在空间比输出空间更具信息性(more informative),因此所提出的MAT可以学习到更健壮紧凑的数据表示,从而进一步提高性能。在三个基准数据集上进行了一系列有监督和半监督的实验,结果表明,所提出的MAT能够取得显著的性能提升,远优于目前最优的对抗性方法。

往期精彩内容推荐

基于深度学习的文本分类6大算法-原理、结构、论文、源码打包分享

模型汇总15 领域适应性Domain Adaptation、One-shot/zero-shot Learning概述

模型汇总-12 深度学习中的表示学习_Representation Learning

斯坦福大学2017年-Spring-最新强化学习(Reinforcement Learning)课程分享

DeepLearning_NLP

深度学习与NLP

商务合作请联系微信号:lqfarmerlq