聊一下 Wide & Deep

1. 什么是记忆能力与泛化能力

1.1记忆能力

Memorization can be loosely defined as learning the frequent co-occurrence of items or features and exploiting the correlation available in the historical data.

-

从历史数据中学习共现的物体/特征组合--->这就对应到上面谈到的经验规律 -

在预测的时候利用到这种学习到的这种相关性--->这就对应到上面谈到的对经验的遵守。

Recommendations based on memorization are usually more topical and directly relevant to the items on which users have already performed actions.

1.2泛化能力

Generalization, on the other hand, is based on transitivity of correlation and explores new feature combinations that have never or rarely occurred in the past.

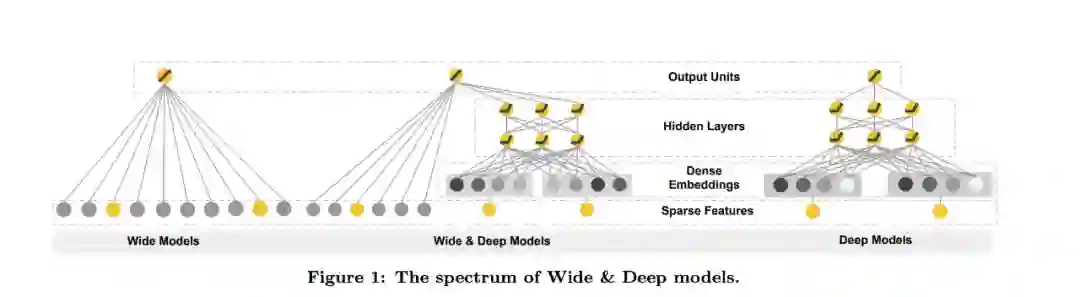

2.模型架构图

-

原始特征 -

特征交叉之后的特征(特征交叉之前各自特征需要one-hot)

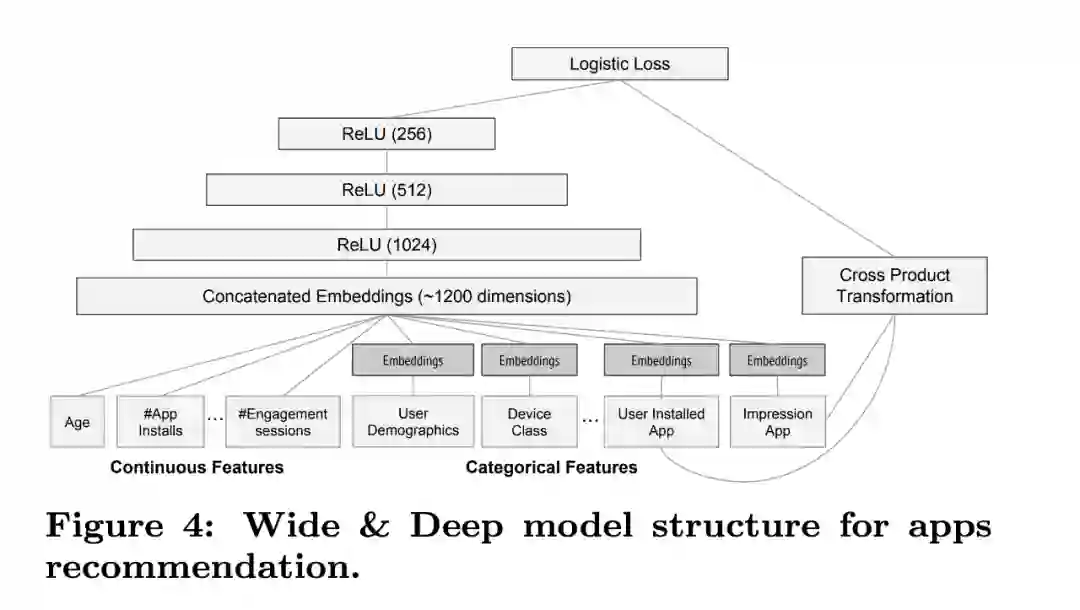

3.实践

3.1 实践架构

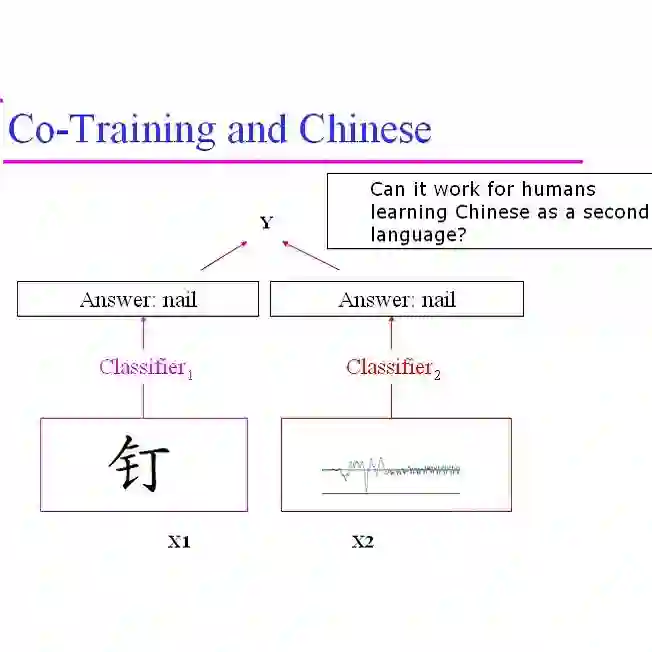

3.2 多模态特征的加入

-

Text 和 Image 的 embedding 向量,采用 和Wide模型一样的方式加入到整体模型中就可以了。至于 两者的Embedding向量如何获取,就看你自己了。 -

Text和Image之间使用attention之后再加入 -

Text和Image 和Deep 模型的输出拼接之后再做一次处理 -

多看 Paper-给个关键词: Multimodal Fusion

3.3 特征工程小记录

后记

由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:

(1)点击页面最上方"AINLP",进入公众号主页。

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

感谢支持,比心

推荐阅读

征稿启示| 200元稿费+5000DBC(价值20个小时GPU算力)

完结撒花!李宏毅老师深度学习与人类语言处理课程视频及课件(附下载)

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

文本自动摘要任务的“不完全”心得总结番外篇——submodular函数优化

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

阅读至此了,分享、点赞、在看三选一吧🙏

登录查看更多