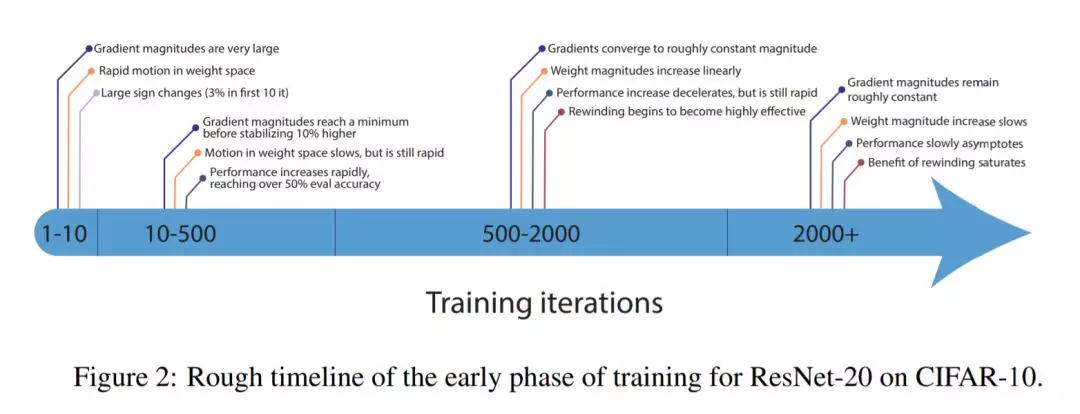

最近的研究表明,神经网络学习的许多重要方面都发生在训练的最早阶段。例如,稀疏的、可训练的子网络出现(Frankle et al., 2019),梯度下降移动到一个小的子空间(guri - ari et al., 2018),网络经历一个关键时期(Achille et al., 2019)。在这里,我们检查了深层神经网络在早期训练阶段所经历的变化。在这些早期的训练迭代中,我们对网络状态进行了广泛的测量,并利用Frankle等人(2019)的框架来定量探测权重分布及其对数据集各个方面的依赖。我们发现,在这个框架中,深度网络在保持符号的同时,对随机权值的重新初始化不够健壮,并且即使经过几百次迭代,权值的分布仍然是非独立的。尽管存在这种行为,使用模糊输入或辅助自监督任务的预训练可以近似监督网络中的变化,这表明这些变化并不是固有的标签依赖,尽管标签显著地加速了这一过程。综上所述,这些结果有助于阐明在学习的关键初始阶段所发生的网络变化。

成为VIP会员查看完整内容

相关内容

专知会员服务

34+阅读 · 2020年2月27日