【泡泡一分钟】对有限训练数据进行语义分割

每天一分钟,带你读遍机器人顶级会议文章

标题:Semantic Segmentation from Limited Training Data

作者:A. Milan, T. Pham, K. Vijay, D. Morrison, A. W. Tow, L. Liu, J. Erskine, R. Grinover, A. Gurman, T. Hunn, N. Kelly-Boxall, D. Lee, et al.

来源:2018 IEEE International Conference on Robotics and Automation (ICRA)

编译:王嫣然

审核:颜青松,陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

我们在杂乱的场景中展示了我们的机器感知方法,从而赢得了最近的2017年亚马逊机器人挑战赛(ARC)。除了具有光泽和透明表面的小物体之外,2017年竞赛的最大挑战是引入不可见的类别。与需要大量标签数据和数小时训练的传统方法不同,这里的任务是在几分钟内完成数据采集和训练过程,获得一个健壮的感知管道。

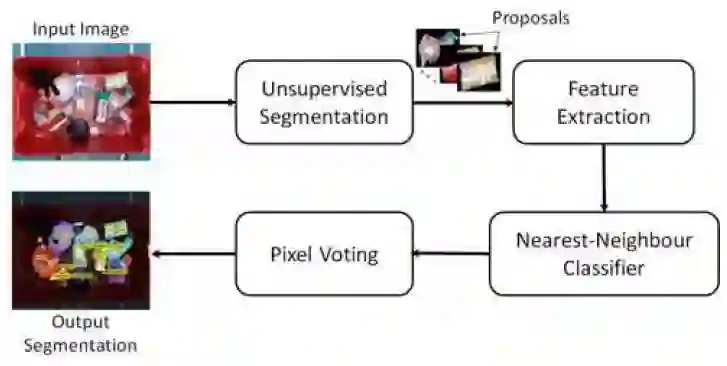

为此,我们提出了两种策略。一种是深度度量学习方法,分为三个独立的步骤:语义无关的边界检测、补丁分类和像素级投票。另一种是具有高效数据收集能力的全监督语义分割方法。

图1 深度度量学习方法框架。

图2 具有全局损失的三重全监督卷积神经网络分割方法框架。

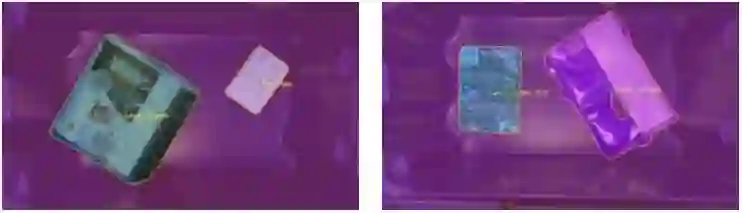

图3 自动分割结果范例。右边显示了一个失败示例,其错误地将项目的红色部分视为背景。这种故障情况可由人工操作人员手动纠正。

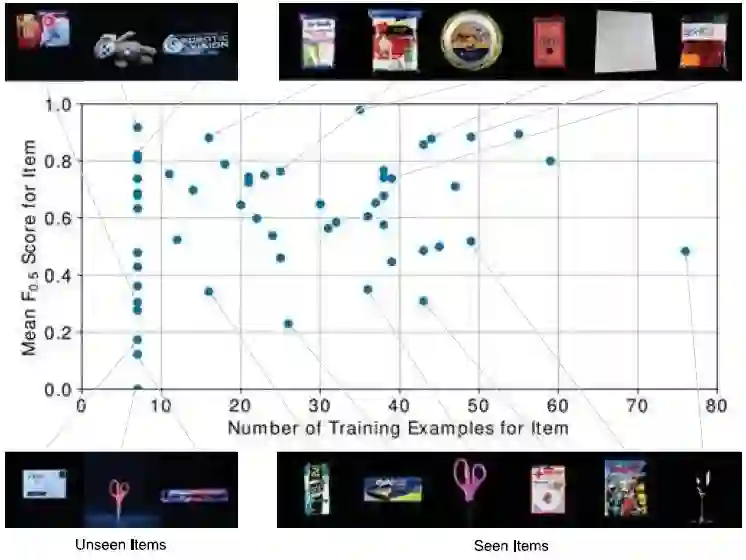

图4 根据可用训练样本的数量对每类别表现进行详细分析结果示例。

我们使用ARC 2017数据集对这两种方法进行了大量分析。有趣的是,为完成这个特定任务,即使是面对非常深的卷积神经网络,每个类中也只有少数例子能够用来进行微调。

Abstract

We present our approach for robotic perception in cluttered scenes that led to winning the recent Amazon Robotics Challenge (ARC) 2017. Next to small objects with shiny and transparent surfaces, the biggest challenge of the 2017 competition was the introduction of unseen categories. In contrast to traditional approaches which require large collections of annotated data and many hours of training, the task here was to obtain a robust perception pipeline with only few minutes of data acquisition and training time. To that end, we present two strategies that we explored. One is a deep metric learning approach that works in three separate steps: semantic-agnostic boundary detection, patch classification and pixel-wise voting. The other is a fully-supervised semantic segmentation approach with efficient dataset collection. We conduct an extensive analysis of the two methods on our ARC 2017 dataset. Interestingly, only few examples of each class are sufficient to fine-tune even very deep convolutional neural networks for this specific task.

如果你对本文感兴趣,请点击点击阅读原文下载完整文章,如想查看更多文章请关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

百度网盘提取码:qidg

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com