一文总览由信息论中“熵”引申出来的各种距离/差异度量

©作者 | 张维鸿

单位 | 中科院深先院

研究方向 | 计算生物学、迁移学习

信息熵

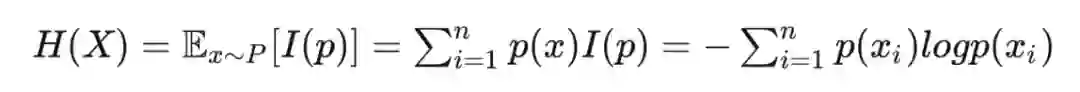

1.1 熵Entropy

假设事件 共有 种可能,发生 的概率为 ,那么事件 的熵定义为:

聪明的读者不难发现,熵就是事件 的信息量的期望,以概率 对事件的所有可能性加权的和。

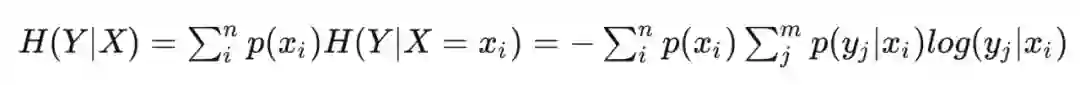

1.2 条件熵Conditional Entropy

对于两个事件 ,条件熵是已知一个事件(如 )时另一个事件(如 )剩余的信息量:

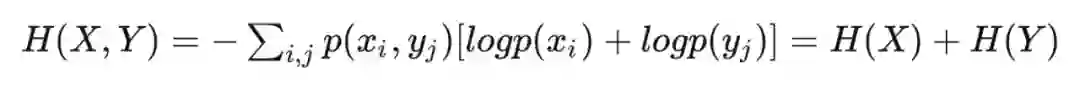

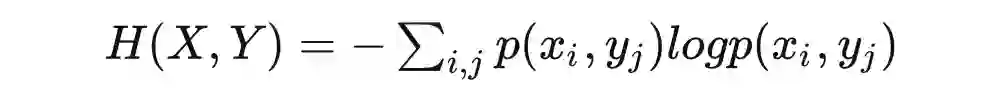

1.3 联合熵Joint Entropy

联合概率 对应的联合事件的熵:

当事件, 独立时,由 知:

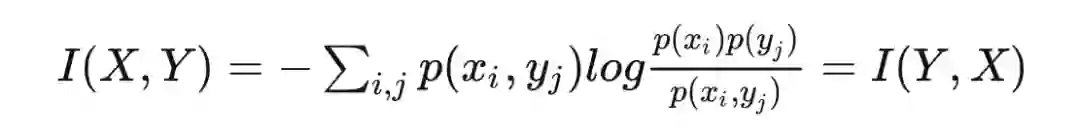

1.4 互信息Mutual Information

事件 重合部分的信息量, 的 intersection,定义为:

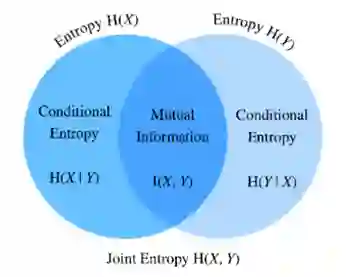

关系辩解

-

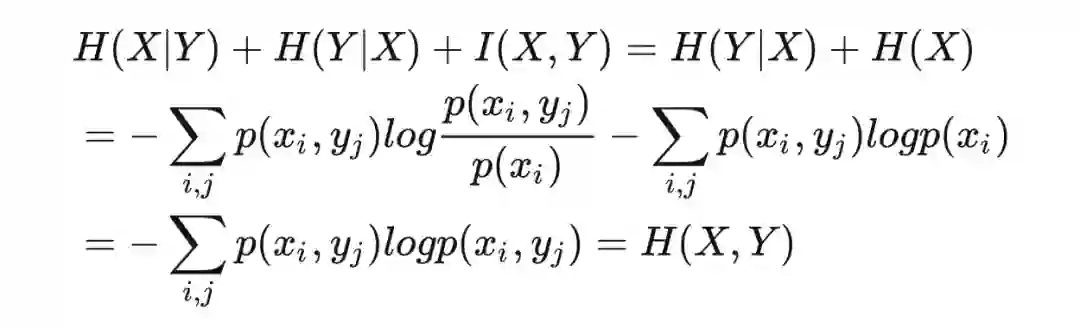

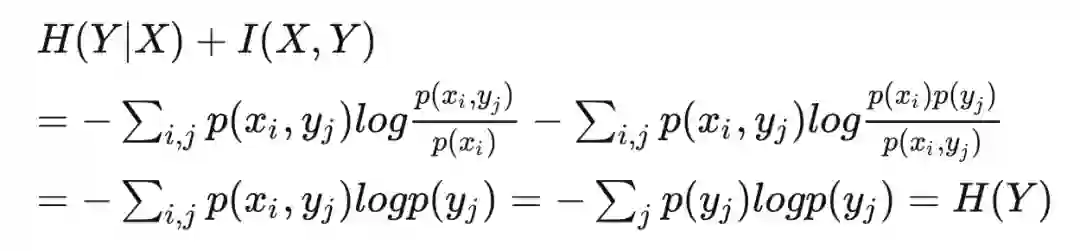

条件熵+互信息=熵(CE + MI = E)

-

熵+条件熵=联合熵(CE1 + CE2 + MI = EI + CE2 = JE)

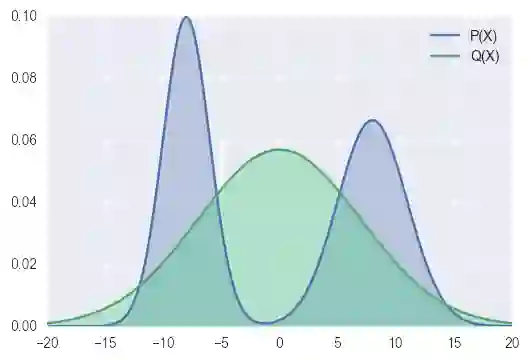

差异度量(KL+)

信息熵可以衡量已知一个事件后另一个事件中未知的信息量,未知的信息量越少则两个事件重合度越高,从而,信息熵可以拓展到度量两个分布的距离/差异。

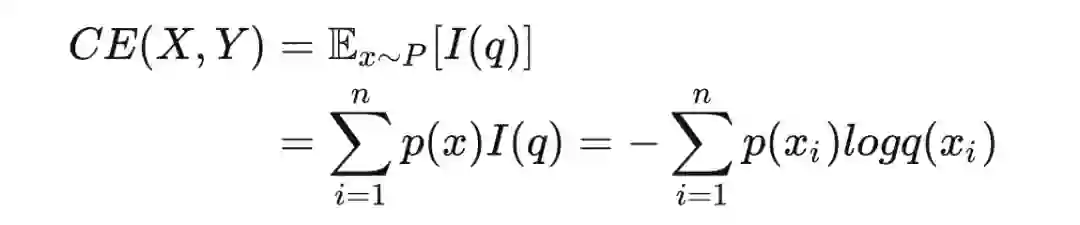

2.1 交叉熵Cross Entropy

回顾1.1中,熵是事件 的信息量的期望,即对事件的所有可能性加权和。假设事件 有真实分布 预测分布 ,

交叉熵的“交叉”体现在用真实分布概率 加权预测分布的信息量 :

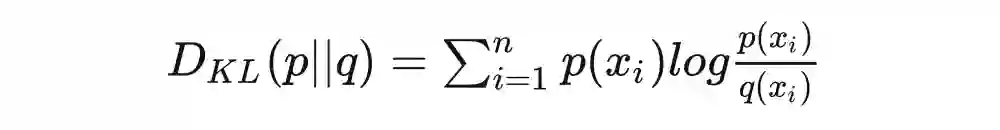

2.2 KL散度Kullback-Leibler Divergence(相对熵Relative Entropy)

相对熵的关键在于“相对”,“相对”体现在真实分布与预测分布的概率之比 ,以真实分布概率加权,(前向)KL 散度定义为:

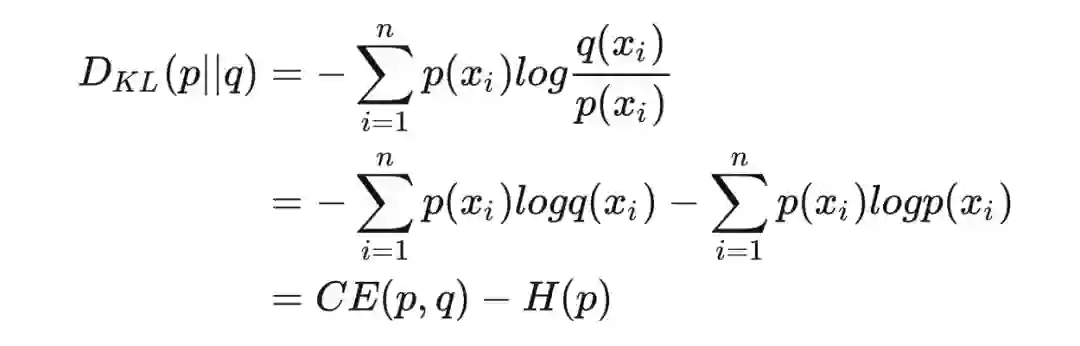

也即:KL散度 = 交叉熵 - 熵

显然,KL 散度不满足对称性,也不满足三角不等式,所以KL散度并不是距离。

✔ 值得注意的是:

在实际应用场景中,真实分布是确定的,故 H(p) 是常数,所以 KL 散度与交叉熵仅相差一个常数,从而,在分类任务中,评估预测分布与真实分布的差异可以用交叉熵损失度量。这就是有监督多分类任务一般用交叉熵损失而不用 KL 散度作为目标函数优化的原因。

相对熵的一些理解:

-

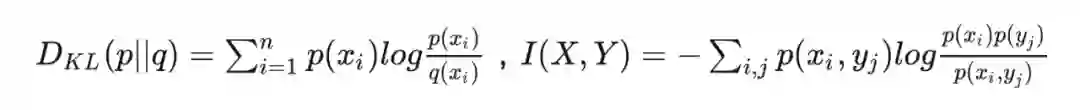

KL 散度 与互信息 的关系:

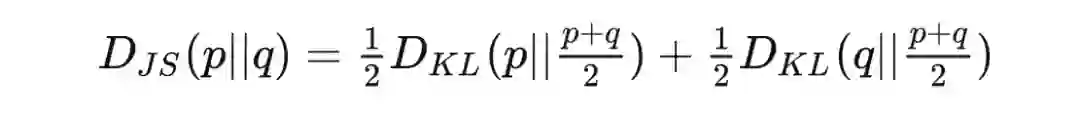

2.3 JS散度Jensen-Shannon Divergence

其它

Wasserstein距离

⌈最优传输OT和p-Wasserstein距离的简介⌋见笔者文章:

⌈最优传输的Python应用实现⌋见笔者文章:

https://zhuanlan.zhihu.com/p/573158960

参考文献

[1] KL散度衡量的是两个概率分布的距离吗?

https://www.zhihu.com/question/345907033/answer/2200649796

[2] 工具人66号:进阶详解KL散度

https://zhuanlan.zhihu.com/p/372835186

[3] KevinCK:交叉熵、相对熵(KL散度)、JS散度和Wasserstein距离(推土机距离)

https://zhuanlan.zhihu.com/p/74075915

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧