ICLR 2022最佳论文:基于对比消歧的偏标签学习

©作者 | 张欣

单位 | 香港理工大学

研究方向 | 图神经网络、自监督学习

论文标题:

PiCO: Contrastive Label Disambiguation for Partial Label Learning

Haobo Wang, Ruixuan Xiao, Yixuan Li, Lei Feng, Gang Niu, Junbo Zhao

ICLR 2022

https://arxiv.org/abs/2201.08984

https://github.com/hbzju/PiCO

Background

Motivation

Method

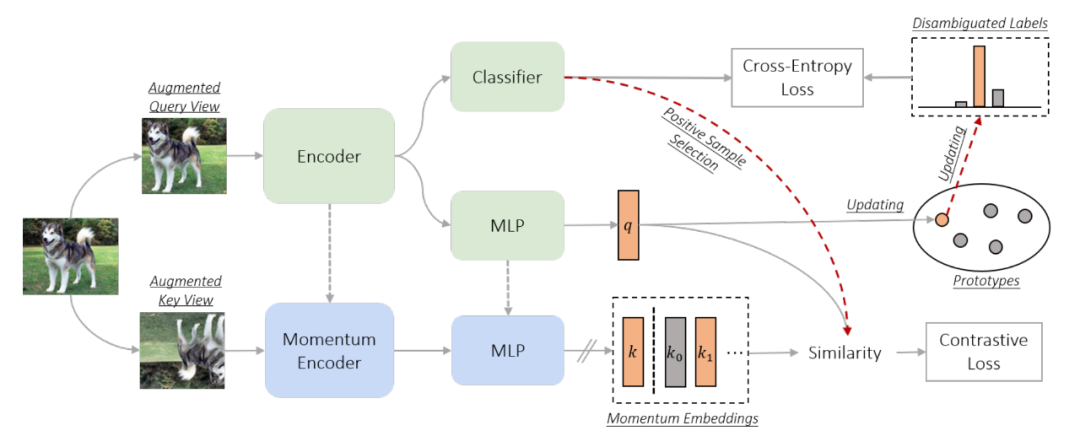

▲ 图2. PiCO的框架图

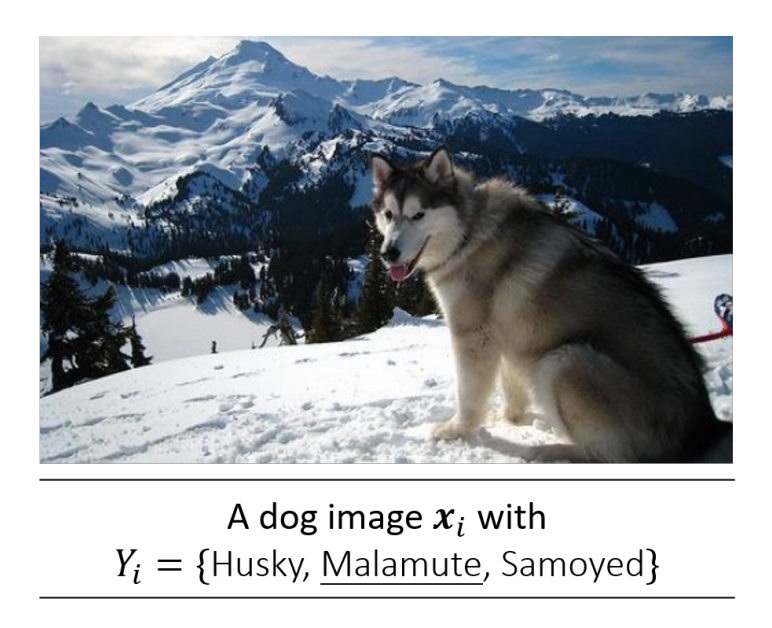

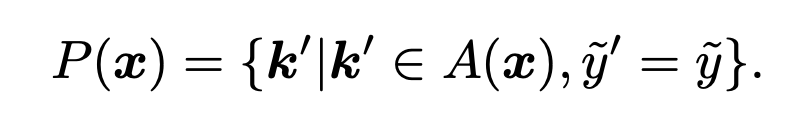

然而,在 PLL 的框架下,由于我们没有真实标签 (ground-truth label),构建正样本对就没那么简单 (straightforward)。以下内容仅对如何在 PLL 中构建正样本对集进行介绍,对传统 PLL 和对比性学习的目标函数 和 不多做赘述,有兴趣的读者可以自行阅读原文。

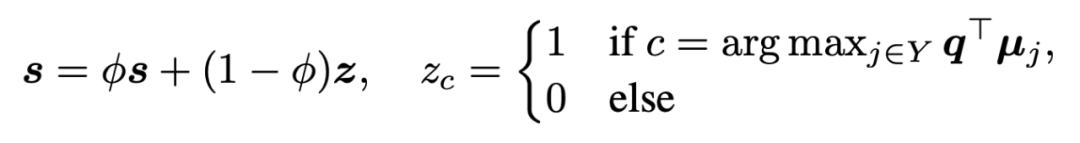

▲ 公式1

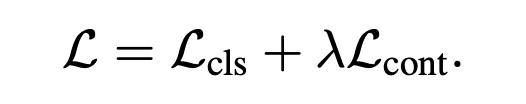

把这一切放在一起,我们共同 (jointly) 训练分类器 (classifier) 和对比网络 (contrastive network),总的损失函数为:

尽管如此,我们想要利用 CL 学习高质量表征 (high-quality representation) 的目标仍然依赖于准确的分类器预测来构建正样本集,这仍然无法解决标签模糊性 (label ambiguity) 的问题。为此,我们进一步提出了一种基于对比性表征 (contrastive embeddings) 的标签消歧机制 (label disambiguation mechanism),并表明这两个组成部分是互惠互利的 (mutually beneficial)。

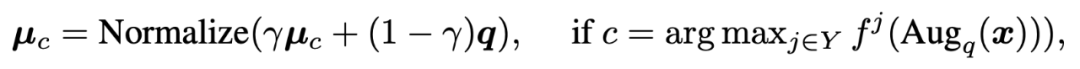

3.2 Prototype-based label disambiguation

▲ 公式3

▲ 公式4

Experiment

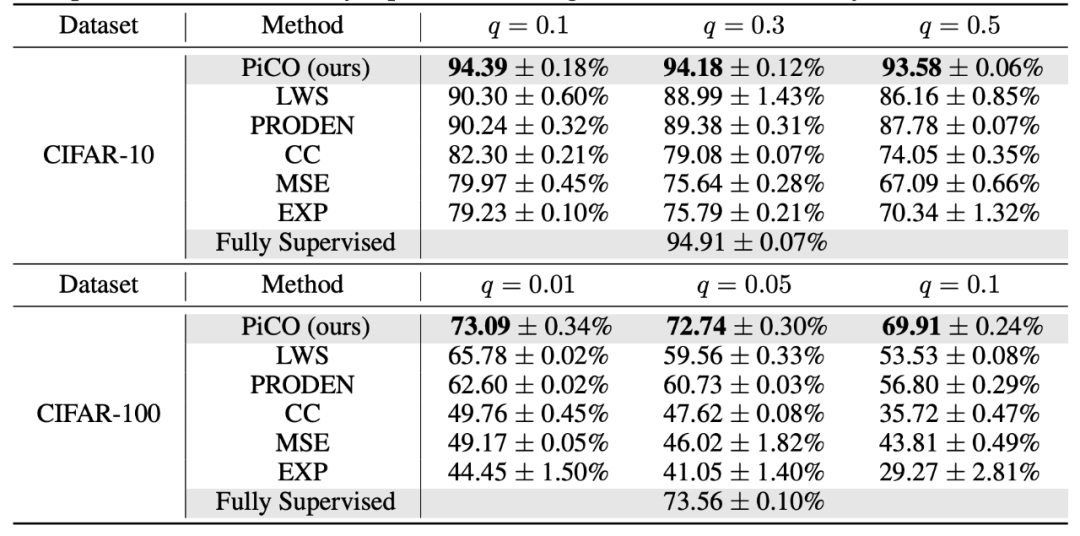

4.1 Main Empirical Results

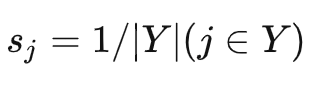

▲ 图3. 图像表征的可视化。不同的颜色代表对应的类别 (class)

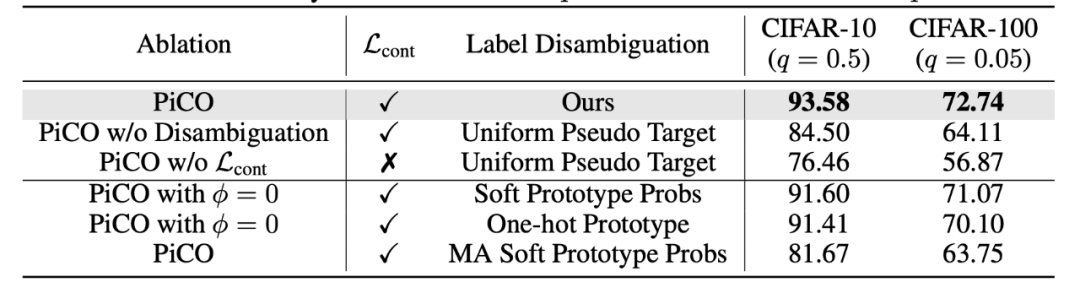

4.2 Ablation studies

▲ 表2. 消融实验的实验结果

(3) 移动平均软典型表征策略 (MA Soft Prototype Probs):使用移动平均 (moving-average) 技术来逐步更新类概率 (soft probabilities) 作为伪标签 (pseudo target)。

实验结果如表 2 所示,我们可以看到,直接使用独热/软典型表征策略都会得到还不错的表现 (competitive result)。但是移动平均软典型表征策略表现不佳,这表明软标签分配在识别真实标签方面不可靠。最后,PiCO 在两个数据集上的准确率都超过了最佳变体≈2%,这显示了我们标签消歧策略的优越性。

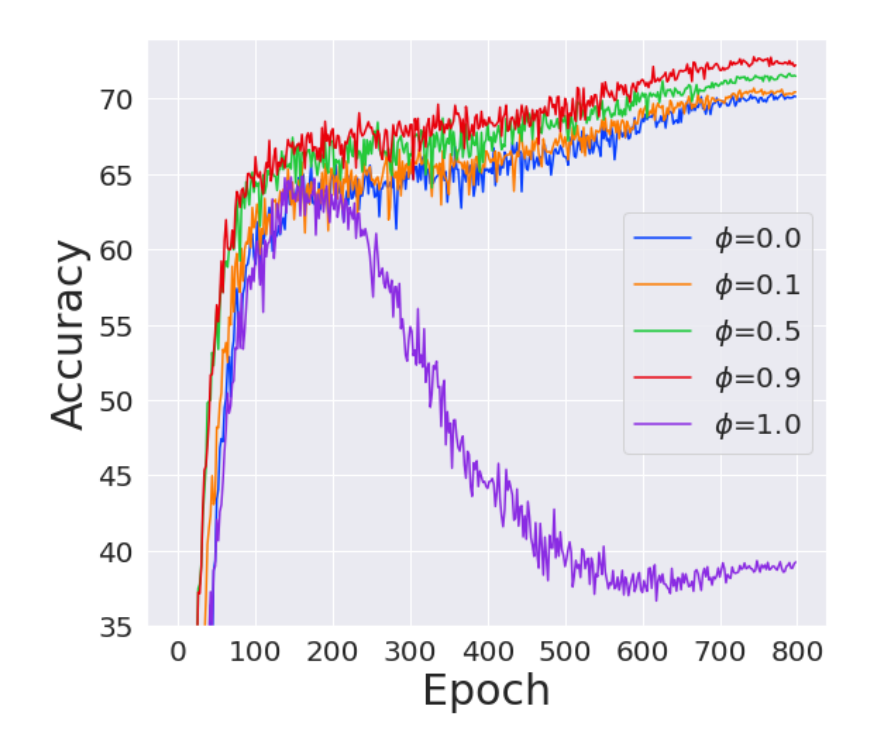

▲ 图4:PiCO在不同的移动平均系数下在CIFAR-100(q=0.05)上的性能

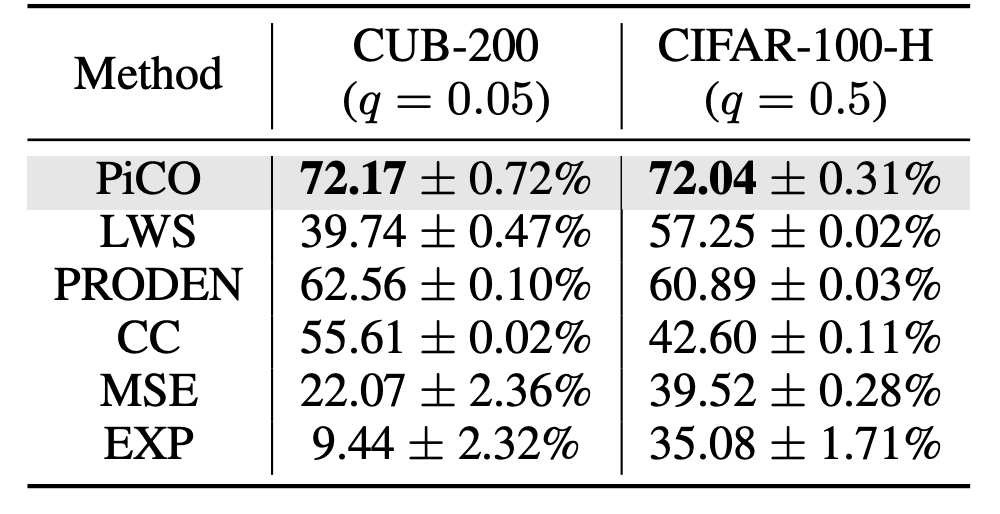

4.3 Further extension: fine-grained partial label learning

▲ 表3. 细粒度数据集上的准确率比较

Why PiCO improves partial label learning?

Conclusion

Personal Comments

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧