SelfKG: 自监督知识图谱实体对齐 | 论文荐读

作者:

刘潇,洪昊昀,王星皓,陈泽毅,叶夫根尼-哈拉莫夫,东昱晓,唐杰

Xiao Liu, Haoyun Hong, Xinghao Wang, Zeyi Chen, Evgeny Kharlamov, Yuxiao Dong, and Jie Tang. SelfKG: Self-Supervised Entity Alignment in Knowledge Graphs. In Proceedings of the Web Conference 2022 (WWW'22) (accepted).

Paper:

http://keg.cs.tsinghua.edu.cn/jietang/publications/WWW22-Liu-et-al-SelfKG.pdf

Code & Data:

https://github.com/THUDM/SelfKG

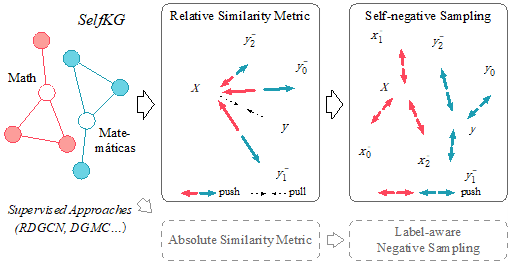

实体对齐,旨在识别不同知识图谱(KGs)中的等价实体,是构建网络规模KGs的一个基本问题。在其发展过程中,标签监督被认为是准确对齐的必要条件。在自我监督学习的最新进展的启发下,我们探索了在多大程度上可以摆脱实体对齐的监督。通常,标签信息(正面的实体对)被用来监督将每个正面的实体对拉近的过程。然而,我们的理论分析表明,实体对齐的学习实际上可以从将取样的负数对中的无标签实体推得更远,而不是将正数对中的实体拉得更近。通过利用这一发现,我们开发了实体排列的自监督学习目标。

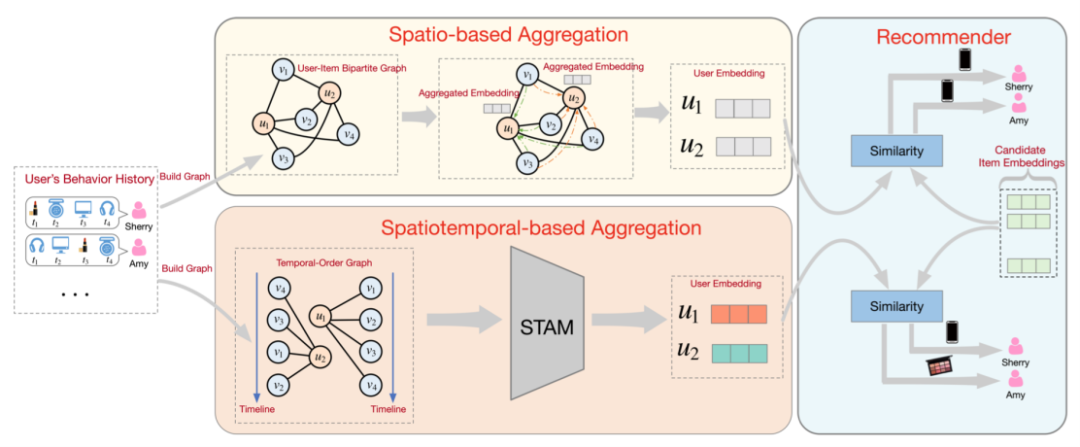

为了将时间信息整合到邻居嵌入学习中,STAM 利用 Scaled Dot-Product Attention 来捕获一阶邻居的时间顺序,并利用多头注意力机制在不同的潜在子空间上执行联合注意力。STAM 的整体架构如下图所示,它以时间序列 Tu 和 Tv 作为输入,输出一阶邻居的时空邻居嵌入表示。

STAM 是一种时空聚合方法,从空间结构和时间顺序两个角度同时学习邻居的嵌入表示。我们将 STAM 应用到基于 GNN 的推荐中来学习用户和商品的嵌入表示。与基于 GNN 的推荐类似,我们堆叠多个 STAM 以捕获用户-商品二部图中的高阶交互信息。然而,当从一阶邻居逐层传播时空邻居嵌入表示时,STAM 将遭受成倍增加的内存消耗。为此,我们从时空邻居嵌入表示中学习一个时空注意力权重矩阵,并将其整合到邻接矩阵中进行用户/商品的嵌入表示学习。

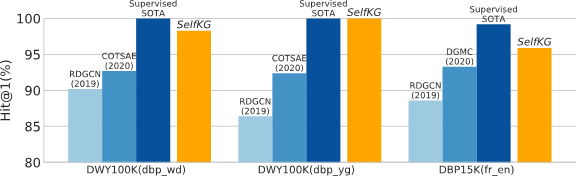

我们提出了 SelfKG 的高效策略,以优化这一目标,在没有标签监督的情况下对实体进行对齐。在基准数据集上进行的广泛实验表明,没有监督的 SelfKG 可以 与最先进的有监督的基线相匹配或达到相当的结果。SelfKG 的性能表明自我监督学习为 KG 中的实体对齐提供了巨大的潜力。

点击【阅读原文】查看paper