【导读】CVPR 2021最佳论文各奖项公布了:来自德国马普智能所德国马普智能所等获最佳论文,何恺明等获最佳论文提名。

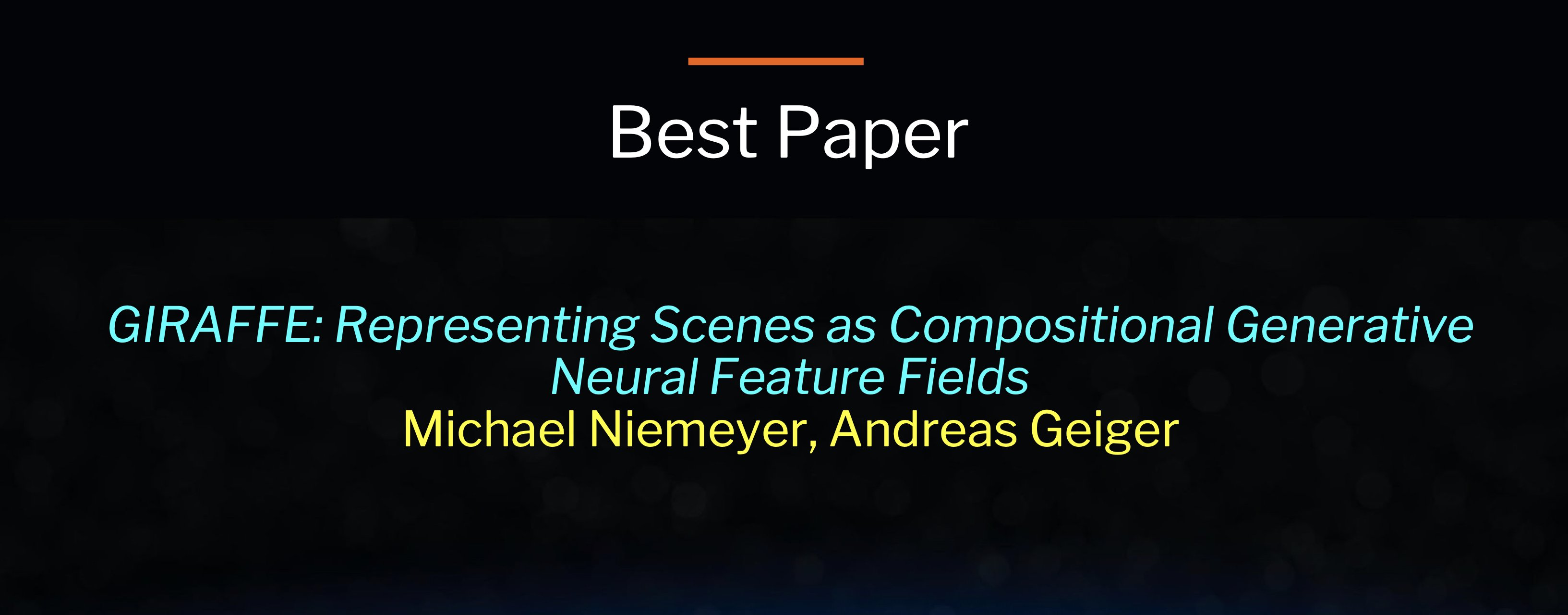

最佳论文奖

深度生成模型允许在高分辨率下合成照片级真实感图像。但是对于许多应用来说,这还不够:内容创造还需要做到可控才行。虽然最近有几项研究探讨了如何解开数据中潜在的变化因素,但大多数研究都是在二维空间中进行的,而忽略了我们的世界是三维的。此外,只有少数研究工作考虑到了场景的组合性质。

本文的关键假设是——将合成的三维场景表示合并到生成模型中会导致更可控的图像合成。将场景表示为合成生成的神经特征场,使我们能够从背景中分离出一个或多个目标以及单个目标的形状和外观,同时在无需任何额外的监督下从非结构化和未使用的图像集合中进行学习。

将这种场景表示与神经渲染 pipeline 相结合,就可以得到一个快速而逼真的图像合成模型。本文的实验证明,我们所提出的模型能够分离单个目标物体,并允许在场景中平移和旋转它们以及改变相机姿势。

论文地址:

https://www.zhuanzhi.ai/paper/500de8ca500d7c3d3c0b74a75c7a692a

https://m-niemeyer.github.io/project-pages/giraffe/index.html

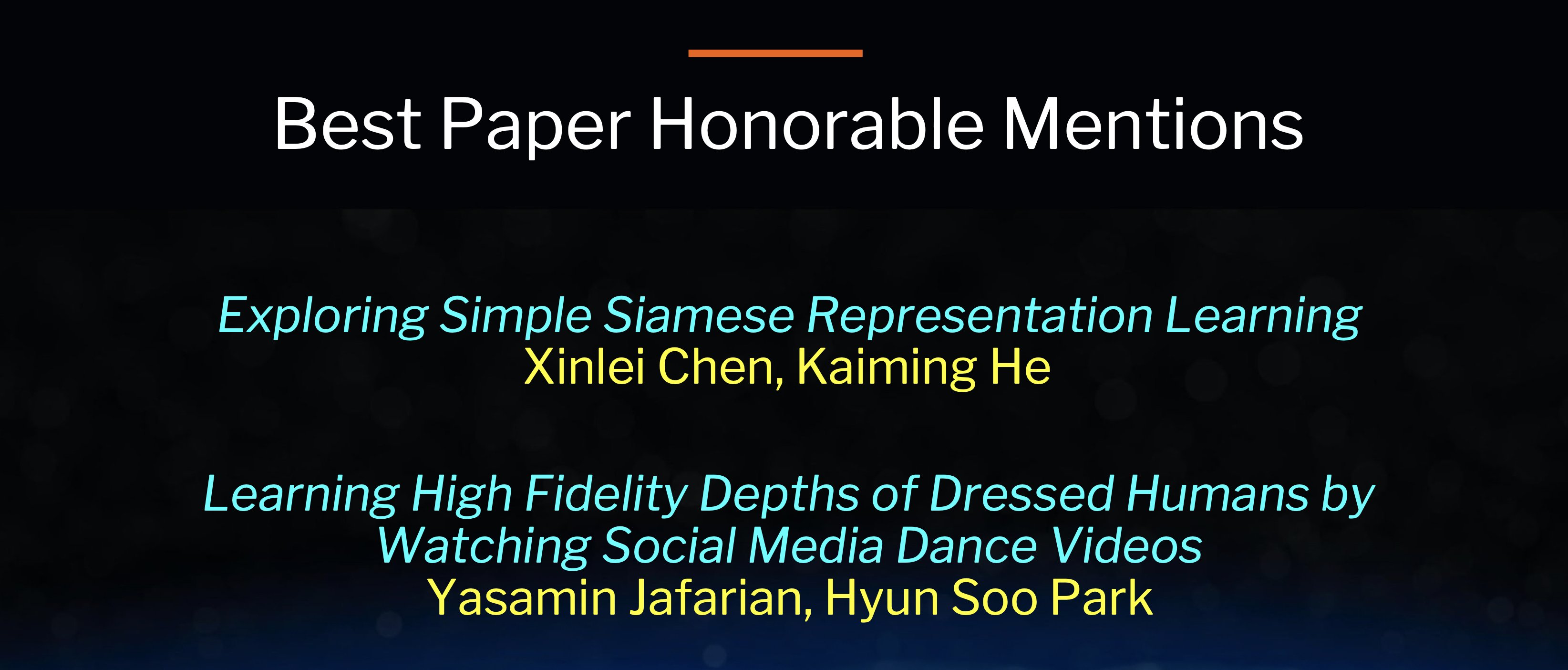

最佳论文荣誉提名奖

1、《Exploring Simple Siamese Representation Learning》

在无监督视觉表征学习的各种最新模型中,孪生网络已经成为一种常见的结构。这些模型在避免某些方案崩溃的某些条件下,可以使一个图像的两次增强之间的相似度最大化。在本文中,作者报告了令人惊讶的经验结果,即使用简单的孪生网络即使不使用以下任何一项也可以学习有意义的表示形式:(i)负样本对,(ii)大批量,(iii)动量编码器。我们的实验表明,对于损失和结构确实存在崩溃解,但是停止梯度操作在防止崩溃方面起着至关重要的作用。作者提供了关于停止梯度含义的假设,并进一步显示了验证它的概念验证实验。本文的孪生网络方法在ImageNet和下游任务上取得了竞争性结果。作者希望这个简单的基准将激励人们重新思考孪生体系结构在无监督表示学习中的作用。

论文地址:

https://www.zhuanzhi.ai/paper/e342faed98244ac695a1881a322dd10b

2、《Learning High Fideity Depths of Dressed Humans by Wathing Socail Media Dance Videos》

学习穿戴人体几何的一个关键挑战在 ground truth 实数据(如三维扫描模型)的有限可用性,这导致三维人体重建在应用于真实图像时性的能下降本文们通过利用一个新的数据资源来应对这一挑战:大量社交媒跳舞蹈视——,涵盖了不同的外观、服装风格、表演和身份。每一个视频都描述了一个人的身体和衣服的动态运动,但缺乏3 ground truth实几何图形.

为了很好地利用这些视频,本文提出了一种新的方法来使用局部变换,即将预测的局部几何体从一幅图像在不同的时刻扭曲到另一幅图像。这使得自监督学习对预测实施时间一致性。此外,我们还通过最大化局部纹理、褶皱和阴影的几何一致性,共同学习深度以及对局部纹理、褶皱和阴影高度敏感的曲面法线。

另外本文的方法是端到端可训练的,能产生高保真深度估计来预测接近于输入的真实图像的精确几何。本文证明了我们提出的方法在真实图像和渲染图像上都优于 SOTA 人体深度估计和人体形状恢复方法。

论文地址:

https://www.zhuanzhi.ai/paper/476c0303a4f47d188c9f95564f71415e

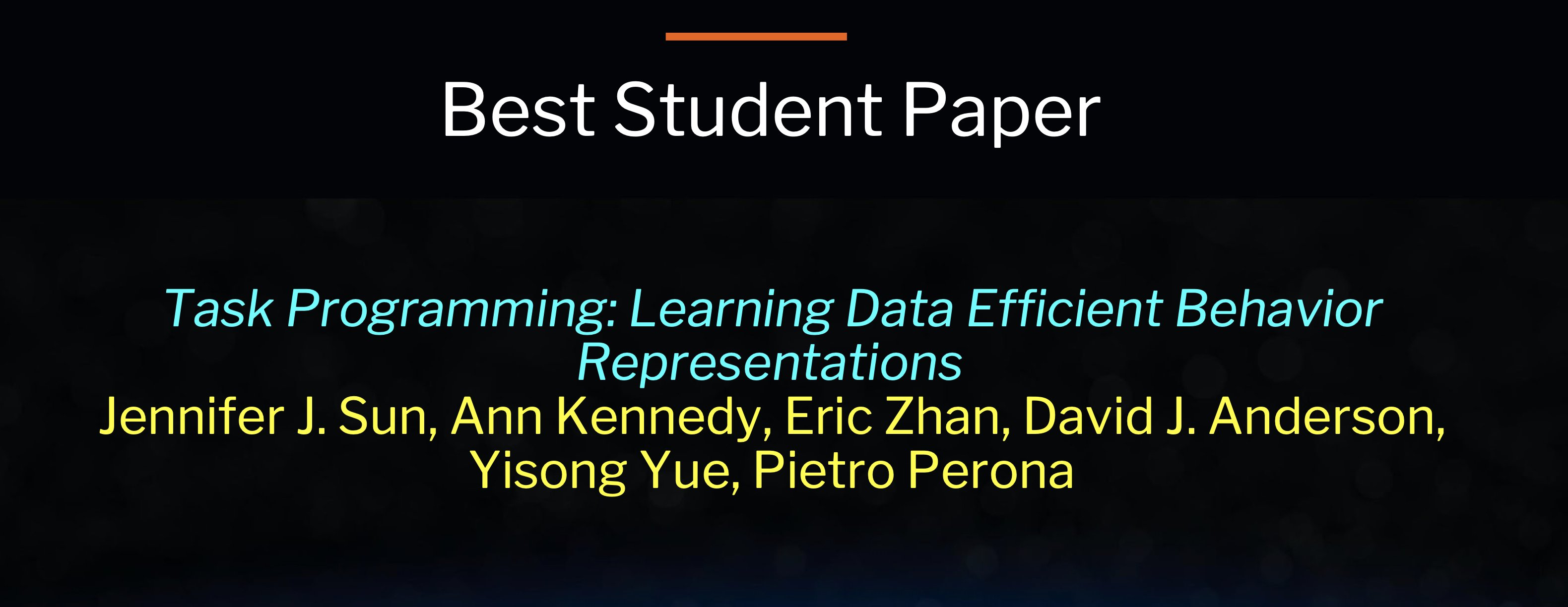

最佳学生论文奖

为了更准确的标注数据集,具备该领域的专业知识是必要的,但这可能意味专家们将承担大量繁重和耗时的工作。这个问题在自动行为分析(automated behavior analysis)中尤为突显。例如,从视频跟踪数据中检测智能体运动或动作。

为了减少注释的工作量,我们基于多任务自监督学习,提出了一种用于行为分析的有效轨迹嵌入方法—TREBA。利用该方法专家们可以通过“任务编程”过程来有效地设计任务,即使用程序编码将领域专家的知识结构化。通过交换数据注释时间来构造少量编程任务,可以减少领域专家的工作量。我们使用行为神经科学领域的数据集评估了该方法,通过小鼠和果蝇两个领域内三个数据集的测试,实验结果表明:通过使用TREBA的嵌入,注释负担减少了10倍。该研究结果表明,任务规划和自监督是减少领域专家注释工作量的有效方法。

论文地址:

https://www.zhuanzhi.ai/paper/475f5ea525606abcb0316e3d3d1f6f76

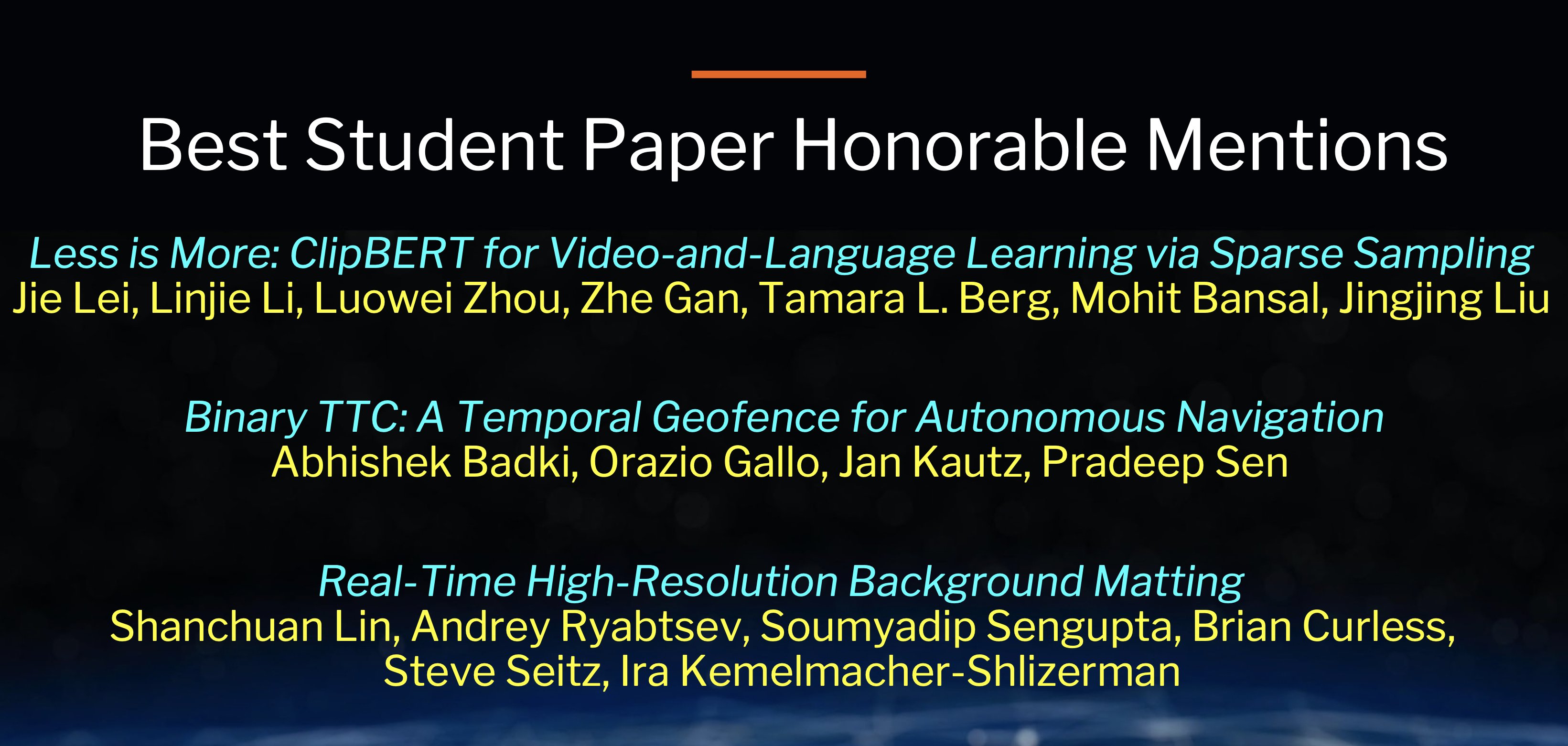

最佳学生论文提名奖

标题: Less is More: CLIPBERT for Video-and-Language Learning via Sparse Sampling 链接: https://www.zhuanzhi.ai/paper/c39c5c9f8b1ce724df6ec8c52686053e code: https://github.com/jayleicn/ClipBERT 图片

规范的视频和语言学习方法(例如,视频问答)规定了一个神经模型,可以从视觉模型的离线提取的密集视频功能和语言模型的文本功能中学习。这些特征提取器是经过独立训练的,通常在与目标域不同的任务上进行训练,使这些固定特征对于下游任务而言不是最理想的。此外,由于密集视频特征的高计算量,通常难以(或不可行)将特征提取器直接插入现有方法中以进行微调。为了解决这一难题,本文提出了一个通用框架CLIPBERT,该框架通过使用稀疏采样(仅使用一个视频中的一个或几个稀疏采样的短片)来实现可负担的视频和语言任务的端到端学习。

- Binary TTC: A Temporal Geofence for Autonomous Navigation

https://www.zhuanzhi.ai/paper/3979b0210705da97a481ef1c4f9c8361

Time-to-contact (TTC),即物体与观察者的水平碰撞时间,它是一个强大的路径规划工具:拥有比场景中物体的深度、速度和加速度更丰富的信息。TTC的最大优点是只需要一个单目的、未校准的摄像机。不过,回归每个像素的TTC并不容易,现有的大多数方法对场景的假设都过于简化。

本文通过一系列简单的二元分类(binary classifications)来估计TTC,从而解决了这个难题。我们以较低的延迟预测观察者是否会在一定时间内与障碍物相撞,这通常比精确每个像素的TTC更为关键。针对这种情况,我们的方法在6.4毫秒内提供了一个临时地理围栏(geofence)——它比现有方法快25倍多。

在计算预算允许的条件下,该方法也可以用任意精细量化(包括连续值)来估计单个像素的TTC。据我们所知,它是第一个在足够高的帧速率下为实际使用提供TTC信息(二进制或粗略量化)的方法。

- 《Real-Time High-Resolution Background Matting》

本文介绍了一种实时、高分辨率的背景更换技术,该技术可以在GPU上以30fps速度运行4K分辨率和以60fps的速度运行高清分辨率。我们的技术基于背景消光(background matting),通过一个额外的背景帧来恢复alpha蒙版和前景层。该技术最大的挑战是计算一个高质量的alpha蒙版,即在实时处理高分辨率图像的同时保留头发的细节。

为了实现这一目标,我们采用了两种神经网络;一个是基础网络计算,二是低分辨率的结果,这个结果由第二个网络在高分辨率的选择性补丁上进行细化。我们介绍了两个大规模的视频和图像抠图数据集:VideoMatte240K和PhotoMatte13K/85。实验证明,该方法与其他现金的背景抠图模型相比,产生了更高质量结果相比,同时显著提高了运行速率和分辨率。

https://www.zhuanzhi.ai/paper/0bd9f7bfd0ca8132ddd7fbcc8d443e2c