GRAND+: 高效可拓展的图半监督学习框架 | 论文荐读

作者:

Wenzheng Feng, Yuxiao Dong, Huang Tinglin, Ziqi Yin, Xu Cheng, Evgeny Kharlamov, and Jie Tang. GRAND+: Scalable Graph Random Neural Networks. In Proceedings of the Web Conference 2022 (WWW'22).

Paper:

http://keg.cs.tsinghua.edu.cn/jietang/publications/WWW22-Feng-et-al-GRAND-plus.pdf

Code & Data:

https://github.com/wzfhaha/GRAND-plus

导读:

本文介绍了清华大学提出的大规模半监督图神经网络框架 GRAND+,该框架可以在 10 分钟之内在单机上完成千万级节点的训练与预测,取得了与此前谷歌提出的同类方法 PPRGo 相似的运行效率,并且显著超越了其分类效果。

半监督学习是机器学习的一种重要范式,其旨在利用大量无标注数据辅助模型训练,从而减轻模型对标注数据的依赖。基于图的半监督学习是半监督学习的一种经典范式,其使用图结构来表示数据之间的关联联系,并利用数据之间的关联信息来提升模型预测性能。近年来,图神经网络(GNN)被证明是图半监督学习最先进的解决方案,然而大部分 GNN 在该场景下会存在着泛化性弱的问题,这是由于 GNN 模型默认只利用有标注数据进行模型训练,对无标注数据的利用仅限于使用特征传播聚合无标注节点的信息,这样导致模型对无标注数据的利用不足,容易过拟合到有限的标注样本上。

为了解决泛化性弱的问题,我们之前提出了图随机神经网络 GRAND,GRAND 使用了一种随机传播的方法来进行图数据增强,并使用一致性正则优化模型对无标注节点不同增强特征的预测结果的一致性,以此来充分利用图中的无标注数据。该方法在半监督节点分类的基准数据集 Cora、Citeseer 以及 Pubmed 上超越了十余种 GNN 模型,达到 SOTA 的 效果。

(详见:https://arxiv.org/abs/2005.11079 )

然而,GRAND 在实际应用中面临着可扩展性方面的局限性,这是因为 GRAND 在每个训练步骤中要执行多次随机传播,而随机传播过程均需要使用幂迭代(power iteration)来计算矩阵乘积,该过程的复杂度与图大小呈线性关系,因此在面临大图时,GRAND 的模型训练会变得非常慢。

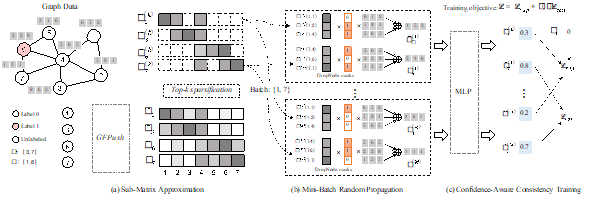

为了解决上述缺陷,我们对 GRAND 模型进行了改进,提出了一种高效可扩展的图半监督学习框架 GRAND+。相比于 GRAND,GRAND+主要对三个方面进行了改进:1.灵活性:GRAND+使用一个通用的混合多阶random walk概率转移矩阵进行特征随机传播,该矩阵通过一组可调整的权重来控制不同阶邻居的重要性,使得模型可以灵活地处理现实中多样的图数据。2.可扩展性:为了提升模型的可扩展性,GRAND+使用了一个通用的矩阵近似算法 GFPush(Generalized Forward Push)和 Top-k 稀疏化技术来对传播矩阵进行近似计算,这种矩阵近似范式可以支持模型以批量化的方式进行随机传播和模型训练,使得 GRAND+的训练过程的时间消耗与图大小无关,可以高效地处理大图。3.预测性能:GRAND+使用了一种新的置信度感知一致性损失(Confidence-aware consistency loss)来进行一致性正则化训练,该损失在计算时会把预测置信度低的无标注节点过滤掉,减少了训练中的噪声,从而进一步提升了模型效果。GRAND+的模型示意图如下所示:

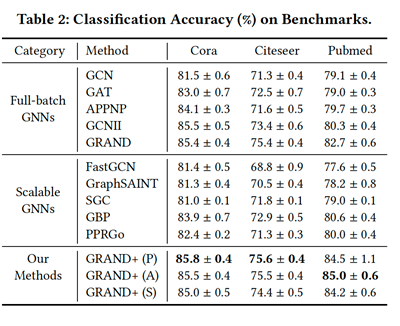

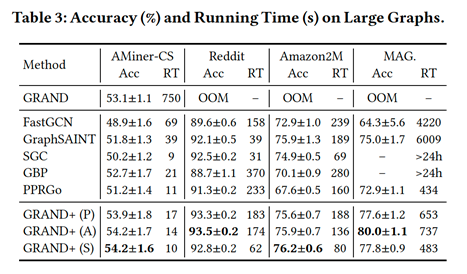

为了验证 GRAND+的预测效果及运行效率,我们选取了 7 个不同大小的图数据集对其进行了评测,并选择了 5 个经典的全批量(Full-batch)GNN 模型 GCN、GAT、APPNP、GCNII、GRAND 以及 5 个代表性的可扩展 GNN 模型 FastGCN、GraphSAINT、SGC、GBP、PPRGo 作为基线方法进行对比。实验结果显示,GRAND+在 3 个基准数据集上超越了所有 10 种基线方法,在另外 4 个较大规模的数据集上超越了 5 种可扩展的 GNN 模型,并具有良好的运行效率。值得一提的是,GRAND+在 Pubmed 上达到了 85% 的预测准确率,比 GRAND 高了 2.3%。在千万级节点数据集 MAG-Scholar-C 上,GRAND+可以在 10 分钟之内对完成训练及预测过程,比 FastGCN 和 GraphSAINT 快了近 10 倍;与此前谷歌提出的 PPRGo 模型相比,GRAND+以相近的运行时间取得了 4.9% 的效果提升。

GRAND+在基准数据集上的评测结果:

GRAND+在大图上的评测结果:

点击【阅读原文】查看paper