NeurIPS 2021 | 对比图泊松网络:面向极少标签的半监督GNN

现实生活中,无标签样本易于获取,而有标签样本的收集通常代价高昂。针对这种情况,半监督学习(Semi-Supervised Learning,简称SSL)被提出,以同时利用少量有标签样本和大量无标签样本来训练分类器。然而,当标签信息极为稀少时,当前的半监督学习方法往往无法取得令人满意的效果。因此,本文提出了一种新型图神经网络框架——对比图泊松网络,其在标签规模非常有限的情况下,仍有不俗的分类表现。该工作由京东探索研究院、南京理工大学、悉尼大学和莫纳什大学合作完成,目前已被NeurIPS 2021接收。

01

研究背景

SSL旨在利用少量有标签数据和大量无标签数据进行模型训练 [2]。过去的几十年间,SSL在多个领域都引起了广泛的研究兴趣,包括协训练 [3]、一致性正则 [4]、支持向量机 [5]等方法陆续被提出。其中,基于图的SSL算法凭借其坚实的数学基础和优越的性能,吸引了众多研究者的注意。

在基于图的SSL算法中,所有的有标签和无标签数据都被表示为图节点,而它们之间的关系则用边来刻画,其主要任务是将少量有标签节点中的标签信息,转移到剩下的无标签节点上,从而实现无标签节点的准确分类。近年来,作为解决这类问题的主流方法之一,图神经网络(Graph Neural Networks,简称GNN)[6]取得了令人瞩目的成果。尽管如此,当前的GNN模型(如图卷积网络GCN [7]和图注意力网络GAT [8])通常需要足够的有标签样本进行训练,才能拥有令人满意的分类能力。然而,对有标签样本的依赖无疑会增加数据收集工作的负担,同时,在某些场景下,有标签样本的数据可能是极为稀少的。由于有限的监督信号不足以训练一个具备良好鉴别能力的模型,所以大部分GNN模型的性能会随着标签数量的减少而逐渐下降,如图1所示。目前为止,关于使用极少标签进行半监督学习的GNN模型研究十分匮乏。

图1 在不同数量的标签下,GCN,GAT和CGPN(本文方法)的分类表现

02

方法原理简述

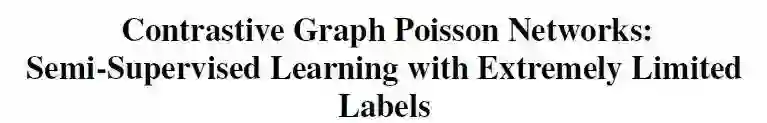

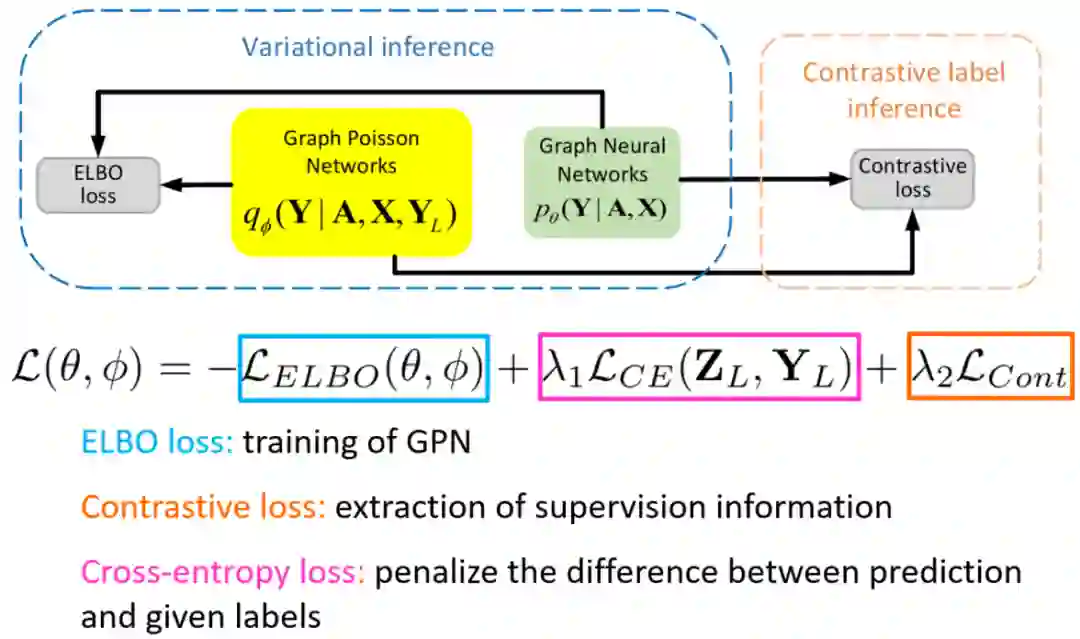

为了填补该研究的空白,我们提出了一个新的框架:对比图泊松网络(Contrastive Graph Poisson Networks,简称CGPN)。该框架基于变分推断和对比学习,拟从两个方面解决标签极少时,分类效果不佳的问题。框架结构如图所示。

图2 CGPN的框架结构

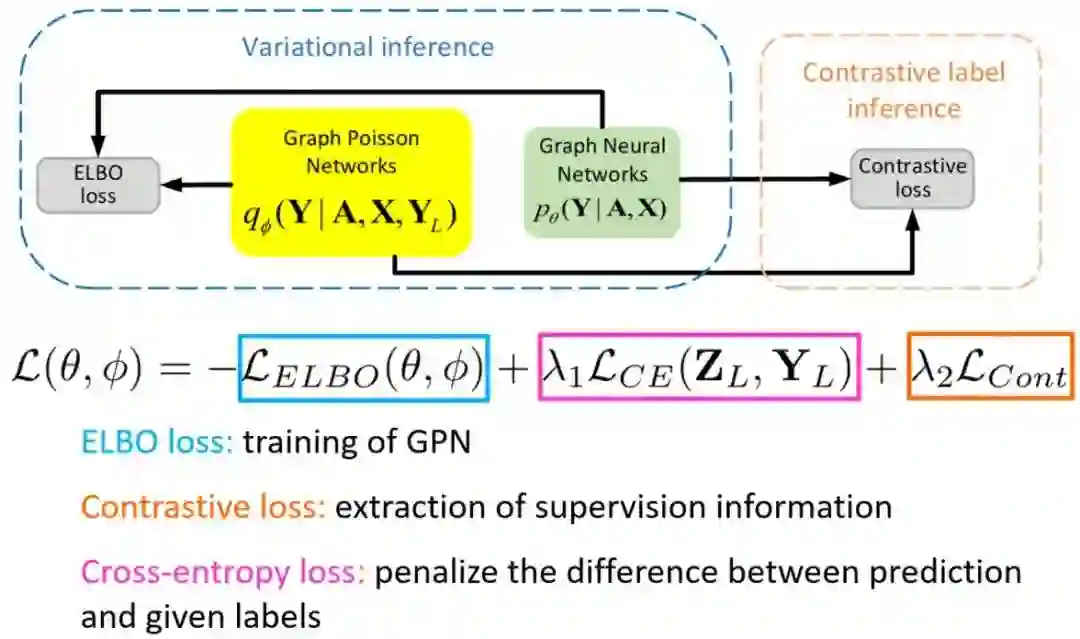

首先,为了促进标签信息在图中更好地传播,我们提出了图泊松网络(Graph Poisson Networks,简称GPN)。借助图结构信息,GPN能够将原本稀少的标签信息灵活地传播到整个图中。具体地,受泊松学习 [8]启发,GPN以如下规则迭代地进行信息传播:

其中,

图3 GPN的传播规则

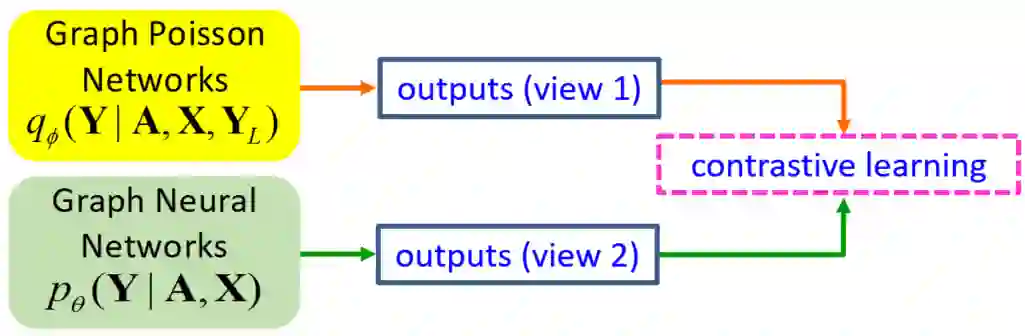

尽管通过GPN能够使得标签信息得到有效传播,但当输入的标签信息极少时,仍不足以训练一个鉴别能力优秀的模型。因此,我们想要从数据本身出发来挖掘额外的监督信息辅助模型训练。由于在变分推断中,我们分别借助GPN和常规的GNN,来对ELBO的两个参数化后验概率模型进行实例化,因此,这两个实例化模型能够分别提供两个视角下的输出,从而我们可以在这里非常自然地使用对比学习 [10, 11],如下图所示。

图4 CGPN中的对比学习

最后,我们的总体目标函数如下,分别由(1)ELBO损失函数、(2)交叉熵损失函数和(3)对比学习损失函数三部分组成:

03

实验结果

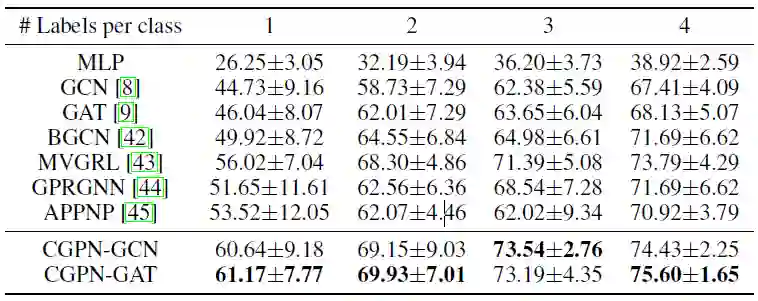

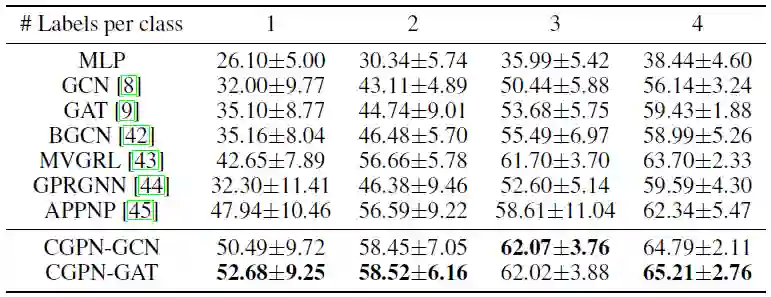

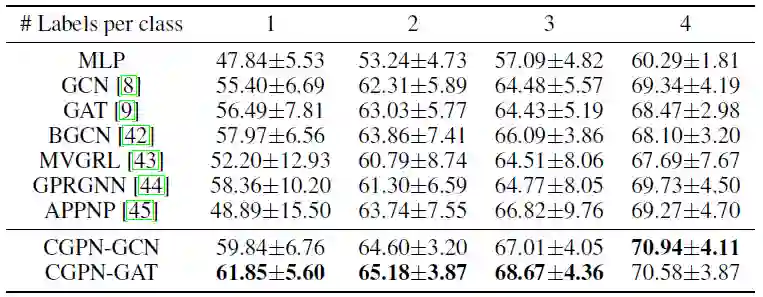

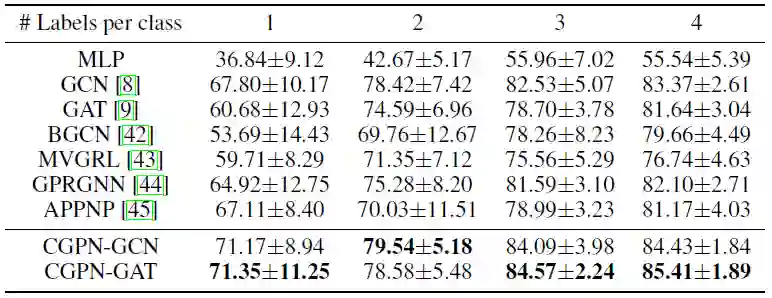

在本节中,我们将本文所提出的CGPN方法与几种最先进的GNN模型在多个数据集 [15, 16]上进行比较并展示了部分比较结果,包括GCN [7](ICLR 17)、GAT [8](ICLR 18)、BGCN [12] (AAAI 19)、MVGRL [11](ICML 20)、GPRGNN [13](ICLR 21)和APPNP [14](ICLR 18)。为了凸显CGPN在标签极为稀缺时的分类优越性,我们从每类中分别随机挑选1、2、3、4个有标签节点进行训练。

表1 Cora数据集上的分类结果

表2 CiteSeer数据集上的分类结果

表3 PubMed数据集上的分类结果

表4 Amazon Photo数据集上的分类结果

04

总结

在面对数量极少的标签时,当前基于图的半监督方法往往无法取得令人满意的分类结果,为了解决这一问题,我们提出了对比图泊松网络框架。通过在对比框架下设计图泊松网络,原本有限的标签信息能够被灵活地传播到整个图中,并且足够的监督信号可以被用作模型训练。在不同数据集上的实验证明了本文所提出的CGPN的有效性。

文章:

https://papers.nips.cc/paper/2021/file/31c0b36aef265d9221af80872ceb62f9-Paper.pdf

参考文献

THE END

往期推荐

ABOUT

京东探索研究院

京东探索研究院(JD Explore Academy)秉承“以技术为本,致力于更高效和可持续的世界”的集团使命,是以京东集团以各事业群与业务单元的技术发展为基础,集合全集团资源和能力,成立的专注前沿科技探索的研发部门,是实现研究和协同创新的生态平台。探索研究院深耕泛人工智能3大领域,包括“量子机器学习”、“可信人工智能”、“超级深度学习”,从基础理论层面实现颠覆式创新,助力数智化产业发展及变革。以原创性科技赋能京东集团零售、物流、健康、科技等全产业链场景,打造源头性科技高地,实现从量变到质变的跨越式发展,引领行业砥砺前行。

京东探索研究院诚招勤于实践、勇于梦想的志同道合之士,包括正式员工或者实习生,方向包括但不限于:算法理论、深度学习、自动机器学习、自然语言处理、计算机视觉、多模态处理、量子机器学习等。

📧 简历投递邮箱:

chengyuanzhuang@jd.com