本论文提出了若干旨在提升视觉生成的方法,重点围绕计算机视觉系统中的可控性与高效性展开。在深入探讨视觉生成领域之前,我们首先介绍 MaskCLIP,它高效地利用了预训练的视觉-语言模型,应用于开放词汇图像分割任务。随后,我们将讨论 DiffusionRig、PatchDM和 Gen2Res,以展示我们在可控且高效图像生成方面取得的进展。综上所述,本论文所展示的研究工作致力于构建既可控又高效的视觉系统,从而促进视觉生成与理解能力的双重提升。

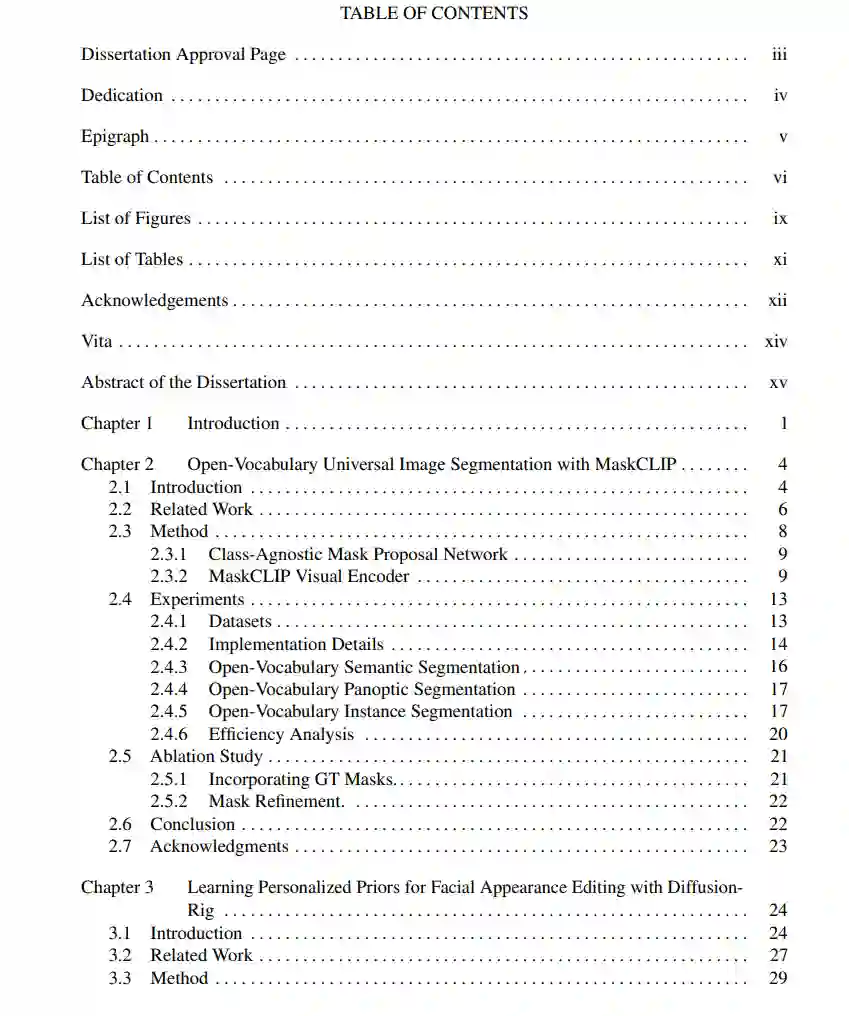

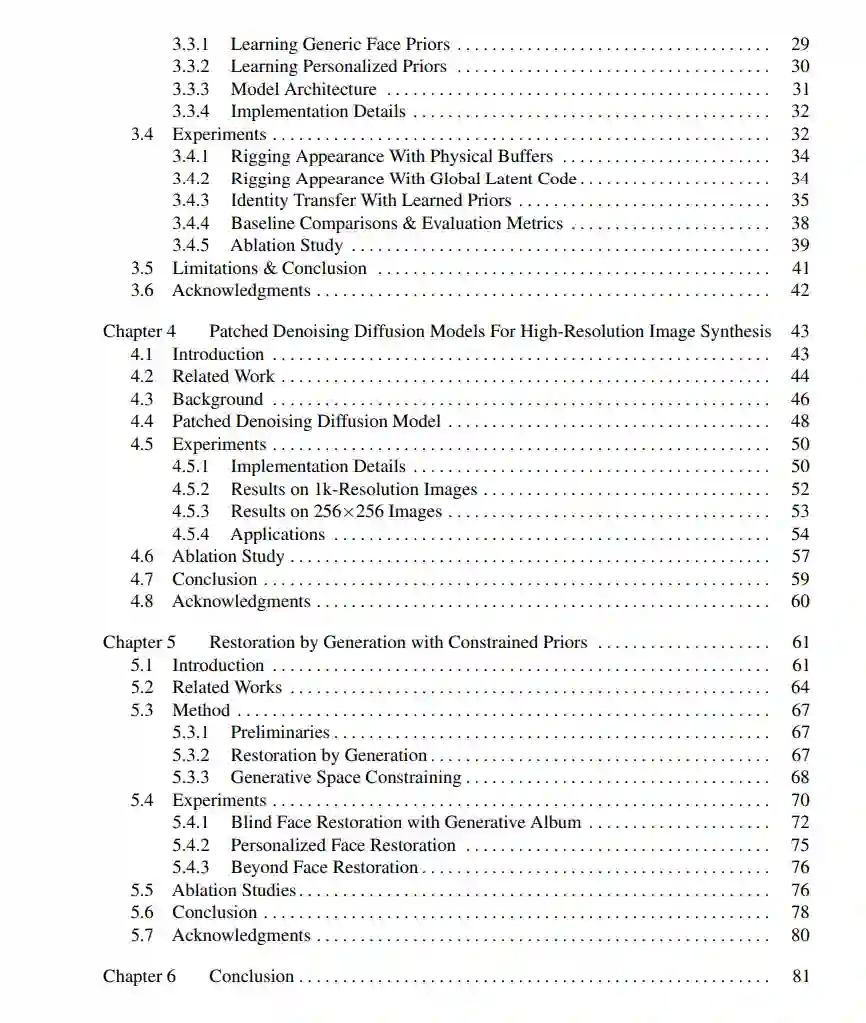

第二章引入了一个新颖的任务:开放词汇通用图像分割(open-vocabulary universal image segmentation),其目标是在推理阶段对任意描述类别执行语义分割、实例分割和全景分割。我们首先基于预训练的 CLIP 模型构建了一个基线系统,并提出了 MaskCLIP——一种基于 Transformer 的方法,采用 MaskCLIP 视觉编码器将掩码 token 融合进预训练的 ViT-CLIP 模型中。该设计在无需计算密集型的师生训练框架下,有效利用 CLIP 的密集特征,实现了分割和类别预测。 第三章介绍了用于个性化面部外观编辑的 DiffusionRig。该方法基于从真实环境图像中估计得到的粗略三维人脸模型,使用条件扩散模型将简单的 CGI 渲染映射为逼真的个人图像。DiffusionRig 采用两阶段训练策略:首先在大规模数据集上学习通用的面部先验,然后在少量个体图像上进行微调。该策略能稳健地编辑面部特征,同时保留个体身份与高频细节。 第四章介绍了 Patch-DM,一种去噪扩散模型,在训练过程中使用小图像块(如 64×64)生成高分辨率图像(如 1024×512)。该方法通过一种新颖的特征拼接策略,缓解了基于图像块合成中常见的边界伪影问题。具体地,该策略通过裁剪并组合邻近图像块中重叠的特征,实现了对偏移图像块的无缝预测。 第五章提出了一种将预训练去噪扩散模型适配至图像修复任务的方法。该方法通过向退化图像中添加噪声,然后利用预训练模型进行去噪,从而完成图像修复。通过在选定的锚图像上微调模型,以保持输入图像的特征,该受限生成空间确保了在保持原始身份与整体质量的同时,获得高质量的修复结果。