本论文旨在研究构建更高效且更强大模型的方法,重点聚焦于两个方面:架构改进与优化方法。我们探讨了一系列具有理论依据的架构修改,这些修改要么降低了计算成本,要么引入了有助于更高效模型利用的新特性。此外,我们还研究了现有的优化方法,以加深我们对神经网络优化的理论理解,并使其更贴近实际应用,从而为未来构建更优的优化器提供更有依据的决策基础。

在论文的第一部分,我们提出了三种对Transformer模型的增强,以应对处理长序列、提升数据效率和优化推理成本等关键挑战。首先,我们提出了Landmark Attention机制,以提升处理长序列的效率,在我们的实验中,该方法将推理成本显著降低了一个大常数因子(达50倍)。通过在注意力机制中引入层级结构,Landmark Attention 能够在推理阶段处理任意长度的输入,而不受训练时序列长度的限制。接着,我们提出了DenseFormer架构,它允许后续层访问前面所有层的输出。得益于增强的信息流,DenseFormer 在保持与更深Transformer模型相同困惑度(perplexity)的同时,在内存效率和推理速度方面均优于基线模型。我们的实验还揭示了信息流中意料之外的连贯模式,显示出远层激活被结构化重用的现象。最后,我们提出了CoTFormer以提升推理效率,其灵感来自大型语言模型中逐步推理的涌现能力。CoTFormer 通过对一个浅层模型的重复应用,实现了与更深模型相当的准确率。该方法虽然引入了额外计算开销,但支持按token粒度灵活调整推理成本。我们的结果表明,在训练自适应CoTFormer时,能在不损失精度的前提下,显著减少计算成本,因其能自动将计算资源分配给最需要的token。

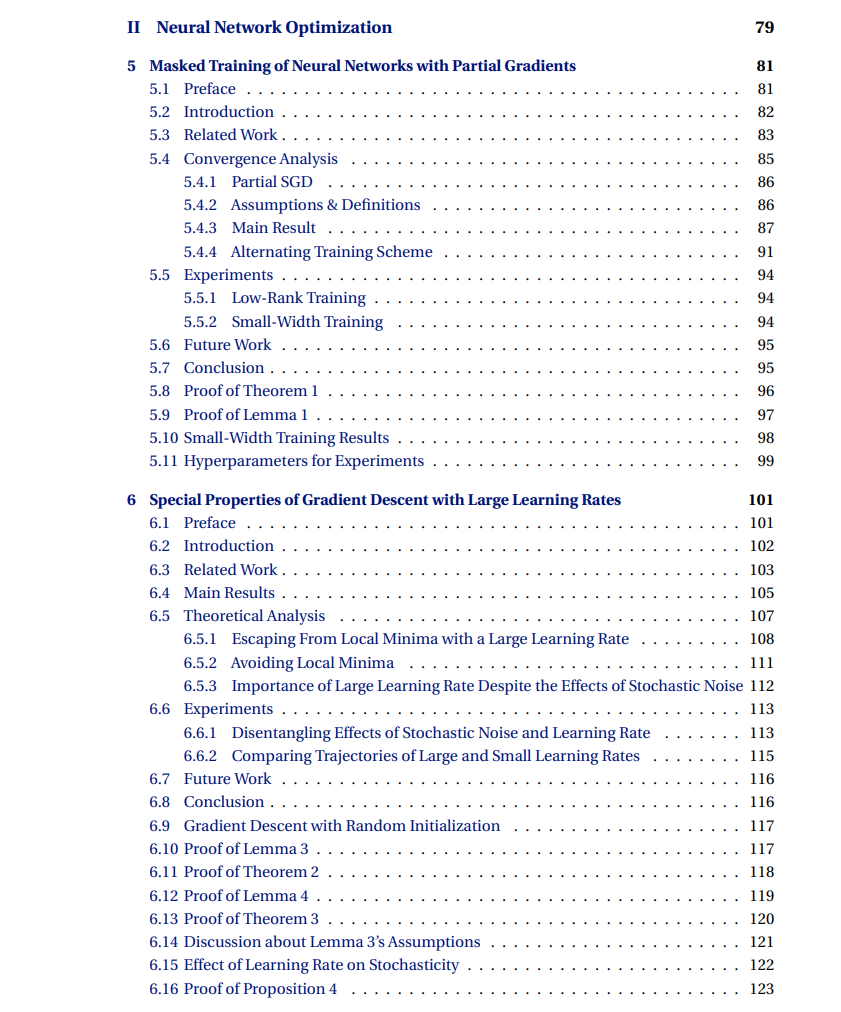

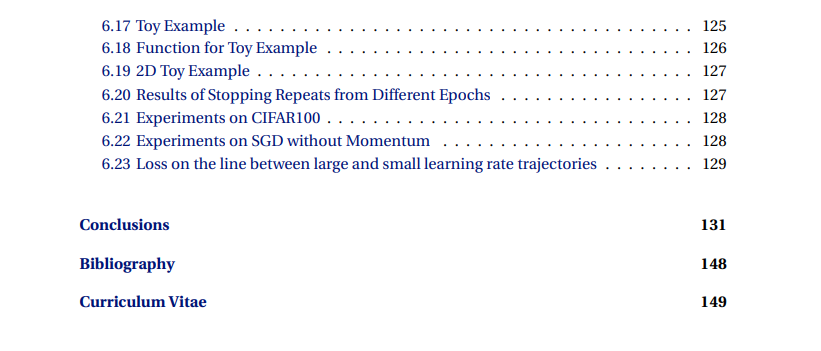

在论文的第二部分,我们聚焦于提升对神经网络优化的理解,动因之一即源于在设计自适应CoTFormer优化方法时遇到的挑战。我们构建了一个理论框架,用于研究参数扰动(parameter perturbation)以及屏蔽参数更新(masking parameter updates)对收敛性的影响。此外,我们通过理论分析与实证实验,加深了对“大步长对于获得更优模型至关重要”这一现象的理解。特别是,我们构造了一个受控实验环境,使得小步长与大步长之间的差异可以被严格地观测和验证。

关键词:语言模型、效率、优化、神经网络、Transformers