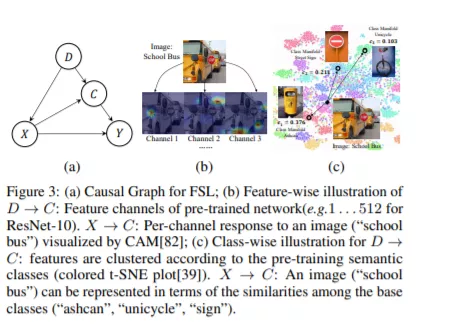

我们发现了在流行的小样本学习(FSL)方法中一直被忽视的一个缺陷: 预训练的知识确实是限制性能的一个混杂因素。这一发现源于我们的因果假设: 一个关于预训练的知识、样本特征和标签之间因果关系的结构性因果模型(SCM)。正因为如此,我们提出了一种新的FSL范式:干预少样本学习(IFSL)。具体来说,我们开发三个有效的IFSL算法,它本质上是一个因果干预SCM学习:目前在因果视图的上限。值得注意的是,IFSL的贡献与现有的基于微调和元学习的FSL方法是正交的,因此IFSL可以改进所有这些方法.

成为VIP会员查看完整内容

相关内容

Arxiv

9+阅读 · 2018年4月22日