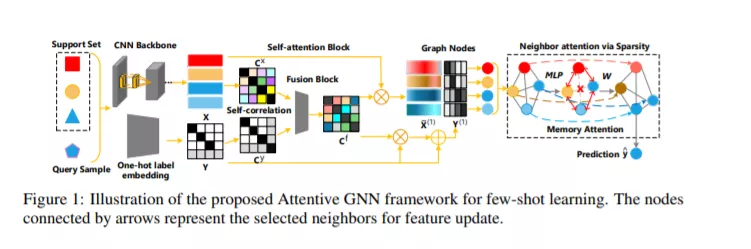

图神经网络(GNN)已经在许多具有挑战性的应用中展示了优越的性能,包括小样本学习任务。尽管GNN具有强大的从少量样本中学习和归纳的能力,但随着模型的深入,GNN通常会出现严重的过拟合和过平滑问题,这限制了模型的可扩展性。在这项工作中,我们提出了一个新的注意力GNN来解决这些挑战,通过合并三重注意机制,即节点自我注意,邻居注意和层记忆注意力。我们通过理论分析和实例说明了所提出的注意模块可以改善小样本学习的GNN的原因。广泛的实验表明,在mini-ImageNet 和Tiered-ImageNet数据集上,通过诱导和直推设置,提出的注意力GNN在小样本学习方面优于基于最先进的GNN方法。

成为VIP会员查看完整内容

相关内容

Arxiv

16+阅读 · 2020年3月30日

Arxiv

44+阅读 · 2020年2月5日