【导读】自监督学习是当下研究的热点。如何在多模态时序数据进行自监督表示学习?最新来自皇家墨尔本理工大学RMIT等学者发表了《自监督表示学习:多模态与时序数据》,首次全面综述多模态时序数据自监督学习方法,非常值得关注!

近年来,自监督表示学习(Self-Supervised Representation Learning, SSRL)在计算机视觉、语音、自然语言处理(natural language processing, NLP)等领域受到广泛关注,近年来,它也逐渐被应用于传感器数据的时间序列等模态。传统模型通常需要大量注释良好的数据进行训练,这一事实推动了自我监督学习的流行。获取带注释的数据可能是一个困难且代价高昂的过程。自监督方法通过使用从原始数据中自由获取的监督信号对模型进行区分性预训练来提高训练数据的效率。现有的研究主要集中在单模态CV或NLP领域的方法,与此不同,本文的目的是首次全面综述多模态时序数据自监督学习方法。为此,我们 1) 对现有的SSRL方法进行了全面的分类; 2) 通过定义SSRL框架的关键组件引入了一个通用流水线; 3) 就其目标功能、网络架构和潜在应用对现有模型进行了比较; 4) 对每种类别和各种模态下的现有多模态技术进行了综述。最后,我们提出了现有的弱点和未来的机会。我们相信,我们的工作为利用多模态和/或时间数据的领域的SSRL需求提供了一个视角。

https://www.zhuanzhi.ai/paper/88836a11fa745f249523bdfcf9298998

表示学习

过去几十年,深度学习技术取得了巨大的成功,催生了大量面向大规模数据集的应用。尽管深度学习具有显著的影响,但许多最先进的技术仍然需要人工干预,例如手动数据预处理和数据注释。这是监督学习模型的一个主要瓶颈,因为获取数据注释通常是一个耗时的过程,需要一些领域知识。自监督表示学习(SSRL)解决了这一瓶颈,它试图通过从数据本身获得的监督信号来训练网络模型,从而揭示关于数据的有意义的信息。这大大增加了用于训练模型的数据带宽,并已被证明可以减少对手动数据注释的依赖[69]。这也可能被认为是迈向通用人工智能道路上的早期一步,因为与监督学习方法相比,计算机从观察数据中学习所需的人工输入要少得多。接下来,我们将概述表征学习和相关的自监督学习技术。

数据表示的研究最初依赖于特征工程,即定义人工步骤将原始数据转换为有意义的特征。这种转换的例子包括统计属性(如均值和标准差)的计算和基于形状或模式的特征(如图1中的小波变换)。然而,为一项复杂任务设计良好的特征选择通常需要大量的人力和大量的领域知识来确保特征的质量。此外,为一个任务选择的特征可能不适合另一个任务,使其不可行的一般化使用这些方法。为此,提出了一种旨在从数据中自动提取鉴别特征的表示学习方法。其基本原理是降维算法,如主成分分析、流形学习和深度学习将只保留高维数据中信息量最大的特征,并在将数据映射到其低维表示时消除数据中的噪声。之后,保留和去噪的特征可以用作后续机器学习模型的输入。由于表示学习对人类干预的依赖程度最低,它不再被视为机器要解决的任务,而是学习一种技能(Satinder Singh),以发展对世界的一般性理解,并汇聚创造一种可以泛化到新场景的一般性共同理解89。因此,表示学习在计算机视觉(CV)、语音识别和自然语言处理(NLP)等多个领域受到了广泛关注。

自监督表示学习

一个监督模型接受一个带注释的数据集用于给定的任务(例如图像分类的ImageNet),并学习数据表示。由于训练任务的普遍性,学习到的表示可以作为一个新的但类似的任务(如物体检测)的良好起点。然而,监督表示学习的主要限制是对注释数据集的要求。数据注释是一个昂贵和耗时的过程,需要大量的人力工作。为了获得高质量的数据集,需要在数据领域(如医疗、法律或生物数据集)拥有广泛的专业知识。此外,对于一些应用领域(如与人类相关的应用),由于隐私问题,获取标签数据集是不可行的。

针对上述问题,提出了一种自监督表示学习方法。它直接处理未标记的数据,不需要外部注释。与人类的自学习过程类似,这是一个“观察、行动、观察和推断”的重复循环,SSRL以原始数据为输入,对输入数据应用一个或多个预定义的动作,观察动作的结果,并推断出模型参数的下一个优化步骤。重复这个过程,SSRL模型可以提取数据的分布和局部/全局特征。SSRL的一个关键组件是对数据输入的预定义操作,它生成伪标签来监督训练过程。这种行为的一个例子是伪装学习的前置任务,它掩盖了一部分数据,使用被掩盖的部分作为标签,并引导模型恢复被掩盖的部分。

由于SSRL不需要外部监督,它可以利用大量可用的未标记数据(例如,所有发布在互联网上的图像)。这导致了SSRL的显著成功。在2000年代,Hinton等人(2006)[70]和Bengio等人(2007)[21]提出了一种自监督算法,在使用真实标签对模型进行微调之前,对深度信任网络进行预训练。他们表明,使用预训练的权值可以提高监督任务的性能。如今,基于深度学习的模型,SSRL不仅在许多下游任务中实现了与其他完全监督竞争方法相比的竞争精度,而且与类似的监督模型相比,具有参数少得多、网络小得多的优势; 因此,它们不容易发生过拟合[78]。此外,SSRL的用例不仅限于作为机器学习管道中的预处理步骤(如迁移学习),还包括其他领域的应用,如通过提高这些学习系统的标签/奖励效率的持续学习[113]和强化学习[124]。

多模态和时序数据的自监督表示学习

多模态时序数据在日常生活中无处不在。数字设备的广泛使用和数字应用(如物联网应用、无线通信和媒体消费)的普及,使时序数据的可用性越来越高。时序数据的例子包括传感器读数、股票价格和医疗记录等等。时序数据分析在环境(如气候建模)、公共安全(如犯罪预测)和智能交通(如城市交通管理)等各个领域都有广泛的应用。

另外,由于产生了大量异构格式的数据,因此涵盖了多种数据形式。例如,自动驾驶汽车的决策同时依赖视觉和传感器数据。这些来自不同来源的数据可以被视为同一主题的不同观点,并提供补充信息。因此,同时利用这两类数据可以提高机器学习模型的有效性和可靠性。尽管多模态和时序数据很重要,但分析它们并非微不足道。时序数据与其他数据类型(如图像和文本数据)相比具有独特的特征,因为它与采集时间有很强的相关性。提取动态时间模式(例如周期模式)对于发现数据如何随时间演变是至关重要的。当有多种可用的数据模式时,学习在不同模式下不仅有效而且语义一致的表示是至关重要的。

为了解决这些问题,许多SSRL模型被提出,利用大量未标记的多模态和/或可用的时间数据来学习可转移到下游预测器的数据表示。这些模型在数据模式(如音频、图像、文本或时间序列或这些模式的组合)、生成监督信号的方法(如借口任务、聚类、对比数据样本和相似性计算)和目标函数(如交叉熵、三元组损失和InfoNCE)等方面存在不同。本文系统地综述了近年来多模态和时序数据SSRL的研究进展。本文对这些研究成果进行了综述,对它们进行了定位和比较,并指出了未来可能的研究方向。

本文贡献:

在这篇文章中,我们介绍了快速发展的表示学习领域,并回顾了SSRL技术。特别地,我们讨论了现有综述中较少涉及的模态(时间数据),并特别关注跨模态学习模型。本文将做出贡献:

-

据我们所知,这是第一次全面的SSRL调研,涵盖了视觉数据之外的多种形态。我们包括音频和时间序列数据类型及其与视觉和文本的组合。这将为研究人员提供一个快速了解这些领域最先进工作的全景图。

-

我们提出一个分类方案来定位、分类和比较审查的工作。比较分析可以作为读者在现实生活中使用哪种模型的实践指南。

-

我们确定了多模态和时间数据SSRL领域的公开挑战。我们进一步讨论可能的未来研究方向,可能解决这些挑战。

本文其余部分的组织如下:在第2节中,我们回顾了关于SSRL的现有综述论文。在第3节中,我们解释了重要的术语和背景信息,以使文章易于阅读和理解。在第4节中,我们描述了现有的类别,并特别介绍了为单一时态数据模式提出的SSRL方法。在第5节中,我们将现有的框架扩展为跨模态方法,并研究跨模态应用可能的框架、需求和挑战。在第6节中,我们关注用于自监督学习的目标函数的演变趋势。最后,第7节讨论了挑战和未来的研究方向。

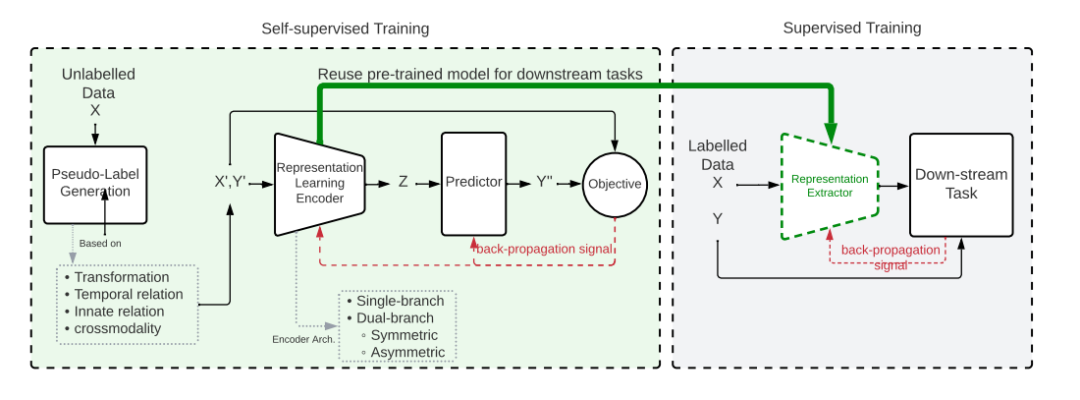

自监督表示学习(SSRL)工作流。首先,SSRL方法以未标记的数据为输入,利用数据转换、时间/空间掩蔽、先天关联和交叉模态匹配等多种技术提取新的实例及其对应的伪标签。接下来,学习表征的目的是预测那些提取的伪标签。最后,一个预训练的编码器将被转移到一个有监督/无监督的下游任务,只有有限的标记数据。

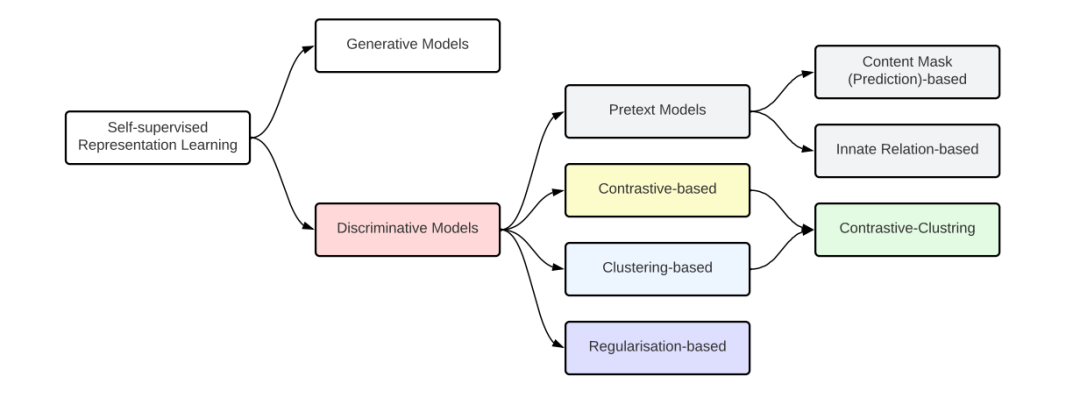

适用于所有基础架构和模式的自监督表征学习框架的类别。

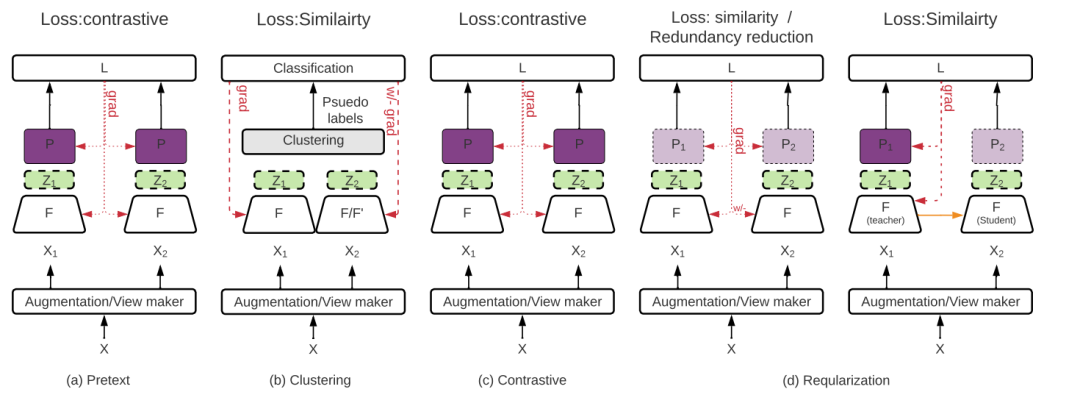

比较不同的自监督表示学习模型的整体架构。