零样本量化

·

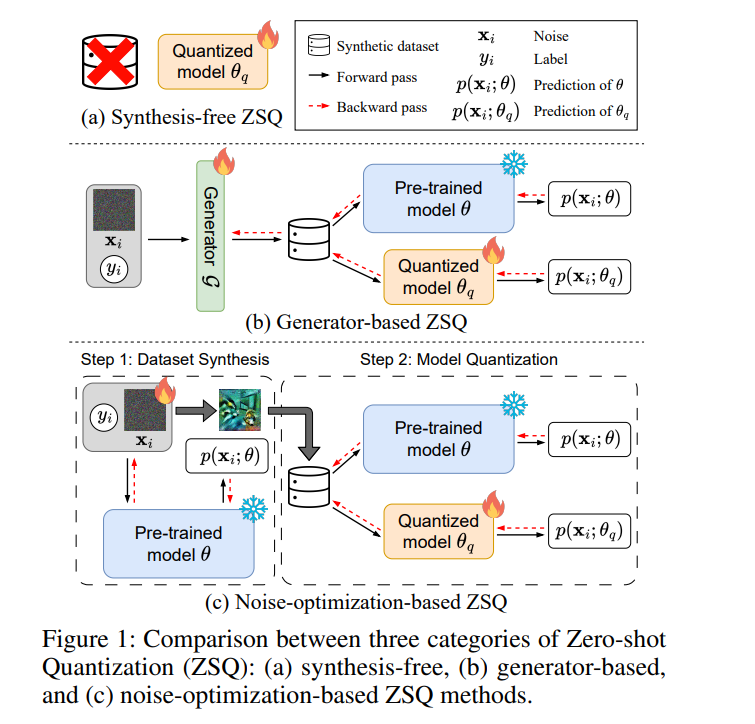

神经网络量化已被证明是一种有效的方法,可显著降低深度学习模型在资源受限设备上的内存占用与计算开销。然而,传统的量化方法通常依赖于对训练数据的访问,在实际应用中,这在隐私保护、安全性或合规性方面常常难以实现。**零样本量化(Zero-shot Quantization, ZSQ)**作为一种新兴方案,能够在完全不依赖真实数据的前提下实现模型量化,因而展现出广阔的应用前景。

本文对当前 ZSQ 方法及其最新研究进展进行了系统综述。首先,我们对零样本量化问题进行了形式化定义,并指出该领域面临的核心挑战。接着,我们根据数据生成策略对现有 ZSQ 方法进行了分类,总结其研究动机、关键思想与主要结论。最后,本文还探讨了未来的研究方向,以期解决当前存在的局限性,推动 ZSQ 领域的持续发展。 据我们所知,本文是目前关于零样本量化问题的首篇系统性综述。

成为VIP会员查看完整内容