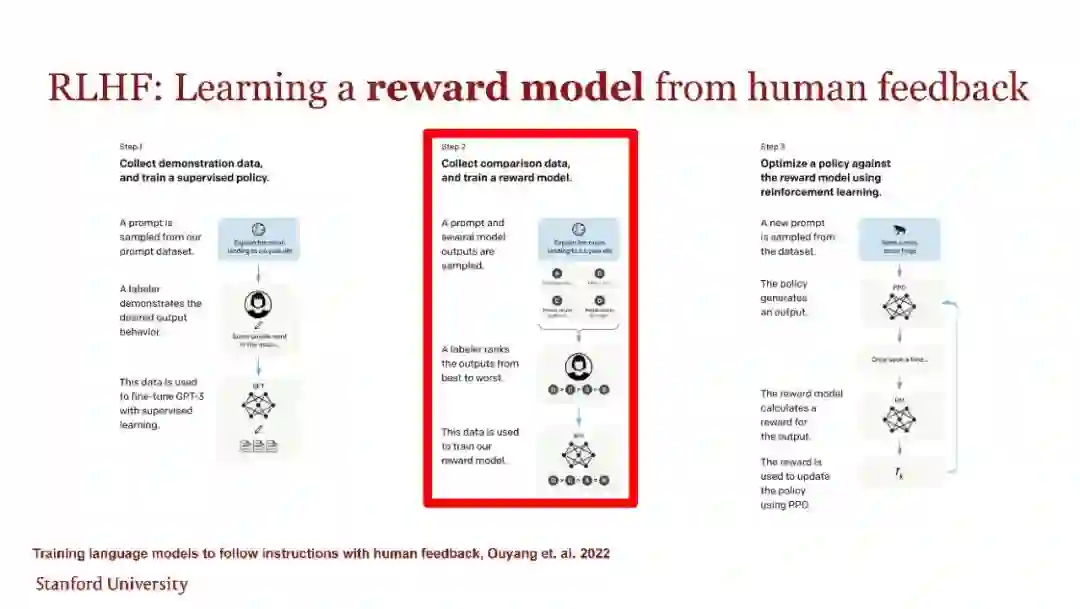

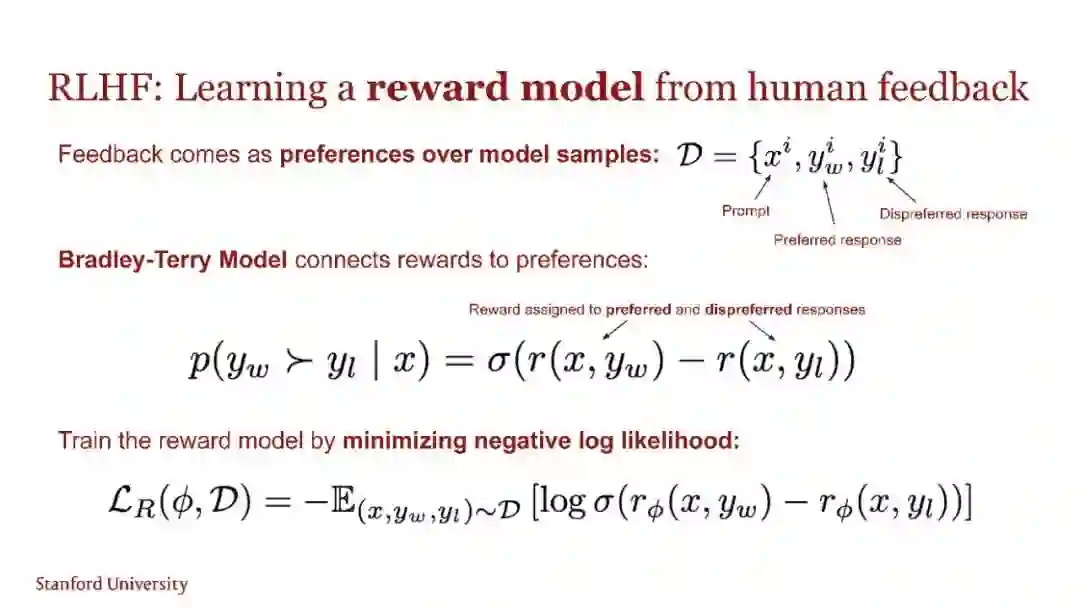

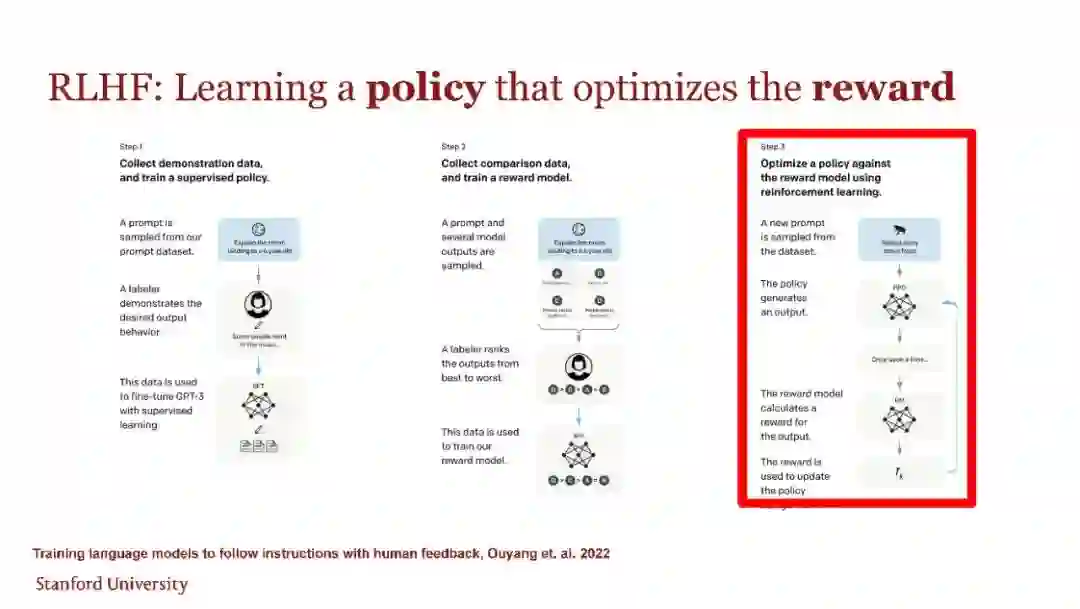

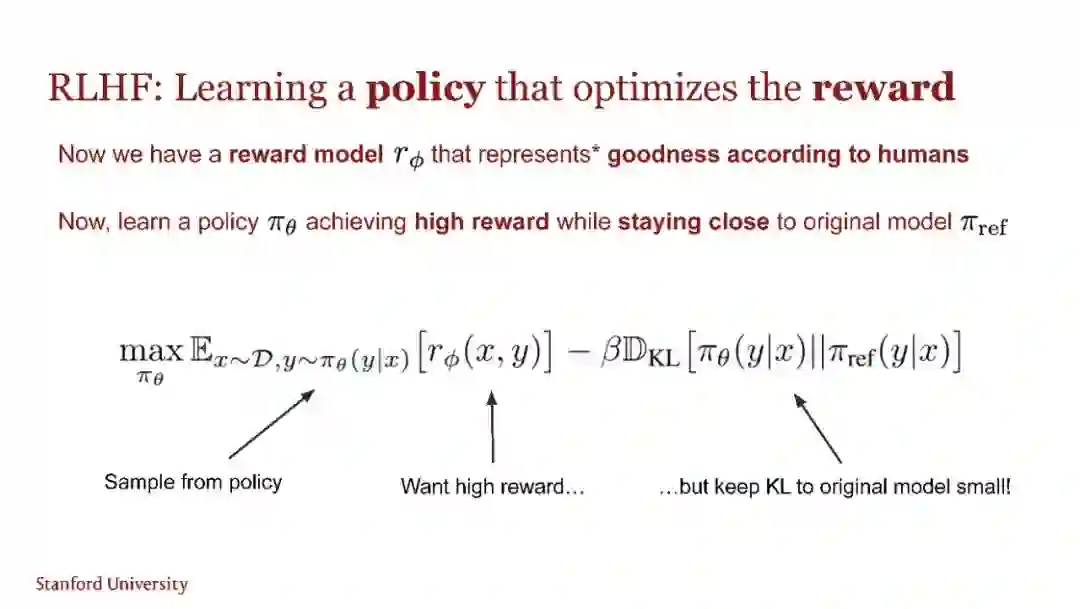

尽管大型无监督语言模型(LMs)可以学习广泛的世界知识和一些推理技能,但由于其训练是完全无监督的,因此难以实现对其行为的精确控制。现有的方法通过收集模型生成结果相对质量的人类标签,并对无监督的语言模型进行微调以符合这些偏好,通常使用来自人类反馈的强化学习(RLHF)。然而,RLHF是一个复杂且常常不稳定的过程,首先需要拟合一个反映人类偏好的奖励模型,然后使用强化学习微调大型无监督语言模型,以最大化这个估计的奖励,同时避免偏离原始模型太远。在本文中,我们引入了一种新的RLHF奖励模型参数化方法,可以以闭合形式提取相应的最优策略,使我们能够仅通过一个简单的分类损失来解决标准的RLHF问题。我们称之为直接偏好优化(DPO)的算法是稳定、高效且计算负担轻微的,消除了在微调过程中从语言模型采样或进行大量超参数调整的需求。我们的实验表明,DPO可以微调语言模型,使其与人类偏好对齐的效果与现有方法相当或更好。值得注意的是,使用DPO进行微调在控制生成结果情感方面超过了基于PPO的RLHF,并且在摘要和单轮对话的响应质量上匹敌或优于现有方法,同时实现和训练过程显著简化。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日