【导读】ICML(International Conference on Machine Learning),即国际机器学习大会, 是机器学习领域全球最具影响力的学术会议之一,因此在该会议上发表论文的研究者也会备受关注。因疫情的影响, 今年第37届ICML大会已于2020年7月13日至18日在线上举行。据官方统计,ICML 2020共提交4990篇论文,接收论文1088篇,接收率为21.8%。与往年相比,接收率逐年走低。ICML官网公布了接受论文列表,小编发现基于Graph相关的paper依然很多,为此,上个月专知小编为大家整理了图神经网络相关的论文,这期小编继续为大家奉上ICML 2020必读的五篇图神经网络(GNN)相关论文-Part 2——贝叶斯GNN、连续GNN、Faster图嵌入、深度GCN、图Pooling、

ICML 2020 Accepted Paper: https://proceedings.icml.cc/book/2020

ICML2020GNN_Part1、KDD2020GNN_Part1、CVPR2020SGNN、CVPR2020GNN_Part2、CVPR2020GNN_Part1、WWW2020GNN_Part1、AAAI2020GNN、ACMMM2019GNN、CIKM2019GNN、ICLR2020GNN、

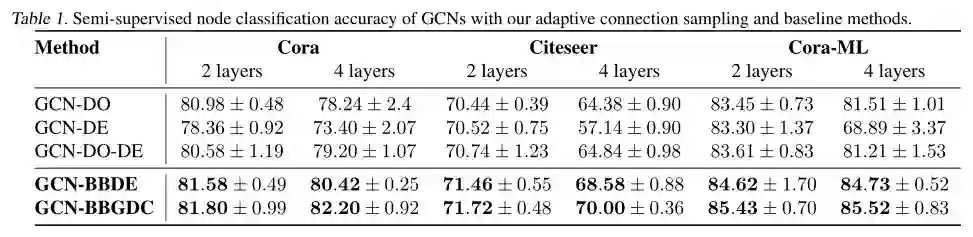

1. Bayesian Graph Neural Networks with Adaptive Connection Sampling

作者:Arman Hasanzadeh, Ehsan Hajiramezanali, Shahin Boluki, Mingyuan Zhou, Nick Duffifield, Krishna Narayanan, Xiaoning Qian

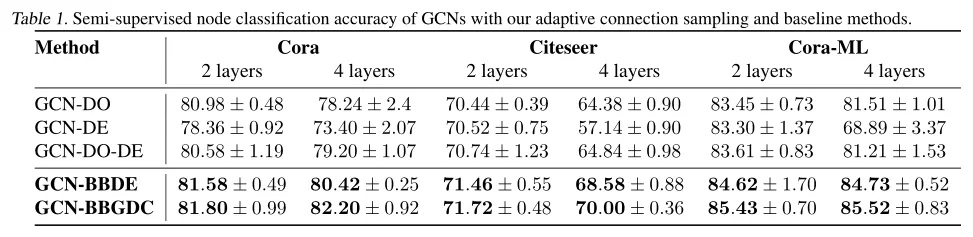

摘要:我们提出了一个用于图神经网络(GNNs)自适应连接采样(connection sampling)的统一框架,该框架概括了现有的用于训练GNN的随机正则化方法。该框架不仅缓解了深层GNNs的过平滑和过拟合趋势,而且使得GNNs在图分析任务中的不确定性学习成为可能。与现有的随机正则化方法那样使用固定的采样率或手动调整它们作为模型超参数不同,我们的自适应连接采样可以与GNN模型参数以全局和局部的方式联合训练。具有自适应连接采样的GNN训练在数学上等价于训练贝叶斯GNN的有效近似。在基准数据集上的消融实验结果验证了自适应学习采样率是在半监督节点分类任务中提高GNNs性能的关键,使其不容易过平滑和过拟合,具有更稳健的预测能力。

网址: https://proceedings.icml.cc/book/4229.pdf

2.Continuous Graph Neural Networks

作者:Louis-Pascal A. C. Xhonneux, Meng Qu, Jian Tang

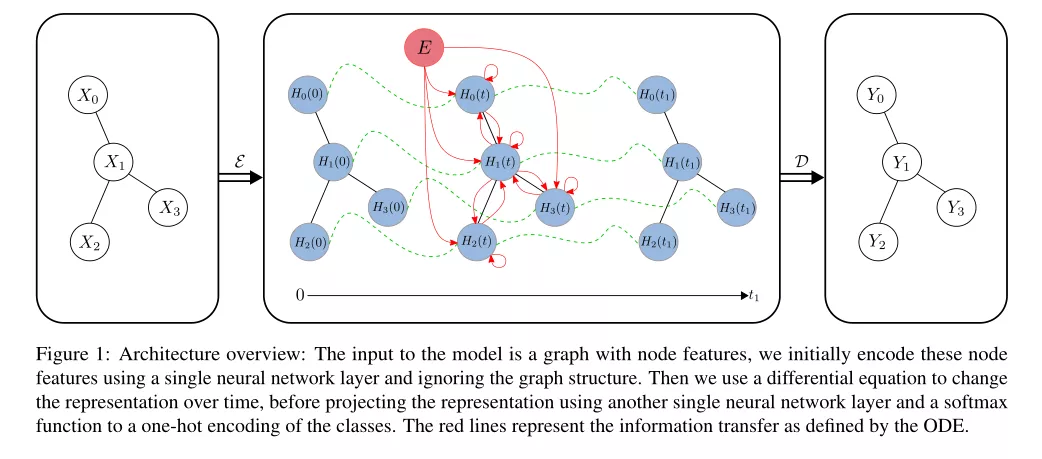

摘要:本文建立在图神经网络与传统动力系统之间的联系之上。我们提出了连续图神经网络(Continuous Graph Neural Networks, CGNN),由于CGNN可以看作是一种特定的离散化方案,它进一步推广了现有的具有离散动力学的图神经网络。其核心思想是如何刻画节点表示的连续动力学,即节点表示的导数。受现有的基于图扩散的方法(如社会网络上的PageRank模型和流行病模型)的启发,我们将导数定义为当前节点表示、邻居表示和节点初始值的组合。我们提出并分析了图上的两种可能的动力学--包括节点表示的每一维(也称为特征通道)独立改变或者彼此交互-这两者都有理论上的合理性。所提出的连续图神经网络对过于过平滑具有较强的鲁棒性,因此可以建立更深层次的网络,从而能够捕获节点之间的长期依赖关系。在节点分类任务上的实验结果证明了我们提出的方法在与基线模型竞争上的有效性。

网址: https://proceedings.icml.cc/book/3916.pdf

3.Faster Graph Embeddings via Coarsening

作者:Matthew Fahrbach, Gramoz Goranci, Richard Peng, Sushant Sachdeva, Chi Wang

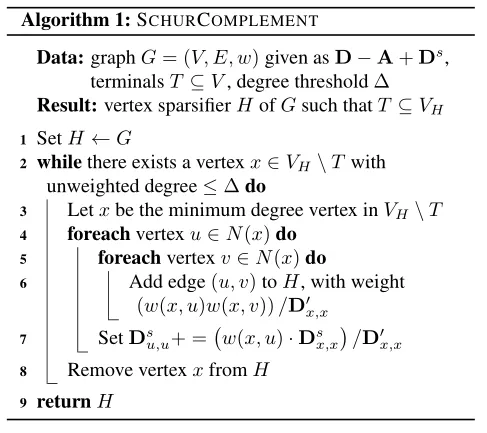

摘要:图嵌入是一种普遍适用于机器学习任务的工具,如图结构数据上的节点分类和连接预测。然而,即使我们只对相关顶点的一小部分感兴趣,计算大规模图嵌入的效率也是很低的。为了解决这个问题,我们提出了一种基于Schur补(Schur complements)的有效图粗化方法,用于计算相关顶点的嵌入。我们证明了这些嵌入被不相关顶点上通过高斯消去法得到的Schur补图精确地保存。由于计算Schur补的代价很高,我们给出了一个近似线性的时间算法,该算法在每次迭代中在相关顶点上生成一个粗化图,该粗化图在期望上与Schur补相匹配。我们在图上进行的预测任务实验表明,计算嵌入到粗化图上,而不是整个图上,在不牺牲精度的情况下,可以节省大量的时间。

网址: https://proceedings.icml.cc/book/4104.pdf

4. Simple and Deep Graph Convolutional Networks

作者:Ming Chen, Zhewei Wei, Zengfeng Huang, Bolin Ding, Yaliang Li

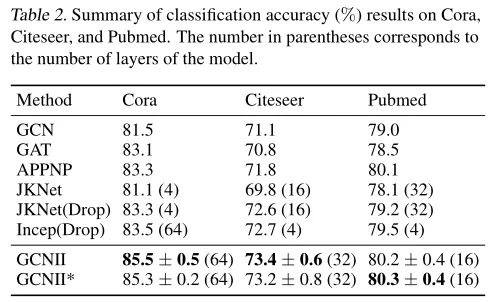

摘要:图卷积网络(GCNS)是一种强大的图结构数据深度学习方法。最近,GCNS及其变体在真实数据集上的各个应用领域都显示出了优异的性能。尽管取得了成功,但由于过平滑的问题,目前的大多数GCN模型都很浅。本文研究了深图卷积网络的设计与分析问题。我们提出了GCNII模型,它是对普通GCN模型的扩展,使用了两个简单而有效的技术:初始残差和恒等映射(Identity mapping)。我们提供了理论和实验证据,证明这两种技术有效地缓解了过平滑问题。我们的实验表明,深度GCNII模型在各种半监督和全监督任务上的性能优于最先进的方法。

网址: https://proceedings.icml.cc/book/3586.pdf

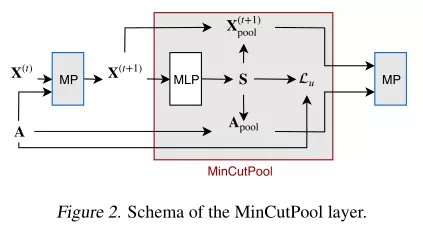

5. Spectral Clustering with Graph Neural Networks for Graph Pooling

作者:Filippo Maria Bianchi, Daniele Grattarola, Cesare Alippi

摘要:谱聚类(SC)是发现图上强连接社区的一种流行的聚类技术。SC可以在图神经网络(GNN)中使用,以实现聚合属于同一集群节点的池化操作。然而,Laplacian特征分解的代价很高,而且由于聚类结果是特定于图的,因此基于SC的池化方法必须对每个新样本执行新的优化。在本文中,我们提出了一种图聚类方法来解决SC的这些局限性。我们建立了归一化minCUT问题的连续松弛(continuous relaxation )公式,并训练GNN来计算最小化这一目标的聚类分配。我们的基于GNN的实现是可微的,不需要计算谱分解,并且学习了一个聚合函数,可以在样本外的图上快速评估。从提出的聚类方法出发,我们设计了一个图池化算子,它克服了现有图池化技术的一些重要局限性,并在多个监督和非监督任务中取得了最好的性能。