论文题目: Specializing Word Embeddings(for Parsing)by Information Bottleneck

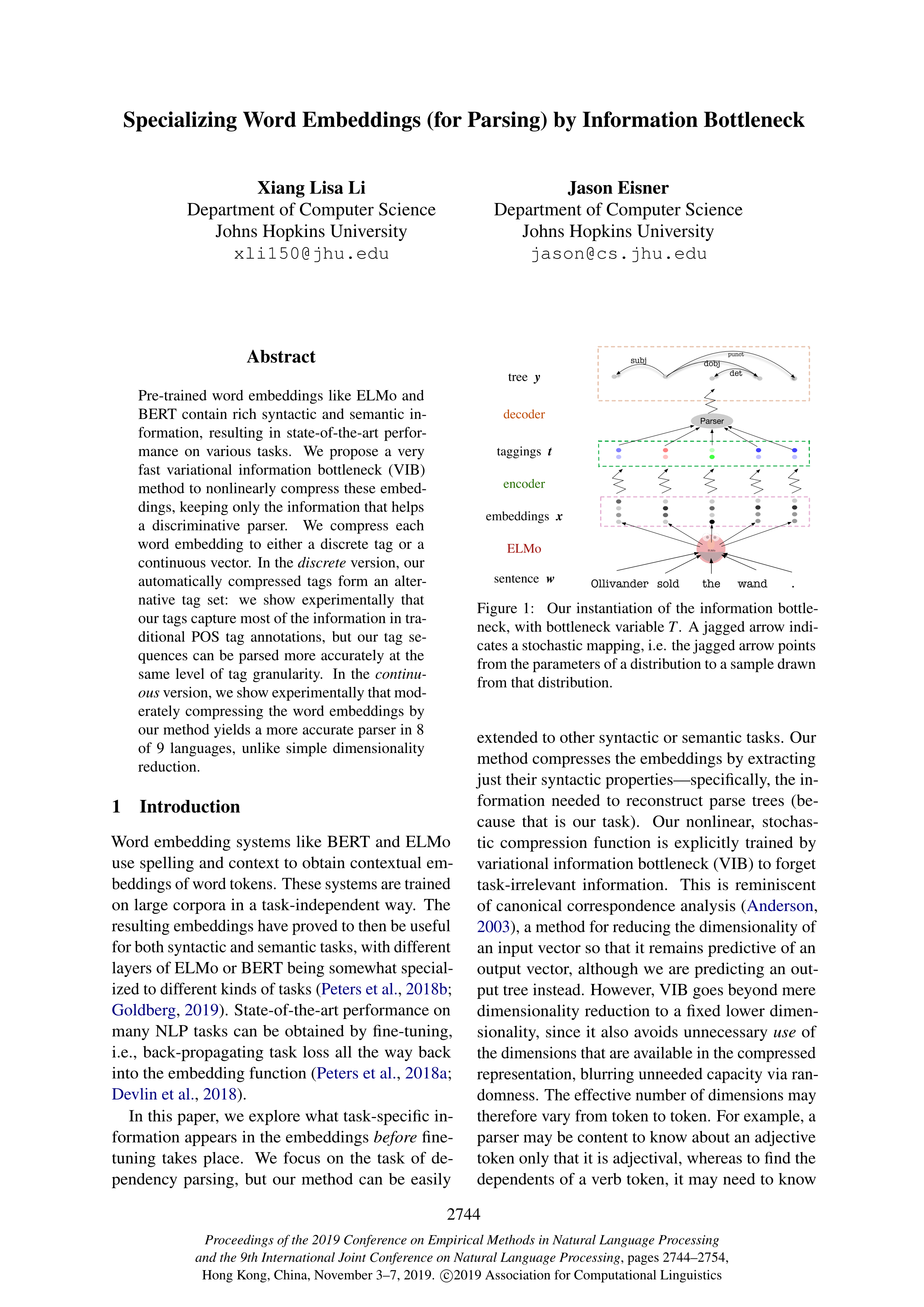

论文摘要: 预训练词向量,如 ELMo 和 BERT 包括了丰富的句法和语义信息,使这些模型能够在各种任务上达到 SOTA 表现。在本文中,研究者则提出了一个非常快速的变分信息瓶颈方法,能够用非线性的方式压缩这些嵌入,仅保留能够帮助句法解析器的信息。研究者将每个词嵌入压缩成一个离散标签,或者一个连续向量。在离散的模式下,压缩的离散标签可以组成一种替代标签集。通过实验可以说明,这种标签集能够捕捉大部分传统 POS 标签标注的信息,而且这种标签序列在语法解析的过程中更为精确(在标签质量相似的情况下)。而在连续模式中,研究者通过实验说明,适当地压缩词嵌入可以在 8 种语言中产生更精确的语法解析器。这比简单的降维方法要好。

作者简介:

Xiang Lisa Li,约翰斯·霍普金斯大学的大四学生,其导师是著名NLP学者Jason Eisner,研究结构化预测和语法。

Jason Eisner,约翰斯·霍普金斯大学计算机科学系教授,ACL研究员。

成为VIP会员查看完整内容

相关内容

专知会员服务

10+阅读 · 2019年11月4日

Arxiv

5+阅读 · 2018年8月6日

Arxiv

5+阅读 · 2018年7月21日