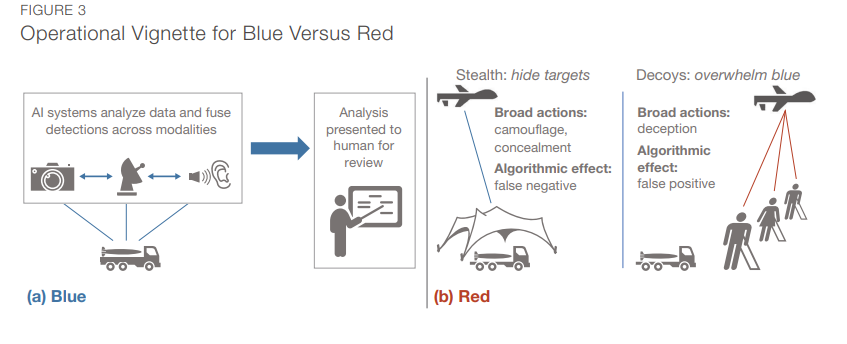

大量的学术文献描述了无数的攻击载体,并表明美国国防部(DoD)的大多数人工智能(AI)系统一直处于危险之中。然而,兰德公司的研究人员调查了旨在隐藏对象(导致算法假阴性)的对抗性攻击,发现许多攻击在操作上是不可行的,因为知识要求高,攻击载体不实用,所以设计和部署不可行。正如研究人员在本报告中所讨论的那样,有一些屡试不爽的非对抗性技术,其成本更低,更实用,而且往往更有效。因此,针对人工智能的对抗性攻击对国防部应用构成的风险比学术研究目前所暗示的要小。然而,精心设计的人工智能系统以及缓解策略,可以进一步削弱这种攻击的风险。

关键发现

- 旨在从人工智能中隐藏物体的对抗性攻击对国防部应用构成的风险比学术研究目前所暗示的要小。

- 在现实世界中,由于高知识要求和不可行的攻击载体,这种对抗性攻击很难设计和部署;通常有成本更低、更实用、更有效的非对抗性技术可用。

- 融合不同传感器模式、信号采样率和图像分辨率的数据和预测,可以进一步减轻针对人工智能的对抗性攻击的风险。

建议

- 美国防部应通过考虑对手如何可行地影响模型来评估其人工智能模型在对抗性攻击方面的风险。它还应该评估有关模型的知识泄露如何影响攻击的有效性,并估计与对手行动相关的成本。

- 美国防部应保持对学术界最先进的技术的了解,以在现实世界的场景中攻击人工智能,并了解这些技术如何可行地影响自己和对手的操作概念。

- 美国防部应开发强大的人工智能模型、预处理技术和适当的数据融合系统,以大大增加对手实施攻击的资源成本。

- 美国防部应投资于人工智能系统的响应性支持团队,以快速检测、识别和回应对手的威胁。

成为VIP会员查看完整内容