人工智能(AI)在国防领域的使用带来了重大的伦理问题和风险。随着人工智能系统的开发和部署,澳国防部将需要解决这些问题,以维护澳大利亚国防军的声誉,维护澳大利亚的国内和国际法律义务,并支持国际人工智能制度的发展。

这份报告《案例研究:国防中的伦理人工智能方法应用于战术指挥和控制系统》是总理与内阁部(PM&C)、澳国防部和澳大利亚国立大学(ANU)3A研究所之间的科技(S&T)合作的产物。它使用《国防中的伦理人工智能方法》[1]来探讨设想中的人工智能战术指挥和控制(C2)系统的伦理风险,该系统整合了各种自主功能,以协助单个人类操作员同时管理多个无人驾驶车辆。

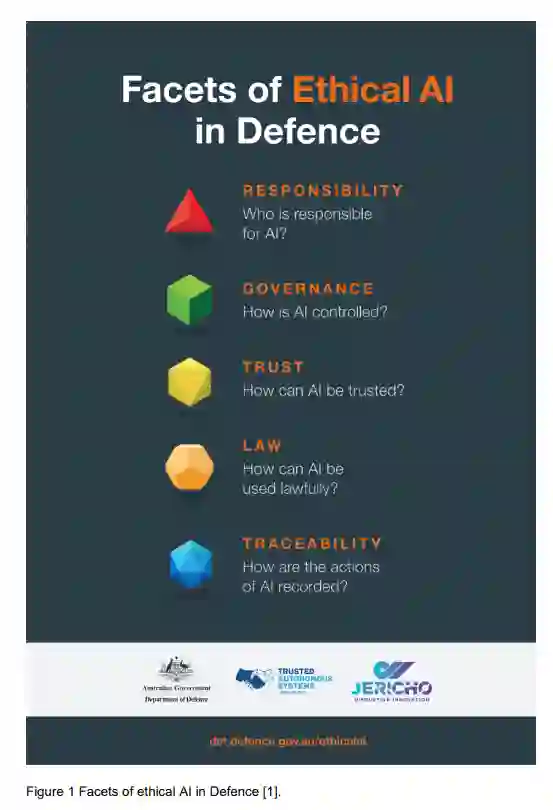

使用 "国防中的伦理人工智能方法 "对这一设想的C2系统进行分析,为三个利益相关者群体提供了关键的发现:澳国防部;人工智能技术开发者,以及那些寻求使用或迭代 "国防中的伦理人工智能方法 "的人。

对于澳国防部,该报告确定了关键的政策差距,并建议在以下方面采取行动。

-

对人工智能所做的决定和使用人工智能所做的决定制定一个问责框架

-

对操作员、指挥和系统开发人员的教育和培训

-

管理支撑许多人工智能应用的数据,包括其收集、转换、存储和使用。

如果不采取行动,这些差距使澳国防部容易受到重大的声誉和业务损害。

对人工智能技术开发者的其他关键发现涉及到有效性、整合、授权途径、信心和复原力等主题。总的来说,这些发现鼓励开发者考虑最有效的系统或算法(例如,在速度或准确性方面),是否一定是为决策者提供帮助的最佳选择。在某些情况下,与规范性决策更一致的效率较低的算法可能更合适。此外,显然需要研究哪些信息是做出好的判断所必需的(特别是在问题复杂、背景重要的情况下);以及应该如何快速传达这些信息。通过考虑作为分析的一部分而开发的七种假设的道德风险情景,可以进一步探讨这些关键的发现。

对于那些寻求应用或迭代《国防伦理人工智能方法》的人来说,报告建议开发更多的工具,以帮助从业者确定对其特定需求具有最大相关性和效用的领域;以及一套全面的定义,以帮助应用该方法。