人工智能(AI)应用于武器系统是过去10年研究的一个主要趋势。这些举措旨在提高武器的准确性,执行非主动的瞄准手段,帮助导航和制导与控制(例如,在全球定位系统被拒绝的情况下),并减少与传统的基于物理学的方法相比的整体计算资源,以便在更小、更实惠的武器系统上实现智能瞄准。这项研究还包括将作战人员的战斗空间扩展到无人驾驶飞行器,并使用蜂群方法与有人和无人平台进行合作。

我们首先概述了人工智能的描述和历史,并概述了人工智能在武器系统中的原理、技术和应用。这包括对监督自主系统;制导、导航和控制;行为和路径规划;传感器和信息融合;智能战略和规划;兵棋推演建模;以及认知电子战的研究和计划的回顾。

然后,对将人工智能应用于武器系统的系统和项目进行了调查。虽然重点是基于美国的系统和项目,但也包括一个关于俄罗斯和中国相关系统的小节。最后,我们对将人工智能用于武器系统的伦理考虑进行了简要评论。

引言

1.1 问题陈述

机器学习(ML)和人工智能研究的最新进展揭示了人工智能在实现创新、增加机器的效用以及增强人类能力和经验方面的力量和潜力。人工智能技术的颠覆性和其影响的深度还没有被广大公众完全掌握。考虑到新时代的新兴技术威胁,展示关键和相关的人工智能研究和最先进的技术是很重要的,这些技术不仅为武器系统提供了比传统武器系统更多的自主权,而且大大增加了它们的杀伤力和战斗生存能力。最终,人工智能在开发改变游戏规则的技术方面带来了巨大的战略机遇,这将确保国家安全、繁荣和技术领先地位。

1.2 常规武器系统

美国军方在创造先进的常规武器技术方面取得了巨大的进步,这些技术支持了士兵在战场上的任务并增强了他们的能力。这些常规武器技术大多是自动化系统,在计划、执行和完成一项任务或使命时依靠一套预先编程的规则。然而,在中国和俄罗斯等国家新开发的武器的前沿阵地上,人工智能支持的战争和高超音速武器给美国武装部队带来了新一代的质量挑战。下一代战斗的步伐要求为战略决策进行时间紧迫和大量的战斗信息处理,这使得美国的许多常规武器系统只能执行低风险的任务,并在核领域之外处于威慑力减弱的态势。

必须承认,人是昂贵的训练资产。在战场上增加更多的人员并不是推进最先进的战争的优雅或廉价的解决方案。相反,用支持人工智能的智能硬件来增强人在回路中的系统,可以在战区提供更多的眼睛和耳朵,并通过使人工智能系统执行一些简单和常规的任务来释放人类的决策。

此外,无人驾驶作战飞机系统(UCAS)是一种成熟的具有成本效益的系统解决方案,用于执行情报、监视和侦察(ISR)任务和远程空袭。然而,自动化能力仍然受到人类在环形操作、评估和接触的限制。虽然在任何可预见的未来都没有打算消除武器化人工智能系统中的人类元素,但人类的能力仍然构成这些系统协同潜力的上限。但是,一个由人工智能驱动的智能武器系统的新生态系统将迎来新的战争形式和战略。

人工智能国家安全委员会在其2021年的报告中提出,美国国防部(DoD)的军事企业在整合人工智能技术方面落后于商业部门,并敦促在2025年前为整个国防部广泛整合人工智能奠定基础[1]。

1.3 人工智能的简要历史

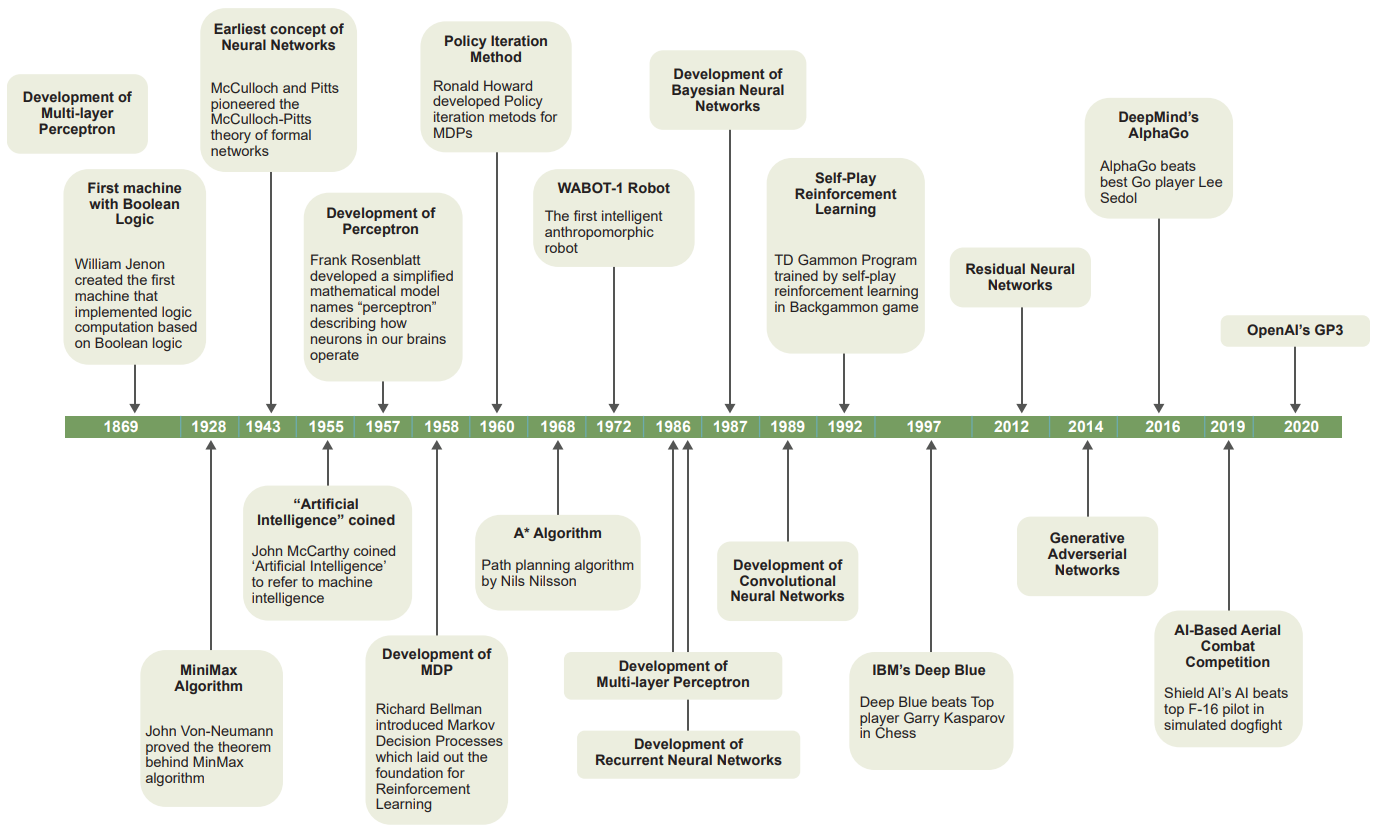

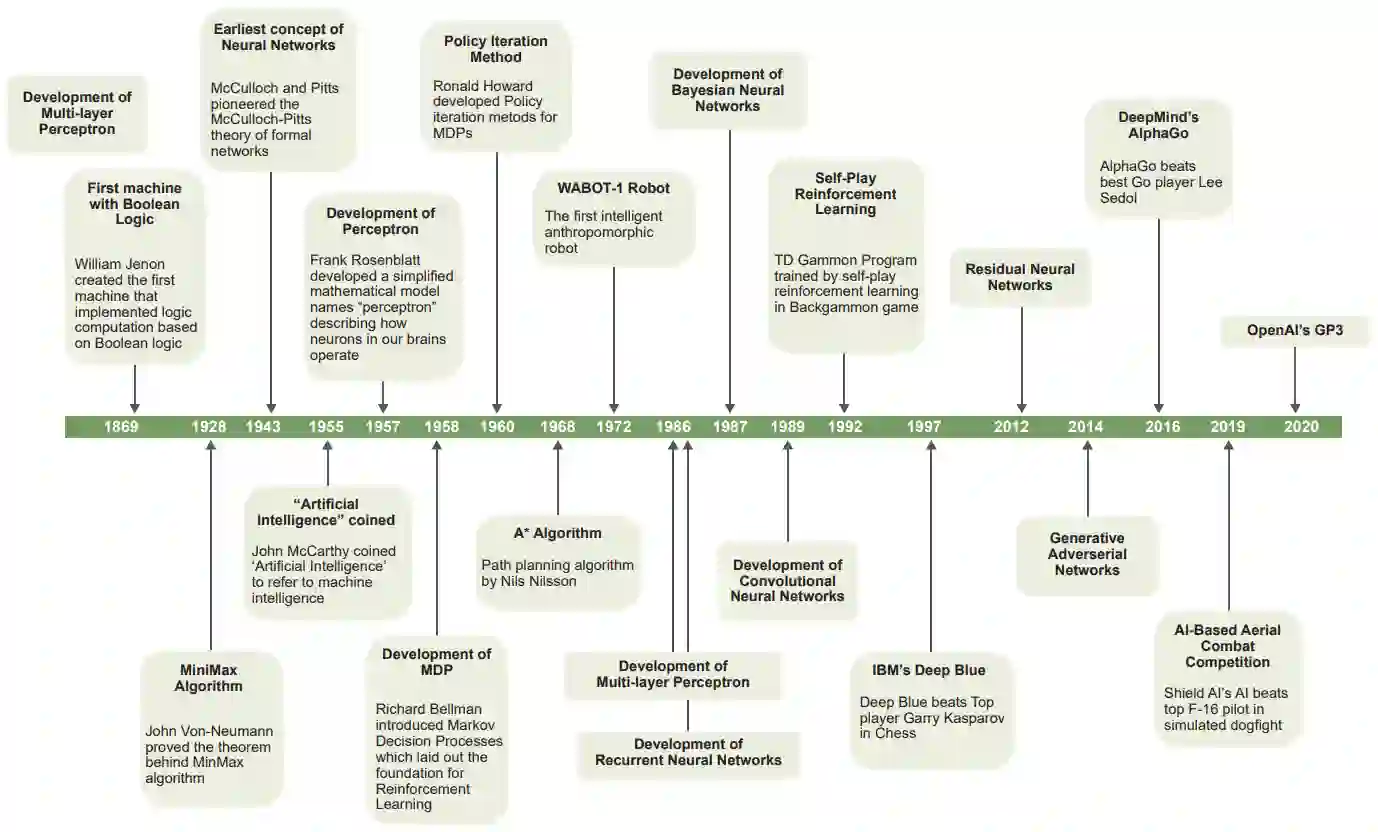

几个世纪以来,哲学家们一直在考虑以某种形式人工复制人类智能的某个方面的概念。1869年,威廉-杰农创造了第一台基于布尔逻辑实现逻辑计算的机器。该机器能够比人类更快地计算布尔代数和维恩图。随着这种逻辑计算机器的发展,人们很自然地质疑机器是否可以通过逻辑推理来为人类解决问题并做出决定。图1-1中的时间轴显示了人工智能的历史和演变,并在本节中进行了详细说明[2]。

在理论计算机科学的一些最早的工作中,英国数学家阿兰-图灵(Alan Turing)思考了机器是否能像人类一样智能地行为和解决问题的问题。他在他的图灵测试中提出,如果一台机器能模糊地模仿人类这样的智能生物,那么这台机器就是智能的。这一理论测试成为一种指导性的形式主义,在这种形式主义中,当前的机器被测试其模仿人类智能概念的能力或潜力。作为测试的见证,Loebner奖是一个图灵测试竞赛,其任务是根据图灵提出的基本问题来评估机器智能研究的现状。

1928年,约翰-冯-诺伊曼证明了Minimax算法的基本定理,该算法旨在提供一种在零和博弈过程中使最大可能损失最小的策略。

图1-1. AI历史年表

在第二次世界大战的高峰期,阿兰-图灵和他的团队开发了一种机器算法,可以破译德国的英格玛信息密码。他的算法的成功,推动了将复杂任务委托给机器的进一步努力,是机器计算的基础,也是ML发展的先导。

1943年,McCulloch和Pitts开创了神经网络(NN)的最早概念--McCulloch-Pitts的形式网络理论--这在1949年冯-纽曼在伊利诺伊大学的四次演讲中得到了体现[3]。

大约在同一时间,约翰-麦卡锡,一位计算机科学家,在1955年创造了 "人工智能 "来指代机器智能;计算机科学家艾伦-纽维尔;以及赫伯特-A-西蒙,一位经济学家和政治学家,开创了第一个旨在自动推理的真正程序(称为逻辑理论家)。随着这一突破性的努力,对智能机器的探索开始了,为人工智能作为计算机科学的一个新的学术研究领域铺平了道路。

1957年,一位名叫弗兰克-罗森布拉特博士的心理学家开发了一个名为 "感知器 "的简化数学模型,描述了我们大脑中的神经元如何运作。这一成就被强调为 "Perceptron收敛定理"。

同年,理查德-贝尔曼开发了动态编程,用于解决一类最佳控制问题。他还介绍了离散随机最优控制问题的马尔科夫决策过程表述,这为现在所称的 "强化学习 "奠定了重要基础。

在这些发展之后,另一位名叫阿瑟-塞缪尔的人工智能先驱利用他早先在ML方面的开创性工作,成功地开发了第一个检查者算法。他实现了现在被称为 "Alpha-Beta修剪 "的早期版本,这是一种搜索树方法,通过Minimax算法减少评估节点的数量。1959年,一位名叫威廉-贝尔森(William Belson)的统计学家开发了一种名为决策树的非参数、监督学习方法的早期版本。

在20世纪60年代,人工智能研究的重点是解决数学和优化问题。1960年,罗纳德-霍华德提出了马尔科夫决策过程的策略迭代方法,建立了一些与强化学习有关的最早的工作。

到1968年,著名的路径搜索算法A-star是由计算机科学家尼尔斯-尼尔森提出的。60年代末,机器人建模、控制和机器视觉方面取得了进展,导致在1972年开发了第一个名为WABOT-1的 "智能 "拟人机器人,并整合了肢体操纵、视觉和语音系统。

Harry Klopf的 "适应性系统的异质理论 "的复兴对适应性系统的试错范式的发展有很大影响。1977年,Ian Witten提出了最早的强化学习系统之一,使用了时间差法。理查德-萨顿和安德鲁-巴托设计了一种强化学习算法,称为演员批评法。

由于70年代中期到80年代末计算机的计算能力限制,人工智能研究在有大量数据处理要求的应用中发现了困难,如视觉学习或优化问题。同时,数学研究 "证明 "了(单层)感知器不能学习某些模式。此外,1973年发表的一份Lighthill报告对人工智能的潜力非常悲观,这导致人工智能研究的资金被削减。结果,资金短缺导致人工智能的研究经历了一个被称为 "人工智能冬天 "的时期。

到了80年代中后期,继1986年多层感知器的发展之后,在NNs方面也做出了重要的理论贡献。这些贡献是David Rumelhart在1986年开发的递归神经网络(RNNs),John Denker等人在1987年开发的贝叶斯网络,以及Yann LeCun在1989年开发的卷积神经网络(CNNs)。

此外,Chris Watkins在1989年开发了另一种重要的强化学习方法,称为 "Q-Learning"。1992年,在IBM的Thomas J. Watson研究中心,Gerald Tesauro通过自我强化学习为双陆棋游戏训练了TD Gammon程序。1997年,IBM的 "深蓝 "计算机使用粗暴的、基于搜索的算法击败了国际象棋世界冠军加里-卡斯帕罗夫,使其成为第一个在国际象棋中战胜顶级职业选手的程序。

在90年代末和21世纪初,在ML中看到的大部分进展是由计算机处理、存储和分布式计算方面的指数级进展所推动的。2007年,需要大量计算资源的保证最优玩法在跳棋中得到了解决。在过去的20年里,图形处理单元用于通用计算的激增导致了今天人工智能应用的进一步进展,特别是在2012年和2014年,不同的NN拓扑结构,如残差网络和生成式对抗网络的发展。

2015年,ImageNet竞赛,一个为约400万张图像的ImageNet图像集开发分类器的公开竞赛,有一个冠军,其错误率被认为低于一个人。2016年,DeepMind的AlphaGo程序在击败当时被认为是最优秀的围棋选手李世石后,成为最佳AlphaGo选手。继AlphaGo的学习能力之后,AlphaZero在2017年扩展了AlphaGo,成为国际象棋和Shogi的最佳棋手。

2019年,美国国防部高级研究计划局(DARPA)推出了AlphaDogfight,这是基于人工智能的空战算法在模拟的F-16狗斗中与经过顶级训练的飞行员进行的一系列三轮竞赛。第一轮和第二轮比赛中,人工智能程序相互竞争。第三轮将人工智能胜利者的飞行员提炼出来,与美国空军武器学校的优秀毕业生进行竞争。苍鹭系统的人工智能飞行员不仅在竞争激烈的人工智能空中战斗人员中获胜,而且在与训练有素的人类F-16飞行员的较量中取得了令人难以置信的五次胜利。

OpenAI在2020年5月推出了一个名为GP3的 "自然语言处理 "模型,它生成的写作内容与人类无异。其最新版本可以从简单的描述性语言生成编程语言代码[4]。人工智能的历史继续向前发展,特别是对国防部的武器系统应用。本报告的其余部分将调查与武器系统有关的当代人工智能技术和系统。

1.4 什么是AI?

根据Barr和Feigenbaum的说法,人工智能被定义为 "计算机科学中与设计智能计算机系统有关的部分,即表现出我们与人类行为中的智能有关的特征的系统--理解语言、学习、推理、解决问题等等"[5]。

Stuart Russel和Peter Norvig在他们的《人工智能:一种现代方法》一书中对人工智能的最新定义是:"设计和建造能够从环境中接收感知并采取影响环境的行动的智能体" [6]。

Pei Wang优雅地将智能定义为 "在知识和资源不足的情况下的适应"[7]。虽然该定义没有说明适应的目的(如目标),但它揭示了为达到这种智能需要完成的工作。

如果要以人类为中心定义人工智能,即执行人类智能水平的任务,那么人工智能需要感知、推理、知识构建、推理、决策和计划、学习、交流,以及有效移动和操纵环境的能力。

人工智能的科学目标是回答哪些关于知识表示、学习、规则系统、搜索等的想法可以解释各种类型和水平的真实智能。工程目标是为不同的应用领域开发人工智能技术,以解决现实世界的问题。

在人工智能的科学基础上,我们发现来自不同科学领域的可识别概念--哲学、逻辑/数学、计算、心理学和认知科学、生物学和神经科学以及进化。在寻求发现和更好地理解人工智能是什么或将是什么的过程中,来自这些不同知识领域的贡献已经被证明是不可避免和不可或缺的了。许多研究人工智能的领域都在同时构建人类认知如何运作的模型,并在它们之间采用有用的概念。例如,NN,一个源于生物学的概念,试图在简化的人工神经元的基础上建立人工系统,这个概念导致了一个简单的抽象知识结构的表示,足以解决大型计算问题集。

人工智能大致分为三个主要层级--人工狭义智能(ANI)、人工通用智能(AGI)和人工超级智能(ASI)。图1-2说明了这三个层级中的各种分组,本节将更多地讨论这些分组。

1.4.1 人工狭义智能(ANI)

ANI是对一个执行狭窄或单一任务的人工智能系统的描述。它可以包括各种方法来获得结果,如传统的ML(以图像分类为例)或目标检测(包括ML和基于规则的系统)。给定一组规则或约束,它的目标是提供一组代表狭义任务的输出。ANI不会扩展或学习新的认知,也不会自我学习新的操作模式。数据挖掘、大多数专家系统和针对某一应用的预测功能(例如,垃圾邮件检测和面部识别)都被认为是ANI的形式。ANI还包括 "有限记忆人工智能"--用于自动驾驶汽车的系统类型,使用过去的经验(训练),并学习做决定,随着时间的推移而改进。

1.4.2 人工通用智能(AGI)

AGI是一种更强大的智能形式,因为它被更多类似人类智能的特征所增强,例如自主学习的能力和解释情绪和语音语调的能力。这使得与AGI相关的智能与人类的智能水平相当。AGI的一些关键核心能力如下:

- 推理、解决问题、运用策略和在不确定情况下做出决定的能力。

- 展示知识的能力。

- 计划的能力。

- 学习的能力。

- 用自然语言交流的能力。

- 将所有上述内容整合为一个共同目标的能力。

- 类似人类的思维与图灵测试等计算的结合。

1.4.3 人工超级智能(ASI)

ASI是一种超越最聪明的人类头脑的智能模型。实现ASI的方法仍在概念化中,但将是那些超越AGI并需要某种自我意识的系统。这些系统最好能代表所有人类的认知能力,甚至更多。

1.5 机器学习(ML)

ML是机器从数据中学习的能力,目的是做出准确的预测。它大致分为四类学习,提供了丰富的专用和通用的技术家族。

1.5.1 监督学习

在这种形式的学习中,训练数据使用包含的输入和标记的或预定的输出数据。如果有缺失的输入或输出条目,它们会被预处理,以便将一个输入正确地映射到其真正的对应输出。通过从正确生成的训练数据集中学习,系统学会了将不在原始数据集中的输入与预测的输出(标签或值)联系起来。这种类型的训练解决的典型问题是回归和分类[8]。

1.5.2 无监督学习

这种形式的学习中,系统直接从未标记的数据中发现有趣的或隐藏的结构[9]。无监督学习被用于聚类分析、降维或估计可能产生输入数据的密度[8]。

1.5.3 半监督学习

当数据集包含有标记的和无标记的数据时,这种学习形式的系统利用无标记的数据来更好地捕捉潜在的数据分布,并获得一个更好的预测,如果它只从标记的数据中训练的话。这种学习形式适用于训练数据集中的标注数据远远少于未标注数据的情况[8]。

1.5.4 强化学习

在这种学习模式中,系统使用奖励/惩罚机制进行训练,这样它所选择和执行的行动,当行动可取时,会使系统得到奖励,当行动不可取时,会受到惩罚。强化学习问题涉及学习如何做(如何将情况映射到行动上)以最大化数字奖励信号[9]。

03 人工智能在武器系统中的应用

人工智能有可能应用于武器系统生态系统的许多方面。它被用来控制系统,从而实现自主性和提高性能,以在具有挑战性的环境中选择指导、导航和控制方面的问题。同样,人工智能可用于解决任务和路径规划中的挑战性问题,从而实现更高水平的复杂任务目标和操作要求。人工智能也被用于电子战领域的支持、反制,甚至是反制措施。它还可能被用于来自不同系统层次和领域的信息融合,以泄露抽象的高价值战场情报,并提供关键线索和快节奏的决策,从而在现代战争中创造宝贵的战术优势。

报告的这一部分将强调最先进的人工智能方法在适用于自主和武器系统的各种人工智能问题领域的使用。它是根据以下问题领域来组织的。

-

自主性

-

感知中的人工智能

-

制导、导航和控制中的人工智能

-

任务和路径规划

-

智能战略

-

对手建模

-

认知型电子战

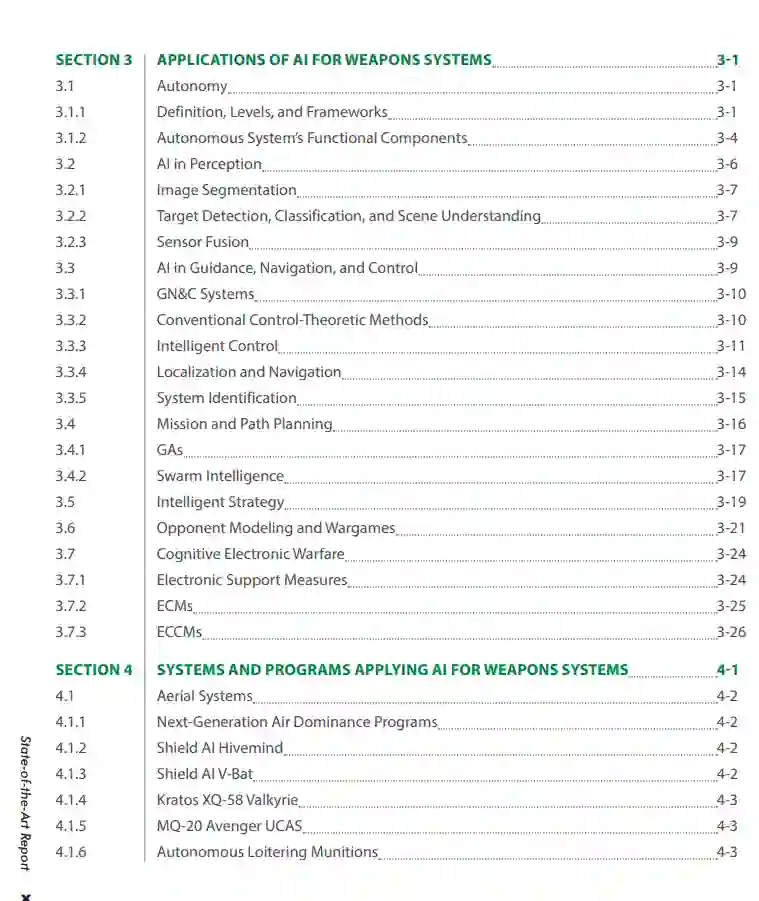

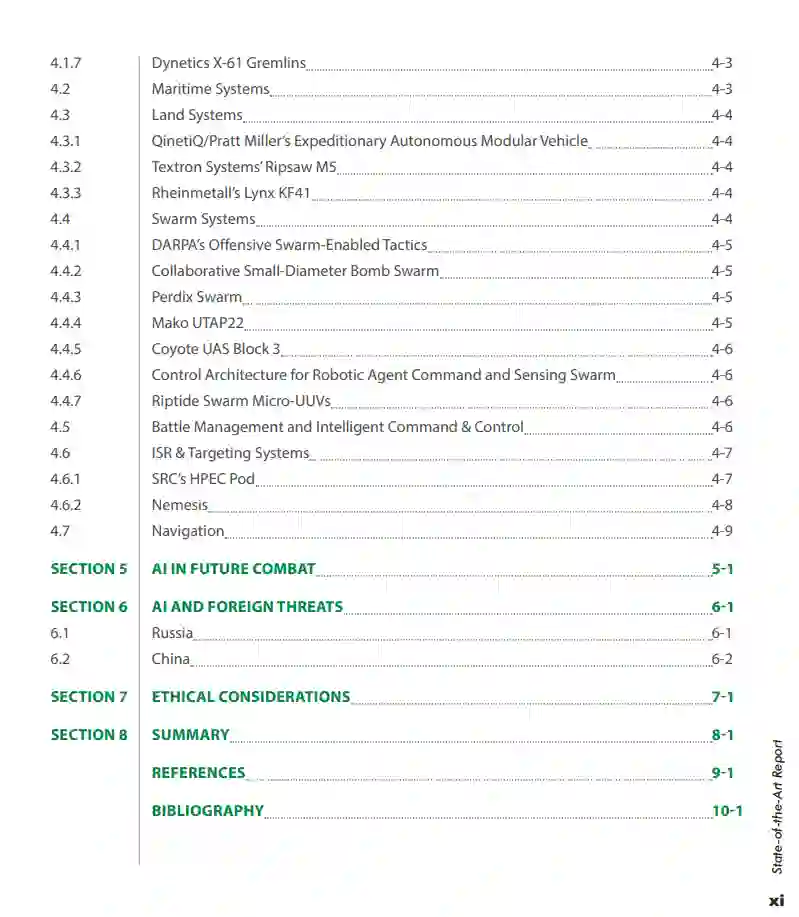

提纲

第一章 引言

1.1问题陈述

1.2常规武器系统

1.3 AI简史

1.4什么是AI?

1.4.1 ANI

1.4.2 AGI

1.4.3 ASI

1.5 ML

1.5.1监督学习

1.5.2无监督学习

1.5.3半监督学习

1.5.4强化学习

第二章 最先进的方法

2.1学习人工智能范例

2.1.1深度学习

2.1.2强化学习

2.2随机优化和搜索算法

2.2.1随机优化

2.2.2图形搜索算法

2.3新兴人工智能范例

2.3.1神经符号AI

2.3.2 NE

第三章 人工智能在武器系统中的应用

3.1自主性

3.1.1定义、级别和框架

3.1.2自主系统的功能组件

3.2感知中的人工智能

3.2.1图像分割

3.2.2目标检测、分类和场景理解

3.2.3传感器融合

3.3制导、导航和控制中的人工智能

3.3.1 GN&C系统

3.3.2常规控制理论方法

3.3.3智能控制

3.3.4本地化和导航

3.3.5系统识别

3.4任务和路径规划

3.4.1GAs

3.4.2群体智能

3.5智能策略

3.6对手建模和兵棋推演

3.7认知电子战

3.7.1电子支持措施

3.7.2 ECMs

3 .7.3 ECCMs

第四章 将人工智能应用于武器系统的系统和程序

4.1天线系统

4.1.1下一代空中优势计划

4.1.2 Shield AI Hivemind

4.1.3 Shield AI V-Bat

4.1.4 Kratos XQ-58 Valkyrie

4.1.5 MQ-20 Avenger UCAS

4.1.6自主弹药

4.1.7 Dynetics X-61小精灵

4.2 海军系统

4.3 陆军系统

4.3.1 QinetiQ/Pratt Miller的远征自主模块化飞行器

4.3.2Textron系统公司的Ripsaw M5

4.3.3 Rheinmetall公司的Lynx KF41

4.4 群系统

4.4.1 DARPA的攻击性蜂群战术

4.4.2自主协同小直径炸弹群

4.4.3 Perdix群

4.4.4 Mako UTAP22

4.4.5 Coyote UAS Block 3

4.4.6机器人代理命令和传感群的控制架构

4.4.7激流勇进微型无人潜水器

4.5战斗管理和智能指挥与控制

4.6 ISR和目标系统

4.6.1 SRC的HPEC Pod

4.6.2复仇女神

4.7导航

第五章 未来作战中的AI

第六章 人工智能和外来威胁

6.1俄罗斯

6.2中国

第七章 伦理考量

第八章 总结

参考文献