报告建议,美国国防部应科学评估对手实施AI对抗性攻击的影响程度,并增强对先进技术的态势感知能力,以了解对手可能采取的作战理念。

2022年12月,美国兰德公司(RAND Corporation)发布题为《防御人工智能对抗性攻击的可行性分析》(Operational Feasibility of Adversarial Attacks Against Artificial Intelligence)的报告。报告分别在光电系统、合成孔径雷达和信号情报三种数据源的场景下,对防御AI对抗性攻击进行了可行性分析,并认为,美国国防部部署的人工智能(AI)系统面临对抗性攻击的风险,但其风险小于学术界的评估。报告建议,美国国防部应科学评估对手实施AI对抗性攻击的影响程度,并增强对先进技术的态势感知能力,以了解对手可能采取的作战理念。

一、 人工智能的对抗性攻击

人工智能对抗性攻击是指通过扰动人工智能输入而使神经网络计算错误导致错误分类的一种技术。这种攻击会对人工智能在操作环境中的安全性和有效性构成重大风险。学界也对这类攻击和防御进行了大量研究,但大部分都缺乏可行性和实用性的考虑。

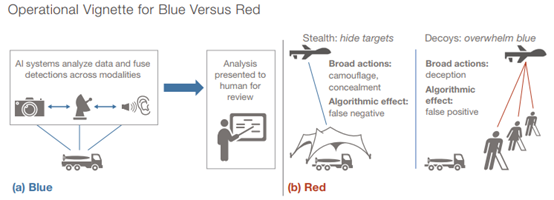

为了研究军用人工智能系统在防御对抗性攻击的可行性,兰德公司采用了基于观察-定位-决策-行动(OODA)循环的分析框架,该框架是从电子战的经验优化而来。同时,兰德公司假定蓝方(美国国防部)使用人工智能系统的目标是快速定位红方(敌方)的高价值资产,而红方目标则是确保蓝方不能够侦查到其高价值资产。

来源:《Operational Feasibility of Adversarial Attacks Against Artificial Intelligence》报告 蓝方应用于智能系统的数据来源于情报、监视与侦查(ISR)光电平台。经过研究,兰德公司将影响人工智能对抗性攻击的数据来源分为3种:光电系统(EO)、合成孔径雷达(SAR)和信号情报(SIGINT),并从人工智能的数据来源分析防御对抗性攻击的可行性。 二、 三种不同数据来源的AI对抗性攻击分析

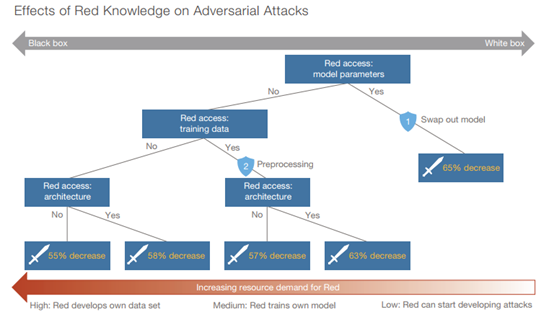

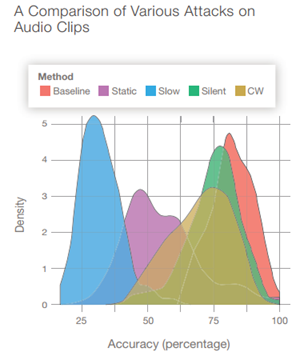

(一)、基于光电系统数据来源的AI对抗性攻击 基于光电系统数据来源的AI对抗性攻击通常会采用物理对抗的方式来降低AI系统识别目标的能力。有相关研究表明,对抗性攻击的成功率与对目标模型的了解程度具有强相关性。兰德公司将对抗性攻击场景分为两类,一类是白盒攻击,在该场景下攻击完全了解目标模型的数据和参数,另一类则是黑盒攻击,这类场景下攻击者完全不了解目标模型。 兰德公司基于CIFAR-10数据集训练了深度神经网络模型,并以73%的分类准确度为基准。兰德公司将红方对蓝方模型的了解程度划分为5档,都介于白盒攻击和黑盒攻击之间,攻击效果如下图所示。可以看出,红方对蓝方模型了解越多,蓝方模型的分类准确率就越低,最低则降低到8%(白盒攻击)。

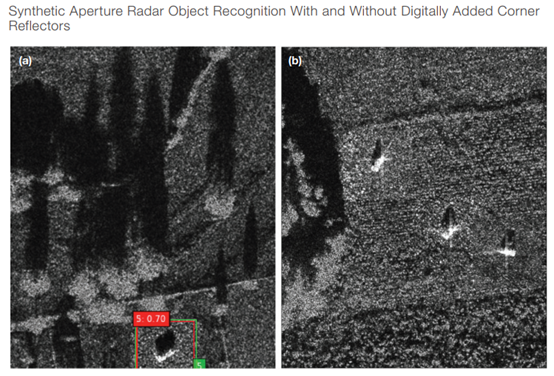

来源:《Operational Feasibility of Adversarial Attacks Against Artificial Intelligence》报告 基于此,兰德公司为蓝方提出两种类似场景的防御措施。第一,将训练数据分拆为n份,每份开发一个独立的模型,并部署其中一个。第二,当面临可信性风险的时候,放弃原部署的模型,并部署其他模型上线。但是,这种防御措施也有局限性。例如,蓝方必须确保拥有大量的数据源,其次分拆训练数据会导致蓝方模型的准确率降低。 (二)、基于合成孔径雷达数据来源的AI对抗性攻击 合成孔径雷达(SAR)是一种主动式的对地观测系统,可安装在飞机、卫星、宇宙飞船等飞行平台上,全天时、全天候对地实施观测、并具有一定的地表穿透能力。SAR的优势是可以在夜间成像,并能够轻易穿透植被、雪和土壤等覆盖物发现目标。

来源:《Operational Feasibility of Adversarial Attacks Against Artificial Intelligence》报告 基于SAR为数据源的人工智能系统可以使用角反射器对其进行数据输入的干扰。角反射器又名雷达反射器,它是由高反射材料制成。当雷达电磁波扫描到角反射后,电磁波会在金属角上产生折射放大,可产生很强的回波信号,足以遮挡附近物体。另外,角反射器成本低、便携性强,在现实场景中部署是可行的。 通过研究,兰德公司发现红方在战场部署角反射器以隐藏其目标是一个不合适的战术选择。角反射器虽然能够降低蓝方AI系统的识别能力,但同时也由于角反射器的存在,让蓝方意图隐藏的区域显得更加与众不同,这种现象可能会引起蓝方AI报警,并启动人工审核。 (三)、基于信号情报数据来源的AI对抗性攻击 该部分主要讨论信号情报数据中的语音情报数据源应用于AI对抗性攻击的防御情况。语音识别是蓝方常用的人工智能系统,它能够识别情报中的关键词或者说话者的身份。而红方在这类对抗中,主要是通过对音频的处理来扰乱红方人工智能系统的输入信号以达到降低其准确度的目的。

来源:《Operational Feasibility of Adversarial Attacks Against Artificial Intelligence》报告 通过研究,兰德公司发现红方可利用目前的信号处理技术对蓝方的AI系统发起有效的攻击,并且具有高成功率。另外,目前正在开发的新式黑盒攻击方法,进一步降低了红方对蓝方模型知识了解的需求,将会产生更大的对抗性攻击风险。

三、 结论与建议

兰德公司评估表明,人工智能对抗性攻击在理论上的可行性不一定证明其在现实场景中也是可行的。对于具体应用场景和任务中的人工智能系统需要全面了解其算法,并进行现实的威胁评估。 兰德公司建议,美国国防部应通过适当的数据预处理和创新的AI模型设计提升对抗性攻击实施的难度,以保障AI系统的安全性。兰德公司还建议,美国国防部应科学评估对手实施AI对抗性攻击的影响程度,并增强对先进技术的态势感知能力,以了解对手可能采取的作战理念。

四、 评述

随着人工智能系统在军事中的部署越来越普及,其可信性和安全性已成为重点关注的领域。近年来,尽管新的对抗攻击和防御方法迅速发展,但终究还是存在科研和实用之间的鸿沟,如何形成一套针对不同现实场景且操作性强的防御AI对抗性攻击的方法具有重要意义。

对于军事用途的人工智能投资确有必要,这有助于保障未来战场中的技术优势地位。鉴于目前人工智能对抗性攻击仍然是相对较新的应用场景,相关研究成果也在不断涌现,同时针对对抗样本的因果关系、一般鲁棒边界的存在等基本问题还需要深入研究。因此,应加深对人工智能安全性的研究,确保相关应用的可信、可靠。

作者简介

刘纪铖 国务院发展研究中心国际技术经济研究所研究二室,助理分析员 研究方向:信息领域战略、技术和产业前沿 联系方式:liujc206@163.com

编辑丨郑实 声明:本文来自全球技术地图,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权