这个项目的目标是通过利用多模态和多语言信息改进矢量空间语言模型来创造更好的词汇表征。我们收集了一个大规模的多语言图像数据集,称为MMID,它将图像与98种不同语言的词联系在一起(每种语言多达10K个词,每个词有100张图像)。这个数据集让我们全面分析了视觉相似性是否可以用来识别翻译,以及这在多大程度上受到语言因素的影响,如语篇和具体性。我们研究了MMID是否可以用来减轻像ImageNet这样的图像分类数据集中的地理偏见(例如婚礼在世界不同地区的视觉上是不同的)。我们研究了地理因素对语言对之间的可译性的影响程度;共同的语系、族群或共同的宗教等因素对视觉相似性的影响比地理因素大,因此通过图像的可译性也大。我们还从维基百科上收集了一个数据集,通过聚合带有多语言标题的共享图像,为我们提供完整的句子,而不是MMID中的单个单词。

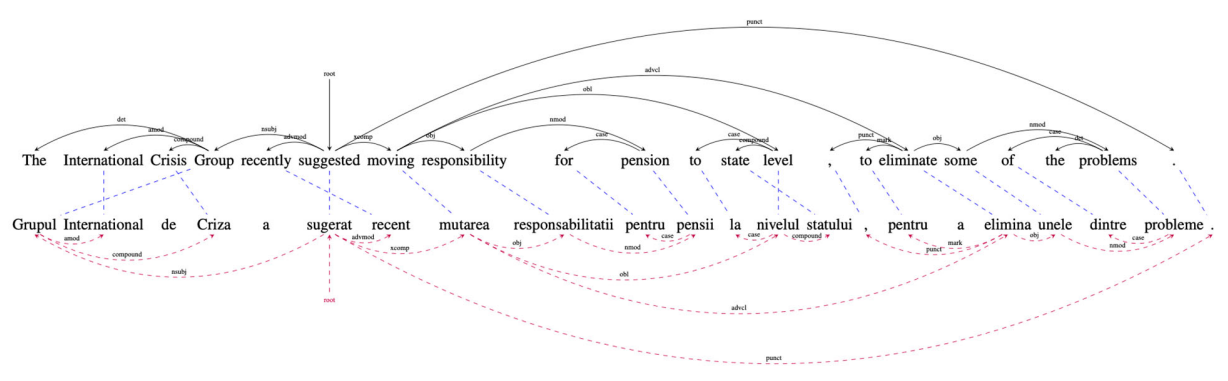

图:一个注释预测示例,上面的源是通过我们的 "wikily"模型翻译的罗马尼亚语目标。受监督的源树是用相交的词对齐来预测的。

本报告总结了题为 "多模态表征的半监督学习 "的项目的主要发现。这个项目的主要研究者是宾夕法尼亚大学的Chris CallisonBurch教授和波士顿大学的Derry Wijaya教授。执行期为19年6月26日至22年6月14日。这个项目与DARPA项目经理Boyan Onyshkevych正在管理的其他项目广泛相关,包括DARPA AIDA项目,但它是一项独立的工作。这个项目是通过DARPA的OpenBAA资助的。这个项目的总预算为428,000美元。

这个项目的目标是通过改进带有多模态和多语言信息的矢量空间语言模型来创造更好的词汇表征。这份最终报告将详细介绍四项研究。

-

- 在准备这个项目时,我们组装了一个大规模的多语言图像数据集,称为MMID,它将图像与98种不同语言的单词联系起来。MMID包含每种语言的多达10,000个词汇,每个词有100张图片。此外,我们还为25万个英语翻译中的每一个提供了100张图片。这个数据集让我们全面分析了视觉相似性是否可以用来识别翻译,以及这在多大程度上受到语言因素的影响,如语篇和具体性。

-

- 我们进行了一项研究,看看MMID是否可以用来减轻像ImageNet这样的图像分类数据集中的地理偏见。由于ImageNet中的西方偏见,使用它训练的分类器往往不能识别世界其他地区视觉上与众不同的物体和事件(例如,印度婚礼)。

-

- 我们调查了地理因素对跨语言对的可译性的影响程度,并将其与文化因素的影响进行了比较。我们发现,共同的语系、种族群体或共同的宗教等因素对视觉相似性的影响比地理因素更大,因此通过图像的可译性也更大。

-

- 我们从维基百科上收集了第二个数据集,通过聚合带有多语言说明的共享图像。这个数据集为我们提供了完整的句子,而不是MMID中的单个单词。我们进行了一组实验,表明我们的维基百科数据如何能够被用作弱监督数据的来源,以执行一些传统上需要双语句子对齐的平行语料库的多语言任务。

图:草莓是心理语言学研究中具有高具体性的一个词的例子。这反映在一致的视觉表示上。