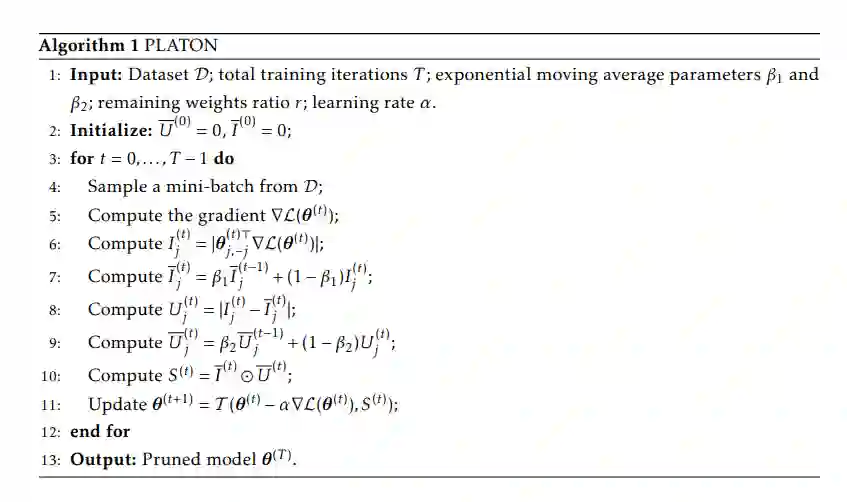

大型基于Transformer的模型在各种自然语言处理和计算机视觉任务中表现出优越的性能。然而,这些模型包含大量的参数,这限制了它们在真实应用中的部署。为了减少模型的大小,研究人员根据权重的重要性评分对这些模型进行修剪。然而,这些分数通常是在训练过程中的小批量估计,由于小批量抽样和复杂的训练动态,这带来了很大的可变性/不确定性。由于这种不确定性,常用的修剪方法会对一些关键权重进行修剪,使得训练不稳定,不利于泛化。为了解决这一问题,我们提出了PLATON算法,该算法通过重要性估计的置信上限(upper confidence bound, UCB)来捕捉重要性得分的不确定性。特别是对于重要性得分低但不确定性高的权重,PLATON倾向于保留它们并探索它们的容量。我们在自然语言理解、问题回答和图像分类等多个基于transformer的模型上进行了大量实验,以验证PLATON的有效性。结果表明,在不同的稀疏度水平下,PLATON算法均有显著的改进。 https://arxiv.org/abs/2206.12562

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年8月17日

Arxiv

15+阅读 · 2021年2月9日