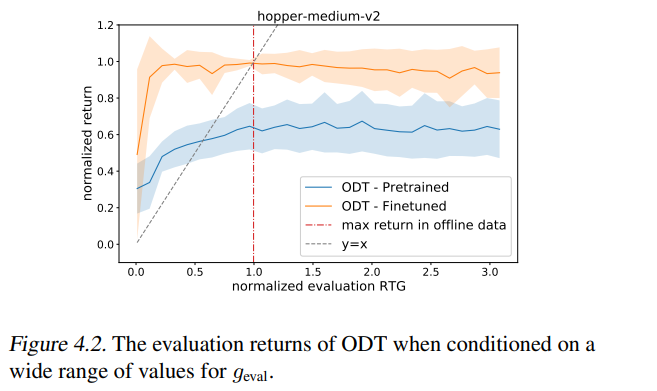

最近的工作表明,离线强化学习(RL)可以被表述为一个序列建模问题(Chen et al., 2021; Janner et al., 2021),并通过类似于大规模语言建模的方法解决。然而,RL的任何实际实例还涉及到一个在线组件,其中在被动离线数据集上预训练的策略通过与环境的特定任务交互进行微调。我们提出了在线决策Transformers (ODT),这是一种基于序列建模的RL算法,在一个统一的框架中融合了离线预训练和在线微调。我们的框架使用序列级熵正则化器与自回归建模目标相结合,用于样本高效的探索和微调。根据经验,我们表明,ODT在D4RL基准测试的绝对性能方面可以与最先进的技术相媲美,但在微调过程中获得的收益要显著得多。 https://www.zhuanzhi.ai/paper/0463e71720c9b14b6391b5c6bbecd1c1

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年9月18日

Arxiv

0+阅读 · 2022年9月16日

Arxiv

21+阅读 · 2020年12月17日