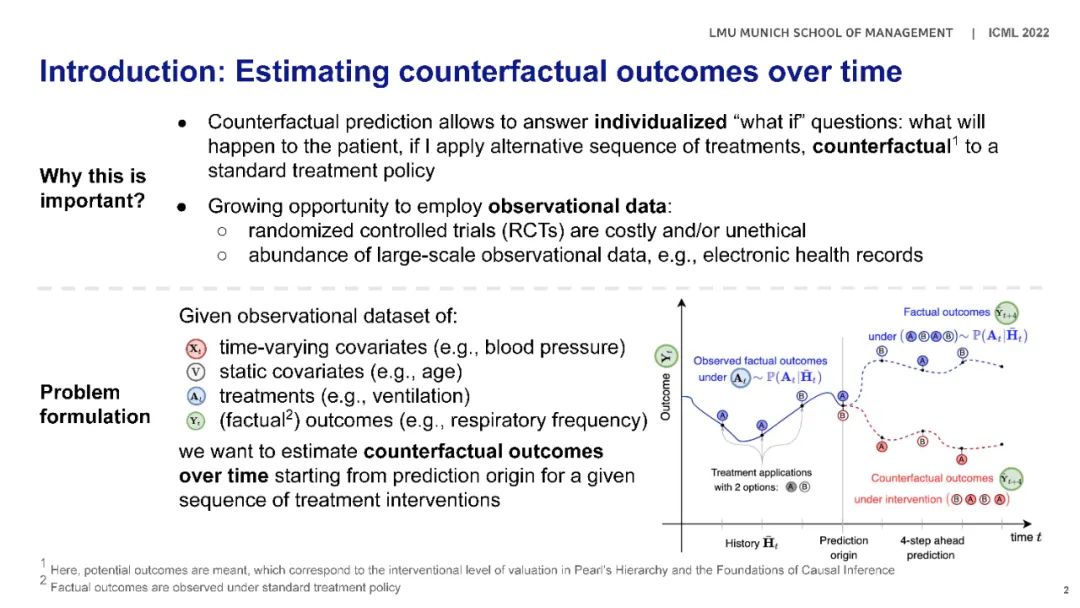

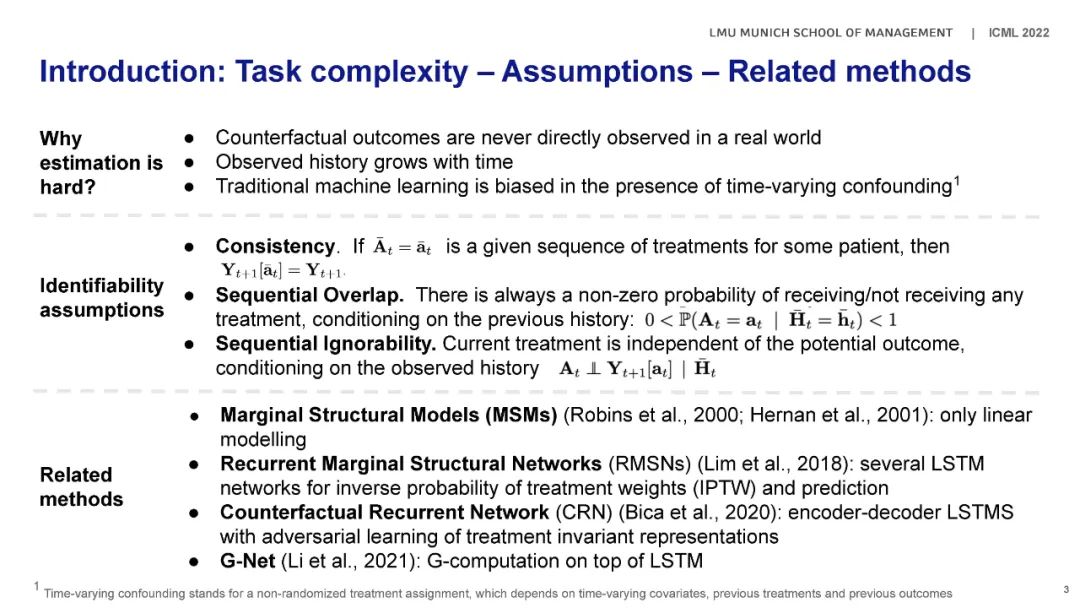

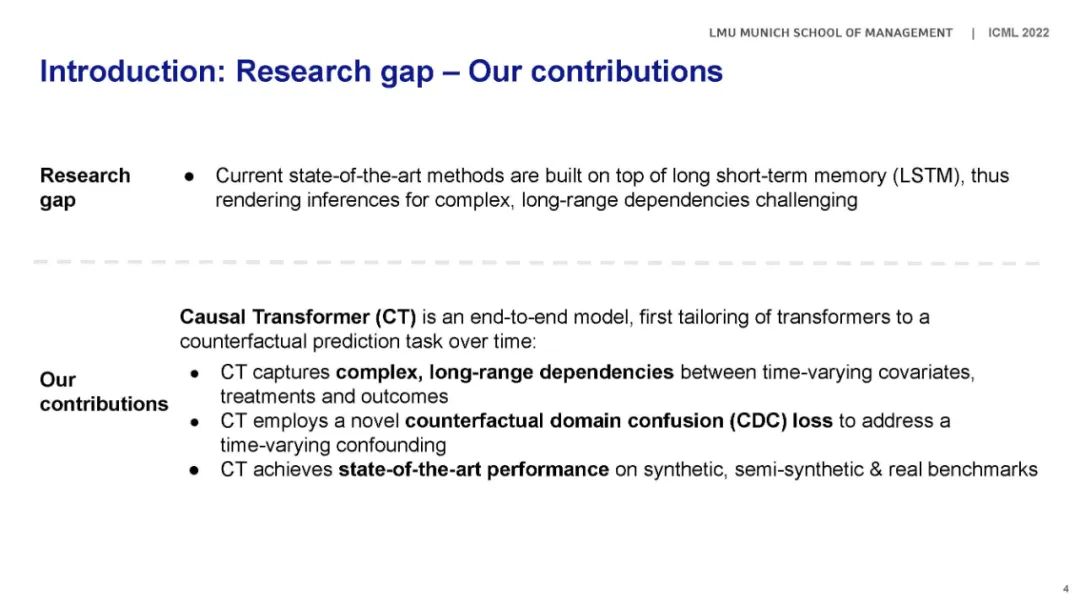

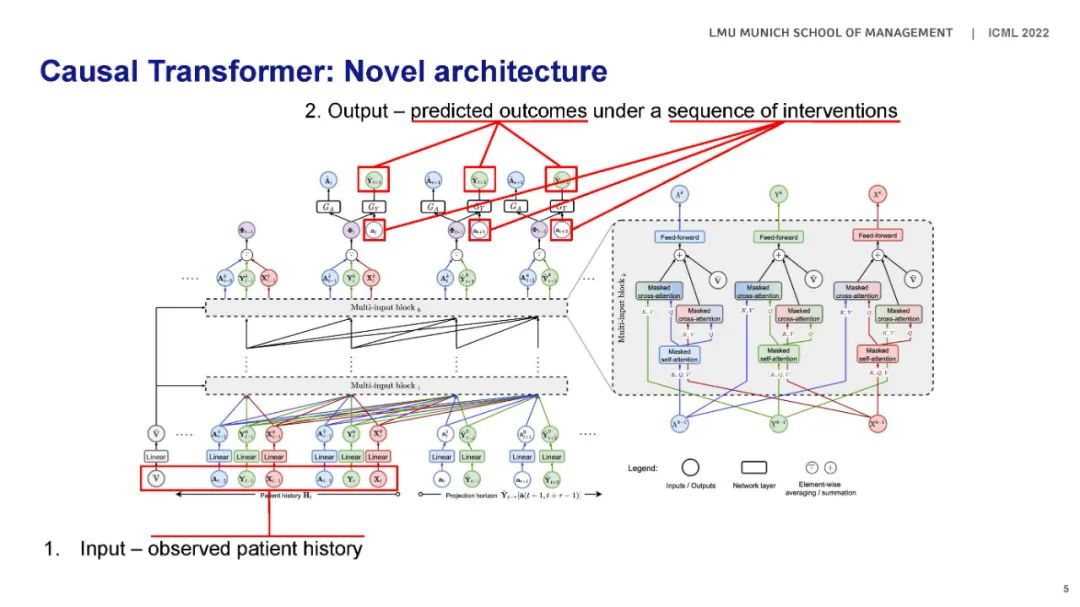

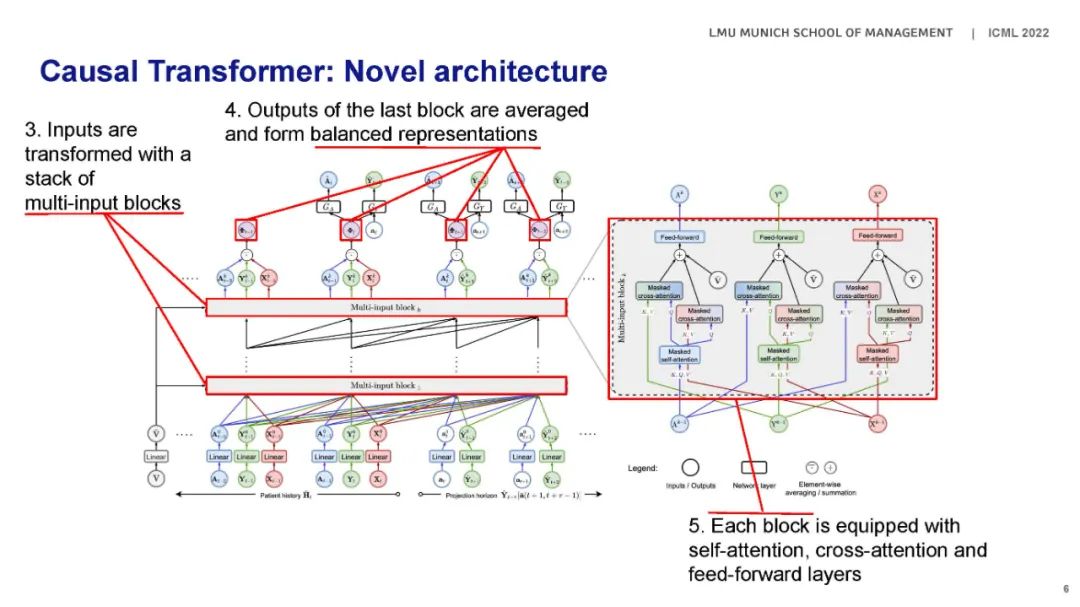

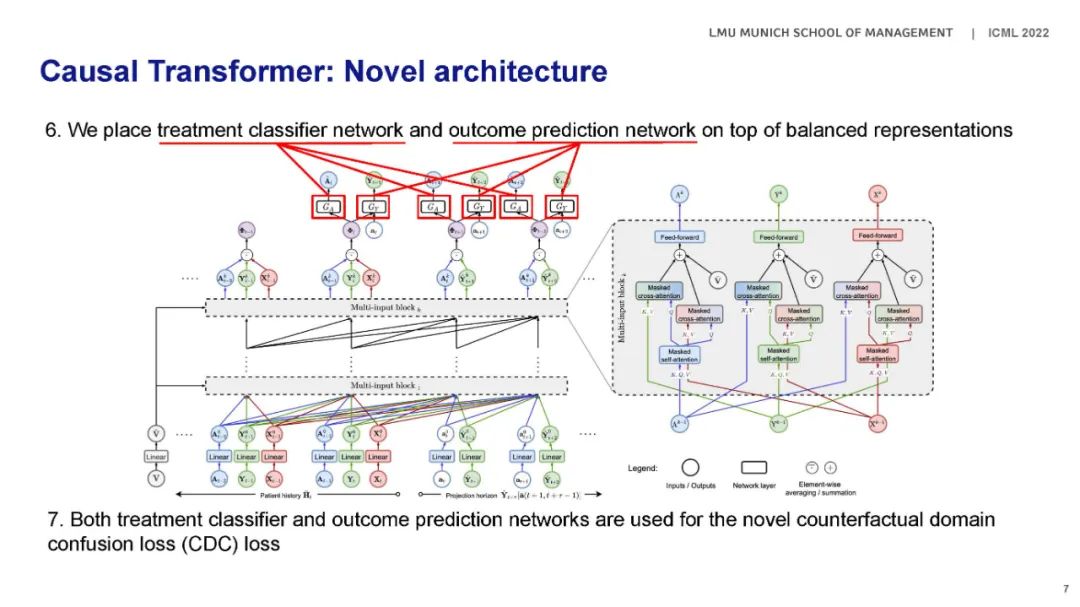

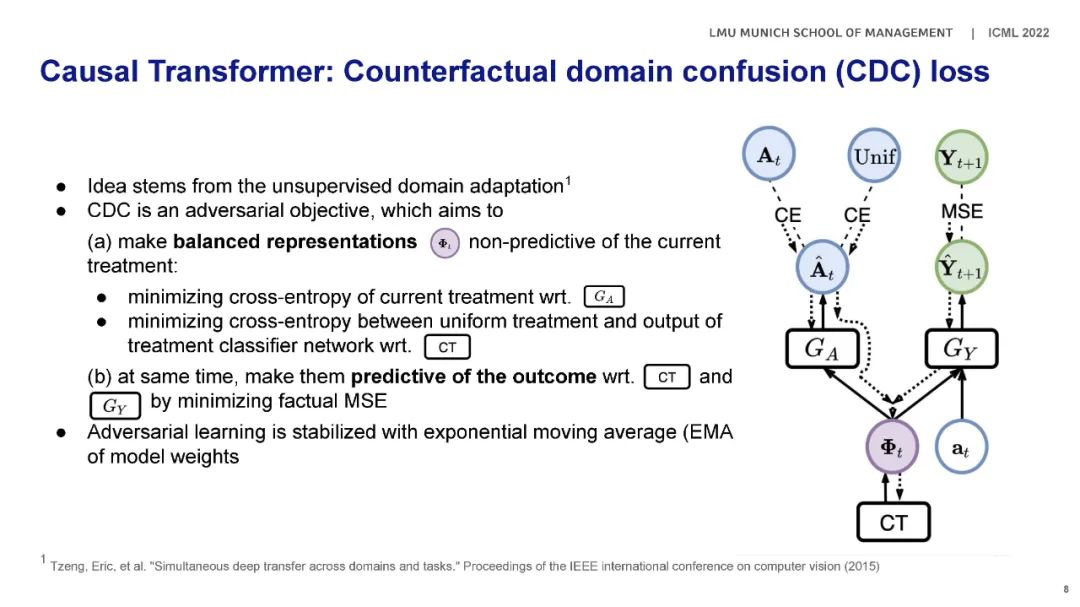

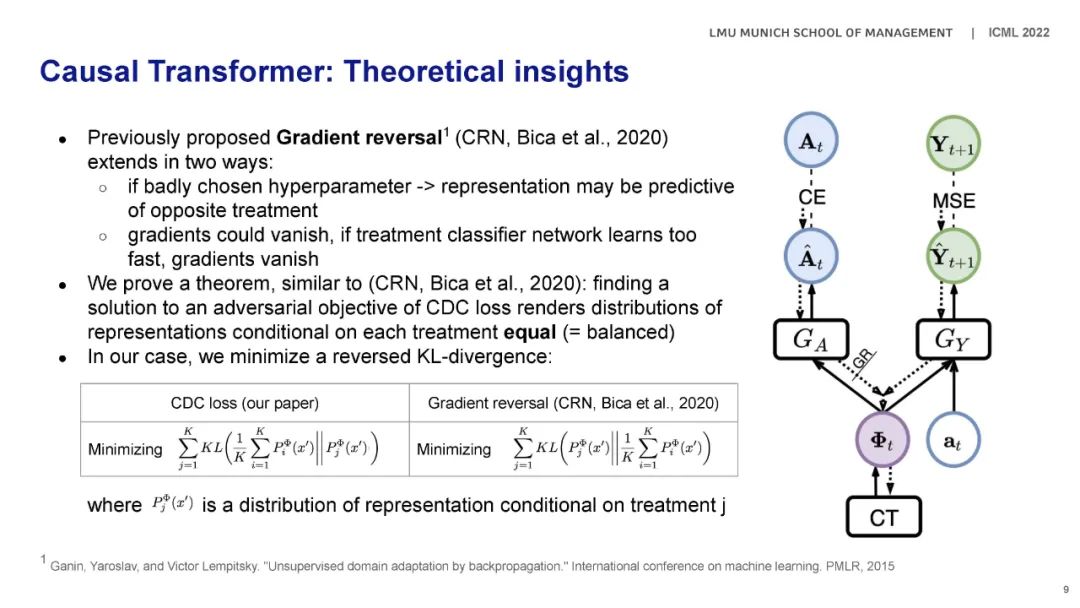

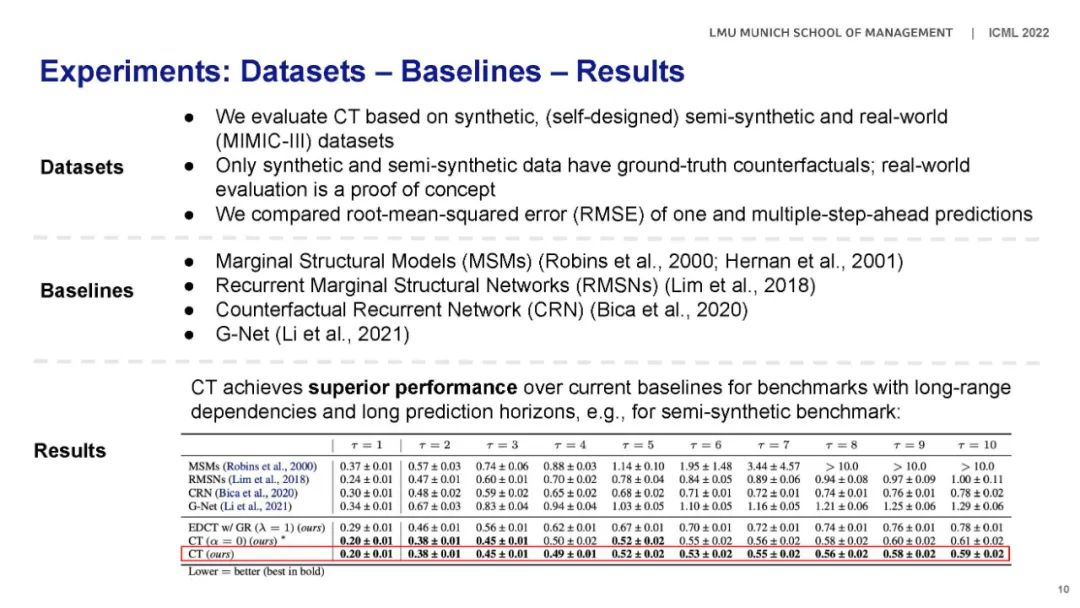

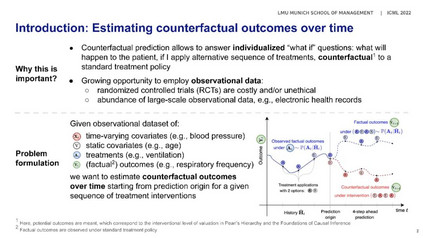

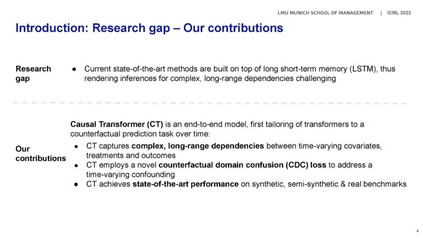

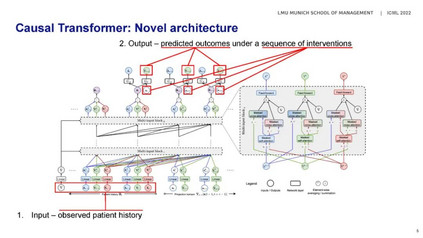

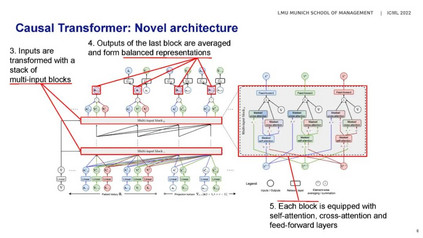

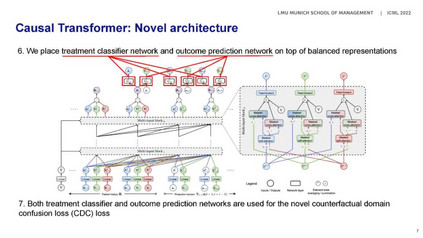

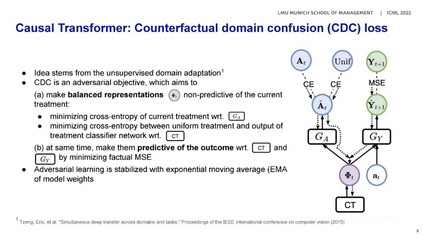

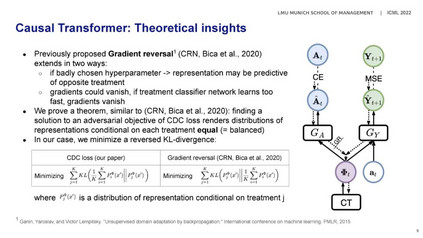

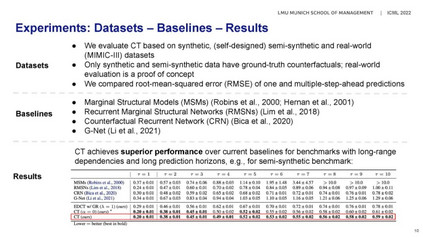

根据观察数据估算反事实结果与许多应用(例如,个性化医疗)相关。然而,最先进的方法建立在简单的长短期记忆(LSTM)网络上,因此对复杂的、长期依赖关系的推断产生了挑战。在本文中,我们开发了一种新的因果Transformer ,用于随着时间的推移估计反事实结果。我们的模型是专门设计的,以捕获复杂的,长期的依赖性,时变混杂。为此,我们将三个Transformer子网络与时变协变量、以前的处理和以前的结果的单独输入组合成一个中间交叉关注的联合网络。我们进一步为因果Transformer 开发了一个定制的端到端培训程序。具体来说,我们提出了一种新的反事实领域混淆损失来解决混淆偏差:其目的是学习对抗性平衡表示,以便它们可以预测下一个结果,但不能预测当前的治疗分配。我们基于合成的和真实的数据集评估我们的因果Transformer,在这些数据集中,它实现了优于当前基线的性能。据我们所知,这是第一个提出基于transformer的架构来从纵向数据估计反事实结果的工作。

成为VIP会员查看完整内容

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构