导读

自然语言处理领域顶级会议EMNLP2019近日公布会议接收论文列表,会议将于十一月在中国香港召开。本文简要介绍5篇EMNLP2019接收论文,各位读者先睹为快。

编译 | Xiaowen

Visualizing and Understanding the Effectiveness of BERT

![]()

摘要

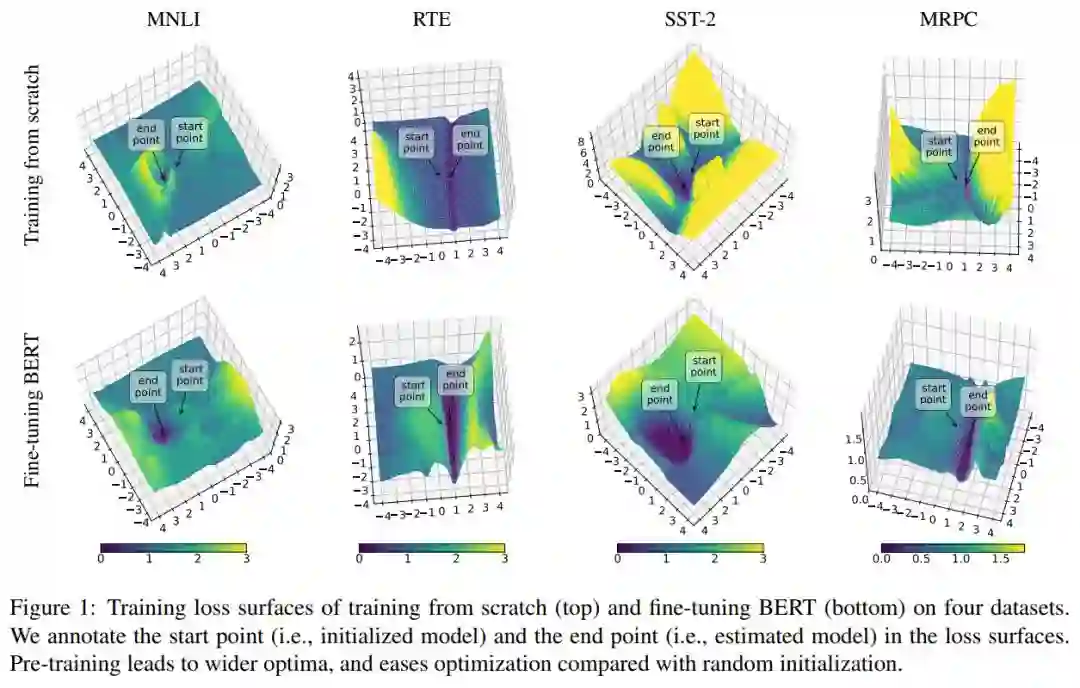

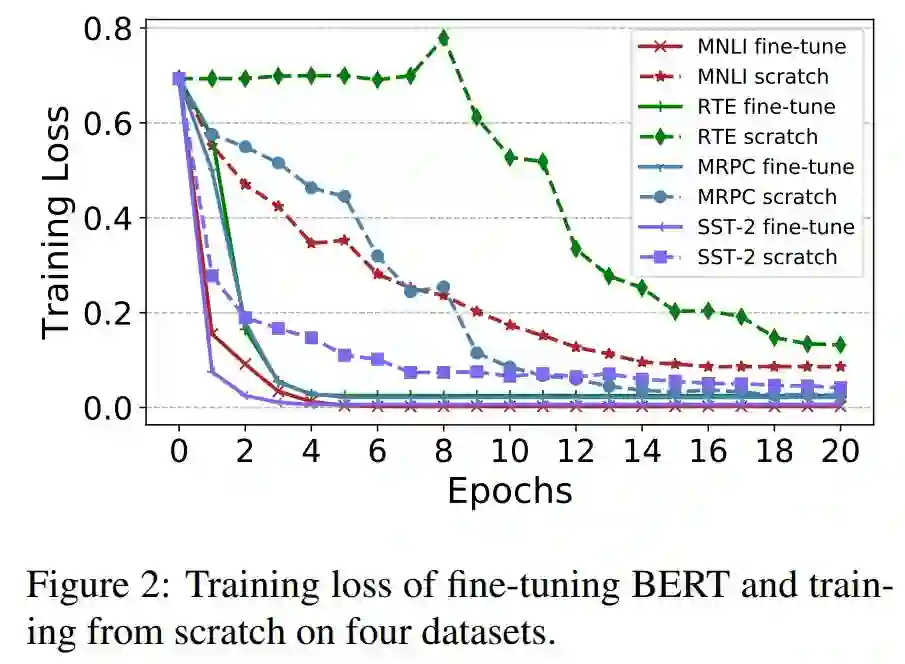

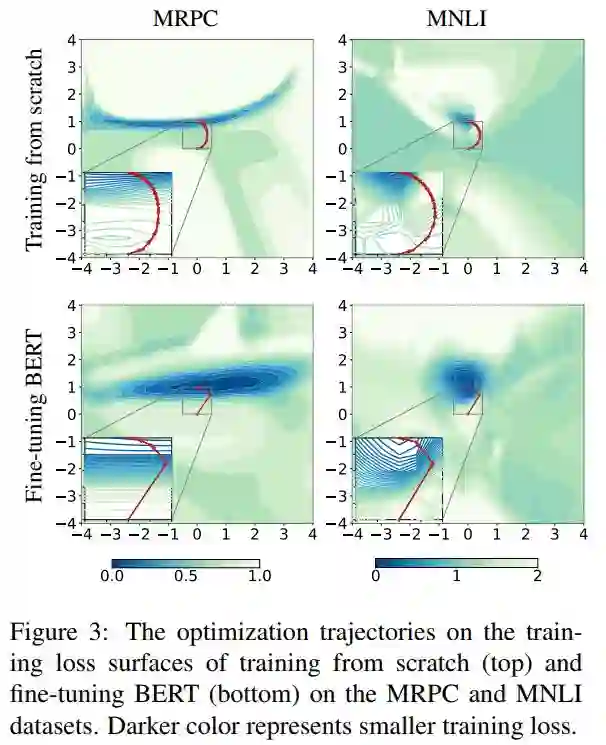

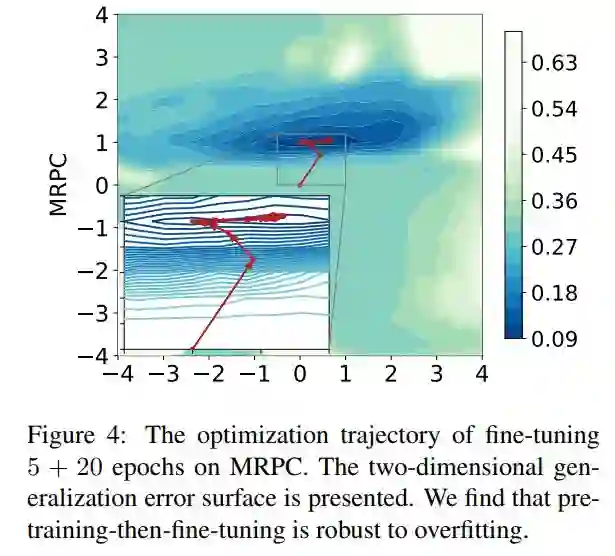

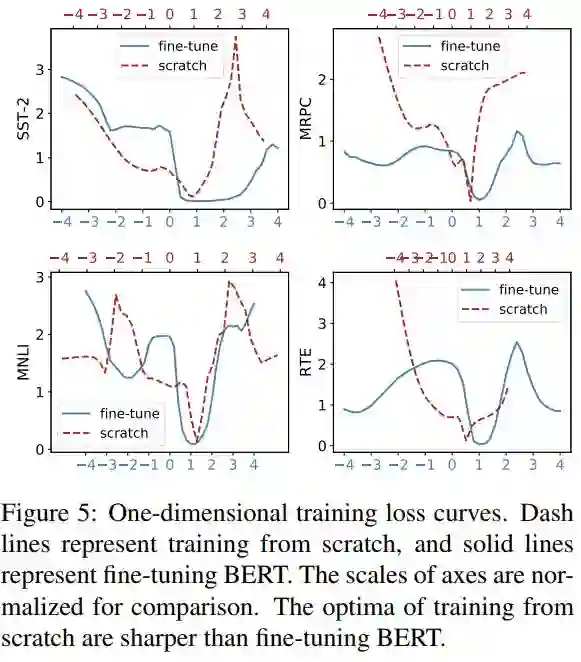

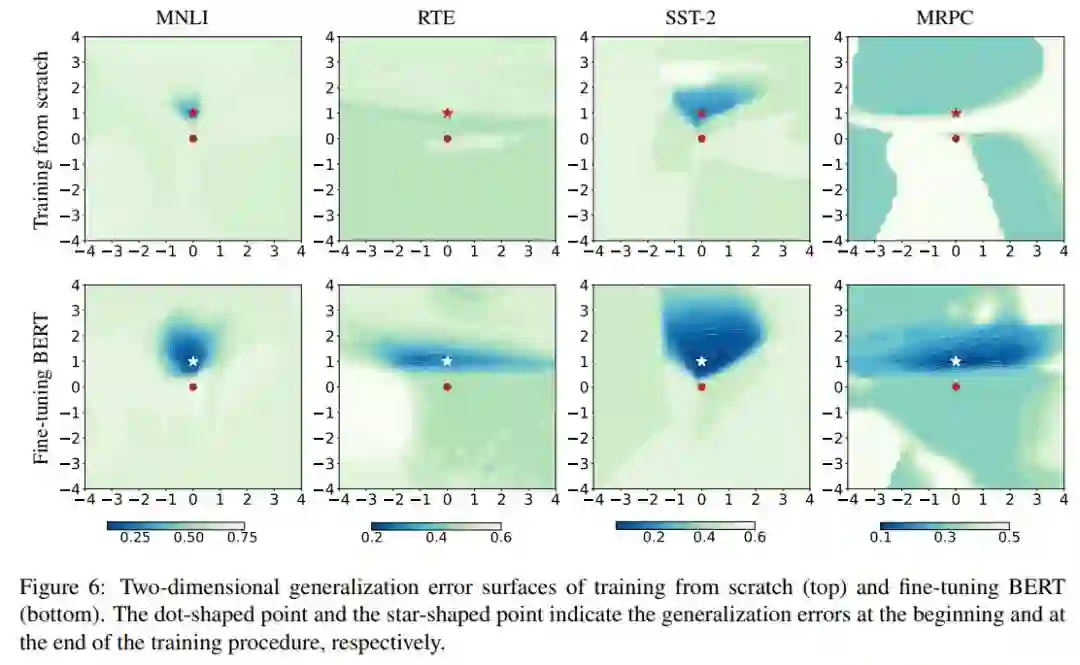

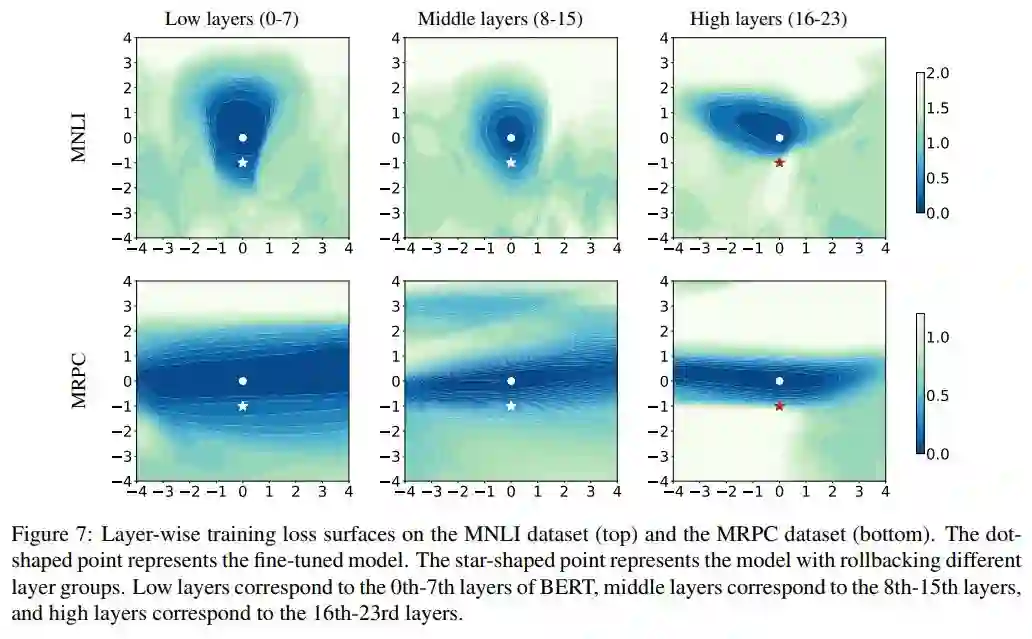

:语言模型预训练(如BERT)在许多NLP任务中取得了显著的结果。然而,还不清楚为什么预训练-然后微调的模式可以改善不同任务的性能和泛化能力。本文提出了对特定数据集微调的损失显示和优化轨迹进行可视化的方法。首先,我们发现,预训练在下游任务中到了一个不错的初始点,这与从头开始的训练相比有了更好的优化。我们还证明了微调的过程对过拟合是鲁棒的,即使BERT对于下游任务是高度超参数化的。第二,可视化结果表明,由于训练损失面与泛化误差面的一致性和平坦、宽的最优性,使得微调BERT具有较好的泛化效果。第三,在微调过程中,BERT的较低层更不稳定,这意味着接近输入的层能够更好地学习语言的可转移表示。

论文地址

:https://arxiv.org/pdf/1908.05620.pdf

![]()

![]()

![]()

![]()

![]()

![]()

![]()

Towards Knowledge-Based Recommender Dialog System

![]()

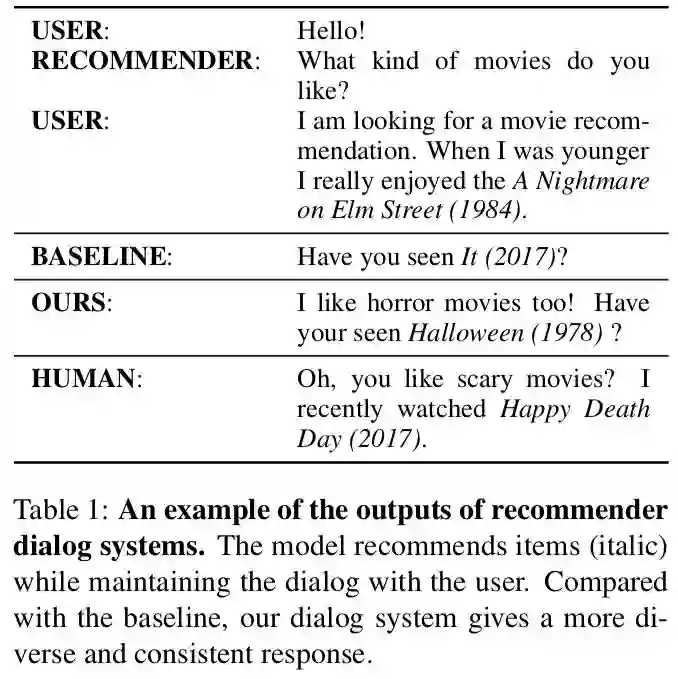

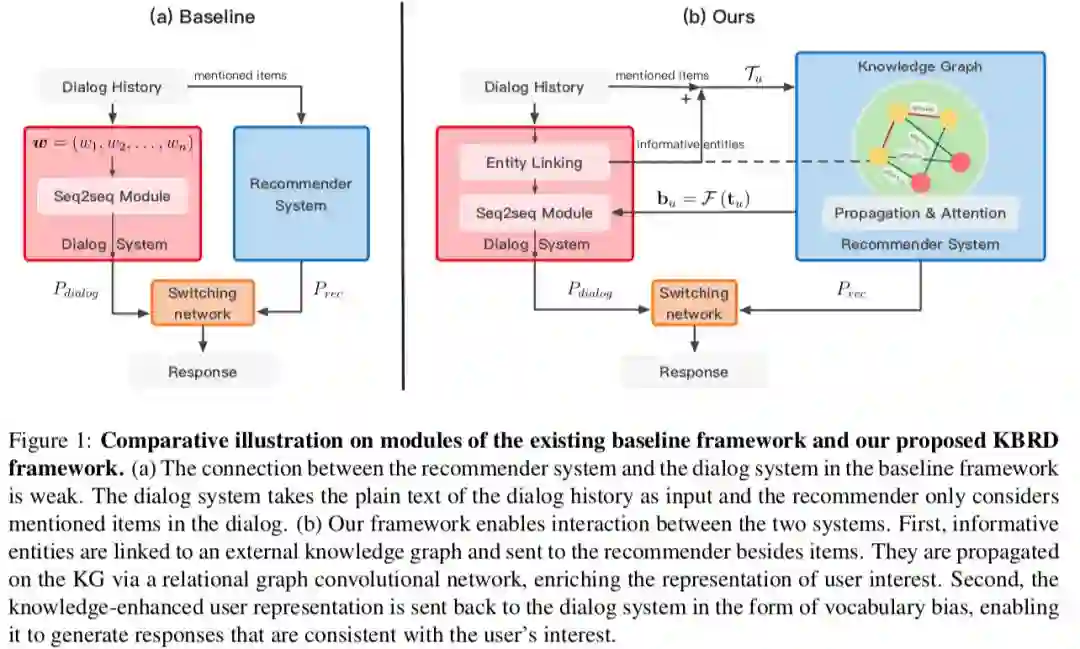

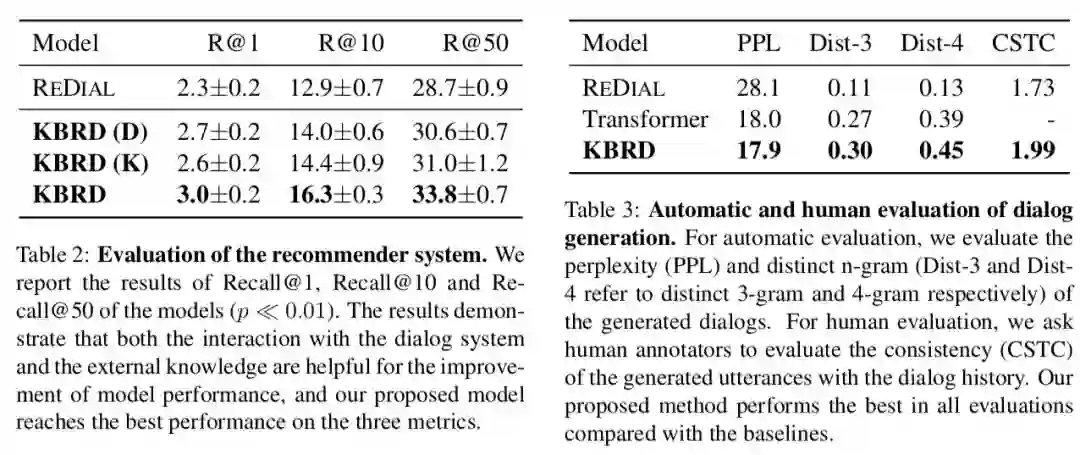

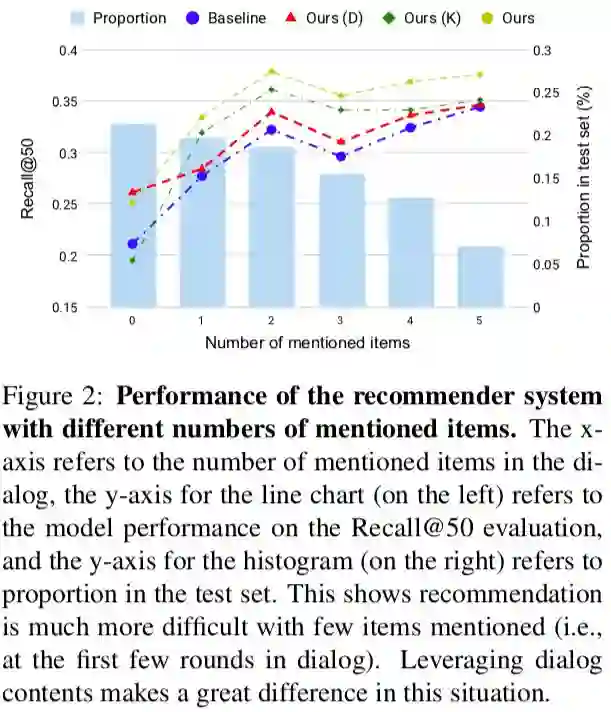

摘要:

在本文中,我们提出了一种新的端到端框架KBRD,一种基于知识的推荐对话系统。它集成了推荐系统和对话生成系统。对话系统通过引入基于知识的用户偏好信息来提高推荐系统的性能,推荐系统通过提供推荐感知的词汇偏误来提高对话生成系统的性能。实验结果表明,该模型在评价对话生成和推荐方面均优于Baseline方法。一系列的分析表明,这两种任务可以相互促进,引入的知识弥补了两种任务之间的差距。

论文地址

:https://arxiv.org/pdf/1908.05391.pdf

![]()

![]()

![]()

![]()

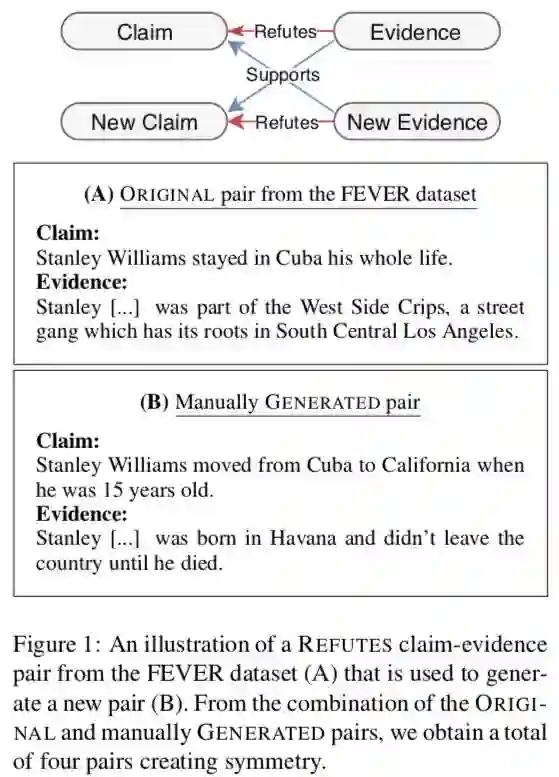

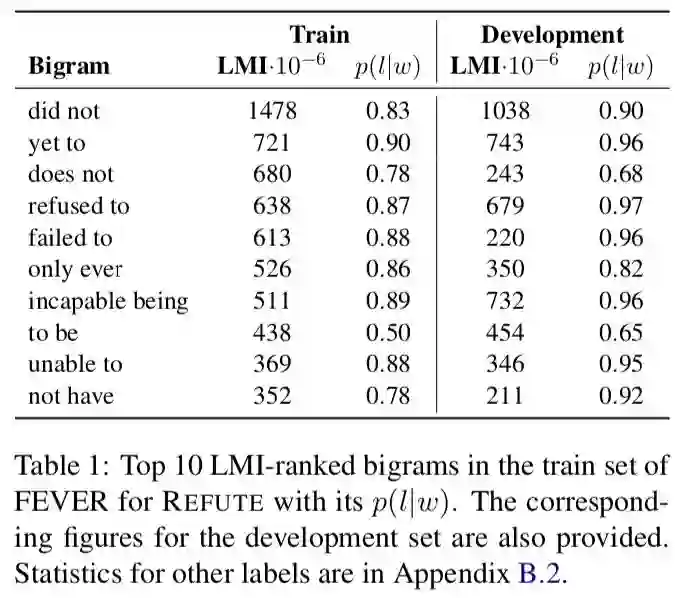

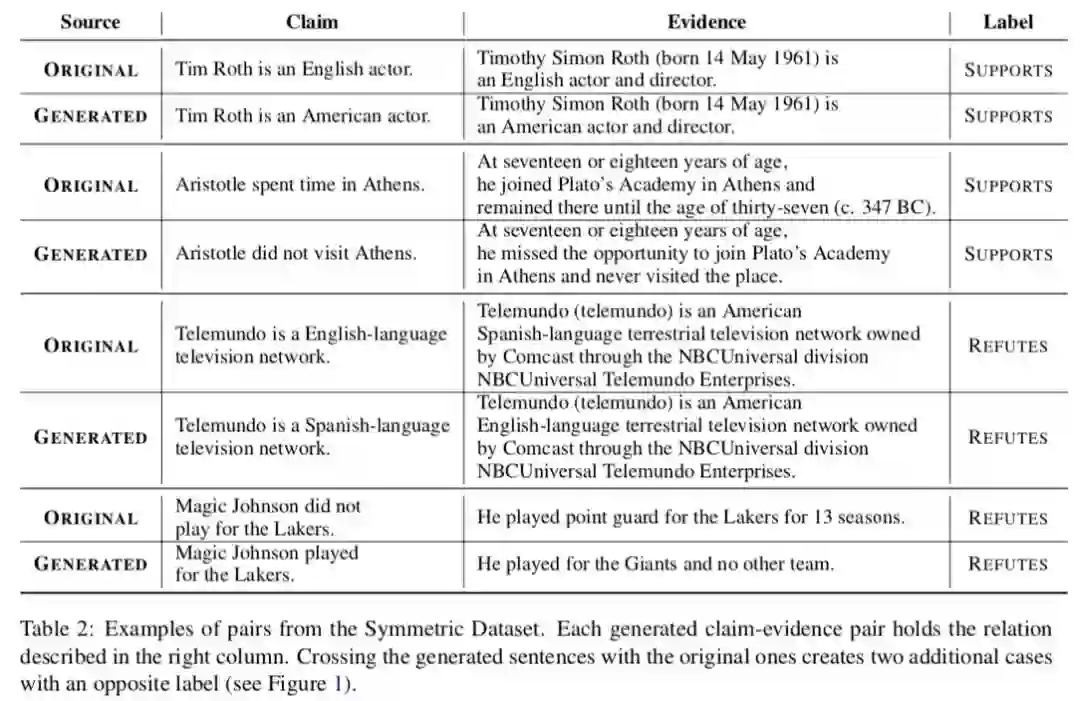

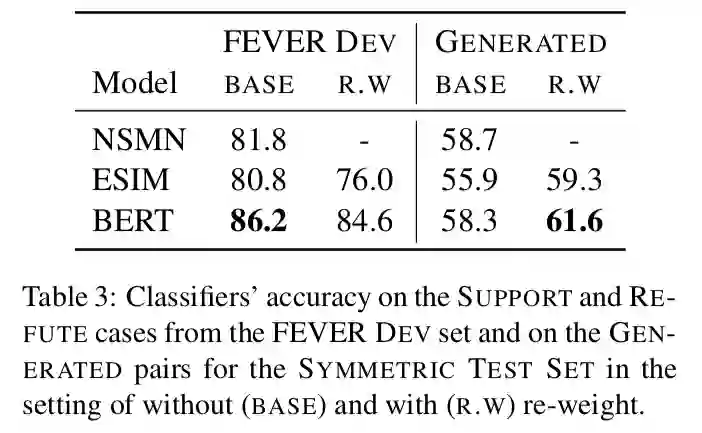

Towards Debiasing Fact Verification Models

![]()

摘要:事实验证需要在证据的上下文中进行验证。然而,本文显示,在流行的FEVER数据集中,不一定是这种情况。只有claim分类器与顶部证据evidence感知模型进行竞争。本文对这一现象的成因进行了调查,提出了仅基于claim来预测标签的强提示,而不考虑任何evidence。我们创建了一个避免这些特质的验证集。在对该测试集进行评估时,已训练模型的性能显著下降。因此,我们引入了一种正则化方法,减轻了对训练数据中的偏差的影响,得到了新创建的测试集的改进。这一工作是对事实验证模式中的推理能力进行更合理的评估的一个步骤。

论文地址:https://arxiv.org/pdf/1908.05267.pdf

![]()

![]()

![]()

![]()

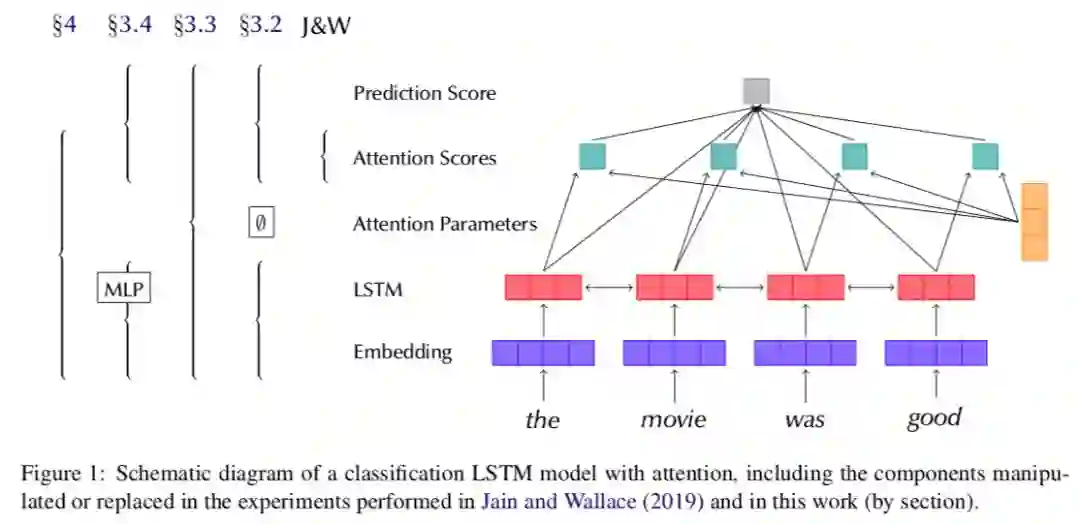

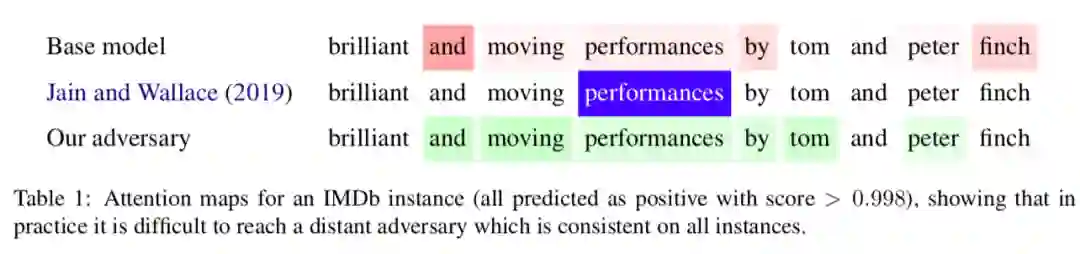

Attention is not not Explanation

![]()

摘要:

注意力机制在NLP系统中起着核心作用,特别是在递归神经网络(RNN)模型中。最近,人们越来越关注这些模块提供的中间表示是否可以用来解释模型预测的推理,从而对模型的决策过程有深入的了解。最近的一篇论文声称“注意力不是解释”

Attention is not not Explanation (

Jain和Wallace,2019年)。

我们对这项工作的许多假设提出了质疑,认为这种说法取决于一个人对解释的定义,而且测试需要考虑到模型的所有要素,使用严格的实验设计。

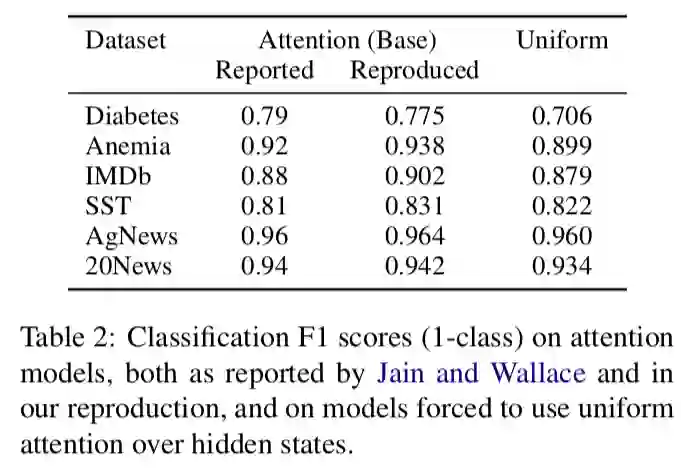

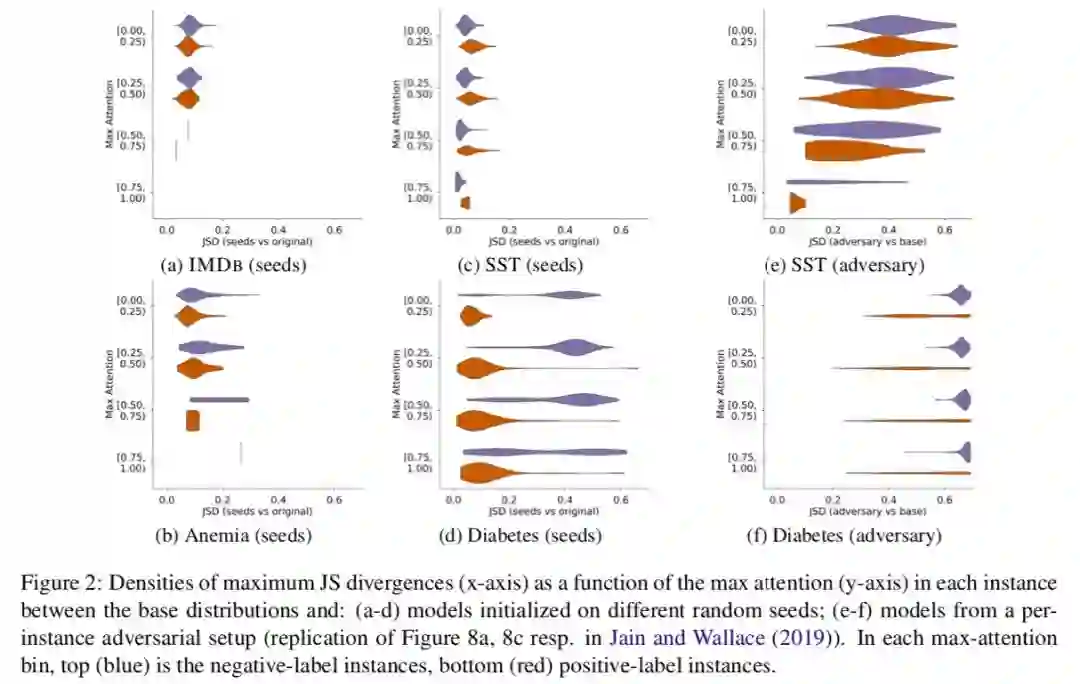

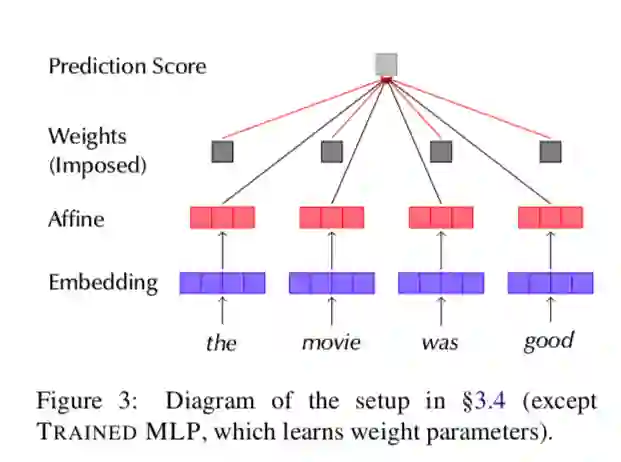

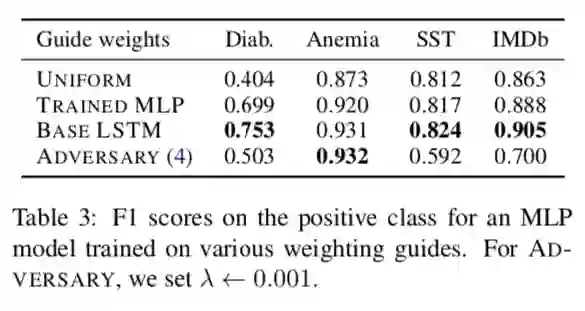

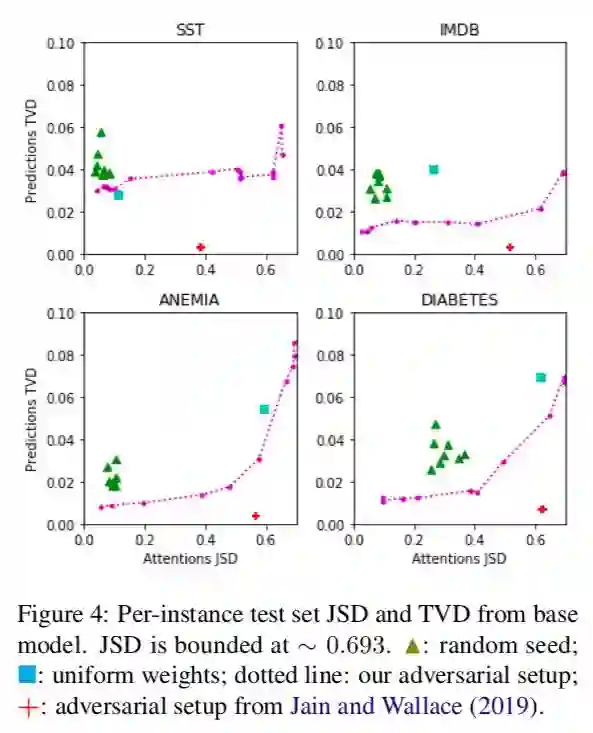

我们提出了四个替代测试,以确定何时/是否可以将注意力作为解释:

一个简单的统一权重Baseline;

一个基于多个随机种子运行的方差校准;

一个使用预训练模型的冻结权重的诊断框架;

以及一个端到端对抗性注意训练协议。

每个模型都允许对RNN模型中的注意力机制进行有意义的解释。

我们发现,即使可以找到可靠的对抗性分布,它们也不能很好地进行简单的诊断,这表明先前的工作并不能证明注意机制对可解释性的有用性。

论文地址:https://arxiv.org/pdf/1908.04626.pdf

![]()

![]()

![]()

![]()

![]()

![]()

![]()

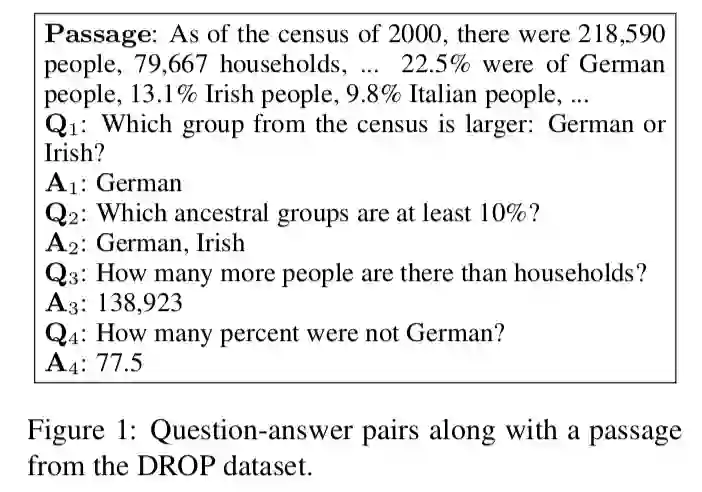

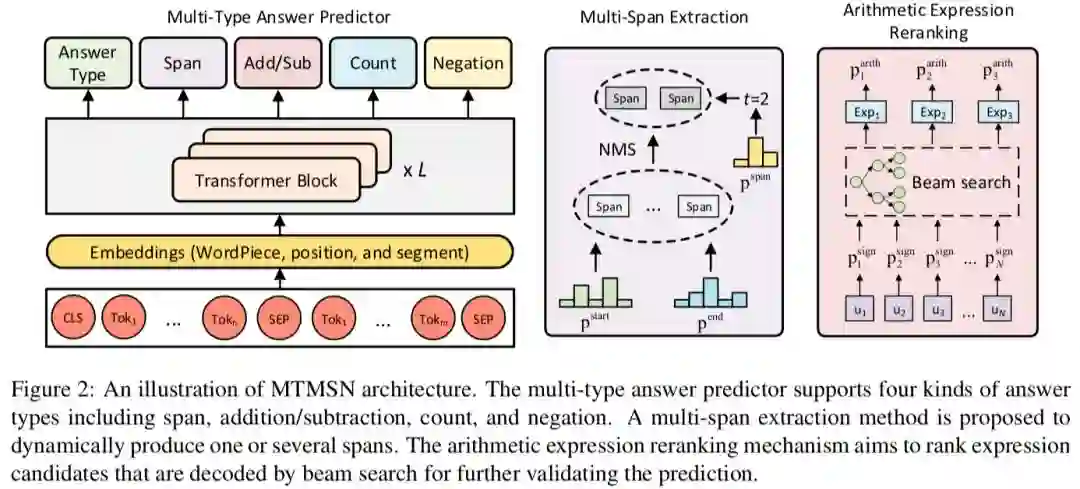

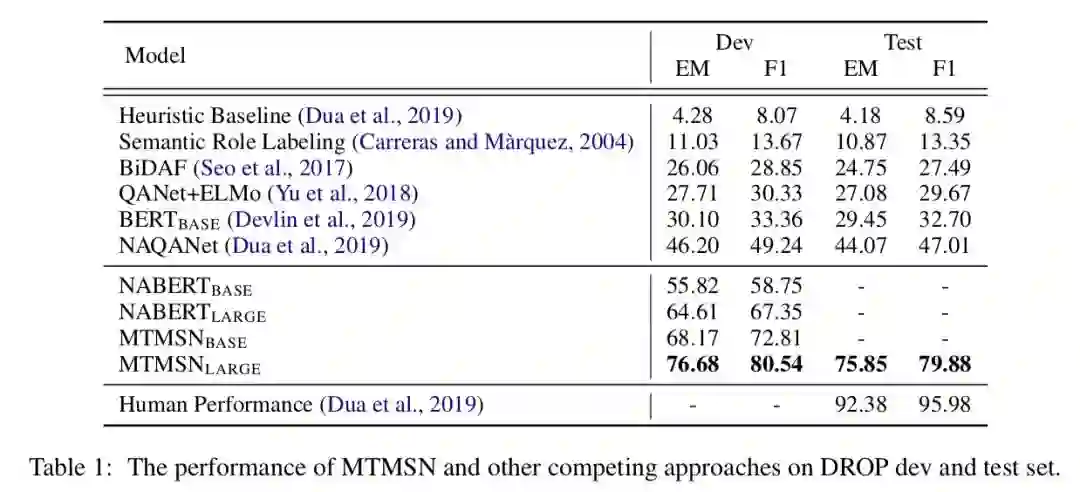

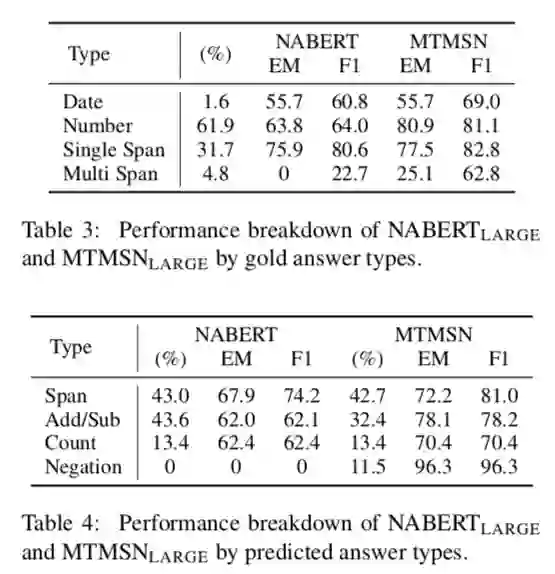

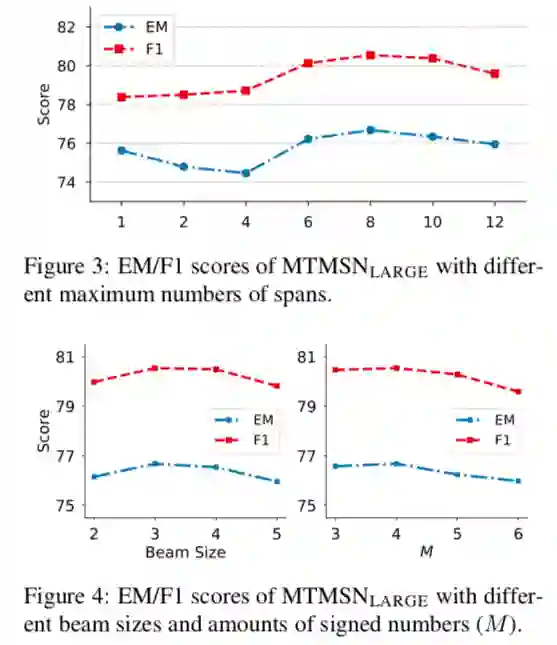

A Multi-Type Multi-Span Network for Reading Comprehension that Requires Discrete Reasoning

![]()

摘要:

目前阅

读理解和问答领域取得了迅速进展,在一些简化的场景中,有几个系统实现了与人相近的水平。然而,当这些模型被应用到更现实的场景中时,这些模型的性能会显著下降,比如答案涉及各种类型,多个文本字符串是正确的答案,或者需要离散推理能力时。本文介绍了一种多类型的多跨度网络(MTMSN),这是一种神经阅读理解模型,它结合了一个多类型的答案预测器,旨在支持各种类型的答案(如广度、计数、否定和算术表达式),并采用多跨度提取方法动态地产生一个或多个文本跨度。此外,还提出了一种算法表达式重路由机制来对候选表达式进行排序,以进一步确定预测结果。实验表明,我们的模型在DROP隐藏测试集上达到了79.9F1,创造了新的最先进的结果。源代码将发布在https://github.com/huminghao16/MTMSN。

论文地址

:https://arxiv.org/pdf/1908.05514.pdf

![]()

![]()

![]()

![]()

![]()

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

![]()

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

![]()

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~