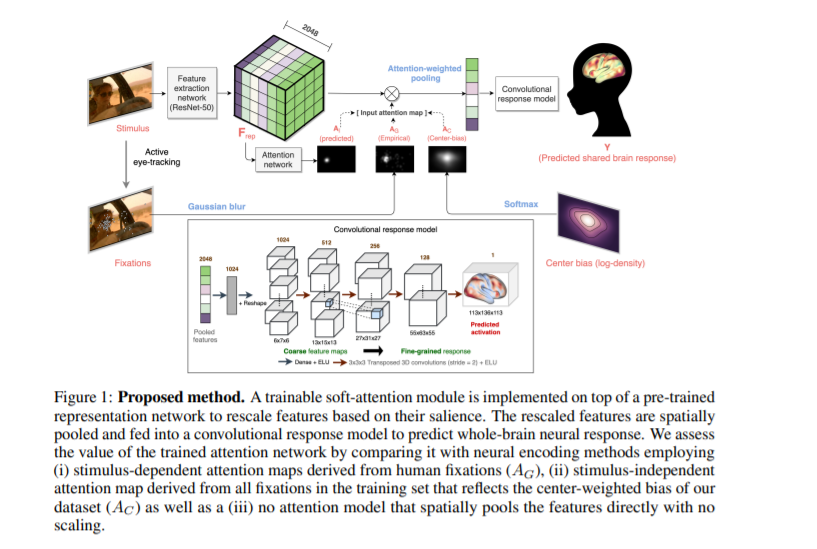

视觉感知受到注意力集中的严重影响。由于有限的资源,众所周知,神经表征偏向于出席地点。利用同时进行的眼球追踪和功能性磁共振成像(fMRI)记录了大量人类观看电影的对象,我们首次证明了利用注视信息,以注意掩蔽的形式,可以显著提高神经编码模型中大脑反应预测的准确性。接下来,我们提出了一种新的神经编码方法,包括一个可训练的软注意模块。利用我们的新方法,我们证明了仅仅依靠fMRI反应数据,而不依赖任何眼球追踪,通过端到端学习来学习视觉注意力策略是可能的。有趣的是,我们发现该模型在独立数据上估计的注意力位置与相应的注视模式非常一致,尽管没有明确的监督。总之,这些发现表明,注意力模块可以在视觉刺激的神经编码模型中发挥作用。

成为VIP会员查看完整内容

相关内容

Arxiv

15+阅读 · 2020年3月31日

Arxiv

3+阅读 · 2020年3月12日