Transformer一直被认为是NLP和CV中的主要神经架构,主要是在有监督的环境下。最近,在强化学习(RL)领域也出现了类似的使用transformer的热潮,但它面临着RL性质带来的独特设计选择和挑战。然而,transformer在强化学习中的发展还没有被很好地解开。本文试图系统地回顾在强化学习中使用transformer的动机和进展,对现有工作进行分类,讨论每个子领域,并总结未来前景。

https://www.zhuanzhi.ai/paper/a72d26ab035255b1bfc3973fc6150e38

1. 概述

强化学习(RL)为序列决策提供了一种数学形式。利用强化学习,我们可以自动获取智能行为。虽然强化学习为基于学习的控制提供了一个通用框架,但深度神经网络的引入,作为一种高容量的函数逼近方式,正在推动在广泛的领域取得重大进展[Silver et al., 2016; Vinyals et al., 2019; Ye et al., 2020a,b]。近年来,深度强化学习(deep reinforcement learning, DRL)在通用性方面取得了巨大的发展,但样本效率问题阻碍了其在现实世界应用中的广泛应用。为了解决这个问题,一种有效的机制是在DRL框架中引入归纳偏差。深度强化学习中一个重要的归纳偏差是函数逼近器架构的选择,例如深度强化学习智能体的神经网络参数化。然而,与监督学习(SL)中架构设计的努力相比,在深度强化学习中选择架构设计的问题仍然较少被探索。大多数现有的强化学习架构工作是由(半)监督学习社区的成功所驱动的。例如,在深度强化学习中处理基于图像的高维输入的常见做法是引入卷积神经网络(CNN) [LeCun et al., 1998; Mnih et al., 2015];处理部分可观察性的另一种常见做法是引入递归神经网络(RNN) [Hochreiter and Schmidhuber, 1997;Hausknecht和Stone, 2015]。

近年来,Transformer架构[Vaswani等人,2017]彻底改变了广泛的SL任务的学习范式[Devlin等人,2018;Dosovitskiy等人,2020;Dong等人,2018],并展示了比CNN和RNN的优越性能。Transformer架构的显著优点之一是能够对长依赖关系进行建模,并具有出色的可扩展性[Khan et al., 2022]。受SL成功的启发,人们对将transformer应用于强化学习的兴趣激增,希望将transformer的好处带到RL领域。在强化学习中使用transformer可以追溯到Zambaldi等人[2018b],其中自注意力机制用于结构化状态表示的关系推理。之后,许多研究人员试图将自注意力应用于表示学习,以提取实体之间的关系,以更好地进行策略学习[Vinyals et al., 2019; Baker et al., 2019]。除了利用transformer进行状态表示学习外,之前的工作还使用transformer来捕获多步时间依赖关系,以处理部分可观测性问题[Parisotto et al., 2020; Parisotto and Salakhutdinov, 2021]。最近,离线强化学习[Levine等人,2020]因其能够利用离线大规模数据集而受到关注。在离线强化学习的激励下,最近的努力表明,Transformer架构可以直接作为序列决策的模型[Chen等人,2021;Janner等人,2021]并将其推广到多个任务和领域[Lee等人,2022;Carroll等人,2022]。

本综述的目的是介绍强化学习中的transformer领域,称为TransformRL。尽管Transformer目前在大多数SL研究中被认为是基础模型[Devlin et al., 2018; Dosovitskiy et al., 2020],它在RL社区中仍然很少被探索。事实上,与SL域相比,在RL中使用transformer作为函数逼近器面临着独特的挑战。首先,强化学习智能体的训练数据通常是当前策略的函数,这在学习Transformer时引入了非平稳性。其次,现有的强化学习算法通常对训练过程中的设计选择高度敏感,包括网络架构和容量[Henderson等人,2018]。第三,基于transformer的架构往往存在高计算和内存成本,使其在强化学习学习过程中的训练和推理都很昂贵。例如,在视频游戏人工智能的情况下,样本生成的效率在很大程度上影响训练性能,取决于强化学习策略网络和价值网络的计算成本[Ye et al., 2020a;Berner等人,2019]。本文试图对TransformRL进行全面的概述,包括当前方法和挑战的分类。我们还讨论了未来的前景,相信TransformRL领域将在释放强化学习的潜在影响方面发挥重要作用,本综述可以为那些希望利用其潜力的人提供一个起点。

我们的论文结构如下。第2节介绍了RL和transformer的背景,然后简要介绍了这两者是如何结合在一起的。在第3节中,我们描述了强化学习中网络架构的演变,以及阻止Transformer架构在强化学习中长期被广泛探索的挑战。在第4节中,提供了强化学习中transformer的分类,并讨论了现有的代表性方法。最后,在第5节中总结并指出了未来的研究方向。 2. Transformers in RL

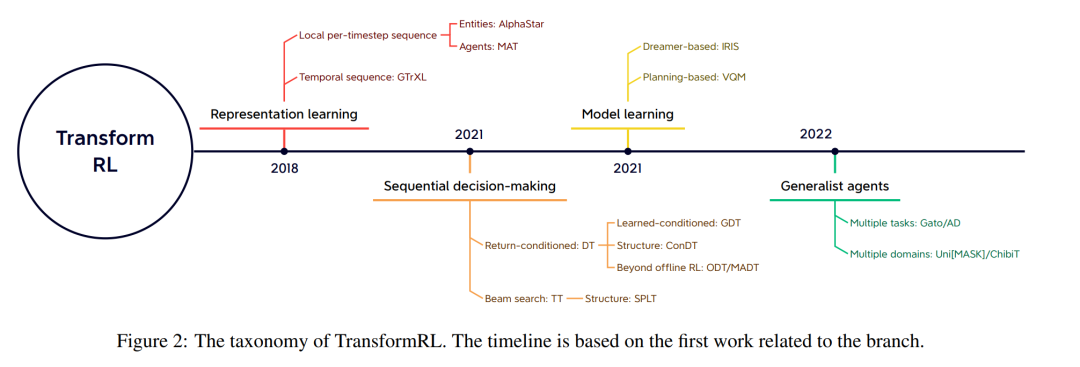

尽管Transformer已经成为大多数监督学习研究的基础模型,但由于上述挑战,它并没有长期在强化学习社区中广泛使用。实际上,大多数TransformRL的早期尝试将transformer应用于状态表示学习或提供记忆信息,同时仍将标准的强化学习算法应用于智能体学习,如时间差异学习和策略优化。因此,尽管引入transformer作为函数逼近器,但这些方法仍然受到传统强化学习框架的挑战。直到最近,离线强化学习才使得从大规模离线数据中学习最优策略成为可能。受离线强化学习的启发,最近的工作进一步将强化学习问题视为固定经验上的条件序列建模问题。通过这样做,它有助于绕过传统强化学习中bootstrapping error的挑战,从而使Transformer架构释放出强大的顺序建模能力。回顾了TransformRL的进展,并提供了一个分类法来介绍当前的方法。将现有方法分为四类:表示学习、模型学习、顺序决策和综合智能体。图2提供了一个分类法草图,其中包含相应作品的子集。

用于表示学习的transformer考虑到强化学习任务的顺序性,尝试Transformer编码器模块是合理的。事实上,强化学习任务中的各种序列需要处理,例如本地每时间步长序列(多实体序列[Vinyals et al., 2019; Baker et al., 2019],多智能体序列[Wen等人,2022年]),时间序列(轨迹[Parisotto et al., 2020; Banino et al., 2021])等等。

用于模型学习的transformer

除了使用Transformer作为序列嵌入的编码器外,Transformer架构还在一些基于模型的算法中充当环境模型的骨干。与以单步观察和行动为条件的预测不同,Transformer使环境模型能够以一定长度的历史信息为条件来预测转换。

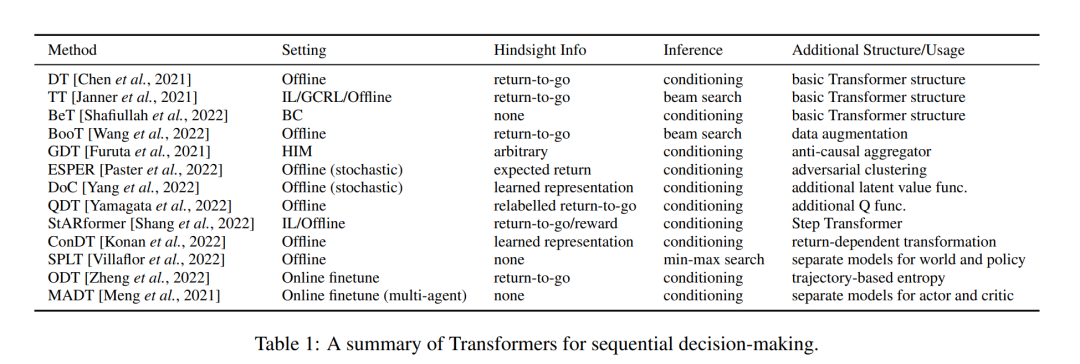

用于序列决策的transformer

除了作为一个可插入到传统RL算法组件中的表达性架构,Transformer本身可以作为一个直接进行顺序决策的模型。这是因为强化学习可以被视为一个条件序列建模问题——生成可以产生高回报的行动序列。

多面手智能体的Transformer

鉴于决策Transformer已经在各种离线数据任务中展示了它的力量,一些工作转向考虑Transformer是否可以使一个多面手智能体解决多个任务或问题,如在CV和NLP领域。

3. 总结

**本文简要回顾了用于强化学习的transformer的进展。**本文对这些进展进行了分类:a) transformer可以作为强化学习的一个强大模块,例如,作为表示模块或世界模型;b) transformer可以作为顺序决策者;c) transformer可以促进跨任务和领域的泛化。虽然我们介绍了这个主题的代表性工作,但在RL中使用transformer并不限于我们的讨论。鉴于transformer在更广泛的人工智能社区的繁荣,我们相信将transformer和RL结合是一个有希望的趋势。最后,讨论了这一方向的未来前景和开放问题。

**结合强化学习和(自)监督学习。**回顾TransformRL的发展,训练方法包括强化学习和(自)监督学习。当作为在传统强化学习框架下训练的表示模块时,Transformer架构的优化通常是不稳定的。当使用transformer通过序列建模解决决策问题时,由于(自)监督学习范式,"致命三元组问题" [Van Hasselt等人,2018]被消除。在(自)监督学习框架下,策略的性能与离线数据质量密切相关,利用和探索之间不再存在明确的权衡。因此,当我们在Transformer学习中结合强化学习和(自)监督学习时,可能会学到更好的策略。部分工作[Zheng et al., 2022; Meng et al., 2021]尝试了有监督的预训练和涉及强化学习的微调方案。然而,相对固定的策略可以限制探索[Nair等人,2020],这是有待解决的瓶颈之一。此外,用于性能评估的任务也相对简单。transformer是否可以将这种(自)监督学习扩展到更大的数据集、更复杂的环境和现实世界的应用,值得进一步探索。此外,我们希望未来的工作提供更多的理论和经验见解,以描述这种(自)监督学习在哪些条件下有望表现良好[Brandfonbrener et al., 2022]。

**用transformer桥接在线和离线学习。**进入离线强化学习是TransformRL的一个里程碑。在实际应用中,利用transformer获取决策序列中的依赖关系并抽象策略,主要离不开大量离线数据的支持。然而,在实际应用中,一些决策任务脱离在线框架是不可实现的。一方面,在某些任务中获取专家数据并不容易;另一方面,有些环境是开放式的(如《Minecraft》),这意味着策略必须不断调整以处理在线交互过程中未见过的任务。因此,我们认为线上学习和线下学习的衔接是必要的。然而,大多数基于Decision Transformer的研究进展都集中在离线学习框架上。一些工作尝试采用离线预训练和在线微调的范式[Xie et al., 2022]。然而,与离线强化学习算法一样,在线微调中的分布变化仍然存在,因此希望对Decision Transformer进行一些特殊设计来解决这个问题。此外,如何从头开始训练一个在线决策Transformer是一个有趣的开放问题。

**为决策问题量身定制的Transformer结构。**目前决策Transformer系列方法中的Transformer结构主要是vanilla Transformer,其最初是为文本序列设计的,可能不适合决策问题的性质。例如,是否适合对轨迹序列采用普通的自注意力机制?在位置嵌入中,是需要区分决策序列中的不同元素还是相同元素的不同部分?此外,由于在不同的Decision Transformer算法中将轨迹表示为序列的变体很多,如何从中选择仍然缺乏系统的研究。例如,在行业中部署此类算法时,如何选择可靠的后见之明信息?此外,普通Transformer是一种具有巨大计算成本的结构,这使得它在训练和推理阶段都很昂贵,并且内存占用很高,这限制了它捕获的依赖项的长度。为了缓解这些问题,NLP中的一些工作[Zhou et al., 2021]从这些方面对结构进行了改进,相似结构是否可以用于决策问题也是值得探索的。

**转向更多面手的Transformers智能体。**对面向多面手的transformer的综述显示了transformer作为一般政策的潜力(第4.4节)。事实上,transformer的设计允许使用类似的处理块处理多种模态(如图像、视频、文本和语音),并对非常大容量的网络和巨大的数据集表现出出色的可扩展性。最近的工作在训练能够执行多个和跨域任务的智能体方面取得了实质性的进展。然而,考虑到这些智能体是在大量数据上训练的,仍然不确定它们是否只是记住了数据集,以及它们是否可以进行有效的泛化。因此,如何学习一个可以在没有强假设的情况下泛化到未见任务的智能体是一个值得研究的问题[Boustati等人,2021]。此外,我们很想知道Transformer是否足够强大,可以学习一个可以在不同任务和场景中使用的通用世界模型。

**Transformer的RL。**虽然我们已经讨论了RL如何从Transformer的使用中受益,但相反的方向,即使用RL来受益于Transformer训练是一个有趣的开放问题,但很少有人探索。我们看到,最近,来自人类反馈的强化学习(RLHF)[欧阳等人,2022]学习了一个奖励模型,并使用RL算法微调Transformer,以使语言模型与人类意图保持一致。未来,我们相信RL可以成为进一步提升Transformer在其他领域性能的有用工具。