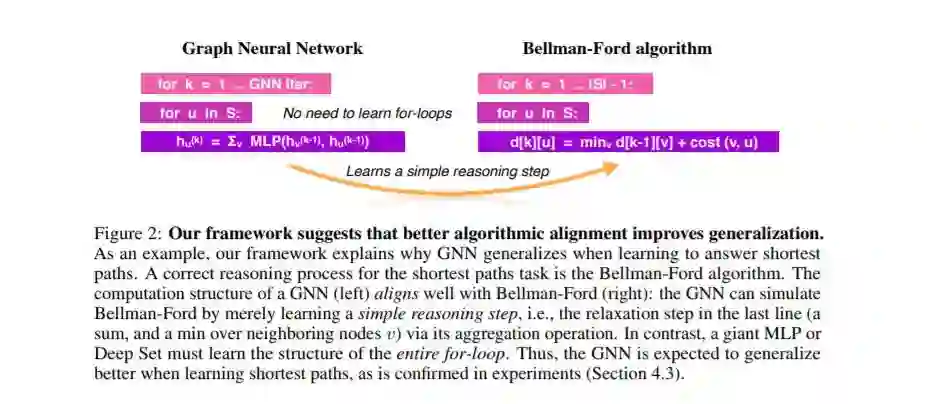

神经网络已经成功地完成了许多推理任务。从经验上看,这些任务需要专门的网络结构,例如,图神经网络(GNNs)在许多这样的任务中表现良好,而较少结构的网络会失败。从理论上讲,尽管网络结构具有相同的表达能力,但人们对网络结构为什么以及何时比其他网络结构更能泛化的理解是有限的。本文通过研究网络的计算结构与相关推理过程的算法结构之间的一致性,建立了一个描述网络能很好学习哪些推理任务的框架。我们正式定义了这种算法对齐,并推导出一个随更好的对齐而减小的样本复杂度界。该框架为流行推理模型的经验成功提供了一个解释,并指出了它们的局限性。例如,我们通过一个强大的算法范例——动态规划(DP),将看似不同的推理任务,如直觉物理、可视化问题回答和最短路径统一起来。我们证明了gnn与DP是一致的,因此可以解决这些问题。在一些推理任务中,我们的理论得到了实证结果的支持。

成为VIP会员查看完整内容

相关内容

人工神经网络(Artificial Neural Network,即ANN ),是20世纪80 年代以来人工智能领域兴起的研究热点。它从信息处理角度对人脑神经元网络进行抽象, 建立某种简单模型,按不同的连接方式组成不同的网络。在工程与学术界也常直接简称为神经网络或类神经网络。神经网络是一种运算模型,由大量的节点(或称神经元)之间相互联接构成。每个节点代表一种特定的输出函数,称为激励函数(activation function)。每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重,这相当于人工神经网络的记忆。网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

最近十多年来,人工神经网络的研究工作不断深入,已经取得了很大的进展,其在模式识别、智能机器人、自动控制、预测估计、生物、医学、经济等领域已成功地解决了许多现代计算机难以解决的实际问题,表现出了良好的智能特性。

专知会员服务

65+阅读 · 2019年12月12日

Arxiv

13+阅读 · 2019年5月22日