当深度强化学习遇见图神经网络

导读

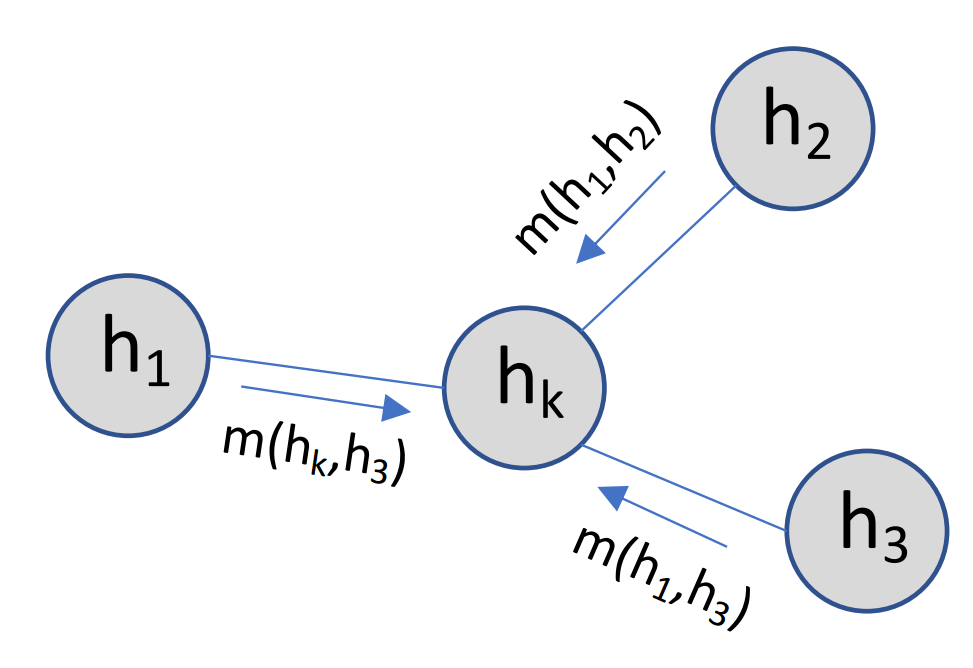

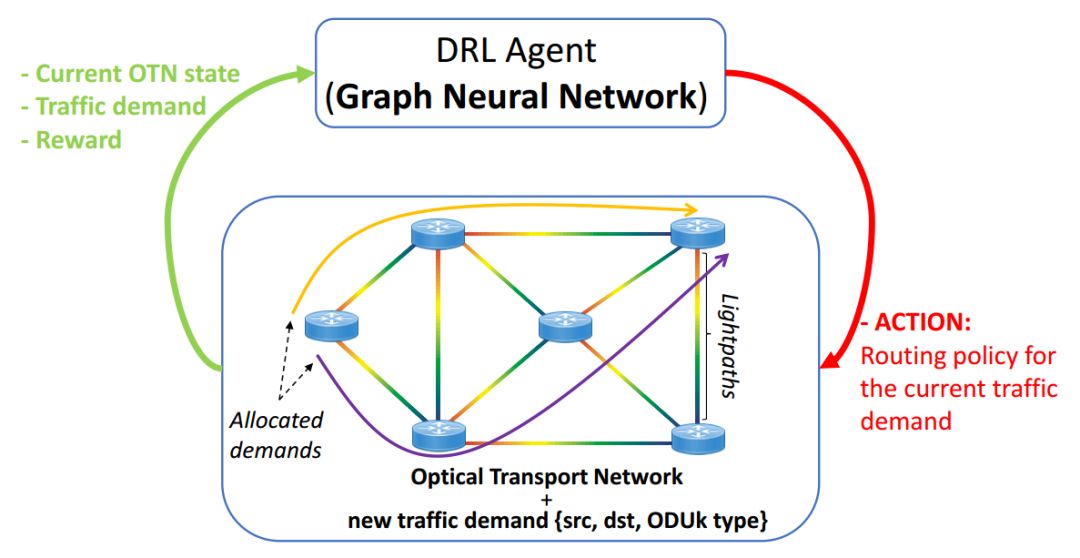

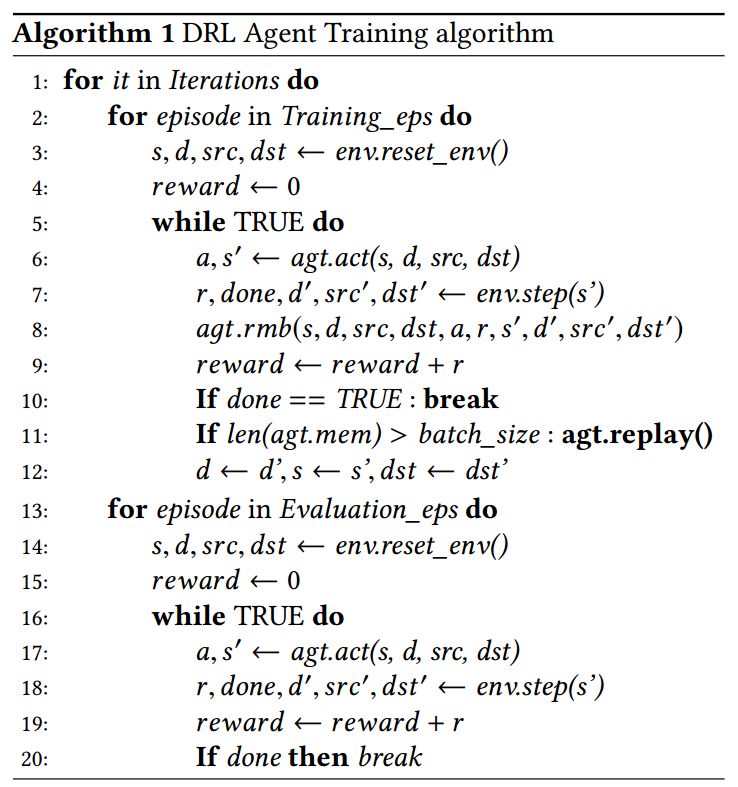

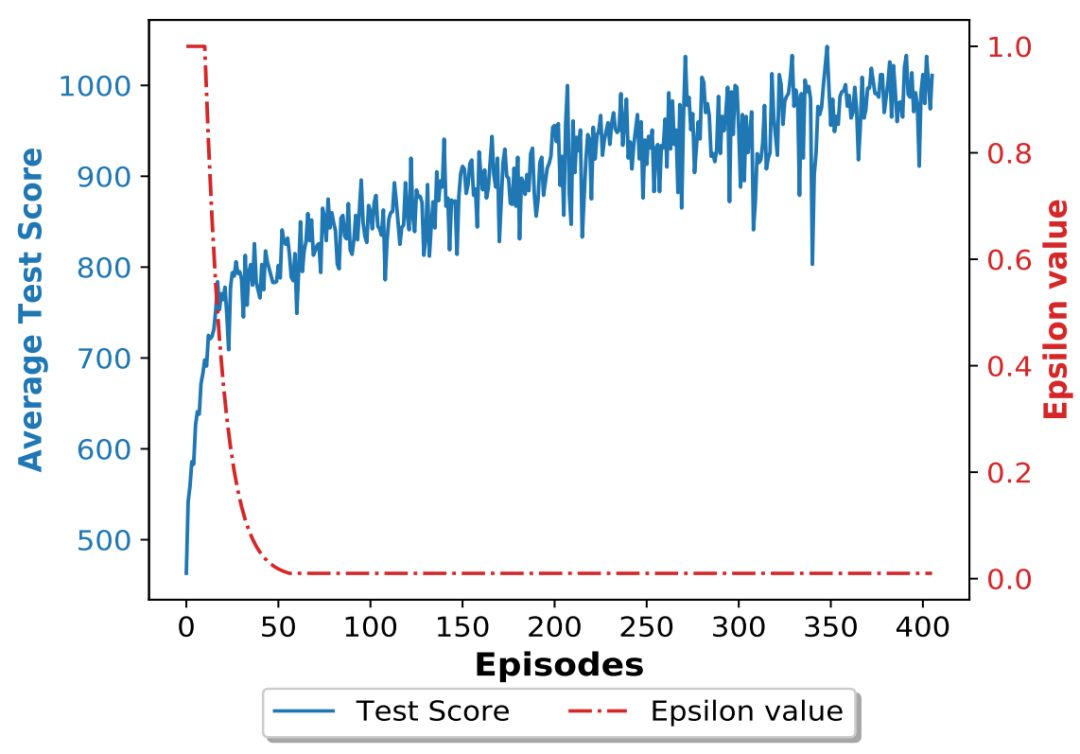

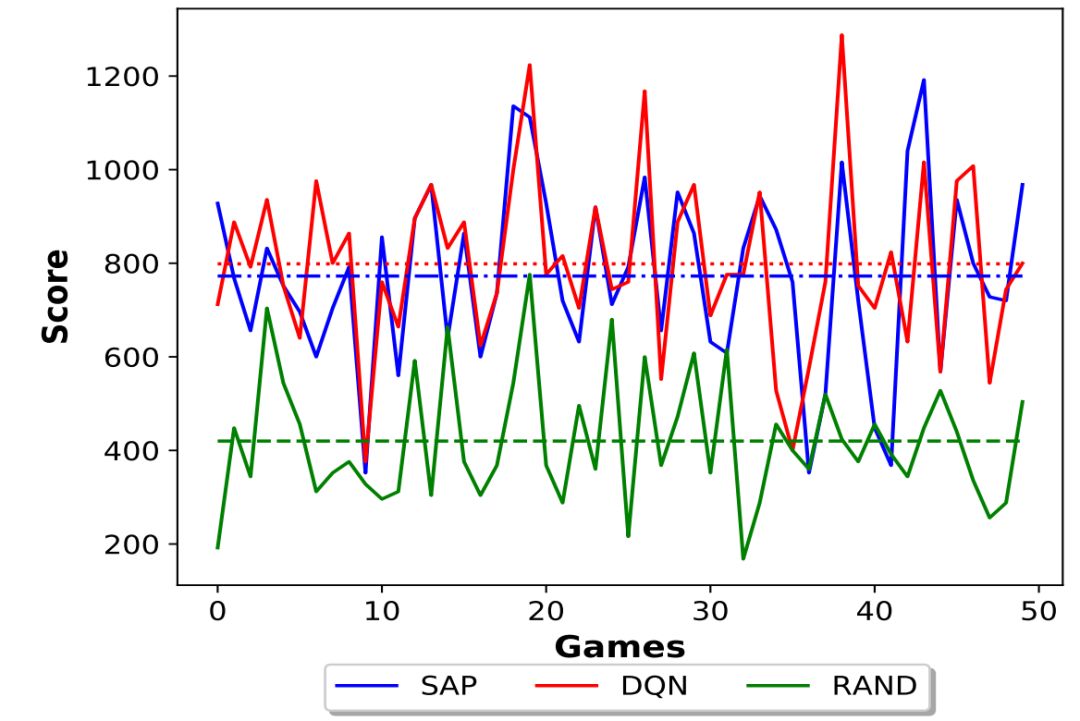

本文提出将图神经网络(GNN)与深度强化学习(DRL)相结合。新的DRL+GNN体系结构能够在任意网络拓扑图上学习、操作和生成。作者认为缺乏泛化是阻碍在生产网络中部署现有的基于DRL的解决方案的主要障碍。因此,所提出的体系结构是开发新一代基于DRL的网络产品的第一步。

作者 | Paul Almasan等

编译 | Xiaowen

论文PDF下载

-

后台回复“DRL-GNN” 就可以获取《 Deep Reinforcement Learning meets Graph Neural Networks》的完整版PDF下载链接~

登录查看更多