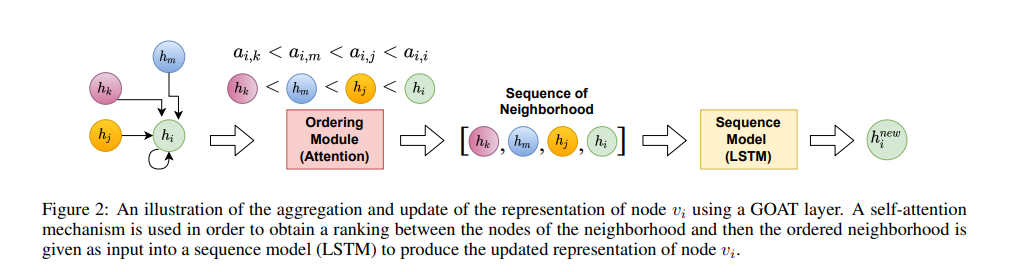

图神经网络(GNNs)已经成功地用于许多涉及图结构数据的问题,实现了最先进的性能。GNN通常采用消息传递方案,其中每个节点使用置换不变聚合函数从其邻居聚合信息。经过严格检查的标准选择(如平均值或和聚合函数)功能有限,因为它们无法捕获相邻函数之间的交互。在这项工作中,我们使用一个信息理论框架来形式化这些交互作用,特别是包括协同信息。在此定义的驱动下,我们引入了图排序注意力层(GOAT),这是一种新颖的GNN组件,用于捕获邻域节点之间的交互。这是通过一种注意力机制来学习局部节点顺序,并使用循环神经网络聚合器处理有序表示来实现的。这种设计允许我们使用一个排列敏感的聚合器,同时保持拟议的GOAT层的排列等效。GOAT模型展示了它在捕获复杂信息的图指标(如中间性中心性和节点的有效大小)建模方面提高的性能。在实际用例中,通过在几个真实的节点分类基准测试中取得的成功,它的卓越建模能力得到了证实。

https://www.zhuanzhi.ai/paper/367986d1916e281d7e097fc058bfeb6e

成为VIP会员查看完整内容

相关内容

Arxiv

12+阅读 · 2020年4月15日