【AAAI2022】用于视觉常识推理的场景图增强图像-文本学习

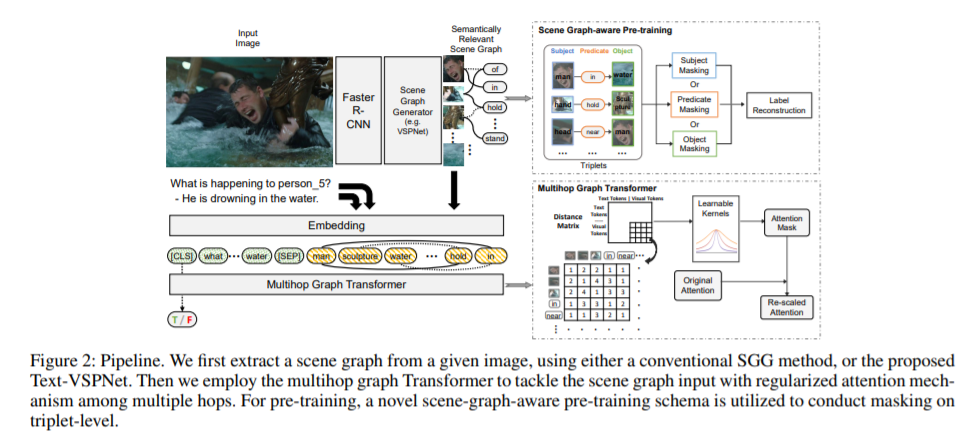

回答关于图像的复杂问题是机器智能的一个雄心勃勃的目标,它需要对图像、文本和常识的联合理解,以及强大的推理能力。最近,多模态变换器在视觉常识推理(Visual Commonsense Reasoning, VCR)任务上取得了很大的进展,通过跨通道注意力层共同理解视觉对象和文本标记。然而,这些方法并没有利用场景的丰富结构和对象之间的交互作用,而这些在回答复杂的常识问题时是必不可少的。我们提出了一个场景图增强图像-文本学习(SGEITL)框架,将视觉场景图纳入常识推理。为了利用场景图结构,在模型结构层次上,我们提出了一种多跳图转换器来正则化各跳间的注意力交互。在预训练方面,提出了一种场景感知的预训练方法,利用视觉场景图中提取的结构知识。此外,我们还介绍了一种使用文本注释在弱监督方式下训练和生成领域相关视觉场景图的方法。在VCR和其他任务上的大量实验表明,与最先进的方法相比,性能有显著提高,并证明了所提出的每个组件的有效性。

https://www.zhuanzhi.ai/paper/b1df219aafbecbaaf09c3a0b10f58df6

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GVCR” 就可以获取《【AAAI2022】用于视觉常识推理的场景图增强图像-文本学习》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月17日

Arxiv

15+阅读 · 2021年5月19日

Arxiv

13+阅读 · 2020年8月11日

Arxiv

21+阅读 · 2018年12月25日