【AAAI2022】通过多任务学习改进证据深度学习

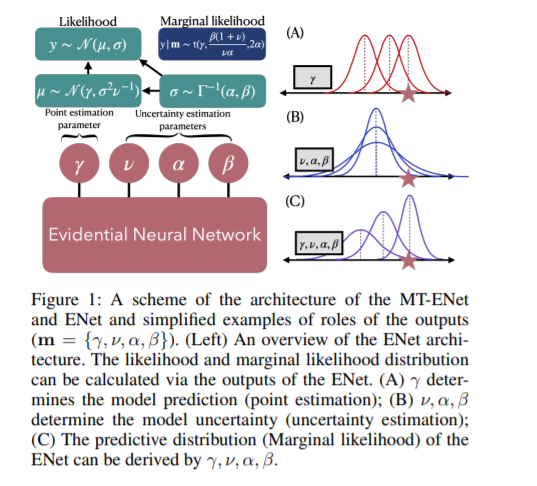

证据回归网络(ENet)估计一个连续目标及其预测的不确定性,无需昂贵的贝叶斯模型平均。然而,由于ENet原始损失函数的梯度收缩问题,即负对数边际似然损失,有可能导致目标预测不准确。本文的目标是通过解决梯度收缩问题来提高ENet的预测精度,同时保持其有效的不确定性估计。一个多任务学习(MTL)框架,被称为MT-ENet,被提出来实现这一目标。在MTL中,我们将Lipschitz修正均方误差(MSE)损失函数定义为另一种损失,并将其添加到现有的NLL损失中。设计了Lipschitz修正均方误差损失,通过动态调整其Lipschitz常数来缓解梯度与NLL损失之间的冲突。这样,李普希茨均方误差损失不影响NLL损失的不确定性估计。MT-ENet提高了ENet的预测精度,同时在合成数据集和现实基准上,包括药物-目标亲和(DTA)回归,不丧失不确定性估计能力。此外,MT-ENet在DTA基准上具有显著的校准和非分布检测能力。

https://www.zhuanzhi.ai/paper/c91e28221315b8539ea96695b53146dc

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“EDML” 就可以获取《【AAAI2022】通过多任务学习改进证据深度学习》专知下载链接

登录查看更多