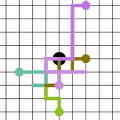

Few-shot learning (FSL) aims to learn a classifier that can be easily adapted to accommodate new tasks not seen during training, given only a few examples. To handle the limited-data problem in few-shot regimes, recent methods tend to collectively use a set of local features to densely represent an image instead of using a mixed global feature. They generally explore a unidirectional query-to-support paradigm in FSL, e.g., find the nearest/optimal support feature for each query feature and aggregate these local matches for a joint classification. In this paper, we propose a new method Mutual Centralized Learning (MCL) to fully affiliate the two disjoint sets of dense features in a bidirectional paradigm. We associate each local feature with a particle that can bidirectionally random walk in a discrete feature space by the affiliations. To estimate the class probability, we propose the features' accessibility that measures the expected number of visits to the support features of that class in a Markov process. We relate our method to learning a centrality on an affiliation network and demonstrate its capability to be plugged in existing methods by highlighting centralized local features. Experiments show that our method achieves the state-of-the-art on both miniImageNet and tieredImageNet.

翻译:少见的学习( FSL) 旨在学习一个易于调整的分类器,以适应培训期间没有看到的新任务,仅举几个例子。为了处理少见系统中的有限数据问题,最近的方法倾向于集体使用一组局部特征来密集代表一个图像,而不是使用混合的全球特征。它们通常探索FSL中的单向询问-支持模式,例如,为每个查询特征找到最接近/最优化的支持功能,并将这些本地匹配合并到联合分类中。在本文中,我们建议采用新方法,即相互集中学习,将两组密集特征的脱节功能完全附在双向模式中。我们把每个本地特征与一个粒子联系起来,这种粒子可以按其关联性在一个离散特征空间双向随机行走。为了估计班级的可能性,我们建议这些特征用来测量在Markov 进程中对该类支持特征的预期访问次数。我们的方法是学习联系网络的中心,并通过突出集中的本地特征和微级网络显示其在现有方法中连接的能力。