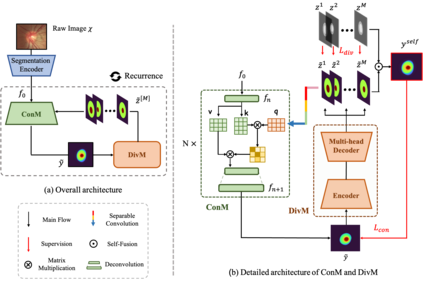

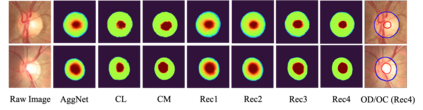

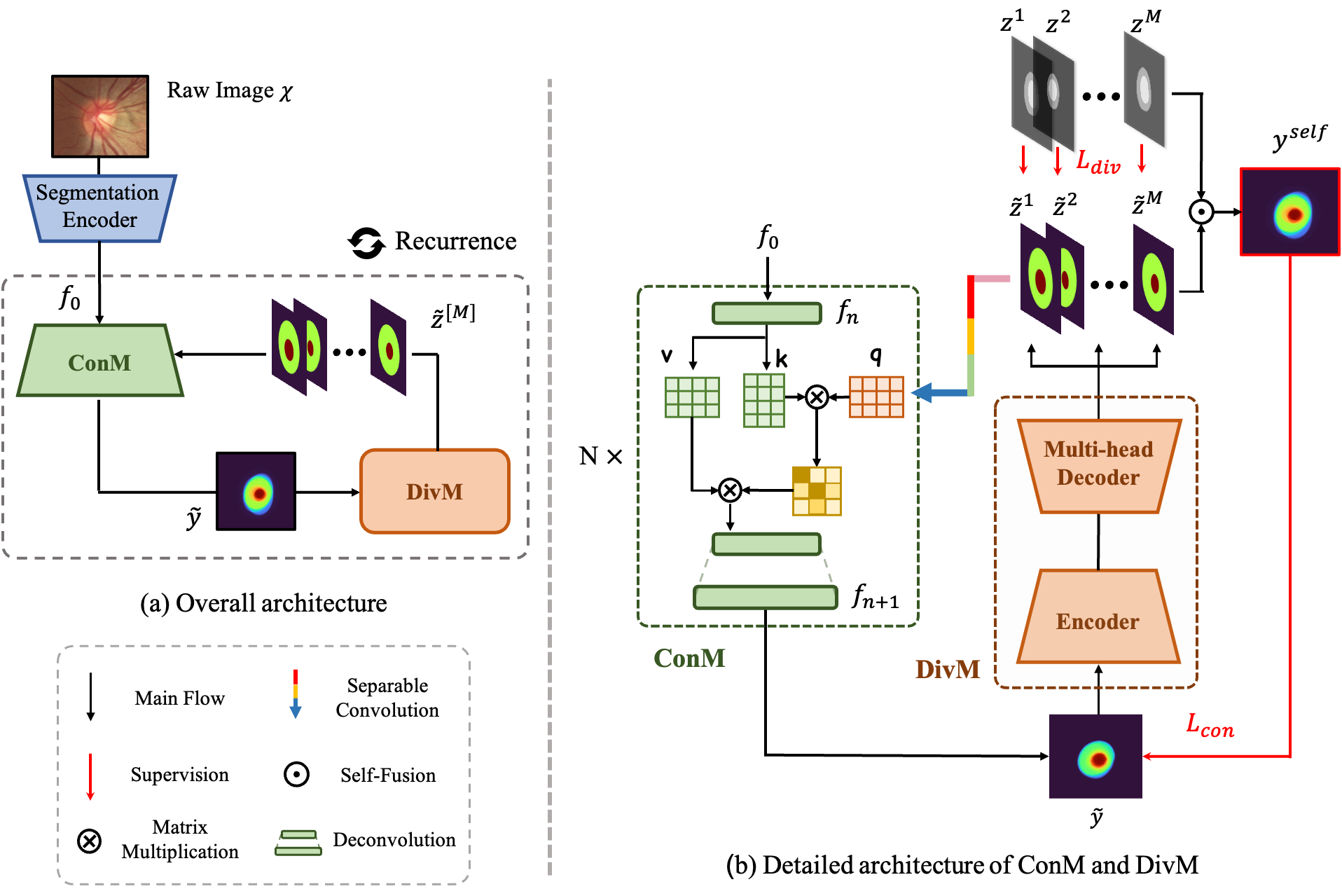

The segmentation of optic disc(OD) and optic cup(OC) from fundus images is an important fundamental task for glaucoma diagnosis. In the clinical practice, it is often necessary to collect opinions from multiple experts to obtain the final OD/OC annotation. This clinical routine helps to mitigate the individual bias. But when data is multiply annotated, standard deep learning models will be inapplicable. In this paper, we propose a novel neural network framework to learn OD/OC segmentation from multi-rater annotations. The segmentation results are self-calibrated through the iterative optimization of multi-rater expertness estimation and calibrated OD/OC segmentation. In this way, the proposed method can realize a mutual improvement of both tasks and finally obtain a refined segmentation result. Specifically, we propose Diverging Model(DivM) and Converging Model(ConM) to process the two tasks respectively. ConM segments the raw image based on the multi-rater expertness map provided by DivM. DivM generates multi-rater expertness map from the segmentation mask provided by ConM. The experiment results show that by recurrently running ConM and DivM, the results can be self-calibrated so as to outperform a range of state-of-the-art(SOTA) multi-rater segmentation methods.

翻译:光碟(OD)和光杯(OC)从 Fundus 图像中分离出来是一项重要的基本任务。 在临床实践中,通常需要收集多位专家的意见,以获得最终的OD/OC批注。这种临床例行做法有助于减轻个人偏差。但是,当数据乘以附加说明时,标准的深层次学习模型将无法适用。在本文件中,我们提议一个新的神经网络框架,以便从多纬度说明中学习OD/OC分解。分解结果通过多纬度专家估计和校准的OD/OC分解的迭接式优化自我校准。在这种方式下,拟议方法可以实现对两个任务的共同改进,并最终获得精细化的分解结果。具体地说,我们提议了差异模型(DivMM)和趋同模型(ConM)分别处理这两项任务。DivM提供的多纬度专家图中的原始图像由DivM生成多纬度专家地图。DivM通过ConM-deal-deal-deal-deal-deal-degrational-mainal-laction abal laction laction raction atraction aclection roglegroduction ablection 由可运行的自动测试结果可以显示为可反复的自我测试结果。