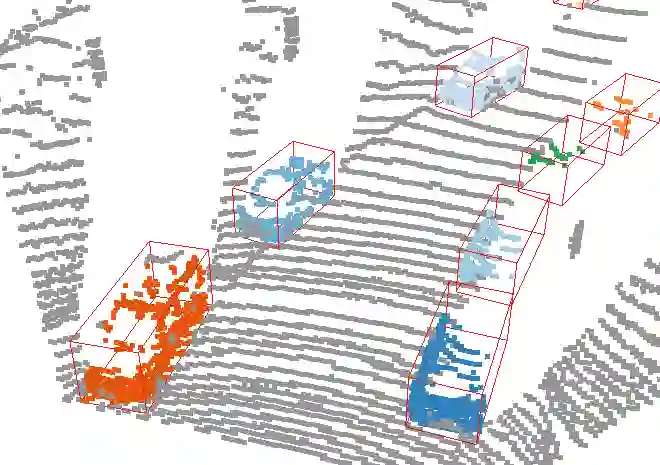

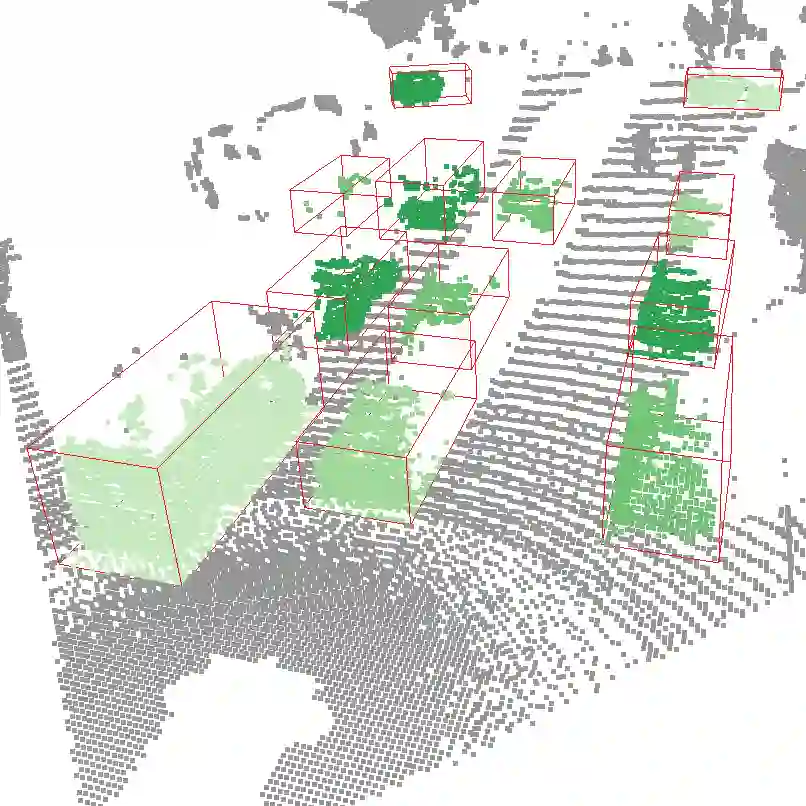

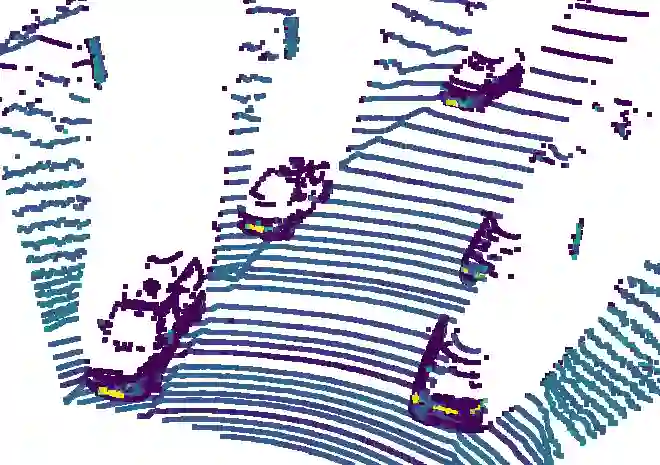

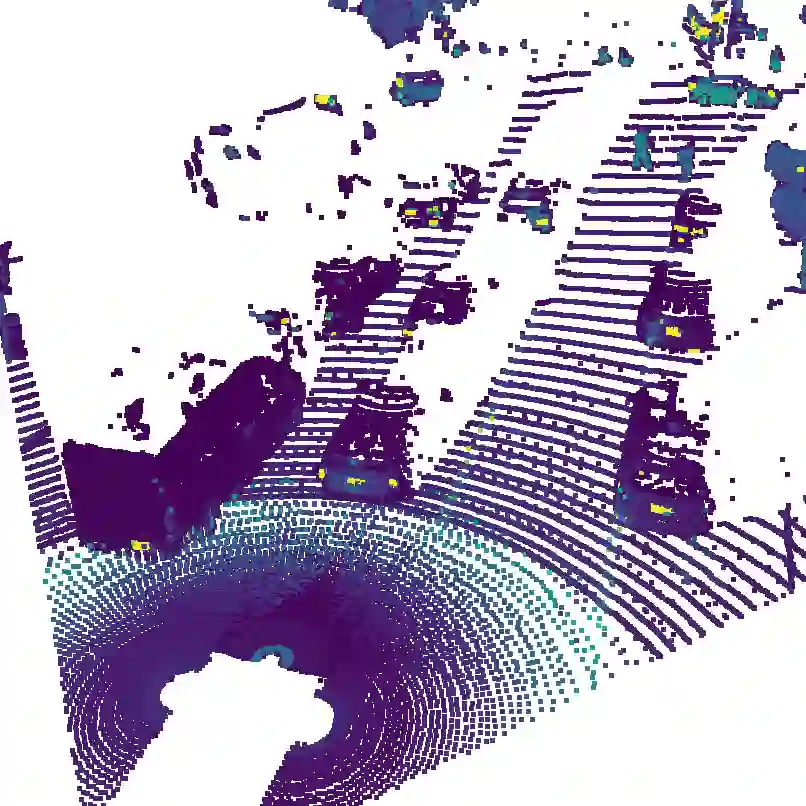

LiDAR 3D object detection models are inevitably biased towards their training dataset. The detector clearly exhibits this bias when employed on a target dataset, particularly towards object sizes. However, object sizes vary heavily between domains due to, for instance, different labeling policies or geographical locations. State-of-the-art unsupervised domain adaptation approaches outsource methods to overcome the object size bias. Mainstream size adaptation approaches exploit target domain statistics, contradicting the original unsupervised assumption. Our novel unsupervised anchor calibration method addresses this limitation. Given a model trained on the source data, we estimate the optimal target anchors in a completely unsupervised manner. The main idea stems from an intuitive observation: by varying the anchor sizes for the target domain, we inevitably introduce noise or even remove valuable object cues. The latent object representation, perturbed by the anchor size, is closest to the learned source features only under the optimal target anchors. We leverage this observation for anchor size optimization. Our experimental results show that, without any retraining, we achieve competitive results even compared to state-of-the-art weakly-supervised size adaptation approaches. In addition, our anchor calibration can be combined with such existing methods, making them completely unsupervised.

翻译:LiDAR 3D 对象检测模型不可避免地偏向于其培训数据集。 检测器在目标数据集中使用时, 特别是对象大小时, 明显显示出这种偏差。 但是, 对象大小因不同域之间差异很大, 例如, 标签政策或地理位置不同。 最先进的不受监督域适应方法, 以外包方法克服对象大小偏差 。 主流尺寸适应方法利用目标域统计, 与原始未经监督的假设相矛盾 。 我们的新颖的未经监督的锚定校准方法解决了这一限制 。 我们的实验结果显示, 在一个经过源数据培训的模型中, 我们完全以不受监督的方式估计最佳目标锚定。 主要想法来自直观观察: 通过改变目标域的锚定大小, 我们不可避免地会引入噪音, 甚至移除有价值的物体提示 。 受锚定型大小影响的潜在物体表示方式, 最接近于最佳目标锚定型锚下的源特征 。 我们利用这种观察来优化锁定大小。 我们的实验结果显示, 未经任何再训练, 我们就能取得竞争的结果, 甚至与州- 的固定固定式的固定式的、 完全地校准的校准方法 。