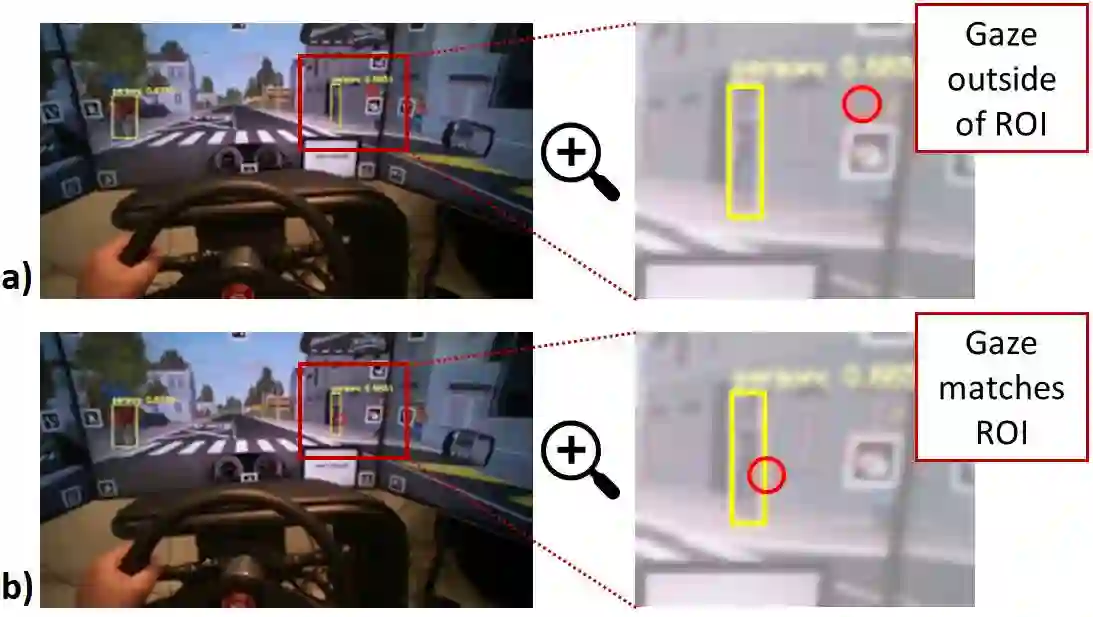

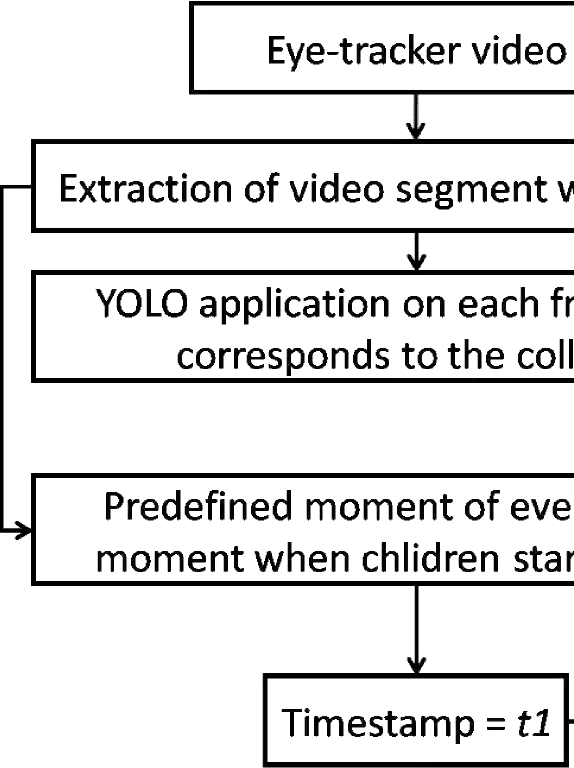

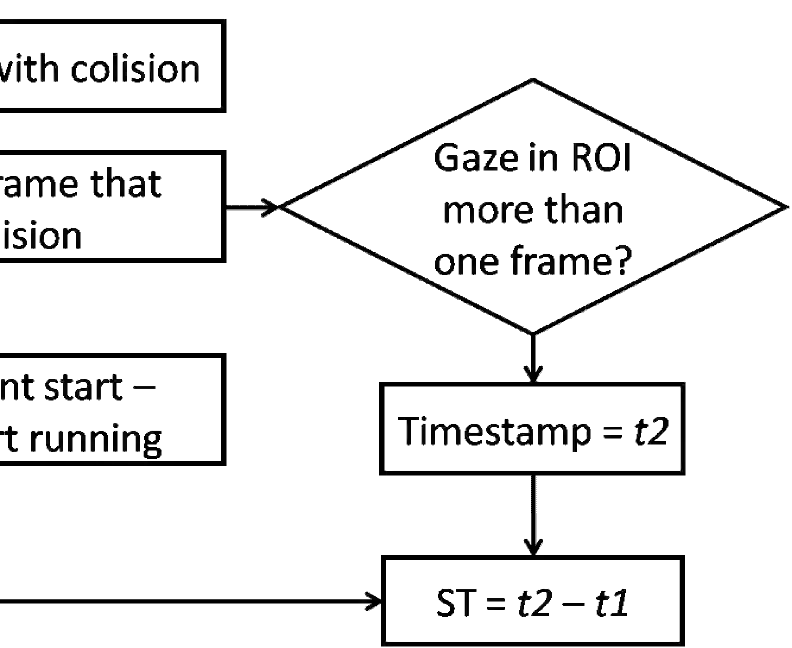

We present a method to automatically calculate sensing time (ST) from the eye tracker data in subjects with neurological impairment using a driving simulator. ST presents the time interval for a person to notice the stimulus from its first occurrence. Precisely, we measured the time since the children started to cross the street until the drivers directed their look to the children. In comparison to the commonly used reaction time, ST does not require additional neuro-muscular responses such as braking and presents unique information on the sensory function. From 108 neurological patients recruited for the study, the analysis of ST was performed in overall 56 patients to assess fit-, unfit-, and conditionally-fit-to-drive patients. The results showed that the proposed method based on the YOLO (You Only Look Once) object detector is efficient for computing STs from the eye tracker data in neurological patients. We obtained discriminative results for fit-to-drive patients by application of Tukey's Honest Significant Difference post hoc test (p < 0.01), while no difference was observed between conditionally-fit and unfit-to-drive groups (p = 0.542). Moreover, we show that time-to-collision (TTC), initial gaze distance (IGD) from pedestrians, and speed at the hazard onset did not influence the result, while the only significant interaction is among fitness, IGD, and TTC on ST. Although the proposed method can be applied to assess fitness to drive, we provide directions for future driving simulation-based evaluation and propose processing workflow to secure reliable ST calculation in other domains such as psychology, neuroscience, marketing, etc.

翻译:我们提出一种方法,用驾驶模拟器自动计算神经损伤科目的视力跟踪数据(ST)的感应时间。ST提供一个人从第一次出现时开始注意刺激的时间间隔。准确地说,我们测量了儿童开始过街直到司机向儿童看车的时间。与常用的反应时间相比,ST不需要额外的神经肌肉反应,如制动,并提供关于感应功能的独特信息。在为研究聘用的108名神经系统病人中,ST的分析是在总共56名病人中进行的,以便评估适合、不合适和有条件适合到驾驶的病人。结果显示,根据YOLO(You Oust Look Omer)对象探测器的建议方法对于神经病人从眼睛跟踪数据中计算ST的效率是有效的。我们通过应用Tukey的诚实显著差异 I 后期测试(p < 0.01),虽然在基于我们适应和不合适到不合适驾驶的病人之间没有区别(p= drifit-drive-frit-drive)组之间没有观察到任何差异,但是,ST-dro-d-deal liction listal lectional laction laction lade,我们显示, Stal-d-dal-dal-ral beal beal be sal be sal be sal be sal be sal be sal be sal be sal be lection) ass be sal be sal be ass be sal be sal be ex be sal be ass be exal be salviolviewal beal beal beal be, 我们viewal betractionaldal be,我们显示, 我们tal beal beal bedaldal bedal bedaldal bedaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldaldalbaldaldaldal be 和 和 和 be 和 和 和 assal bedaldal be) 我们,我们,我们, 我们daldal bedaldal be slal be sal be saldaldal be sal be ass be ass be